为了提升精度并减少目标搜索空间,大幅宽遥感图像下的动目标检测研究通常基于多视图的方法实现。首先利用遥感图像分割[2-4]或显著性检测[5-6]算法,粗糙快速地定位目标可能存在的区域,然后利用手工提取的外观特征如HOG(Histogram of Oriented Gradient)、Haar等训练一个鲁棒的分类器来逐个过滤错误的检测结果。而近来基于卷积神经网络(Convolutional Neural Network,CNN)的模型替代传统分类器取得了显著的效果。LaLonde等[4]通过使卷积层同时学习目标的运动和外观信息,提出了一个端到端的全CNN模型,在实现多目标检测、简化流程的同时达到了精度最优。Blasch等[7]利用卷积和全连接层对图像块进行分类,结果显著优于支持向量机方法。其他以包含背景信息的图像块作为原始输入,基于CNN实现的高精度多目标检测模型包括FasterR-CNN(Faster Region with CNN)[8]、YOLO(You Only Look Once)[9]、SSD(Single Shot multibox Detector)[10]及R-FCN (Region-based Fully Convolutional Networks)[11]等。

当前高精度CNN模型存在的不足是:其和传统分类器一样无法减少动目标在大幅宽图像下的搜索空间。任何硬件都无法支持CNN同时处理数百万像素点,直接将图像尺寸归一到固定大小则可能导致小目标消失融合在背景中[4]。因此,通过运动信息对目标进行预提取依然是必要的步骤,但现有的像素级分割算法通常都不是为CNN设计优化的,其输出不规则的区域(blob)或质心点[12]作为候选目标,而CNN需要背景信息来辅助检测,其以矩形的图像块(patch)作为原始输入,如果直接在目标聚集区域简单地通过区域扩展得到图像块,则会导致块之间存在大量的重叠,也就意味着小目标可能在后续的CNN模型中被重复地检测,需要额外的后处理过程并浪费计算资源。

本文为优化CNN在大幅宽遥感图像下的输入,提出了一种多尺寸动目标分块提取方法。首先,将现有图像分割算法中普遍采用的误差全局处理转换为局部操作,实现快速、粗糙地提取候选目标运动区域;然后,通过合并相邻区域的方式减少输出图像块的面积和数量。针对该过程存在的目标规模庞大、空间密度分布不均匀、结果易陷入局部最优等问题,在相邻块合并阶段设计了一种基于空间约束的密度聚类算法——SC-DBSCAN,利用对象的相对密度自适应地将数据分解为多个相互独立的子簇,实现了问题的分治,可并行化处理。同时分析了模拟退火思想与合并过程的相关性,将数量及面积指标作为相邻对象合并的优化目标,引入随机扰动来提升图像块质量。

本文主要贡献有:①从优化图像块质量的角度减少检测模型的搜索空间,避免了目标的重复检测。②改进的分割及误差处理算法在保证检测精度的同时提升了候选区域提取的效率。③SC-DBSCAN算法能根据目标聚集程度自适应地进一步减小检测范围。

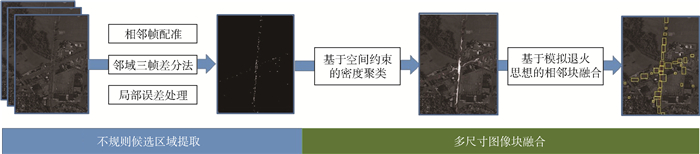

1 基于图像分割的动目标候选区域提取 本文方法结构如图 1所示。首先,提取动目标候选区域的过程依赖于像素级图像分割算法实现,虽然已有许多研究针对光照变化、运动视差等遥感图像特有的问题给出了改进方案,但根据CNN模型特性进行优化的工作鲜有进展。CNN模型以具有一定尺寸大小、包含目标背景信息的图像块作为输入数据,这在进一步减少搜索空间的同时能够为简化误差预处理提供可能,本节基于此介绍并分析了几种主流分割算法的特点,并以邻域三帧差分法为基础,对误差优化过程进行改进。

|

| 图 1 模块结构 Fig. 1 Modular structure |

| 图选项 |

1.1 预处理 利用目标运动信息的算法通常需要先固定背景,即对相邻帧执行配准操作以补偿相机运动。本文与其他文献[3-4]一致,考虑到大幅宽遥感图像的处理对计算复杂度更加敏感,采用基于特征点匹配的算法实现帧配准[13]。首先分别对每帧图像提取Harris角点,然后在各角点周围提取128维尺度不变特征转换(Scale-Invariant Feature Transform,SIFT),通过随机抽样一致(Random Sample Consensus,RANSAC)算法过滤掉不合适的特征点,最后执行匹配得到单应性矩阵,完成坐标转换过程。

1.2 基于像素分割的候选运动区域提取

1.2.1 面向CNN的分割算法分析 分割得到目标运动区域等价于检测相邻帧图像的像素级变化。相比于计算量较大的光流法,背景建模[12]和时域差分法[2-3](帧差法)在大幅宽图像中的应用更为普遍。背景建模法通过连续帧像素的统计信息来构建静态背景,再将当前帧与其做差得到运动区域,该类方法能抑制场景中突变的运动,如树叶随风摇曳、湖水的波动等,但其最优精度需要依据相机和场景的实际情况进行调参,且使用帧数越多,图像可建模区域就越窄。时域差分法直接计算相邻帧的像素差,其速度快且对光照缓慢变化的情况更加鲁棒,但易受噪声影响产生不精确的结果。

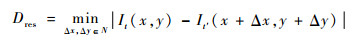

Sommer等[12]比较了11种基于背景建模和时域差分法实现的动目标检测算法,其中引入局部邻域考虑的策略取得了最优的精度。该实验对正确检测的定义是提取的区域质心点和真实标注距离在20像素以内,但这并不适合于评价作为CNN输入的图像块质量。如图 2所示,为实现多目标同时检测,网络模型输入的图像块尺寸通常远大于单个小目标,如224×224或512×512[4],简单分割算法导致的局部不精确(目标融合、分离、位置漂移等)不会对最终的结果产生显著影响。因此,现有文献对造成局部不精确的光照变化、运动视差以及配准误差等而设计的全局图像预处理方法(全局直方图匹配[12]、高斯盒滤波[2]和平均梯度归一化[3]等)是可以简化的。更重要的是,简化这些误差消除操作能加快目标检测的过程,在大幅宽图像上即使是简单滤波的耗时也是不可忽视的,将有限的星上资源利用在其他过程以提升精度是更好的选择。

|

| 图 2 面向图像块的局部不精确分割效果比较 Fig. 2 Comparsion of patch-oriented local imprecise segmentation effect |

| 图选项 |

1.2.2 邻域三帧差分法 基于1.2.1节分析及现有研究成果[12, 14],本节利用基于邻域考虑的三帧差分法快速获取目标候选区域,在计算差分图像的同时执行滤波操作来抑制局部噪声,保证检测质量。计算公式如下:

| (1) |

式中:N为邻域;It为第t帧图像;It′为相邻的t-1和t+1帧图像;Dres为差分图像,取值为It内各像素点与相邻帧对应位置邻域内的最小差值,本文中邻域的尺寸为3×3。

差分图像中目标和背景处于不同的灰度级,因此需通过阈值分割(二值化)提取出运动区域,多数文献基于最为著名的大津法OTSU[3]自适应地确定分割阈值GT:

| (2) |

式中:ω和μ分别为某类像素占图像的比例和平均灰度,下标0和1分别为背景和前景。但在大幅宽遥感图像中,本文认为低阈值分割是更优的选择,一方面其能降低漏警率,遥感图像中存在不同亮度的车辆及道路背景,且目标与背景的大小比例极度悬殊,这不符合OTSU法以最小化类内方差为目标求取最优值的理论前提,易导致低速运动或与背景相似的目标被漏检、分离,较低阈值则可更好地保留这类复杂目标。另一方面,由于事先引入邻域考虑来计算差分图像,多数局部噪声已被有效抑制,因此低阈值分割并不会造成虚警率的显著增加。

1.2.3 任务驱动的误差处理 地物的复杂环境决定了误差处理的必要性,本节采用基于任务驱动的局部处理替代主流分割算法中直接的全局优化操作。其出发点在于:幅宽数十公里的遥感图像内,地物间的强相关性只存在于局部范围,并非整幅图像都需要进行对比度增强、拼接线消除等操作。现有算法统一地使用某种滤波器执行全局锐化或去噪处理,虽然能增强某一区域的图像质量,但也意味着在正常区域执行了不必要的计算。因此有针对性地根据局部的具体情况,如运动视差、目标模糊或光照不一致等,选择对应的消除算法,相比全局性的统一操作不仅处理速度快,而且在保证了该区域图像质量改进的同时杜绝其他区域产生额外误差造成虚警的可能。

与传统算法中先进行全图去噪,再计算差分图像、精确定位动目标的流程不同,本文采用自顶向下的思路,先粗糙确定目标位置(即任务范围),再执行局部操作提升分割精度。得益于CNN输入图像块具有容忍小目标局部不精确的优势,拼接线、视差、配准不精确等易导致虚警但不会造成目标漏检的误差,本文在提取候选目标区域后再分别对其执行消除操作。而在计算差分图像前仅重点关注对结果影响显著的光照变化问题,过程如下:

1) 提取光照变化区域。图像内光照变化区域面积通常远大于单一小目标,其在差分图像上呈现一定的规模及几何特征,因此先执行形态学分析,再根据各连通分量的面积及边缘线段来提取各光照不一致区域。

2) 局部直方图匹配。获取目标区域后,对相邻帧图像的每个变化区域分别建立灰度级映射关系,使原始图像的直方图匹配特定的形状。由于遥感成像机理复杂,拍摄角度、阴影变化、树叶摆动都会导致相邻帧对应区域的灰度级不能完全匹配,因此在光照问题上,局部处理能精准消除亮度不一致,同时避免在光照正常区域执行无效的匹配,产生大量误差。

2 基于密度聚类和模拟退火的相邻对象合并 获取不规则的候选动目标区域后,需将其扩展为矩形图像块作为CNN模型的输入。考虑到在目标高密度聚集位置直接拓展每个候选区域为矩形块,会导致相邻块之间出现大量的重叠部分,浪费计算资源,因此问题转化为二维空间矩形聚类(合并)的最优化求解,迭代地合并邻近图像块以减少检测次数和计算量。

本节首先基于密度聚类算法,利用最大空间尺寸约束将目标区域划分为相互独立的簇,通过剔除孤立点并对各簇分治处理的方式来缩小问题搜索空间。随后以最小化输出图像块的面积和数量作为优化目标,以各核心对象为初始点,依据相对密度权重动态确定遍历顺序。在迭代合并过程中,引入模拟退火思想概率选取当前状态下的次优解,以跳出局部最优。

2.1 关键问题分析

2.1.1 目标规模大及分布不均匀 大幅宽遥感图像,特别是以城镇、高速公路等为拍摄背景的图像,可能同时采集到成百上千的动目标,且其空间分布受到所处的复杂地物环境约束,变化过程难以建模,无法根据先验信息初始化聚类个数、中心点、大小等参数。在相关的无监督聚类研究中,原型聚类算法k-均值、高斯混合模型(Gaussian Mixed Model,GMM)[15]或层次聚类(Hierarchical Clustering,HC)算法等需多次更新对象间距离关系,不仅计算量大,且不适合处理非球型、大小不同的簇。相比之下,先验参数少、对噪声和聚类形状不敏感的空间密度聚类算法[16]——DBSCAN在本问题中具备更好的鲁棒性。

DBSCAN算法是最经典的基于密度峰值的空间聚类算法,其以数据在空间分布上的稠密程度为依据进行聚类,主要思想是从某个核心对象出发,不断向密度可达的区域扩张,从而得到一个内部任意两点密度相连,包含核心和边界对象的最大化区域(簇),不在簇内的对象则视为噪声。其优点是:无需预先设定聚类个数,能够发现任意形状的簇并有效剔除噪声。劣势是:原始算法在全局范围内使用2个固定参数(即邻域大小ε和密度阈值MinPts)来定义数据的密度范围及稠密程度,当空间数据的密度分布不均匀时,会导致聚类质量较差。

本文所检测车辆动目标的空间分布形状多样,如长条形(市内公路)、环形(高架桥)、十字形(交叉路口),因此其本质上可看作是一个非凸稠密的数据集,适用于DBSCAN的思想进行区域划分,但需解决算法自适应问题。

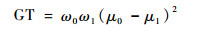

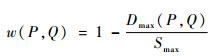

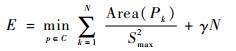

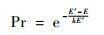

2.1.2 易陷入局部最优 在多数环境下目标稀疏分布,相邻块合并存在唯一解,如图 3(a)、(b)所示,圆形范围的中心为各运动目标位置,矩形框为最终输出结果,但在目标密集区域,图像块合并的先后顺序对结果影响显著,如图 3(c)所示,这使得解空间数量庞大,难以在有限时间内遍历得到最优解,可考虑引入随机效应跳出局部最优。其中,模拟退火算法[17]在随机搜索中的使用最为著名,其思想来源于模拟高温晶体的物理退火原理,最早于20世纪80年代由Kirkpatrick和Vecchi[18]提出并用于解决组合优化问题。在给定目标函数E时, 可根据Metropolis准则,引入温度参数T和玻尔兹曼常数k来动态地调整优化过程中接受次优解的概率为:Pr=e-ΔE/(kT),最终通过随机搜索策略跳出局部极小,达到全局最优。

|

| 图 3 基于SC-DBSCAN算法的分簇结果 Fig. 3 Clustering results by SC-DBSCAN algorithm |

| 图选项 |

空间图像块的合并也可看作是求取最优解的问题,本文以最小化图像块数量及面积作为优化目标,等价于求解模拟退火中的能量最低状态,迭代选择图像块的合并过程则可理解为退火中的温度冷却阶段。因此理论上模拟退火的思想能够指导图像块合并过程,提升图像块质量。

2.2 基于空间约束的密度聚类算法 基于分治思想将数据划分为不同大小的簇,各簇相互独立且与原问题性质相同,因而可减少每个子问题的搜索空间。本节针对该任务设计了一种新的基于空间约束的自适应密度聚类算法,并将其称之为SC-DBSCAN,不同于经典的DBSCAN算法需预先设定2个固定参数值对邻域和密度进行硬划分,其通过约束先验能够自适应地为每个对象定义邻域大小,并对每个对象的相对稠密程度赋予权重表示,解决全局密度分布不均匀问题。其中,空间约束这一前提是合理的,因为CNN模型执行卷积计算的时空间复杂度与输入的图像尺寸呈正相关,包含待检测目标的每个图像块都不能无限制地扩展大小。

2.2.1 基本定义 在给定二维矩形数据集D及对象合并的最大尺寸约束Smax下,本文定义相关概念如下。

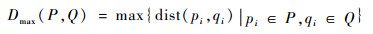

1) 距离权重。对任意图像块P和Q,定义w(P, Q)来度量其可合并程度。

| (3) |

| (4) |

式中:pi和qi分别为2个图像块内的任意点。距离计算使用各坐标数值差的最大值即Chebyshev距离:

| (5) |

权重w表示图像块的关联程度,当其为负数时,图像块的关系超出空间约束,无可行的合并方案。

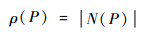

2) 邻域及密度。对于?P∈D,定义其邻域N(P)为包含所有可与P合并的对象集合:

| (6) |

邻域内的对象数即为P的密度ρ(P):

| (7) |

3) 核心、边界、噪声对象。对于?P∈D,根据其与邻域内对象的密度关系进行分类:

① 核心对象Pc。定义P为核心对象的条件是?Q∈N(P)且N(P)≠?时, ρ(P)≥ρ(Q)。

② 边界对象Pb。当P不属于核心对象,但其落在某个核心对象的邻域内时,定义其为边界对象。

③ 噪声对象Pn。当P既不是核心,也不是边界对象即N(P)=?时,定义其为噪声对象。

4) 相对密度。给定对象P和Q∈N(P),定义Q相对于P的密度u(P, Q)为

| (8) |

相对密度是非对称的,即u(P, Q)≠u(Q, P)。

5) 密度可达。假设存在对象链P1, P2, …, Pn,对Pi∈D, 有Pi∈N(Pi+1),那么称对象P1和Pn是密度可达的,密度可达是对称的。

6) 簇。从某个核心对象出发,不断地向密度可达区域扩展,其内所有对象构成一个簇,不在簇内的视为噪声。

2.2.2 目标区域分簇 对空间中给定的一系列分布不均匀矩形区域,其分簇过程可看作图论中连通分量的构建,SC-DBSCAN算法过程如下:

1) 将所有对象按定义分别标记为核心对象、边界对象和噪声对象。

2) 邻域大小为空、不存在合并可能的噪声对象,可直接扩展为单一图像块输出,如图 3(a)所示。

3) 互相在对方邻域内的核心对象之间构建一条边,每组连通的核心对象形成一个簇。

4) 将边界对象归类到所属核心对象的簇中。

5) 当某一簇内所有对象都在各自邻域的交集中,即只存在核心对象时,称其为简单簇,如图 3(b)所示。简单簇在满足空间尺寸的约束下仅需要一个最小包围框即可覆盖所有对象,因此可以直接得到固定解。否则称其为复杂簇,如图 3(c)所示。复杂簇存在多种合并策略,需引入模拟退火思想迭代求解。

2.3 基于模拟退火思想的复杂簇对象合并算法

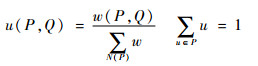

2.3.1 目标函数 本节使用对CNN模型输入影响较大的评价指标作为对象合并的准则函数E(等价于模拟退火算法中的能量函数), 给定一个复杂簇C,相关定义如下:

| (9) |

式中:Area(Pk)为图像块k的面积; γ为用于权衡两项指标的因子,当其较大时,算法更倾向于合并距离更远的图像块,这在导致总数量减少的同时可能增加面积。

目标函数包含了输出图像块的总面积和数量,前者决定CNN的计算量,后者决定了CNN需要执行的推断次数。

参数γ保证了本文方法可适用于丰富的应用场景。例如对低轨微纳卫星而言,星上计算资源有限,无法部署以大尺寸图像为输入的CNN模型,因而可降低γ值实现最小化图像块面积;反之,地面高性能平台以实时处理为主要需求,最小化图像块数量以减少CNN模型的推断次数则是更优的选择。

2.3.2 基于模拟退火思想的邻域对象合并 各复杂簇间相互独立,因此可实现并行化处理。基于模拟退火思想的邻域对象合并过程如下:

1) 在某一复杂簇中以核心对象为中心点P′。

2) 按照相对密度u大小降序进行合并,即优先将中心点P′与邻域N(P′)内距离最近的对象用生成的最小包围框替换,并计算能量函数E。

3) 引入随机扰动,对中心点P′以概率u(P, Q)选取邻域内对象Q做合并,计算新的能量函数E′。

4) 当ΔE=E′-E < 0时,接受E′作为新解,否则按照Metropolis准则定义概率:

| (10) |

式中:k为0~1范围内的随机数。当概率Pr > k时,接受E′作为新解,扰动过程在目标函数不再变化时停止。

5) 输出生成的最小包围框并重新计算各项权重,迭代上述过程直到没有对象可在空间尺寸约束下合并。

对象间是以距离为合并准则,因而在迭代过程中,进行合并的相邻块重叠度是逐渐降低的,这使得目标函数下降速度由快到慢,此过程等价于模拟退火思想中,概率在时间的推移下,随着温度冷却而逐渐降低。

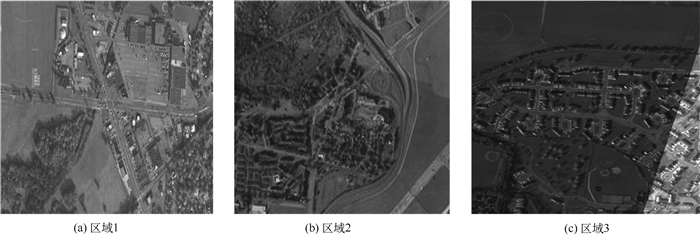

3 实验验证 3.1 数据集 本文使用美国空军实验室提供的公开数据集wpafb2009[19]进行实验,其包含了数千条车辆标注信息,传感器成像平台由6台相机按2行3列的形式排列组成,帧率为2帧/s,拼接后的图像尺寸达到2万像素×2万像素。为了与其他算法[2, 7, 12, 20]进行对照,本文参考Basharat等[20]的研究成果裁剪了3个区域用于实验。如图 4所示,区域1和区域2包含了交通要道上的大量车辆目标,用于比较最终生成的图像块质量,区域3用于比较光照变化处理。

|

| 图 4 wpafb2009数据集 Fig. 4 wpafb2009 dataset |

| 图选项 |

3.2 实验分析 本文算法包含基于图像分割提取候选目标、相邻块聚类合并2个独立模块,故将每个模块分别与对应的经典算法进行了对照实验分析。实验硬件环境为Intel Core i7-7700HQ 64位处理器、8 GB内存、NIVIDIA GTX 1050 4 GB显卡,编程语言为MATLAB。

3.2.1 候选运动区域提取方法比较 针对提取到的不规则候选运动区域,本节将对应算法与包含有全局误差处理过程的混合高斯背景建模法GMM[15]、标准三帧差分法S-3frame[4]以及邻域三帧差分法N-3frame[14]进行了相关的对照实验。如表 1所示,由于容忍了目标分离、融合等局部不精确误差,本文算法的精度有所降低,但3.2.2节实验验证了精度可在后续聚类过程中得到改进。

表 1 候选运动目标质量比较 Table 1 Qualitative comparison in candidate moving objects

| % | ||

| 算法 | 精度 | 召回率 |

| GMM | 92.72 | 83.53 |

| S-3frame | 89.06 | 75.76 |

| N-3frame | 91.37 | 87.73 |

| 本文算法 | 90.68 | 93.30 |

表选项

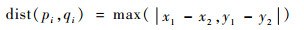

此外,本文算法显著提升了召回率,这是得益于低阈值分割策略,实验中的阈值设定为OTSU法的取值乘以权重系数0.6。如图 5(a)所示,低阈值分割提取到的白色不规则区域或是更为完整、贴近图中圆点所示的真实标注,或是能够检测和道路背景相似的深色车辆目标,有助于降低漏警率。

|

| 图 5 低阈值分割和OTSU阈值分割的效果比较 Fig. 5 Comparsion of low-threshold segmentation and OTSU threshold segmentation |

| 图选项 |

误差处理上,本节实验将局部光照处理策略和全局直方图匹配[12]、基于盒滤波的均值滤波算法[2]进行了对比,效果如图 6所示,图中圆点为目标的真实标记,白色区域为检测出的候选目标,在未经处理的图 6(a)中,由于相邻帧对应像素点的灰度差值大,光照变化区域被误分割为目标,形成了白色宽条带。在处理效果方面,大幅宽图像中的光照变化区域只占据小部分面积,简单的全局直方图匹配无法精确地定位局部的光照变化位置,且易产生额外噪声,如图 6(b)左下角树木的阴影处就错误地检测出运动信息。类似的,虽然均值滤波能够缓解光照不一致现象,但由于边缘像素邻域同时包含了亮度正常和变化的2种情况,均值无法准确表达像素点受到的光照强度,导致边缘亮度匹配的效果较差,同时滤波器还造成部分目标被过度模糊,融合在背景中而遭漏检,这些在图 6(c)中体现为边缘产生2条白色细条带及道路上圆点标注的部分车辆未被分割为目标。与现有算法不同,本文通过差分图像定位光照变化区域再分别处理,使得直方图能够更好地表达局部光照强度,图 6(d)中算法很好地消除了光照条带,在不产生额外误检测的同时位于该区域内的目标也能被完整地分割检测到。

|

| 图 6 相邻帧光照变化处理比较 Fig. 6 Comparison of illumination in neighbor frames |

| 图选项 |

计算速度上,本文算法在区域3的光照处理速度比全局直方图匹配快2.3倍,比基于盒滤波器的均值滤波法快8.9倍,这得益于光照变化区域平均仅占全图的2.5%。此外,实验在区域1、2中提取到的候选目标区域平均仅占全图的6.1%,使得对应的高斯模糊、平均梯度抑制等用于消除拼接线、视差的操作范围大幅度缩小。

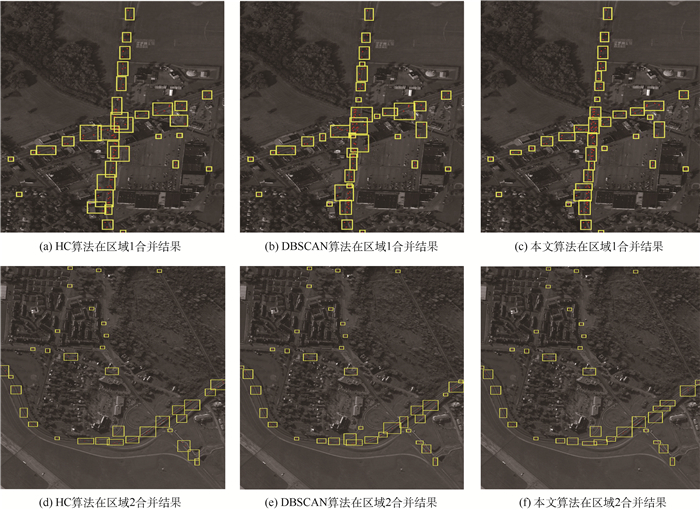

3.2.2 相邻块聚类合并算法比较 对于生成图像块的质量评估,本节实验将直接拓展不规则区域为矩形块的方法作为本文相邻块合并方法的参考基线,将经典层次聚类算法HC和空间密度聚类算法DBSCAN作为对照算法进行比较。

评价指标上,除精度与召回率外,本文重点分析了对CNN模型影响较大的评价指标,即输出图像块的总数量、面积以及重复出现在不同区域内的目标数量,其值等价于CNN所浪费的冗余检测。这3个指标除以真实人工标注所对应的取值后得到比率。

参数取值上,考虑到CNN一方面需提供部分背景信息作为辅助检测,或实现多目标同时检测,另一方面需避免每次推断阶段占用过多内存和计算资源,本节参考LaLonde等[4]将默认图像块尺寸设为64×64,合并最大尺寸约束为256×256。

表 2展示了固定参数γ值为0的结果。如表 2所示,得益于相邻目标的合并过程,不精确分割导致的局部目标分离或运动视差、配准造成的误检测都可能在迭代过程中和包含目标的图像块融合输出,由于本文选取目标高度集中的交通要道作为实验数据,因此精度提升显著,但需要指出的是,在目标稀疏分布区域,聚类对精度的提升能力还是有限的,精度主要取决于图像分割和局部误差处理过程。

表 2 最终图像块质量比较 Table 2 Qualitative comparison of final image patches

| 算法 | 精度/% | 召回率/% | 数量比 | 面积比 | 重复比 |

| 基线 | 90.98 | 93.96 | 1.2241 | 1.2241 | 1.4804 |

| HC | 98.60 | 94.25 | 0.3876 | 1.1049 | 0.0843 |

| DBSCAN | 98.59 | 94.15 | 0.4018 | 1.1053 | 0.0999 |

| 本文算法 | 98.79 | 94.34 | 0.3818 | 1.0586 | 0.0756 |

表选项

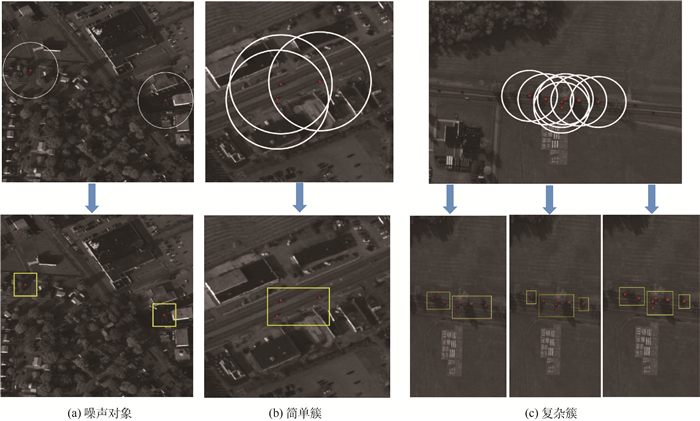

此外,表 2显示本文相比经典聚类算法能够更好地降低图像块的数量、面积和重复率,从数据预筛选的角度为CNN模型的高效检测提供了支持。利用本文SC-DBSCAN算法对数据进行分簇后,可有效根据目标密集程度选择简单或复杂的策略进行相邻对象合并,实现自适应处理。如图 7所示,在目标离散稀疏分布区域,最优解固定,因而所有算法的结果是一致的,但在十字路口、高速公路等目标高密度聚集区域,经典HC和DBSCAN算法生成的图像块存在尺寸较大且相互重叠的情况,而本文算法能够以更少面积和数量的图像块来提取候选目标,区域中目标的聚集密度越高,算法的优势就越大。

|

| 图 7 不同算法在区域1、2的合并结果 Fig. 7 Merging results by different algorithms in Region 1 and Region 2 |

| 图选项 |

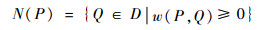

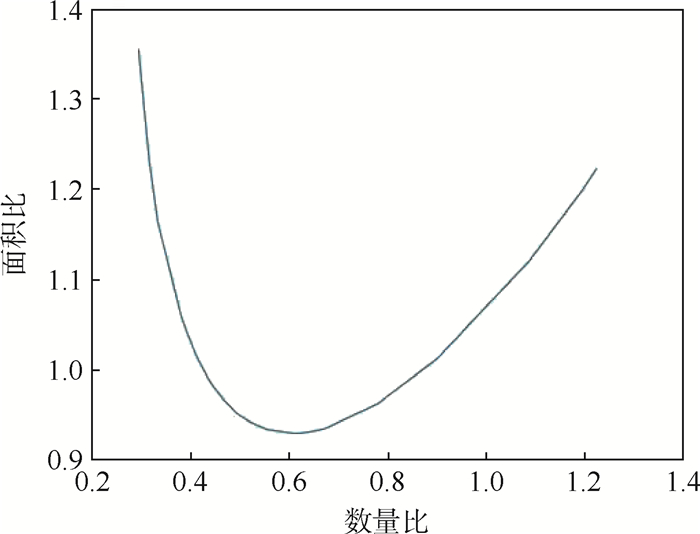

表 3和图 8同时展示了目标函数的权重参数γ递减对结果的影响。在wpafb2009数据集中,本文算法可同时减少总数量和面积(-0.02 < γ < 0.06时),其中数量最多可在测试数据集中减少到原来的30%以内(γ > 0.3时)。参数γ的取值增加意味着算法更注重减少图像块数量,等价于允许2个密度较稀疏的不相交图像块进行合并,但这可能在进一步减少数量的同时导致2个对象的最小包围框面积增加。具体参数值的设定取决于算法在实际应用时,对应的CNN模型特点及所部署平台的各项计算约束条件。

表 3 参数γ对结果的影响 Table 3 Impact of parameter γ on result

| 权重γ | 数量比 | 面积比 |

| -0.05 | 1.1963 | 1.2008 |

| -0.02 | 0.7792 | 0.9626 |

| 0 | 0.6108 | 0.9299 |

| 0.03 | 0.4947 | 0.952 |

| 0.06 | 0.4352 | 0.9921 |

| 0.1 | 0.3818 | 1.0586 |

| 0.3 | 0.2973 | 1.341 |

| 0.55 | 0.2953 | 1.356 |

表选项

|

| 图 8 参数γ对最终图像块数量和面积的影响 Fig. 8 Impact of parameter γ on final image patches' amount and area |

| 图选项 |

4 结论 本文为大幅宽图像下的CNN动目标检测模型提出了一种多尺寸运动图像分块提取方法,在目标候选运动区域筛选、相邻对象合并等问题上进行了深入分析并给出了相应的优化算法。相关成果能够用于在不同的神经网络模型、系统操作平台上进行对应的数据预筛选操作,为避免遥感数据爆炸、快速获取运动目标的高价值信息提供了帮助。

1) 算法方面。本文主要基于目标运动信息实现数据筛选,而事实上基于显著性检测的算法在兴趣区域提取的研究中更类似于人类的视觉感知过程。一些利用生物视觉感知模型,对目标阴影、形状、颜色等信息进行显著性提取的算法[5, 6, 21]能够有效加快遥感典型目标检测效率,且同样适用于河流等分割算法无法处理的复杂非刚体目标运动[22]。未来研究将尝试把本文算法与显著性检测相关的视觉感知算法融合,以实现更准确地快速提取候选目标区域。

2) 应用方面。虽然本文所提取的图像块是以CNN的输入作为用途,但相关算法的应用场景并不局限于此,其可用于卫星在轨预筛选运动目标,避免星地间数据的冗余压缩、传输;也可用于从海量遥感视频中提取目标检测的数据集,并结合运动及外观特征进行标注,为CNN模型在轨训练提供基础等。后续研究中,算法将被部署在中国首颗软件定义卫星“天智一号”上进行在轨实验验证,以期待减少数据存储和计算上的冗余,进一步实现星上加速及智能的运动目标检测。

参考文献

| [1] | 徐伟, 金光, 王家骐. 吉林一号轻型高分辨率遥感卫星光学成像技术[J]. 光学精密工程, 2017, 25(8): 1969-1978. XU W, JIN G, WANG J Q. Optical imaging technology of JL-1 lightweight high resolution multispectral remote sensing satellite[J]. Optics & Precision Engineering, 2017, 25(8): 1969-1978. (in Chinese) |

| [2] | MARK K, LUIS G, CHRIS S.Real-time tracking of low-resolution vehicles for wide-area persistent surveillance[C]//Workshop on Application of Computer Vision.Piscataway, NJ: IEEE Press, 2013: 441-448. |

| [3] | IMRAN S, MUBARAK S. Multiframe many-many point correspondence for vehicle tracking in high density wide area aerial videos[J]. International Journal of Computer Vision, 2013, 104(2): 198-219. |

| [4] | LALONDE R, ZHANG D, SHAH M.ClusterNet: Detecting small objects in large scenes by exploiting spatio-temporal information[C]//Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ: IEEE Press, 2018: 4003-4012. |

| [5] | GAO F, ZHANG Y, WANG J, et al. Visual attention model based vehicle target detection in synthetic aperture radar images:A novel approach[J]. Cognitive Computation, 2015, 7(4): 434-444. DOI:10.1007/s12559-014-9312-x |

| [6] | GAO F, MA F, ZHANG Y, et al. Biologically inspired progre-ssive enhancement target detection from heavy cluttered SAR images[J]. Cognitive Computation, 2016, 8(5): 955-966. DOI:10.1007/s12559-016-9405-9 |

| [7] | BLASCH E, CHEN G, LING H.Vehicle classification in WAMI imagery using deep network[C]//Sensors and Systems for Space Applications.New York: SPIE, 2016: 9838-9846. |

| [8] | REN S, HE K, GIRSHICK R, et al.Faster R-CNN: Towards real-time object detection with region proposal networks[C]//International Conference on Neural Information Processing Systems.Cambridge: MIT Press, 2015: 91-99. |

| [9] | REDMON J, DIVVALA S, GIRSHICK R, et al.You only look once: Unified, real-time object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2016: 779-788. |

| [10] | LIU W, ANGUELOV D, ERHAN D, et al.SSD: Single shot multibox detector[C]//European Conference on Computer Vision (ECCV).Berlin: Springer, 2016: 21-37. |

| [11] | DAI J, LI Y, HE K, et al.R-FCN: Object detection via region-based fully convolutional networks[C]//Advances in Neural Information Processing Systems.Piscataway, NJ: IEEE Press, 2016: 379-387. |

| [12] | SOMMER L W, TEUTSCH M, SCHUCHERT T, et al.A survey moving object detection for wide area motion imagery[C]//Winter Conference on Applications of Computer Vision (WACV).Piscataway, NJ: IEEE Press, 2016: 1-9. |

| [13] | 罗群明, 施霖. 图像拼接方法综述[J]. 传感器与微系统, 2017, 36(12): 4-6. LUO Q M, SHI L. Review on image stitching methods[J]. Transducer & Microsystem Technologies, 2017, 36(12): 4-6. (in Chinese) |

| [14] | THOMAS P, MATTHEW A.Detecting and tracking all moving objects in wide-area aerial video[C]//Computer Vision and Pattern Recognition Workshops.Piscataway, NJ: IEEE Press, 2012: 15-22. |

| [15] | ZIVKOVIC Z.Improved adaptive Gaussian mixture model for background subtraction[C]//International Conference on Pa-ttern Recognition.Piscataway, NJ: IEEE Press, 2004: 28-31. |

| [16] | ESTER M, KRIEGEL H P, SANDER J, et al.Density-based spatial clustering of applications with noise[C]//International Conference on Knowledge Discovery and Data Mining.Reston: AIAA, 1996: 226-231. |

| [17] | 张小朋, 钱海忠, 岳辉丽, 等. 基于模拟退火的空间聚类算法[J]. 测绘科学技术学报, 2010, 27(4): 306-309. ZHANG X P, QIAN H Z, YUE H L, et al. Simulated-annealing based spatial clustering algorithm[J]. Journal of Geomatics Science & Technology, 2010, 27(4): 306-309. DOI:10.3969/j.issn.1673-6338.2010.04.018 (in Chinese) |

| [18] | KIRKPATRICK S. Optimization by simulated annealing:Quantitative studies[J]. Journal of Statistical Physics, 1984, 34(5-6): 975-986. DOI:10.1007/BF01009452 |

| [19] | AFRL.Wright-patterson air force base (wpafb) dataset[EB/OL].[2017-12-10].http://sdms.afrl.af.mil/index.php?collection=wpafb2009. |

| [20] | BASHARAT A, TUREK M, XU Y L, et al.Real-time multi-target tracking at 210 megapixels/second in wide area motion imagery[C]//IEEE Winter Conference on Applications of Computer Vision.Piscataway, NJ: IEEE Press, 2014: 839-846. |

| [21] | GAO F, YOU J, WANG J, et al. A novel target detection method for SAR images based on shadow proposal and saliency analysis[J]. Neurocomputing, 2017, 267: 220-231. |

| [22] | GAO F, MA F, WANG J, et al. Visual saliency modeling for river detection in high-resolution SAR imagery[J]. IEEE Access, 2018, 6: 1000-1014. DOI:10.1109/ACCESS.2017.2777444 |