目前的大部分目标跟踪算法可以被大致分为两类:随机性框架和确定性框架[2, 3].确定性框架通常使用梯度下降搜索以使代价函数达到最小,这类算法的典型是Mean Shift算法[4, 5].一般而言,确定性框架计算效率高,实时性好,但容易陷入局部最值.与之相对,随机性框架为了更大概率地达到代价函数的全局最值在搜索过程中引入了一些随机参数.采用随机性框架的典型算法是Kalman滤波算法[6]和粒子滤波算法[7, 8].与确定性框架相比,随机性的搜索方法更加鲁棒,但是它们所需的计算量很大,尤其是在高维状态空间进行估算时计算量的问题更加突出.在军事应用中,为了满足实时性的要求,计算效率高的Mean Shift算法得到了更为广泛的应用[3, 9].

尽管Mean Shift算法具有优良的性能,但其也具有一定缺点:①由于灰度目标所包含的信息较少,目标与背景的区别较小,Mean Shift算法容易收敛到局部最值,导致跟踪结果发生漂移[10];②Mean Shift算法对目标的旋转变化适应性较差[11];③由于缺乏有效的模型更新策略,Mean Shift算法往往无法适应目标的尺寸和形状变化[12].为了解决上述问题,研究者们提出了一些方法改进Mean Shift算法.如采用级联灰度空间来描述目标[13]或在似然比函数中加入局部背景信息[14],以增强Mean Shift算法区分目标与背景的能力;通过引入目标倾角[15]或用协方差矩阵作为高斯分布的带宽矩阵[11, 16],增强Mean Shift算法对发生旋转的目标的适用性;通过改变核窗宽度[17],改善Mean Shift算法对目标尺寸和形状变化的适用性.此外,为了进一步提高Mean Shift算法的性能,研究者们将Kalman滤波器与Mean Shift算法相结合[18, 19],以便同时利用两种跟踪框架的优点.利用Kalman滤波器对目标进行预估,再利用Mean Shift算法进行定位.这种策略不仅降低了Mean Shift算法在迭代过程中发散的风险,而且对于目标被遮挡的情况也能取得较好的跟踪效果.

虽然上述方法增强了传统跟踪算法的鲁棒性,但当图像中目标发生剧烈变化时,传统算法往往无法完成跟踪.本质原因在于传统跟踪算法要求相邻图像帧之间目标的灰度分布保持稳定.不幸的是,由于目标的快速运动、不规律的运动轨迹、发生翻滚或旋转等原因,目标在图像序列中很可能会发生剧烈变化,但传统跟踪算法对这些剧烈变化的灰度目标无能为力.

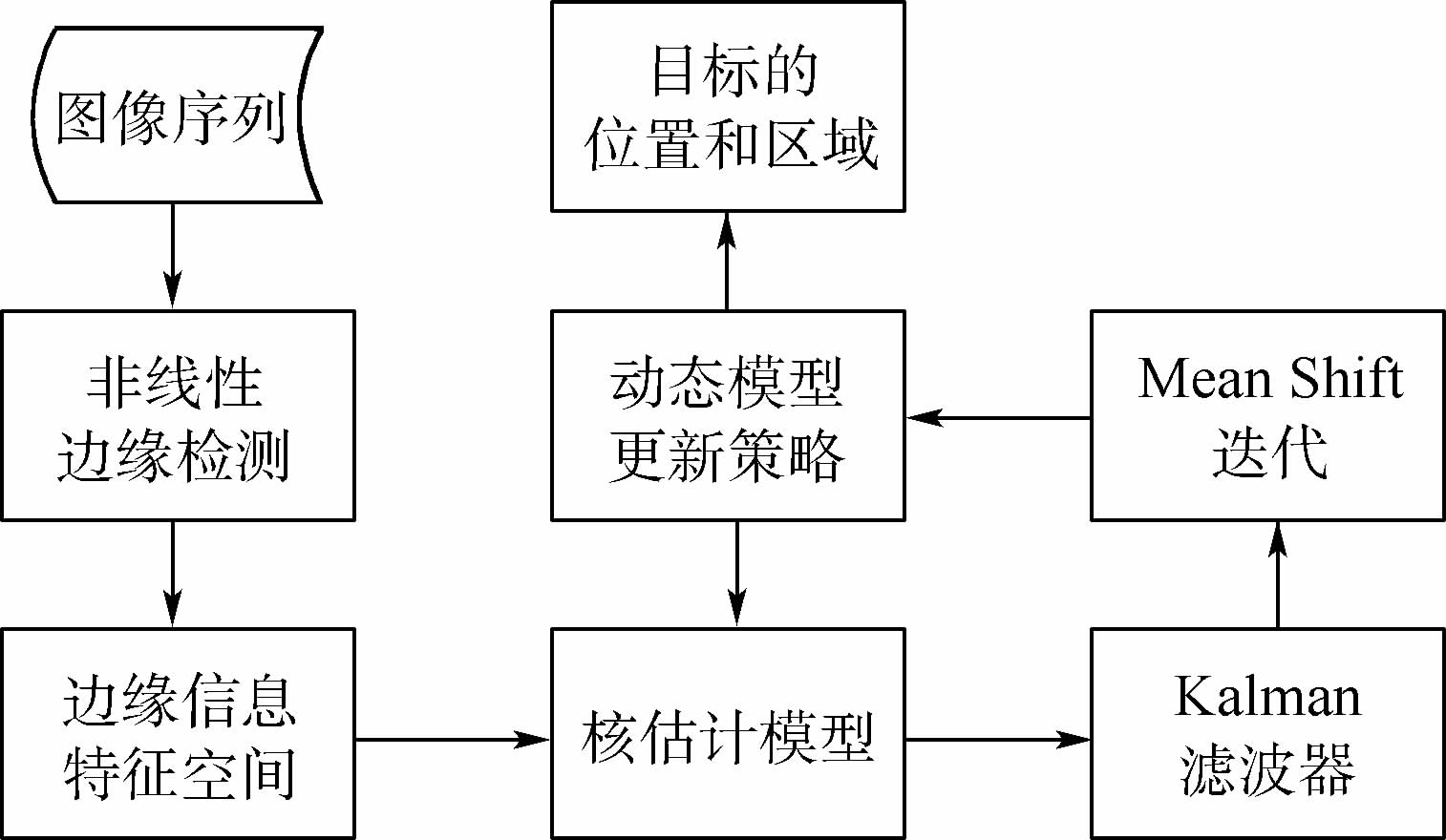

为了实现对剧烈变化灰度目标的跟踪,本文提出了一种基于边缘信息的目标跟踪算法.本文算法首先利用非线性边缘检测技术得到高质量的边缘信息;其次,提出了一种通过组合边缘图像来构建特征空间的方法,以解决单一边缘特征空间不能充分描述目标的难题;再次,使用核估计方法在构建的特征空间中对目标进行建模;在目标定位阶段,利用Kalman滤波器对目标进行预估,再由Mean Shift算法在预估位置邻近区域实现目标定位;最后,为了进一步提升算法表现,提出了一种基于形态学的动态模型更新策略.

1 基本动机选择合适的特征对于跟踪算法而言是很重的[20].为了保持目标跟踪的稳定性,跟踪算法必须根据应用目的选择合适的特征.一般来说,跟踪特征所拥有的特性最好具有唯一性,这样在其特征空间中目标可以很容易地被区分开.特征选择和物体的表征方法是紧密相关的.比如,颜色常被用于基于直方图类表征方法的特征,而边缘常被选为基于轮廓的表征方法的特征.

在灰度目标跟踪算法中最常选用的特征是灰度密度特征,但其在跟踪剧烈变化的目标时有一定的缺陷.首先,由于灰度目标所包含的信息不丰富,选择灰度密度特征时,目标与背景的区别不明显;尤其是当目标与背景的灰度分布较为相似时,跟踪算法很难完成跟踪任务.其次,由于目标的剧烈变化,跟踪算法很难应用已有的目标模型去定位目标在当前图像中的位置.

与灰度密度特征相比,在跟踪剧烈变化的灰度目标时,边缘特征具有以下特定优点:首先,边缘特征简单而准确,在跟踪目标边界的算法中,其经常被选为特征[20];其次,目标的边界在图像密度上容易产生很强的变化,采用边缘特征在跟踪过程中更容易精确地获得目标区域.

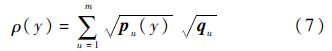

基于以上原因,本文选择边缘特征进行跟踪,并提出了一种基于边缘信息的灰度目标跟踪算法,其流程如图 1所示.接下来本文将对提出的跟踪算法进行详细介绍.

|

| 图 1 本文算法的流程Fig. 1 Flowchart of proposed algorithm |

| 图选项 |

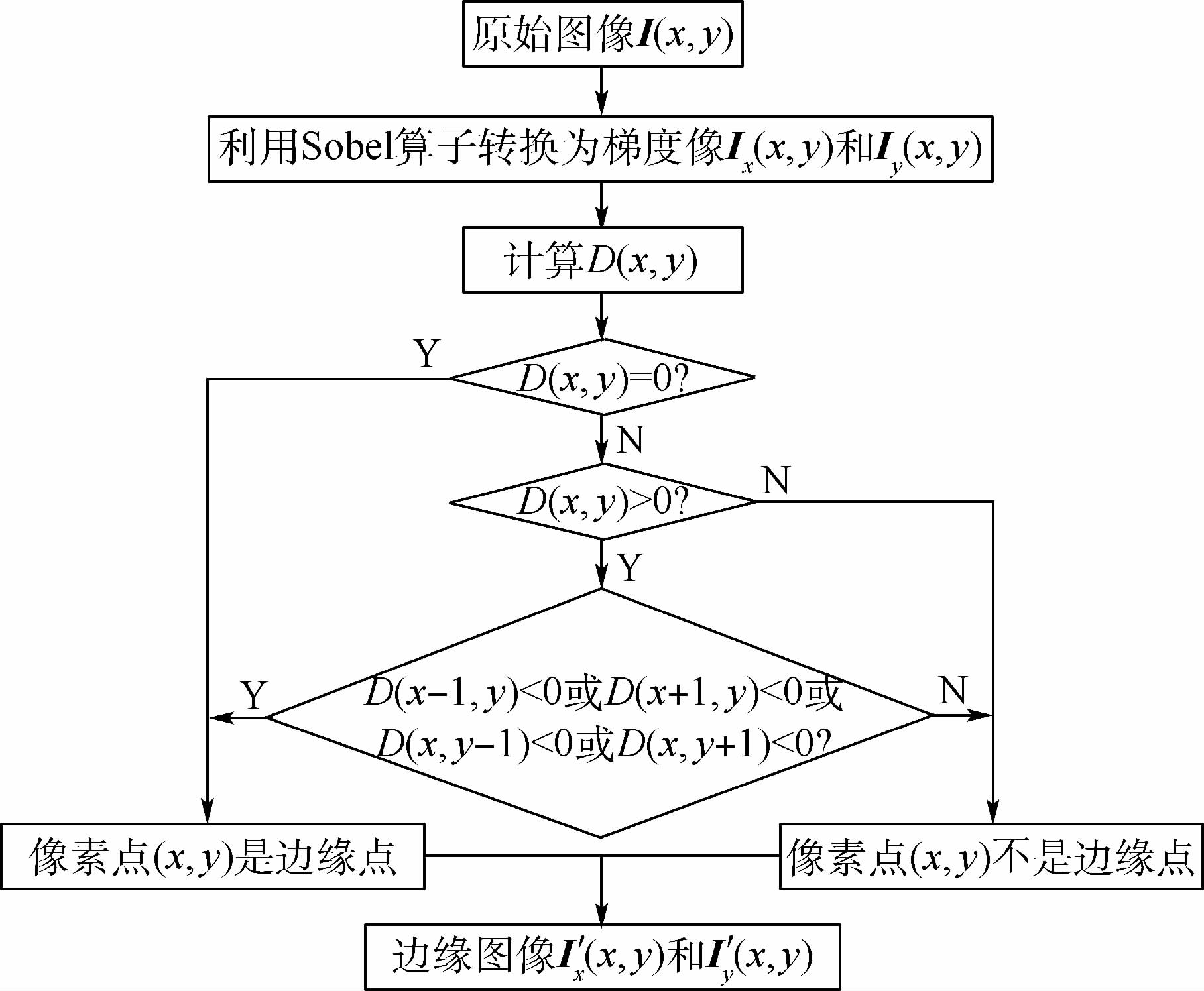

2 非线性边缘检测尽管边缘特征具有很多优点,但边缘容易受到背景噪声的干扰和遮挡.因此为了保证跟踪效果,首先要设法得到高质量的边缘图像.常用的线性边缘检测算子如Sobel、Prewit、Robert和Laplace等算子在加性高斯噪声条件下是最优解.但在复杂背景的灰度图像序列中,其背景噪声经常是非加性高斯的[21],此时线性算子得到的边缘图像不尽人意.这种情况下,采用非线性边缘检测算法可以有效抑制噪声并保留图像中目标的形状和边缘信息[22],这对实现基于边缘的跟踪有重要意义.因此,本文首先引入一种非线性边缘检测算法,以获得高质量的边缘,其流程如图 2所示.

|

| 图 2 非线性边缘检测算法流程Fig. 2 Flowchart of nonlinear edge detection algorithm |

| 图选项 |

本文采用的非线性边缘检测算法分两步进行:首先,为了凸显容易受到背景影响的小尺寸目标并抑制背景噪声,选用Sobel算子对原始图像边缘点进行初选[13];其次,利用双同心圆窗口算子[23]在初选图像中寻找真正的边缘.设I(x,y)为原始灰度图像,利用Sobel算子对原始图像进行水平向和垂直向滤波,得到初选图像Ix(x,y)和Iy(x,y).在初选图像中任取一个像素点s(x,y),以s(x,y)为圆心建立两个同心圆窗口W1(s)和W2(s),其半径分别为R1和R2,且满足R1<R2.定义gmax1和gmax2分别为同心圆窗口W1(s)和W2(s)中的灰度最大值,gmin1和gmin2是相应窗口中的灰度最小值.定义双窗口算子为

由于像素点s(x,y)任意选取,则D(s)值可能为正、零或负.边缘点的确定原则如下:如果D(s)=0,则该像素点是边缘点;如果D(s)>0,并且沿水平向和垂直向的4个邻域中至少有一个像素点处的D(s)<0,则该像素点也是边缘点.对Ix(x,y)和Iy(x,y)中所有像素点进行上述操作,即可得到最终的边缘图像I′x(x,y)和I′y(x,y).

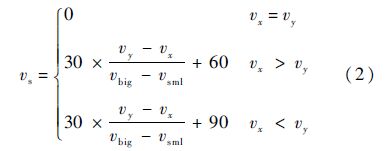

3 特征空间构建和目标描述方法3.1 特征空间构建单一的边缘特征空间包含的信息较少,不能有效地区分目标与背景;同时,在单一的边缘空间里描述目标时,噪声对其影响比较大,跟踪算法的表现不够稳健.这意味着利用单一边缘空间来描述灰度目标是不充分的.为了克服上述缺点,本文提出了一种通过组合边缘图像构造特征空间的方法.本文构造的特征空间可以增强真实的边缘并有利于目标跟踪,其具体实现方法如下:将第2节中得到的边缘图像I′x(x,y)和I′y(x,y)作为两个基本图像,构建一幅合成图像Is(x,y).对任意一个位置(x,y),假设其在I′x(x,y)中对应的灰度值为vx,其在I′y(x,y)中对应的灰度值为vy.将vx和vy之中较大的值记为vbig,较小的值记为vsml,则在合成图像Is(x,y)中对应于位置(x,y)的灰度值由式(2)确定:

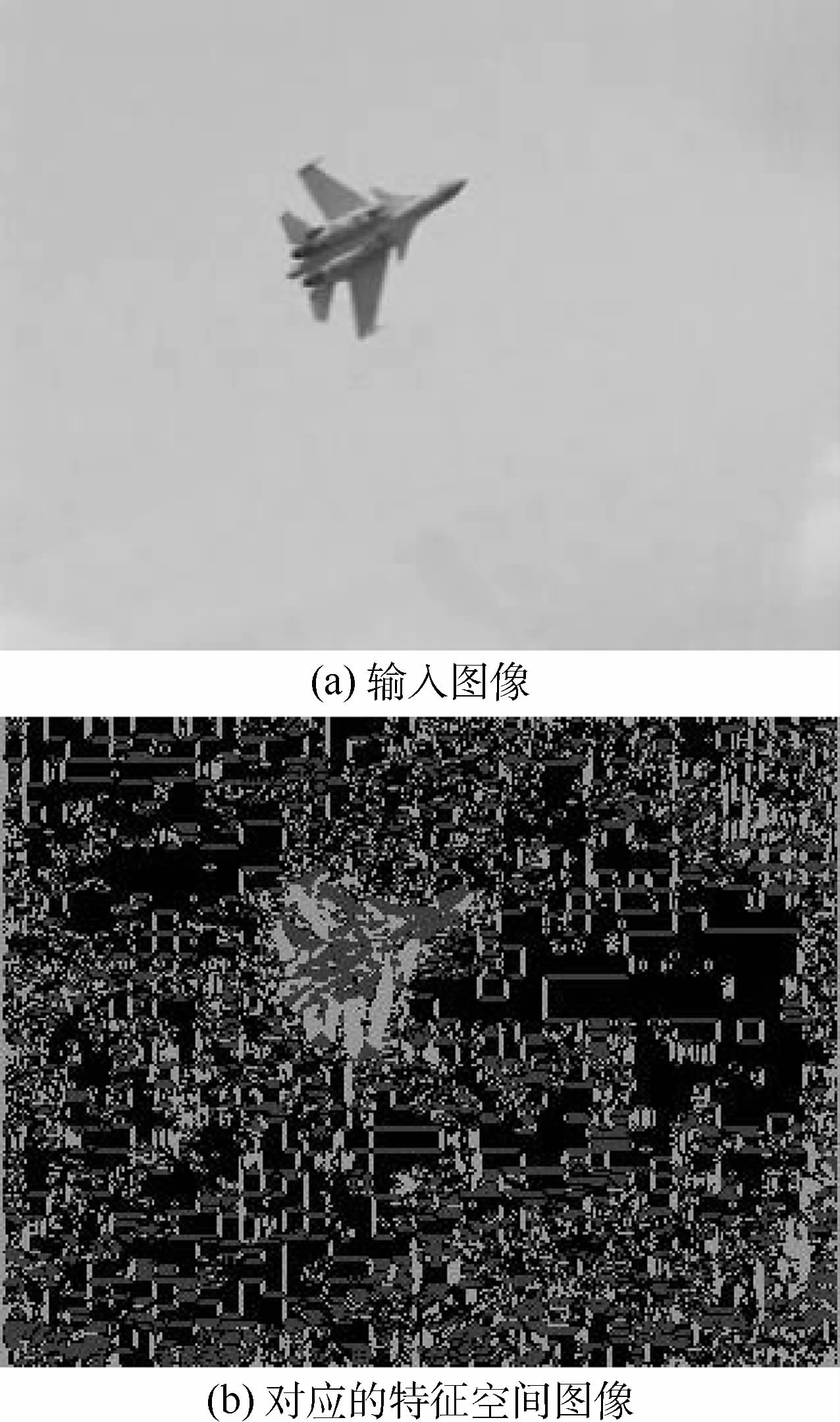

在一幅图像中,大部分的像素点都不是边缘像素点,它们对应的vx和vy均为0.因此,如式(2)所示,当一个像素点不是边缘像素点时,它对应的vs为0.当一个像素点是边缘像素点时,其对应的vx和vy必然不同时为0.如果vx大于vy,则其对应的vs被设定为30;反之,则其对应的vs被设定为120.事实上,vs也可以被设定为其他数值.比如,当vx>vy时,vs可以被设定为60或90;反之,vs可以被对应地设定为150或180.而且,本文可以将vx>vy时设定的vs值与vx<vy时设定的vs值进行对调.特征空间的建立目的是为了增强真实边缘,本文有多种方式对vs进行设定.但是,本文在108个图像序列上进行了大量实验,式(2)的形式具有最好的跟踪表现.本文将合成图像Is(x,y)用作特征空间.图 3展示了一幅输入图像和它对应的特征空间.

|

| 图 3 一幅输入图像和其对应的特征空间图像Fig. 3 An input image and its corresponding feature space image |

| 图选项 |

3.2 目标描述方法在构建的特征空间里,假设目标模型的像素集合为{xi}i=1,2,…,n,目标的中心位置为xc.为了满足实时性要求,对目标模型的像素进行量化.定义函数b(xi):R2→{1,2,…,m},用于表示像素xi的量化特征值.考虑到算法精度和运算量的限制,本文中量化级数取值为16.

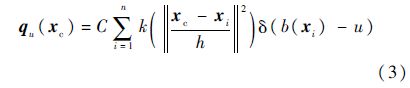

根据核估计理论,目标模型的量化特征概率密度分布可以描述为[5]

式中:k(·)为Epanechnikov核的剖面函数;δ(·)为狄拉克函数;u=1,2,…,m为不同的特征值;h为核窗口带宽;C为归一化常数,满足

.

.同理,对于候选目标也可以采用同样的方法进行描述.设候选目标像素集合为{xi}i=1,2,…,n,中心位置为yc,则候选目标的量化特征概率密度分布可描述为

式中:Cr为对应于候选目标的归一化常数.

4 目标的定位方法本文中目标的定位分为两个步骤:首先,利用Kalman滤波器对目标进行预估;其次,在预估位置邻近区域内利用Mean Shift算法进行迭代实现目标定位.这种策略既可以减小Mean Shift迭代过程中的发散风险,又可以提高算法的效率.

4.1 Kalman滤波器预估目标中心在每一帧图像中的位置构成了目标运动的轨迹.引入Kalman滤波器的目的是根据前一帧目标的中心位置预测当前帧中目标中心的可能位置.

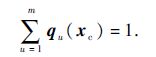

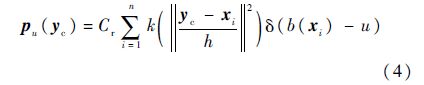

对于第k帧图像,Kalman滤波器的状态向量选取为X(k)=[x(k) y(k) x′(k) y′(k)]T,其中x(k)和y(k)分别表示目标中心的水平向坐标和垂直向坐标;x′(k)和y′(k)则分别表示目标中心在水平向和垂直向上的速度分量.观测向量为Y(k)=[xc(k) yc(k)]T,其中xc(k)和yc(k)分别表示目标中心在水平向和垂直向上的观测值.则Kalman滤波器可以由式(5)和式(6)表示[24]:

式中:W(k)为过程噪声;V(k)为观测噪声.初始值设为X(0)=[x0 y0 0 0],x0和y0分别表示初始帧中目标中心的水平向坐标和垂直向坐标.

4.2 Mean Shift算法定位Mean Shift算法核心思想是将目标的跟踪问题近似为一个Mean Shift最优化问题.Mean Shift算法使用Bhattacharyya系数来衡量目标模型与候选目标之间的相似性,其定义为

式中:qu和pu(y)分别为目标模型和候选目标的特征.ρ(y)的取值范围为[0, 1],其值越大表示目标模型与候选目标之间越相似.

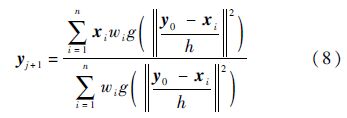

当前帧中位置y0处候选目标特征为pu(y0),根据Mean Shift理论[5],目标中心的迭代式为

其中函数g(x)满足g(x)=-k′(x),且有

通过求取y1完成第一次均值移位;随后令y1→y0进行下一次移位;如此反复,最终将取得Bhattacharyya系数的局部极大值,此时的位置即为当前帧中的目标位置.

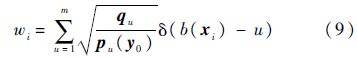

5 动态模型更新策略对于剧烈变化的灰度目标而言,由于快速运动、不规律的运动轨迹、发生翻滚或旋转等原因,目标外观在整个图像序列上变化较大.因此,固定的目标模型不能在整个图像序列上持续有效.为了进一步提升算法的性能,本文提出了一种基于形态学的动态模型更新策略,其流程如图 4所示.

|

| 图 4 动态模型更新流程Fig. 4 Dynamic model update process |

| 图选项 |

下面详细介绍其具体的实现方法.

步骤1 取边缘图像I′x(x,y)和I′y(x,y)作为两个通道,再将12(I′x(x,y)+I′y(x,y))作为第3个通道,合成一幅复合图像IC.将此复合图像转换为灰度图像IG.由于IC是由去除了边缘图像合成而来,因而IG中包含的是原图像中的边缘信息.

步骤2 为了让数学形态学有更好的表现,同时进一步去除背景的边缘,利用Canny算子对IG进行滤波得到二值图像.

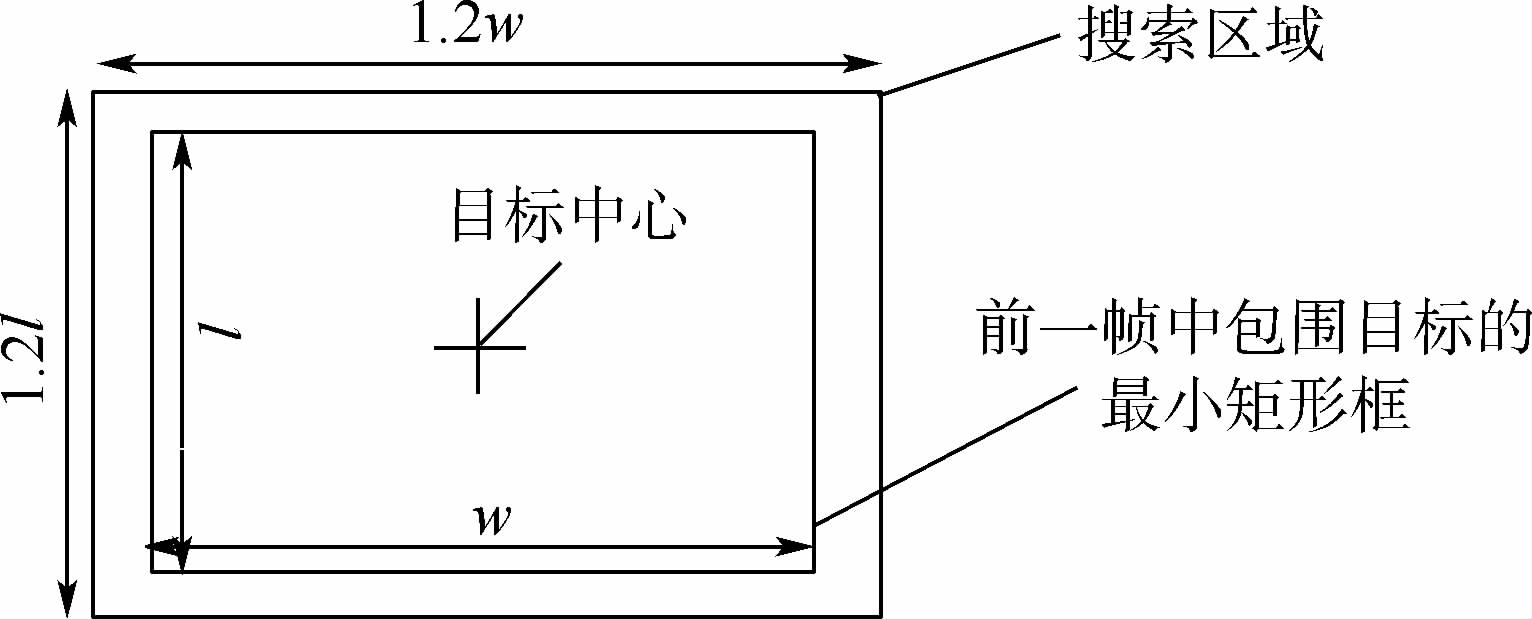

步骤3 对进行Canny滤波后的二值图像进行先膨胀后腐蚀的形态学操作.

步骤4 在特定的搜索区域内找出其中的最大连通域.假设上一帧中目标的长和宽分别为l和w.一般来说,目标在相邻两帧图像中的尺寸变化不超过20%.因此,本文在得到的二值图像中目标位置上选取长和宽分别为1.2l和1.2w的区域作为搜索区域,其示意图如图 5所示.

|

| 图 5 搜索区域示意图Fig. 5 Schematic diagram of search area |

| 图选项 |

步骤5 通过确定最大连通域的边界点即可获得目标的精确区域,然后利用第3.2节所述的目标描述方法,即可完成对目标模型的更新.

步骤6 在完成了目标模型的更新后,还需要更新Kalman滤波器的迭代参数,这样可以保证Kalman滤波器始终以最稳定的性能预测下一帧中的目标位置.具体方法是用Mean Shift迭代得到的目标中心替换当前帧中Kalman滤波器的观测向量.

6 实验结果及分析为了反映跟踪算法的性能,需要说明跟踪算法跟踪效果的表示方法.最常用来表征跟踪效果的评价准则是跟踪误差,其计算方法如式(10)所示[25]:

式中:Soi为目标的真实位置;Sri为跟踪算法得到的目标位置.跟踪误差可以反映出每帧图像中跟踪结果与目标真实位置之间的误差,其取值越小越好.为了直观地体现跟踪算法对一个序列整体的跟踪效果,本文使用平均跟踪误差进行评价,其定义为

式中:N为序列中图像的总数量.

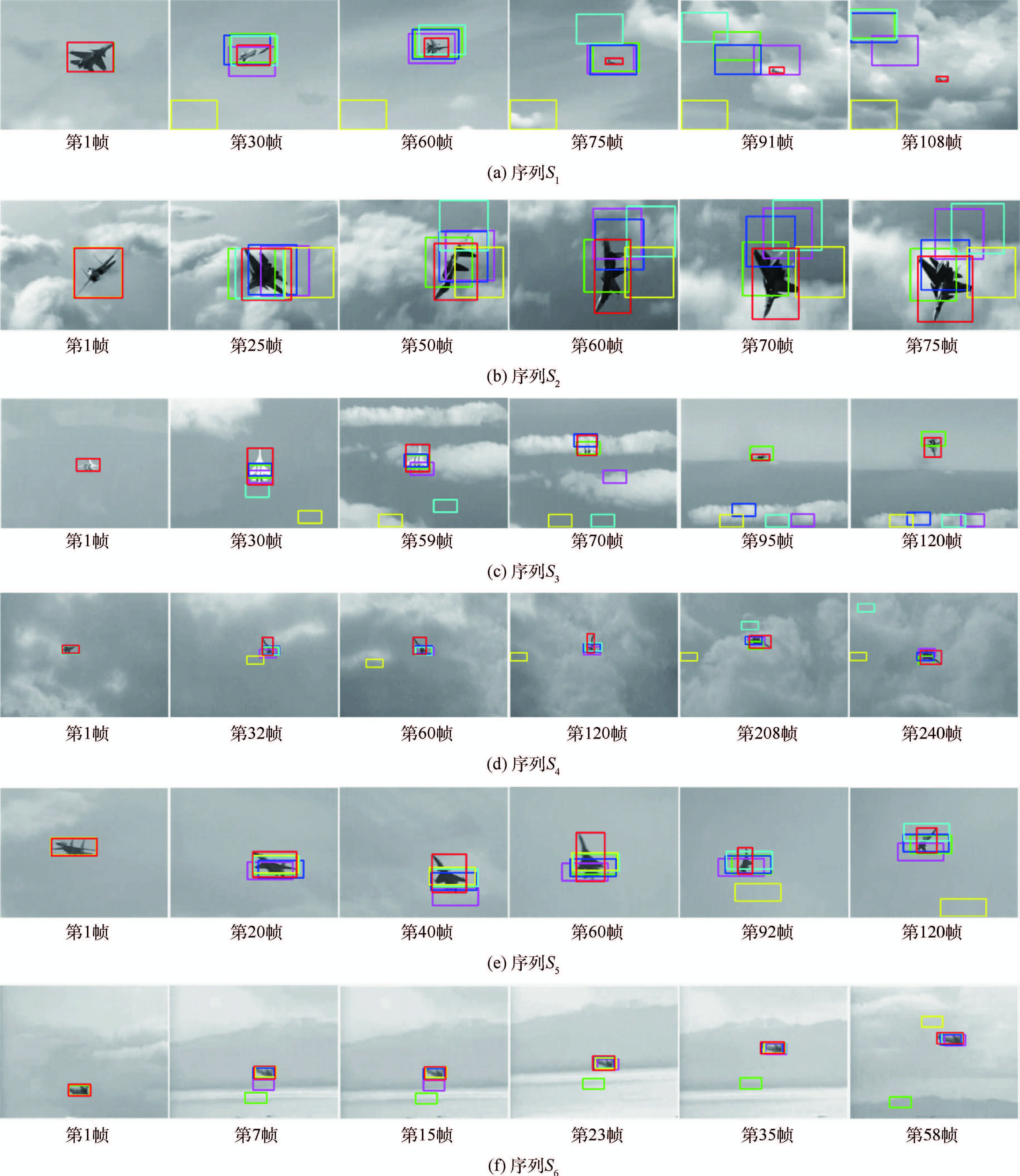

为了验证本文提出算法的有效性和鲁棒性,本文选取了6个包含剧烈变化灰度目标的真实图像序列进行实验.这6个图像序列被依次命名为S1~S6.在这些图像序列中,造成目标剧烈变化的原因包括极快的速度、不规律的运动轨迹、发生翻滚和大幅度的旋转等.本文将提出的算法应用到这些图像序列上进行跟踪实验,并与5个最先进的跟踪算法进行了系统地对比.这5个跟踪算法是分布域跟踪算法(DFT)[26]、最低软阈值平方跟踪算法(LSST)[27]、压缩跟踪算法(CT)[28, 29]、多任务稀疏学习跟踪算法(MTT)[30]以及结合了Kalman滤波器的Mean Shift跟踪算法(KMS).本文算法与5个对比算法定性比较的结果如图 6所示,定量比较结果如表 1和图 7所示.

由表 1可以看到,当使用DFT在序列S1、S3和S4上进行跟踪时,DFT在一半以上的图像帧中都丢失了目标.在这种情况下使用跟踪误差去评价算法的跟踪表现是没有意义的.因此,DFT在这3个图像序列上的跟踪误差在图 7中并没有画出.由于相同的原因,KMS和LSST在图像序列S3上的跟踪误差,以及MTT在图像序列S6上的跟踪误差在图 7中也没有画出.从图 6和表 1可以看到,在所有的6个序列上DFT的跟踪结果全部都是丢失目标;而KMS和LSST的跟踪结果中跟踪失败的序列数都达到了一半以上(4个).这说明DFT、KMS和LSST不能适用于跟踪剧烈变化的灰度目标.此外,DFT、KMS和LSST的平均跟踪误差远远大于MTT、CT和本文算法的平均跟踪误差,这也说明了前三者的跟踪性能远远落后于后三者.因此,在接下来的分析中,本文只专注于MTT、CT和本文算法的比较.

|

| 图 6 本文算法(红色)与KMS(品红)、MTT(绿色)、CT(蓝色)、LSST(青色)和DFT(黄色)的定性比较结果Fig. 6 Qualitative comparison result of proposed algorithm (red) with KMS (magenta),MTT (green),CT (blue),LSST (cyan) and DFT (yellow) |

| 图选项 |

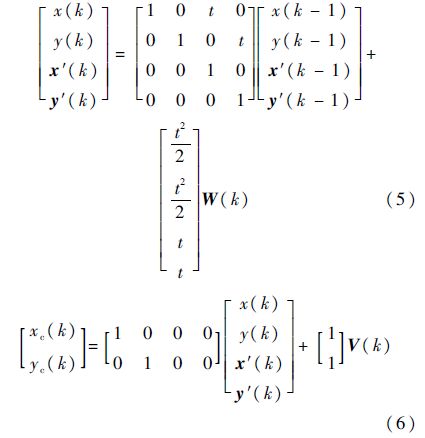

表 1 本文算法与KMS、MTT、CT、LSST和DFT的定量比较结果Table 1 Quantitative comparison result of proposed algorithm with KMS,MTT,CT,LSST and DFT

| 序列 | 帧数 | 目标丢失帧数 | 平均跟踪误差/像素 | ||||||||||

| 本文算法 | KMS | MTT | CT | LSST | DFT | 本文算法 | KMS | MTT | CT | LSST | DFT | ||

| S1 | 108 | 0 | 11 | 22 | 19 | 37 | 80 | 0.44 | 17.34 | 34.15 | 30.85 | 53.94 | 131.60 |

| S2 | 75 | 0 | 17 | 0 | 0 | 5 | 18 | 0.92 | 46.21 | 17.07 | 29.75 | 45.07 | 57.09 |

| S3 | 128 | 0 | 64 | 0 | 55 | 116 | 115 | 2.00 | 73.08 | 9.24 | 49.20 | 109.10 | 116.92 |

| S4 | 250 | 0 | 0 | 0 | 0 | 44 | 206 | 0.68 | 15.25 | 10.32 | 10.32 | 30.31 | 124.42 |

| S5 | 120 | 0 | 0 | 0 | 0 | 0 | 30 | 0.24 | 25.27 | 11.56 | 14.54 | 9.20 | 40.39 |

| S6 | 70 | 0 | 2 | 57 | 0 | 0 | 3 | 2.43 | 7.07 | 91.00 | 1.85 | 3.52 | 5.21 |

表选项

|

| 图 7 本文算法与KMS、MTT、CT、LSST和DFT的跟踪误差比较Fig. 7 Tracking error comparison of proposed algorithm with KMS,MTT,CT,LSST and DFT |

| 图选项 |

在序列S1中,目标尺寸由85×54剧烈变化至21×9,而且目标在运动过程中经历了显著的翻滚和旋转.从图 6中可以观察到,第108帧中的目标区域大小只有第1帧中目标区域大小的5%左右;由于目标模型是在第1帧中确定的,因此当前目标区域是由真实目标和占比95%左右的云层背景一起组成的.因此,目标很容易被具有与目标相似灰度分布的云层所干扰.MTT和CT都只能在前20帧中成功跟踪到目标,而在其后的许多图像帧中都丢失了目标.由图 7可以看到,本文算法的跟踪误差主要出现在18~30帧之间.这主要是因为目标在完成一个翻滚的战术动作,导致目标的机翼轮廓变得模糊,目标的机翼与云层难以区分,所以本文算法的跟踪结果没能获得完整的机翼区域.但如表 1所示,对于整个序列而言,本文算法的平均跟踪误差仅为0.44像素,跟踪表现远优于MTT和CT.这主要是因为本文算法基于边缘信息进行跟踪,不依赖于灰度分布,因而目标的尺寸变化以及与目标灰度分布相似的云层对本文算法的影响不大.

在序列S2中,目标在飞行过程中俯冲,并发生大幅度的翻滚和旋转,导致目标的外观发生很大变化.由图 6可以看到,MTT和CT的跟踪结果明显地偏离了目标区域,而本文算法可以获得目标的精确区域.对于MTT和CT而言,目标外观的剧烈变化意味着目标灰度分布的剧烈变化,从而导致了严重的漂移.如图 7所示,本文算法最大的跟踪误差出现在第50帧;此时目标在翻滚时机翼边缘变得极为模糊,与云层背景区分度很弱,因此本文算法没能获得目标的完整机翼区域,导致本文算法的跟踪结果出现了最大跟踪误差.但如表 1所示,本文算法的平均跟踪误差仅为0.92像素,远远优于MTT(17.07像素)和CT(29.75像素)的跟踪表现,在整个序列上表现优异.究其原因,是因为本文算法基于边缘信息建模,配合动态模板更新,能稳定利用前一帧的目标信息,进行最优匹配,再利用基于形态学的搜索,保证获得目标的精确区域.

在序列S3中,目标尺寸先由47×70剧烈变化至18×9,随后由18×9剧烈变化至32×40.同时,目标由天空背景快速运动到海天背景.目标的剧烈变化和复杂的背景极大地增加了跟踪难度.由图 6和表 1中可以看到,CT在全部128帧图像中的55帧都丢失了目标,跟踪失败;而本文算法和MTT可以成功地在整个序列上完成目标跟踪.由图 7可以看到,尽管MTT也成功地完成了目标跟踪,但其在整个序列上的跟踪误差都要高于本文算法.本文算法在整个序列上的平均跟踪误差仅为2.00像素,远低于MTT的平均跟踪误差9.24像素,本文算法的跟踪表现优于MTT算法.这主要归功于基于形态学的动态搜索策略令本文算法具备了获得精确目标区域的能力.

在序列S4中,目标在进行著名的眼镜蛇机动.飞机的机头突然抬起并迅速提升至垂直位置;机头继续向后形成机头在后、机尾在前的状态,随后机头再拉回到水平位置正常飞行.因此,目标具有不规律的运动轨迹,并经历了大幅度的旋转.由图 6可以看到,MTT和CT的跟踪结果均明显地偏离了目标区域;与之成对比的是,本文算法可以成功地获得精确的目标区域.由图 7可以看到,本文算法在整个序列上都保持了很低的跟踪误差,明显低于MTT和CT的跟踪误差.由表 1可以看到,本文算法的平均跟踪误差仅为0.68像素,而MTT和CT的平均跟踪误差均为10.32像素,本文算法的跟踪表现远远优于MTT和CT的跟踪表现.

在序列S5中,目标快速运动来完成一个战术动作,形成了不规律的运动轨迹.同时,目标经历了显著的旋转和尺寸变化.因此,目标的外观变化明显,给跟踪带来了很大的难度.由图 6可以看到,虽然MTT、CT和本文算法均可以成功地跟踪目标,但MTT和CT不能获得精确的目标区域并且出现了一定的漂移.反观本文算法,正如图 7所示,其在整个序列上都可以精确地跟踪目标,而且在除了第32帧以外的所有图像帧中均没有发生任何漂移.表 1的结果也证实了本文算法的优异跟踪表现:本文算法的平均跟踪误差仅为0.24像素,而MTT和CT的平均跟踪误差分别为11.56像素和14.54像素,它们的跟踪表现远不如本文算法的跟踪表现.

在序列S6中,目标先从天空背景快速运动到山峰背景,继而从山峰背景运动到河流背景.同时,目标在相邻的两帧图像中的位置经历了剧烈变化:平均的位置变化程度为8.11像素,最大的位置变化程度是22.29像素.巨大的位置变化和复杂的背景极大地增加了目标跟踪的难度.因此,由图 6和表 1可以看到,MTT在全部70帧图像中的57帧中都丢失可目标,跟踪失败;而本文算法和CT可以成功地完成整个序列的目标跟踪.CT的平均跟踪误差为1.85像素,本文算法的平均跟踪误差为2.43像素.虽然本文算法的跟踪误差略大于CT的平均跟踪误差,但本文算法与CT一样在整个序列上的跟踪表现都很优秀.正如图 7所示,本文算法和CT在整个序列上都保持了极低的跟踪误差,远远优于其他对比算法的跟踪表现.

由图 6可以清楚地看到,本文算法不仅可以获得精确的目标区域,跟踪窗口还可以实现对目标尺寸和形状变化的自适应.而KMS、MTT、CT、LSST和DFT均不能实现对目标尺寸变化或形状变化的自适应.在本文提出的算法中,首先使用Mean Shift算法对目标中心进行定位,之后在目标中心周围的特定区域进行基于形态学的搜索,以获得精确的目标区域.这样的机制使得本文算法具备了对目标尺寸和形状变化实现自适应的能力.

7 结 论本文提出了一种基于边缘信息的目标跟踪算法,用于实现对剧烈变化的灰度目标的精确跟踪,经实验验证表明:

1) 算法可以有效跟踪剧烈变化的灰度目标,且跟踪效果优于传统的跟踪算法.

2) 算法不仅可以获得精确的目标区域,还可以实现对目标尺寸和形状变化的自适应.

参考文献

| [1] | 刘彬杰.复杂场景下灰度图像目标的精确跟踪方法研究[D].成都:电子科技大学,2011. Liu B J.Target tracking technology of grayscale image under complex background[D].Chengdu:University of Electronic Science and Technology of China,2011(in Chinese). |

| Cited By in Cnki (1) | |

| [2] | Wu Y,Lim J,Yang M H.Online object tracking:A benchmark[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2013:2411-2418. |

| [3] | Wang X,Liu L,Tang Z M.Infrared human tracking with improved mean shift algorithm based on multicue fusion[J].Applied Optics,2009,48(21):4201-4212. |

| Click to display the text | |

| [4] | Leichter I.Mean shift trackers with cross-bin metrics[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(4):695-706. |

| Click to display the text | |

| [5] | Comaniciu D,Ramesh V,Meer P.Kernel-based object tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2003,25(5):564-577. |

| Click to display the text | |

| [6] | 孔军,汤心溢,蒋敏,等.基于多尺度特征提取的Kalman滤波跟踪[J].红外与毫米波学报,2011,30(5):446-450. Kong J,Tang X Y,Jiang M,et al.Target tracking based on multi-scale feature extraction Kalman filter[J].Journal of Infrared and Millimeter Waves,2011,30(5):446-450(in Chinese). |

| Cited By in Cnki (21) | Click to display the text | |

| [7] | Isard M,Blake A.Condensation-conditional density propagation for visual tracking[J].International Journal of Computer Vision,1998,29(1):5-28. |

| Click to display the text | |

| [8] | Pan P,Schonfeld D.Video tracking based on sequential particle filtering on graphs[J].IEEE Transactions on Image Processing,2011,20(6):1641-1651. |

| Click to display the text | |

| [9] | Ling J G,Liu E,Liang H Y,et al.Infrared target tracking with kernel-based performance metric and eigenvalue-based similarity measure[J].Applied Optics,2007,46(16):3239-3252. |

| Click to display the text | |

| [10] | Zhang S,Qin Y P,Jin G.Analyzing of mean-shift algorithm in gray target tracking technology[M]//Artificial Intelligence and Computational Intelligence.Berlin:Springer,2011:155-162. |

| [11] | 宋新,王鲁平,王平,等.基于改进均值位移的红外目标跟踪方法[J].红外与毫米波学报,2007,26(6):429-432. Song X,Wang L P,Wang P,et al.IR target tracking based on improved mean shift method[J].Journal of Infrared and Millimeter Waves,2007,26(6):429-432(in Chinese). |

| Cited By in Cnki (19) | Click to display the text | |

| [12] | 赵倩,袁健全,鲁新平,等.结合目标预估计与Mean Shift理论的运动目标跟踪算法[J].红外与激光工程,2010,39(6):1152-1156. Zhao Q,Yuan J Q,Lu X P,et al.Moving object tracking algorithm based on object estimation and Mean Shift theory[J].Infrared and Laser Engineering,2010,39(6):1152-1156(in Chinese). |

| Cited By in Cnki (8) | Click to display the text | |

| [13] | 程建,杨杰.一种基于均值移位的红外目标跟踪新方法[J].红外与毫米波学报,2005,24(3):231-235. Cheng J,Yang J.Novel infrared object tracking method based on mean shift[J].Journal of Infrared and Millimeter Waves,2005,24(3):231-235(in Chinese). |

| Cited By in Cnki (63) | Click to display the text | |

| [14] | Wang Z,Hou Q,Hao L.Improved infrared target-tracking algorithm based on mean shift[J].Applied Optics,2012,51(21):5051-5059. |

| Click to display the text | |

| [15] | 贾静平,张艳宁,柴艳妹,等.目标多自由度Mean Shift序列图像跟踪算法[J].西北工业大学学报,2005,23(5):618-622. Jia J P,Zhang Y N,Chai Y M,et al.Making tracking of object in image sequences steady despite complex movement of objects[J].Journal of Northwestern Polytechnical University,2005,23(5):618-622(in Chinese). |

| Cited By in Cnki (22) | Click to display the text | |

| [16] | Zivkovic Z,Krose B.An EM-like algorithm for color-histogram-based object tracking[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2004:798-803. |

| [17] | 刘兴淼,王仕成,赵静,等.基于自适应核窗宽的红外目标跟踪算法[J].控制与决策,2012,27(1):114-119. Liu X M,Wang S C,Zhao J,et al.Infrared target tracking algorithm based on adaptive bandwidth of Mean Shift[J].Control and Decision,2012,27(1):114-119(in Chinese). |

| Cited By in Cnki (5) | Click to display the text | |

| [18] | 徐蓉萍,杨磊.红外复杂背景中一种融合两类跟踪框架优点的小目标跟踪算法[J].红外与毫米波学报,2008,27(5):354-360. Xu R P,Yang L.Small target tracking approach combined the merits of two tracking frameworks under infrared complex background[J].Journal of Infrared and Millimeter Waves,2008,27(5):354-360(in Chinese). |

| Cited By in Cnki (8) | Click to display the text | |

| [19] | Li X H,Zhang T Y,Shen X D,et al.Object tracking using an adaptive Kalman filter combined with mean shift[J].Optical Engineering,2010,49(2):020503-1-020503-3. |

| Click to display the text | |

| [20] | Yilmaz A,Javed O,Shah M.Object tracking:A survey[J].Acm Computing Surveys (CSUR),2006,38(4):1-45. |

| [21] | 宋新.红外地面目标的检测、识别与跟踪技术研究及实现[D].长沙:国防科学技术大学,2007. Song X.Research and implementation of infrared ground target detection,recognition and tracking[D].Changsha:National University of Defense Technology,2007(in Chinese). |

| Cited By in Cnki (4) | |

| [22] | 梁燕,刘文耀.一种新型非线性边缘检测算法[J].光电子·激光,2003,14(12):1332-1335. Liang Y,Liu W Y.A new nonlinear algorithm for edge detection[J].Journal of Optoelectronics·Laser,2003,14(12):1332-1335(in Chinese). |

| Cited By in Cnki (5) | Click to display the text | |

| [23] | di Sciasio E,Guaragnella C.Simple nonlinear dual-window operator for edge detection[J].Optical Engineering,2002,41(9): 2181-2185. |

| Click to display the text | |

| [24] | Yuan S,Li J H,Han J.An adaptive target tracking algorithm based on multi-feature fusion[C]//Proceedings of International Conference on Biomedical Engineering and Computer Science.Piscataway,NJ:IEEE Press,2010:1-4. |

| [25] | 刁伟鹤,毛峡,常乐.自动目标识别中的图像序列质量评价方法[J].电子与信息学报,2010,32(8):1729-1735. Diao W H,Mao X,Chang L.Quality estimation of image sequence for automatic target recognition[J].Journal of Electronics & Information Technology,2010,32(8):1729-1735(in Chinese). |

| Cited By in Cnki (4) | Click to display the text | |

| [26] | Sevilla-Lara L,Learned-Miller E.Distribution fields for tracking[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2012:1910-1917. |

| [27] | Wang D,Lu H,Yang M H.Least soft-threshold squares tracking[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2013:2371-2378. |

| [28] | Zhang K,Zhang L,Yang M H.Real-time compressive tracking[M]//Proceedings of European Conference on Computer Vision.Berlin:Springer,2012:864-877. |

| [29] | Zhang K H,Zhang L,Yang M H.Fast compressive tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2014,36(10):2002-2015. |

| Click to display the text | |

| [30] | Zhang T Z,Ghanem B,Liu S,et al.Robust visual tracking via multi-task sparse learning[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2012:2042-2049. |