由于3D视频需要额外考虑视点间的码率分配,3D视频的HAS技术比传统2D视频的更加复杂。目前,针对3D视频HAS的相关工作还比较少,文献[2]提出了交互式多视点HAS的最优传输策略来平衡编码的失真和渲染合成失真, 该算法同时考虑了视频内容特征和用户交互度。文献[3]利用软件定义网络(Software Defined Network, SDN)提出了基于视频块的流媒体传输框架,这个方案可以根据感兴趣区域改善用户体验质量。文献[4]提出了一种基于HTTP动态自适应流媒体(Dynamic Adaptive Streaming over HTTP, DASH)的高效3D自适应流媒体服务方法,其能为用户提供流畅的立体视频。尽管上述工作已经为3D流媒体应用提出了有效的方案,但是为了给用户提供最佳的观看体验,评估不同流媒体自适应方案的用户体验质量至关重要[5]。目前,对于基于HAS技术的3D视频传输中的用户体验的研究越来越受到关注。QoE模型反映了客观质量与用户体验质量之间的关系,可以极大地帮助3D HAS系统的设计和优化。

文献[6]发现相对于视频质量的瞬间急剧变化,视频质量由低到高缓慢变化时的用户观看体验质量更高。基于这一特性,提出了一种适用于DASH的QoE自适应算法。文献[7]通过分析2D视频和3D视频的自适应流媒体传输策略,发现由3D到2D的转换可能是降低比特率的最佳选择,而相反的由2D到3D的转换并没有明显改善用户的体验质量。虽然文献[7]定性分析了3D视频质量切换对感知质量的影响,但是仍然缺乏可以用于指导3D视频传输时质量切换的QoE的量化模型。另外,已有大量工作致力于3D图像的客观质量评价[8-10],这些评价算法可以准确反映3D内容的感知质量,但无法用于表达视频质量切换导致的QoE变化。

为了研究3D视频传输过程中网络质量波动(Network Quality Fluctuation,NQF)对用户体验质量的影响,本文设计了主观实验用于获取用户在NQF情况下观看视频的体验质量。主观实验特别考虑了单视点和双视点的视频质量改变分别对3D视觉感知质量的影响。最后,提出了一个基于卷积神经网络(Convolutional Neural Networks,CNN)的QoE模型,该模型体现了块级客观质量与用户对3D视频的观看体验质量的映射关系,可用于指导3D视频自适应传输中的视点间码率分配。

1 网络质量波动的影响 双目立体3D视频(Stereoscopic 3D video)通常包含左右2个视点,其所需的带宽远大于传统的2D视频。3D视频的自适应传输在带宽不足情况下会面临视频质量的突降以及左右视点的比特率平衡等问题。本节通过主观实验来分析单视点和双视点视觉质量的改变对3D感知质量的影响。文献[11]表明, 主视眼的不同对总体感知质量的影响可忽略不计。因此,实验中单视点的图像质量变化均基于左视点的图像。

实验总共使用了13个3D视频序列,其中包括3MV-HEVC数据库[12]中的CP (Carpark)、SK (Shark)、ST (Street)、GF (Gtfly)、KD (Kendo)、LB (Lovebird)、BN (Balloons)、BA (Bookarrival),以及数字音频编解码技术标准工作组(AVS)数据库[13]中的BM (Badminton)、JL (Jinli)、DB (Dubai)、AG (Asiangame)、WS (Wushu)。图 1为各个序列的截图,表 1为相应的空间信息(Spatial Information,SI)和时间信息(Temporal Information,TI)[14]。所有视频序列时长为10 s,视频质量的变化发生在视频序列第5 s末,即每个序列的前5 s和后5 s拥有不同的视频质量。为了避免引入由分辨率不同造成的体验质量差别,高分辨率视频均采用了下采样处理,所有序列的分辨率为1 024×768,帧率为25帧/s。

|

| 图 1 3D序列截图[12-13] Fig. 1 Snapshots of 3D sequences[12-13] |

| 图选项 |

表 1 测试数据集[12-13] Table 1 Test dataset[12-13]

| 分辨率 | 序列名称 | 空间信息 | 时间信息 |

| 1 024×768 | KD | 40.07 | 13.96 |

| LB | 57.83 | 4.05 | |

| BN | 37.48 | 8.39 | |

| BM | 56.15 | 9.07 | |

| 1 920×1 080 | JL | 42.56 | 24.83 |

| DB | 35.72 | 2.56 | |

| AG | 78.73 | 17.88 | |

| WS | 54.57 | 17.27 | |

| 1 920×1 088 | CP | 65.11 | 5.98 |

| SK | 23.65 | 15.05 | |

| ST | 57.58 | 8.47 | |

| GF | 51.96 | 16.11 |

表选项

NQF实验按照4种比特率编码视频:

1)“全比特率”表示足够的带宽使得视点质量近似原画质,视点比特率设置为1 000 kbit/s。

2)“高比特率”模拟网络轻微阻塞时的视点比特率,设置为200 kbit/s。

3)“中比特率”模拟网络遭受中等阻塞时的视点比特率,设置为100 kbit/s。

4)“低比特率”模拟网络遭受严重阻塞时的视点比特率,设置为50 kbit/s。

由表 2可知,模拟的NQF类型包含4种质量的切换,分别为单视点质量上升、双视点质量上升、单视点质量下降和双视点质量下降。其中质量上升和下降过程被细分为6种比特率变化:低到全、中到全、高到全;全到低、全到中、全到高。使用3D-HEVC标准参考软件HTM 16.0作为编码器,13个原始序列依据12种视频质量切换类型共生成156组3D测试序列。实验中采用的观看设备为华硕PG278 3D屏幕和NVIDIA 3D眼镜。本次实验共有34名受试者,包括23名男性和11名女性,年龄介于21~25岁。所有受试者都通过了视力测试并且在观看3D视频中没有产生不适感。在主观测试之前,受试者都已熟悉3D视频显示方式和实验流程,并将显示屏和眼镜调整到舒适的位置。主观测试遵循ITU-R BT.500[15]建议书推荐的单激励(Single Stimulus,SS)方法和五级损伤量表[15]。在测试期间,所有NQF测试序列在随机打乱顺序后连续显示,每个序列结束后都有5 s的间隔用于评分。

表 2 网络质量波动类型 Table 2 Network quality fluctuation types

| 质量变化 | 视点 | 编号 | 前5 s视频质量 (左/右)/(kbit·s-1) | 后5 s视频质量 (左/右)/(kbit·s-1) |

| 上升 | 单视点 | 1 | 50/1 000 | 1 000/1 000 |

| 2 | 100/1 000 | 1 000/1 000 | ||

| 3 | 200/1 000 | 1 000/1 000 | ||

| 双视点 | 4 | 50/50 | 1 000/1 000 | |

| 5 | 100/100 | 1 000/1 000 | ||

| 6 | 200/200 | 1 000/1 000 | ||

| 下降 | 单视点 | 7 | 1 000/1 000 | 50/1 000 |

| 8 | 1 000/1 000 | 100/1 000 | ||

| 9 | 1 000/1 000 | 200/1 000 | ||

| 双视点 | 10 | 1 000/1 000 | 50/50 | |

| 11 | 1 000/1 000 | 100/100 | ||

| 12 | 1 000/1 000 | 200/200 |

表选项

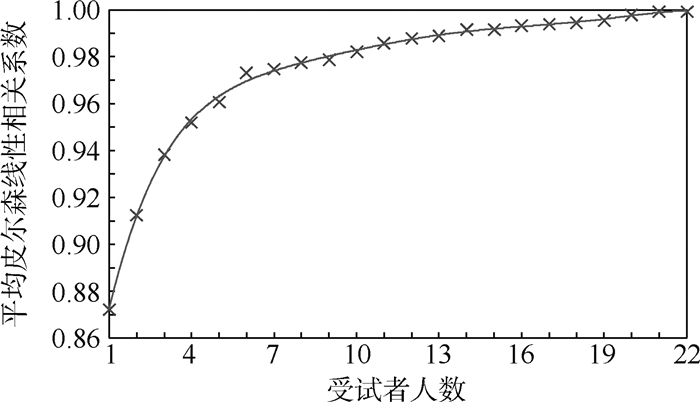

为了提高数据的可靠性,每个受试者的测试都引入重复序列。数据结果采用ITU-R BT.500建议书中的可靠性原则[15]来排除不可靠的分数。24名受试者对视频质量的评分值被保留至后续的数据分析。为了检查选择的样本量是否足以产生稳定的结果,以“数据饱和度”作为指导原则[16]。受试者人数上升导致的平均意见得分(Mean Opinion Score,MOS)数据饱和曲线如图 2所示,每个受试者对13个序列的主观评分为an,选取m个受试者的主观评分均值为

|

| 图 2 受试者人数上升导致的MOS数据饱和 Fig. 2 MOS data saturation caused by increased number of subjects |

| 图选项 |

| (1) |

所有24个主观评分均值为s,xm和s之间的皮尔森线性相关系数(Pearson Linear Correlation Coefficient, PLCC)随着选取人数m增加而增大,“饱和值”出现在受试者人数达到20时, 这表明本次实验采用24个样本值已足够。

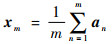

根据ITU-R BT.500建议书[15],所有受试者的MOS表现了主观评分等级。图 3给出了不同比特率切换时单目和双目质量波动的主观评分。图 3(a)和(b)分别表示单视点和双视点质量上升的MOS值,可以看出,单视点质量切换比双视点质量切换引起了更小的用户体验质量下降;图 3(c)和(d)的比较同样可以发现单视点质量切换对体验质量的影响更小。该结果符合双目视觉的掩蔽特性,当一个视点质量不变,另一个视点质量下降至一定范围内,人眼无法察觉到失真[17]。该结论已应用至3D视频的非对称编码[18-19]来减少视觉冗余,也成为3D视频非对称码率传输的基础[20]。

|

| 图 3 NQF主观实验结果 Fig. 3 Subjective experimental results of NQF |

| 图选项 |

为了研究上升和下降2种视频质量切换的区别,表 3显示了同种类型质量变化下所有13个视频序列MOS的平均值。由表 3可知,无论何种视频质量(低、中、高)和视点(单视点、双视点),视频质量上升的评分总高于质量下降的评分。原因是,在视频质量上升类型中,10 s序列的后5 s为高画质,短时记忆的影响使得受试者的最终评价分数更接近后出现的高画质的分数;同理,质量下降类型中后出现的低画质降低了整体评分。这个现象是由于用户体验质量会受到心理学中的近因效应影响,即前一时刻的体验质量会对之后一段时间内的观看体验造成影响[21-22]。当用户接受高质量视频时会产生更高视频质量的期望,因此视频质量的下降会使得用户更加沮丧,加速用户体验质量的下降;相反,观看低质量视频的用户则对视频质量的上升更加敏感,提高了体验质量的评分。本文主观实验中,视频质量的上升和下降2种切换表现出了不同体验质量评分,这一结果与现有时变视频质量研究[21-22]一致。这说明在3D视频自适应传输策略方面:带宽受限时,视频质量可以避免出现突然剧烈的下降;带宽充足时,可以快速提升视频的质量。

表 3 视频质量波动类型的MOS均值 Table 3 Average MOS of video quality fluctuation types

| 视频质量类型 | 单视点升 | 单视点降 | 双视点升 | 双视点降 |

| 低质量 | 3.39 | 3.11 | 2.00 | 1.83 |

| 中质量 | 3.88 | 3.55 | 2.87 | 2.78 |

| 高质量 | 4.17 | 4.11 | 3.61 | 3.47 |

表选项

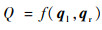

2 3D QoE模型 目前,主观测试虽然是衡量用户体验质量的最可靠方法,但存在高成本,低速度和无法进行实时评估等缺点。客观QoE模型是一种获得近似主观评分的低成本方法。利用第1节方法所获得的视频主观质量数据库及CNN构建了3D视频的客观QoE模型。将3D测试序列和原始序列的每一帧划分为64×64子块,并计算左右视图中测试序列的子块与相对应原始序列的子块的结构相似性(Structural Similarity,SSIM)[23-24],左右视点所有帧的块级SSIM分别表示为ql和qr。所得到的ql和qr输入到CNN网络中预测用户的体验质量值。因此,本文提出的QoE模型为

| (2) |

式中:Q表示用户体验质量的预测值,预测函数基于CNN完成。

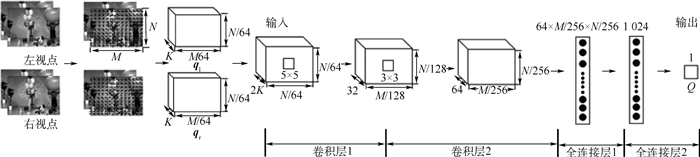

如图 4所示,本文设计的CNN模型由2层卷积层和2层全连接层组成。卷积核的大小分别设置为5×5、3×3。图中:M和N分别为视频的宽和高,K为视频帧数。输入为测试序列的块级SSIM,输出为用户体验质量的预测值Q。在网络训练过程中,从156组3D测试序列中随机选取141个样本作为训练集,用于训练并验证MOS和3D视频内容的块级SSIM之间的关系,剩余15个样本作为测试集用作最后的测试。

|

| 图 4 3D QoE模型框架 Fig. 4 Framework of 3D QoE model |

| 图选项 |

在图像视频质量评价中,通常通过斯皮尔曼秩相关系数(Spearman Rank Order Correlation Coefficient,SROCC)、肯德尔秩相关系数(Kendall Rank Order Correlation Coefficient,KROCC)、PLCC来评价所提模型的性能。其相关系数能够用于反映客观质量评价与主观MOS值的相关程度,值越接近于1,则说明模型的性能越好。由表 4可知,测试集中所有序列的主观评价MOS值与模型预测值之间的SROCC、KROCC、PLCC分别为0.927、0.775、0.906,评估结果说明基于CNN的QoE模型能够较好地预测用户体验质量。

表 4 QoE模型和其他方法的性能比较 Table 4 Comparison of performance between QoE model and other methods

| 指标 | QoE模型 | PSNR | SSIM | 文献[10] |

| SROCC | 0.927 | 0.357 | 0.464 | 0.550 |

| KROCC | 0.775 | 0.257 | 0.371 | 0.390 |

| PLCC | 0.906 | 0.411 | 0.460 | 0.441 |

| 时间/s | 842 | 6.8 | 29.0 | 4 770 |

表选项

由于缺少同类型数据库和模型进行比较,本文设置了3组对比实验:①将每个视频序列的2个视点PSNR的平均值作为预测QoE;②将每个视频序列的2个视点SSIM的平均值作为预测QoE;③采用文献[10]的3D质量评价算法。实验测试使用了同样配置的电脑(Intel Core i5-7500,8GB RAM,Windows 10 64-bit)。实验结果如表 4所示,可以看出,SSIM、PSNR无法很好地反映用户体验质量,文献[10]的3D质量评价算法在本文的数据库上表现同样不佳,但优于PSNR、SSIM,这是由于3D质量评价方法针对于评价3D立体图像和视频的压缩失真,考虑了图像失真类型和人眼双目视觉特性而没有考虑真实传输过程中的视频质量的变化。本文还记录了不同算法测试一个10 s序列的运行时间,本文模型需要计算块级SSIM,导致运行时间大于直接计算3D视频的PSNR、SSIM,但是性能远好于其他3种方法。

3 结论 本文研究了3D自适应流媒体应用中的用户体验质量,并设计了网络带宽不稳定情况下的3D视频质量变化的主观实验。

实验结果表明受试者对单视点质量变化不敏感,并且视频质量上升状态的用户体验质量更高。通过训练主观评分数据,本文建立了基于CNN的QoE模型用于评估3D视频在自适应传输中的用户体验质量。该模型提供了高精度的QoE预测值,可用于改进3D自适应传输和平衡3D视频传输中两视点间比特率。在流媒体视频服务中,代理服务器可以根据该模型预测得到的QoE为用户提供不同码率的3D视频,从而有效分配网络带宽资源。

参考文献

| [1] | MILLER K, QUACCHIO E, GENNARI G, et al.Adaptation algorithm for adaptive streaming over HTTP[C]//Proceedings of the 19th International Packet Video Workshop.Piscataway, NJ: IEEE Press, 2012: 173-178. |

| [2] | ZHANG X, TONI L, FROSSARD P, et al. Adaptive streaming in interactive multiview video systems[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2019, 29(4): 1130-1144. DOI:10.1109/TCSVT.2018.2819804 |

| [3] | ZHAO S, MEDHI D.SDN-Assisted adaptive streaming framework for tile-based immersive content using MPEG-DASH[C]//Proceedings of the IEEE Conference on Network Function Virtualization and Software Defined Networks.Piscataway, NJ: IEEE Press, 2017: 1-6. |

| [4] | PARK G, LEE J, LEE G, et al.Efficient 3D adaptive HTTP streaming scheme over internet TV[C]//Proceedings of the IEEE International Symposium on Broadband Multimedia Systems and Broadcasting.Piscataway, NJ: IEEE Press, 2012: 1-6. |

| [5] | GARCIA M N, SIMONE F D, TAVAKOLI S, et al.Quality of Experience and HTTP adaptive streaming: A review of subjective studies[C]//Proceedings of the 6th International Workshop on Quality of Multimedia Experience, QoMEX.Piscataway, NJ: IEEE Press, 2014: 141-146 |

| [6] | MOK R, LUO X, CHAN E, et al.QDASH: A QoE-aware DASH system[C]//Proceedings of the 3rd Multimedia Systems Conference.New York: ACM Press, 2012: 11-22. |

| [7] | TAVAKOLI S, GUTIERREZ J, GARCIA N. Subjective quality study of adaptive streaming of monoscopic and stereoscopic video[J]. IEEE Journal on Selected Areas in Communications, 2014, 32(4): 684-692. DOI:10.1109/JSAC.2014.140402 |

| [8] | SHAO F, LIN W, GU S, et al. Perceptual full-reference quality assessment of stereoscopic images by considering binocular visual characteristics[J]. IEEE Transactions on Image Processing, 2013, 22(5): 1940-1953. DOI:10.1109/TIP.2013.2240003 |

| [9] | LIN Y H, WU J L. Quality assessment of stereoscopic 3D image compression by binocular integration behaviors[J]. IEEE Transactions on Image Processing, 2014, 23(4): 1527-1542. |

| [10] | ZHANG Y, CHANDLER D M. 3D-MAD:A full reference stereoscopic image quality estimator based on binocular lightness and contrast perception[J]. IEEE Transactions on Image Processing, 2015, 24(11): 3810-3825. DOI:10.1109/TIP.2015.2456414 |

| [11] | BATTISTI F, CARLI M, L E CALLET P, et al. Toward the assessment of quality of experience for asymmetric encoding in immersive media[J]. IEEE Transactions on Broadcasting, 2018, 64(2): 392-406. DOI:10.1109/TBC.2018.2828607 |

| [12] | RUSANOVSKYY D, MVLLER K, VETRO A.Common test conditions of 3DV core experiments[EB/OL].(2013-08-02)[2019-07-06]. https://phenix.int-evry.fr/jct2/doc_end_user/current_document.php?id=1344. |

| [13] | AVS Video Group.General test conditions of stereoscopic video coding[EB/OL]. (2010-12-16)[2019-07-06]. http://www.avs.org.cn/FileList.asp?meetingid=53&filetype=output. |

| [14] | ITU-Recommendation.BT.1788.Methodology for the subjective assessment of video quality in multimedia applications[S].Geneva: ITU, 2007. |

| [15] | ITU-Recommendation.BT.500-11.Methodology for the subjective assessment of the quality of television pictures[S].Geneva: ITU, 2012. |

| [16] | ZHANG W, LIU H. Toward a reliable collection of eye-tracking data for image quality research:Challenges, solutions, and applications[J]. IEEE Transactions on Image Processing, 2017, 26(5): 2424-2437. DOI:10.1109/TIP.2017.2681424 |

| [17] | ZHAO Y, CHEN Z, ZHU C, et al. Binocular just-noticeable-difference model for stereoscopic images[J]. IEEE Signal Processing Letters, 2010, 18(1): 19-22. |

| [18] | SHAO F, JIANG G, WANG X, et al. Stereoscopic video coding with asymmetric luminance and chrominance qualities[J]. IEEE Transactions on Consumer Electronics, 2011, 56(4): 2460-2468. |

| [19] | HUANG Y H, HUANG Y H, LIU W C. Quality-efficient upsampling method for asymmetric resolution stereoscopic video coding with interview motion compensation and error compensation[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2014, 24(3): 430-442. DOI:10.1109/TCSVT.2013.2276877 |

| [20] | SAYGILI G, GURLER C G, TEKALP A M. Evaluation of asymmetric stereo video coding and rate scaling for adaptive 3D video streaming[J]. IEEE Transactions on Broadcasting, 2011, 57(2): 593-601. DOI:10.1109/TBC.2011.2131450 |

| [21] | CHEN C, CHOI L K, DE VECIANA G, et al. Modeling the time-varying subjective quality of HTTP video streams with rate adaptations[J]. IEEE Transactions on Image Processing, 2014, 23(5): 2206-2221. DOI:10.1109/TIP.2014.2312613 |

| [22] | ZHENGFANG D M, MA K D, WANG Z. Quality-of-experience for adaptive streaming videos:An expectation confirmation theory motivated approach[J]. IEEE Transactions on Image Processing, 2018, 27(12): 6135-6146. DOI:10.1109/TIP.2018.2855403 |

| [23] | WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment:from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612. |

| [24] | ZHANG W, QU C, MA L, et al. Learning structure of stereoscopic image for no-reference quality assessment with convolutional neural network[J]. Pattern Recognition, 2016, 59: 176-187. DOI:10.1016/j.patcog.2016.01.034 |