现有图像去雾算法从是否利用物理模型的角度,可粗略分为2类:基于图像恢复的方法和基于图像增强的方法。基于物理模型的雾天图像恢复是考虑雾天图像退化原因,利用大气散射模型通过求解模型中的相关参数,反解出无雾图像,从而改善图像质量,其目的在于还原真实无雾场景。基于图像增强技术的去雾是不考虑图像退化的原因,仅考虑图像呈现的低对比度、低饱和度等特征,通过对图像有用信息进行增强同时抑制或者去除不需要的信息,来改善图像质量、提高图像的清晰度。

基于物理模型的雾天图像恢复方法主要包括基于偏振特性的方法[5-8]、基于偏微分方程的方法[9-10]、基于深度信息的方法[11-14]、基于先验知识或假设的方法[15-20]和基于深度学习的方法[21-23]。

基于偏振特性的方法是以光的偏振特性为基础,依靠硬件的支持且需要多幅图像才能完成模型参数估计,具有局限性。而基于偏微分方程的方法和基于深度信息的方法通常需要一定程度的人工交互操作,无法做到自动处理。因此,日常监控系统的工程实践中并不常用。

基于先验知识或假设的方法是利用单散射模型中参数的特性,人为设置一些约束条件,从而使得参数可解,目前已取得了突破性的进展[15-20, 24]。基于深度学习的方法不需要人工设计特征提取器,而是由机器自动学习获得,典型的工作包括:Cai等[21]提出DehazeNet网络结构,利用特殊设计的卷积神经网络来学习雾天图像的特征,解决手工特征设计的难点。Ren等[22]考虑雾天图像的多尺度特征,提出多尺度卷积神经网络学习雾天图像的特征估计透射率。Li等[23]利用变形的大气散射模型,提出All-in-One去雾卷积神经网络,它可从有雾图像直接估计无雾图像。

基于物理模型的雾天图像恢复方法虽然在解决问题的思路上存在区别,但是最终目标都是通过单散射模型求解无雾的图像。然而,单散射模型假设场景光辐射充足且非常均匀,适合描述薄雾条件下的场景成像过程。浓雾情况下,悬浮颗粒的浓度变大时,可见光的穿透能力变弱,地表场景光辐射出现衰减,若仍利用单散射模型进行去雾处理,图像会出现亮度偏低、细节凸显不明显的情况。

可见,浓雾图像更适合使用增强方法进行处理。图像增强方法忽略图像降质原因,主要以提升图像细节来改善图像清晰度。典型的雾天图像增强方法包括直方图均衡化方法(Histogram Equalization,HE)[25-29]、曲波变换[30]和Retinex算法。

直方图均衡化方法可对图像的像素值进行非线性重映射,从而重新分配像素值,使其尽可能地均衡分布,实现对比度的增强。典型的直方图均衡化方法主要包括全局直方图均衡化方法[25]、局部直方图均衡化方法[26]、限制对比度自适应直方图均衡化方法(Contrast Limited Adaptive Histogram Equalization,CLAHE)[27]、广义直方图均衡化方法[28]和内容自适应的直方图均衡化方法[29]。直方图均衡化方法以合并数量较少的像素为代价完成像素值的重新分布,这会造成细节信息的丢失或图像模糊。

曲波变换是在小波变换基础上发展起来的多尺度分析方法。Eriksson[30]利用曲波变换的优势,采用基于曲波的消失点检测对雾天图像进行了自动去雾处理。然而,该类方法将整幅图像作为一个整体进行操作,不能保证一些关注区域得到所需要的增强效果。

Retinex算法通过分离图像的低频分量和高频分量,然后移除低频分量,调整高频分量动态范围,实现对高频分量的放大,来完成细节的突出显示。从单尺度Retinex(Single Scale Retinex,SSR)算法到多尺度Retinex (Multi-scale Retinex,MSR)算法,再到带颜色恢复的多尺度Retinex (Multi-Scale Retinex with Color Restore,MSRCR)算法[31-33]。Retinex算法在图像浓雾去除中的应用取得了一定的成果。Retinex可以在灰度动态范围压缩、细节增强和颜色恒定3方面达到平衡,对各种场景的雾天图像都适用,因而一直受到国内外****的广泛关注[34-36]。

然而,Retinex用于浓雾图像增强时,通过全局均值统计量来对高频分量的动态范围进行截断量化[31-32],对浓度分布均匀的雾天图像处理效果较好。当浓度分布不均匀时,由于每个区域的最优动态截断并不统一,无法保证每个区域的增强效果。因此,本文提出多子块协同单尺度Retinex算法,通过结合局部统计信息,获取多个局部最优的增强图像,再融合多个局部最优的图像获得最终的增强图像。实验结果表明,本文方法能够有效去除图像中浓雾的影响,并保证去雾后图像的亮度保持在适合人眼观察的范围。

1 单尺度Retinex算法及其问题分析 1.1 单尺度Retinex算法 Retinex算法中,图像可表示为低频分量和高频分量的乘积形式:

| (1) |

式中:I为采集设备获取的图像信息;L为不受关注的低频分量;R为能够体现物体真实细节特征的高频分量;(x, y)为像素的位置。利用Retinex算法实现图像对比度增强和色彩复原过程中,如何去除低频分量获取图像高频分量是其中一个关键环节。

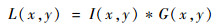

应用最为广泛的单尺度Retinex是由中心/环绕理论发展而来,核心思想是:每个像素所包含的不受关注的低频分量是通过赋予其邻域像素不同的权重来进行估计的,权重的取值由一个函数来确定。数学表达式形式为

| (2) |

式中:“*”表示卷积运算;G(x, y)为中心/环绕函数,通常采用高斯函数,公式如下:

| (3) |

| (4) |

式中:κ为归一化因子;c为高斯函数的尺度参数。

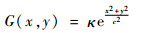

为便于计算,将式(2)两边取对数,单尺度Retinex提取高频分量rSSR过程可表示为

| (5) |

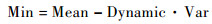

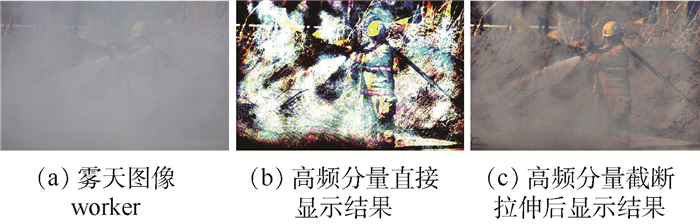

经过式(5)的处理,图像高频分量被提取,但对将其作为最终的增强结果并不适合观察,如图 1(b)所示。接下来,还需对高频分量进行截断量化拉伸。首先,计算出高频分量的均值Mean和均方差Var,得到动态范围的截断值Min和Max:

| (6) |

| (7) |

|

| 图 1 单尺度Retinex处理结果 Fig. 1 Processed result of single-scale Retinex |

| 图选项 |

式中:Dynamic为动态范围控制参数。然后,对高频分量进行线性映射,获得最终增强后的图像Value:

| (8) |

量化拉伸后结果如图 1(c)所示,显然,与图 1(b)比较,其动态范围更合理,更适合观察显示。

1.2 问题分析 传统的单尺度Retinex算法易于实现,且具有较好的图像增强效果,但其仍具有如下的缺陷:利用全局均值统计量来进行高频细节信息动态范围调整并不适合所有图像,因为当雾气浓度分布不均匀时,每个区域的均值差别较大,最优动态截断范围并不一致。

如图 2所示,当利用浓雾区域(图 2(a)中下方矩形区域)的均值统计量计算动态截断范围时,浓雾区域去雾更为彻底(例如:图 2(b)中工人的腿部),但薄雾区域却出现了过增强(例如:图 2(b)中图像顶部)。当利用了薄雾区域(图 2(a)中上方矩形区域)的均值统计量计算动态截断范围时,薄雾区域未出现过增强,但浓雾区域去雾却不彻底。

|

| 图 2 利用不同局部均值统计拉伸量化后结果 Fig. 2 Stretched quantization result using different local mean statistics |

| 图选项 |

2 多子块协同单尺度Retinex算法 针对第1节关键问题,本文提出基于多子块协同单尺度Retinex算法,该算法将图像划分为多个子块进行均值统计并计算动态截断值,再利用各截断值分别获得多个局部最优的增强图像,最后,融合各增强图像获得最终的增强结果。算法流程如图 3所示。下面对关键部分的实施细节进行介绍。

|

| 图 3 基于多子块协同的单尺度Retinex算法流程 Fig. 3 Flowchart of multi-block coordinated single-scale Retinex algorithm |

| 图选项 |

1) 高频细节信息分解:本文将图像分解为低频分量和高频分量所采用方法与传统单尺度Retinex思想一样。只不过,为了抑制光晕,所用低通滤波器选用保持边缘滤波器-引导滤波器[37],获取的高频细节分量为rSSR。

2) 多子块划分:雾气的浓度通常具有一定的规律性,呈现连续变化的趋势。为了使不同浓度的有雾区域尽可能地聚集到同一个子块且不影响运行速度,本文在水平和垂直方向上将图像划分为M行和N列。值得注意的是,划分子块越多雾气浓度划分越准确,但子块过小又会影响动态截断效果,因此,一般情况下M和N的取值应满足:

| (9) |

式中:W和H分别为图像的宽度和高度。之后,形成k个子块[D′1, D′2, …, D′k],k=MN。这k个子块所对应的高频细节分量为[rSSR1, rSSR2, …, rSSRk]。

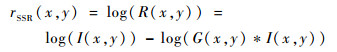

3) 多个动态截断值获得多幅增强图像:对每一高频细节分量子块rSSRn,n=[1, 2, …, k],统计其均值Meann和均方差Varn,并计算出动态范围的截断值Minn和Maxn:

| (10) |

| (11) |

然后,利用每对动态范围截断值对高频细节分量进行线性映射,获得多幅增强后的图像Value′n:

| (12) |

4) 图像融合:为了在图像细节增强和图像过增强之间寻找平衡点,本文最后将多个局部最优的增强图像进行线性加权组合,其数学表达式为

| (13) |

式中:r为多子块协同单尺度Retinex的输出结果;wn为第n个局部最优增强图像的权重,满足条件:

| (14) |

一般情况下w1=w2=…=wk=1/k。

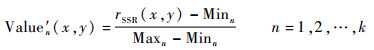

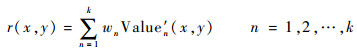

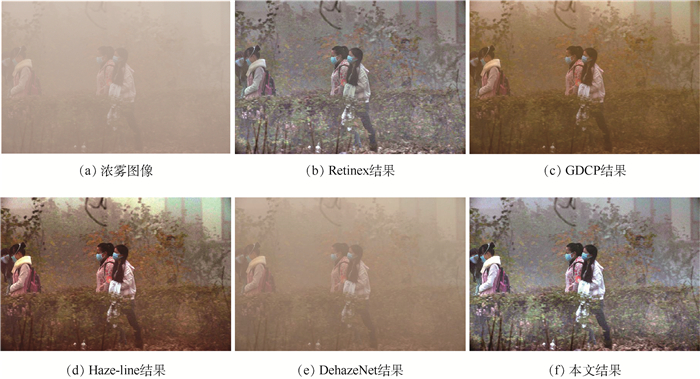

3 实验结果与分析 为了验证本文算法的效果,本节将展示与典型图像去雾算法的对比结果。现有基于图像增强的图像去雾方法效果较好的主要有基于直方图均衡化的方法和Retinex算法。由于基于直方图均衡化的方法对浓雾图像的清晰度提升有限,本文取经典Retinex算法进行对比。此外,本文还提供了基于引导滤波的暗原色(Dark Channel Prior based on Guided filter,GDCP)算法[37]、Haze-line算法[20]和DehazeNet算法[21]的结果。GDCP算法是暗原色算法的改进,利用局部先验知识进行图像去雾,公认效果较好,使用最为广泛。Haze-line是利用全局先验进行去雾的算法,有利于图像去雾后防止色彩过饱和。DehazeNet是基于深度学习的去雾算法,由机器自动学习获得雾天图像特征完成去雾,解决了手工设计特征的问题。另外,为了验证本文算法改进单尺度Retinex的必要性,还提供了经典Retinex算法的结果进行对比。

主观评价方法的结果完全由人眼的主观感受决定,能够比较准确地反映视频的质量,但却无法定量测量。本文算法主要用于提升图像细节和边缘,因此,为了验证去雾结果的客观效果,本文利用信息熵(h)[38]、新增可见比(e)和可视边缘梯度信息(γ)[39]来对增强后图像进行客观质量评价。去雾效果对比示例如图 4~图 6所示。

|

| 图 4 去雾效果对比示例1 Fig. 4 Example 1 of defogged result comparison |

| 图选项 |

|

| 图 5 去雾效果对比示例2 Fig. 5 Example 2 of defogged result comparison |

| 图选项 |

|

| 图 6 去雾效果对比示例3 Fig. 6 Example 3 of defogged result comparison |

| 图选项 |

GDCP算法基于单散射模型,场景光辐射的衰减被忽略,较适合薄雾图像,处理浓雾图像时,图像亮度无法得到保证。如图 5(c)所示,图像虽然实现了去雾,但是亮度明显变低,细节难以辨识。Haze-line算法根据雾天图像中相同颜色的像素分布在一条直线的规律,通过聚类找到许多雾线,并假设半径最长的点透射率为1,反解出无雾图像。然而,半径最长的点透射率不一定是1,所以会残留较多雾气,如图 4(d)、图 5(d)所示。DehazeNet算法对大量有雾和无雾图像对进行训练,利用了深度学习的优势,但其仍基于单散射模型。因此,利用DehazeNet算法进行浓雾图像的去除会出现去雾失败的情况,如图 4(e)和图 6(e)所示。经典Retinex算法和本文算法不考虑退化因素,从增强的角度对图像进行清晰化,从灰度动态范围压缩、细节增强和颜色恒定几个方面展现出了优势。而且,由于本文算法考虑了不同区域动态截断值不同的特性,进行了多个子块协同处理,因此,去雾效果较Retinex算法更好,如图 4(f)和图 6(f)所示。

上述主观评价反映了图像增强的视觉质量。为了对图像质量进行定量的比较,还需对处理后图像进行客观评估。客观质量评估主要用于对图像的某些重要特征进行定量的描述。表 1~表 3给出了上述信息熵(h)、新增可见比(e)和可视边缘梯度信息(γ)的计算结果,每幅图像的最优结果已加粗标注。其中,新增可见比和可视边缘梯度信息是专门用于去雾结果盲评估的评价指标。

表 1 图 4去雾后客观指标评价结果 Table 1 Objective indicator evaluation results of defogged images in Fig. 4

| 图像编号 | h | e | γ |

| 图 4(b) | 6.57 | 284.20 | 8.42 |

| 图 4(c) | 6.92 | 56.96 | 3.82 |

| 图 4(d) | 7.38 | 247.70 | 7.07 |

| 图 4(e) | 5.43 | 8.87 | 2.21 |

| 图 4(f) | 7.24 | 286.73 | 9.47 |

表选项

表 2 图 5去雾后客观指标评价结果 Table 2 Objective indicator evaluation results of defogged images in Fig. 5

| 图像编号 | h | e | γ |

| 图 5(b) | 6.23 | 2.38 | 4.60 |

| 图 5(c) | 6.94 | 1.36 | 1.89 |

| 图 5(d) | 7.11 | 0.10 | 3.03 |

| 图 5(e) | 7.46 | 0.51 | 1.67 |

| 图 5(f) | 6.38 | 4.35 | 6.18 |

表选项

表 3 图 6去雾后客观指标评价结果 Table 3 Objective indicator evaluation results of defogged images in Fig. 6

| 图像编号 | h | e | γ |

| 图 6(b) | 6.59 | 248.67 | 7.48 |

| 图 6(c) | 6.46 | 283.46 | 3.47 |

| 图 6(d) | 7.53 | 281.39 | 6.78 |

| 图 6(e) | 5.43 | 9.39 | 1.37 |

| 图 6(f) | 7.37 | 358.36 | 13.13 |

表选项

信息熵用来描述图像的平均信息量,在不引起失真的情况下,其值越大代表所含的细节越丰富。从信息熵的对比结果中可以看出,本文算法的信息熵并非最高,这是因为,Retinex算法采用动态截断的方法进行量化拉伸得到最终的增强结果,会有部分信息量的损失,但仍优于对比的大多数算法。

新增可见比和可视边缘梯度信息是衡量细节增强情况的指标,通常,其值越大表明去雾后图像可视边缘和细节的强度越大、数量越多。从表 1~表 3的结果可以看出,本文算法要明显优于其他对比算法。这意味着,虽然部分算法增强后细节要多于本文算法,但可视能力却要弱于本文算法。

4 结论 本文在单尺度Retinex算法基础上提出了多子块协同单尺度Retinex浓雾去除算法。经实验验证,得到:

1) 本文算法考虑了雾气不均匀的浓雾图像特征,针对每个局部的均值统计量不一致的情况,改进了经典单尺度Retinex量化拉伸的过程,从而增强了Retinex算法的鲁棒性。

2) 本文算法可以实现较优的去雾性能,与其他典型去雾算法相比有所提高。

通过实验验证,本文算法的图像去雾效果得到了提升,一定程度上提高了图像的清晰度。在未来,可以改进该算法,增加多个增强图像融合的自适应性,从而取得更好的去雾效果。

参考文献

| [1] | 代书博, 徐伟, 朴永杰, 等. 基于暗原色先验的遥感图像去雾方法[J]. 光学学报, 2017, 37(3): 341-347. DAI S B, XU W, PIAO Y J, et al. Remote sensing image defogging based on dark channel prior[J]. Acta Optica Sinica, 2017, 37(3): 341-347. (in Chinese) |

| [2] | 崔运前.图像去雾技术研究与实现[D].南京: 南京理工大学, 2017: 1-8. CUI Y Q.Research and implementation of image dehazing technology[D].Nanjing: Nanjing University of Science and Technology, 2017: 1-8(in Chinese). http://cdmd.cnki.com.cn/Article/CDMD-10288-1017053387.htm |

| [3] | 王圣江, 童冬生, 王海平, 等. 视频监控取证系统在海警舰艇上的应用[J]. 中国公共安全(学术版), 2014(1): 105-108. WANG S J, TONG D S, WANG H P, et al. Application of video monitoring evidence system on the coast guard ship[J]. China Public Security(Academy Edition), 2014(1): 105-108. DOI:10.3969/j.issn.1672-2396.2014.01.027 (in Chinese) |

| [4] | MCCARTNEY E J. Optics of the atmosphere:Scattering bymolecules and particles[M]. New York: John Wiley and Sons, 1976: 13-51. |

| [5] | NARASIMHAN S G, NAYAR S K.Interactive (de)weathering of an image using physical models[C]//IEEE Workshop on Color and Photometric Methods in Computer Vision.Piscataway, NJ: IEEE Press, 2003: 1-8. |

| [6] | SCHECHNER Y Y, NARASIMHAN S G, NAYAR S K.Instant dehazing of images using polarization[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2001: 325-332. |

| [7] | SCHECHNER Y Y, NARASIMHAN S G, NAYAR S K. Polarization-based vision through haze[J]. Applied Optics, 2003, 42(3): 511-525. DOI:10.1364/AO.42.000511 |

| [8] | SHWARTZ S, NAMER E, SCHECHNER Y Y.Blind haze separation[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2006: 1984-1991. |

| [9] | 孙玉宝, 肖亮, 韦志辉, 等. 基于偏微分方程的户外图像去雾方法[J]. 系统仿真学报, 2007, 33(3): 55-58. SUN Y B, XIAO L, WEI Z H, et al. Method of defogging image of outdoor scenes based on PDE[J]. Journal of System Simulation, 2007, 33(3): 55-58. (in Chinese) |

| [10] | 翟艺书, 柳晓鸣, 涂雅媛. 基于模糊逻辑的雾天降质图像对比度增强算法[J]. 计算机应用, 2008, 28(3): 662-664. ZHAI Y S, LIU X M, TU Y Y. Contrast enhancement algorithm for fog-degraded image based on fuzzy logic[J]. Computer Applications, 2008, 28(3): 662-664. (in Chinese) |

| [11] | NARASIMHAN S G, NAYAR S K.Chromatic framework for vision in bad weather[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2000: 598-605. |

| [12] | NARASIMHAN S G, NAYAR S K. Vision and the atmosphere[J]. International Journal of Computer Vision, 2002, 48(3): 233-254. DOI:10.1023/A:1016328200723 |

| [13] | KOPF J, NEUBERT B, CHEN B, et al. Deep photo:Model-based photograph enhancement and viewing[J]. ACM Transactions on Graphics, 2008, 27(5): 1-10. |

| [14] | NARASIMHAN S G, NAYAR S K.Removing weather effects from monochrome images[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2001: 186-193. |

| [15] | TAN R T.Visibility in bad weather from a single image[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2008: 1-8. |

| [16] | FATTAL R. Single image de-hazing[J]. ACM Transactions on Graphics, 2008, 27(3): 72. |

| [17] | HE K M, SUN J, TANG X O.Single image haze removal using dark channel prior[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2009: 1956-1963. |

| [18] | FATTAL R. De-hazing using color-lines[J]. ACM Transactions on Graphics, 2014, 34(1): 13. |

| [19] | ZHU Q, MAI J, SHAO L. A fast single image haze removal algorithm using color attenuation prior[J]. IEEE Transactions on Image Processing, 2015, 24(11): 3522-3533. DOI:10.1109/TIP.2015.2446191 |

| [20] | BERMAN D, TREIBITZ T, AVIDAN S.Non-local image dehazing[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2016: 1674-1682. |

| [21] | CAI B, XU X, JIA K, et al. DehazeNet:An end-to-end system for single image haze removal[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5187-5198. DOI:10.1109/TIP.2016.2598681 |

| [22] | REN W Q, LIU S, ZHANG H, et al.Single image dehazing via multi-scale convolutional neural networks[C]//European Conference on Computer Vision, 2016: 154-169. |

| [23] | LI B, PENG X, WANG Z, et al.AOD-Net: All-in-One dehazing network[C]//IEEE International Conference on Computer Vision.Piscataway, NJ: IEEE Press, 2017: 4780-4788. |

| [24] | ORCHARD M T, BOUMAN C A. Color quantization of images[J]. IEEE Transactions on Signal Processing, 1991, 39(12): 2677-2690. DOI:10.1109/78.107417 |

| [25] | KIM T K, PAIK J K, KANG B S. Contrast enhancement system using spatially adaptive histogram equalization with temporal filtering[J]. IEEE Transactions on Consumer Electronics, 1998, 44(1): 82-87. DOI:10.1109/30.663733 |

| [26] | KIM J Y, KIM L S, HWANG S H. An advanced contrast enhancement using partially overlapped sub-block histogram equalization[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2002, 11(4): 475-484. |

| [27] | ZUIDERVELD K.Contrast limited adaptive histogram equalization[M]//JAMES A.Graphics gems.San Diego, CA: Academic Press Professional, Inc., 1994: 474-485. |

| [28] | XU H, ZHAI G, WU X, et al. Generalized equalization model for image enhancement[J]. IEEE Transactions on Multimedia, 2014, 16(1): 68-82. DOI:10.1109/TMM.2013.2283453 |

| [29] | WANG S H, CHO W, JANG J, et al. Contrast-dependent saturation adjustment for outdoor image enhancement[J]. Journal of the Optical Society of America A-Optics Imaging Science and Vision, 2017, 34(1): 2532-2542. DOI:10.1364/JOSAA.34.000007 |

| [30] | ERIKSSON B. Automatic image de-weathering using curvelet-based vanishing point detection[J]. Communications on Pure and Applied Mathematics, 2007, 3(5): 219-232. |

| [31] | ZIA R.Properties of a center/surround Retinex: Part 1.Signal processing design: cr198194[R].Washington, D.C.: NASA, 1995. |

| [32] | JOBSON D J, GLENN A W.Properties of a center/surround Retinex: Part 2.Surround design: tm110188[R].Washington, D.C.: NASA, 1995. |

| [33] | RAHMAN Z U, JOBSON D J, WOODELL G A.Multi-scale Retinex for color image enhancement[C]//IEEE International Conference on Image Processing.Piscataway, NJ: IEEE Press, 2002: 1003-1006. |

| [34] | WANG W, LI B, ZHENG J, et al.A fast multi-scale Retinex algorithm for color image enhancement[C]//IEEE International Conference on Wavelet Analysis and Pattern Recognition.Piscataway, NJ: IEEE Press, 2008: 80-85. |

| [35] | 肖胜笔, 李燕. 具有颜色保真性的快速多尺度Retinex去雾算法[J]. 计算机工程与应用, 2015, 51(6): 176-180. XIAO S B, LI Y. Fast multiscale Retinex algorithm of image haze removal with color fidelity[J]. Computer Engineering and Applications, 2015, 51(6): 176-180. DOI:10.3778/j.issn.1002-8331.1410-0045 (in Chinese) |

| [36] | WANG J, LU K, XUE J, et al. Single image dehazing based on the physical model and MSRCR algorithm[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 28(9): 2190-2199. |

| [37] | HE K M, SUN J, TANG X O. Guided image filtering[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(6): 1397-1409. DOI:10.1109/TPAMI.2012.213 |

| [38] | YE Z, MOHAMADIAN H, YE Y.Discrete entropy and relative entropy study on nonlinear clustering of underwater and arial images[C]//IEEE International Conference on Control Applications.Piscataway, NJ: IEEE Press, 2007: 313-318. |

| [39] | HAUTIERE N, TAREL J P, AUBERT D, et al. Blind contrast enhancement assessment by gradient ratioing at visible edges[J]. Image Analysis and Stereology, 2008, 27(2): 87-95. |