飞机目标通常停靠在停机坪和跑道区域内,对停机坪和跑道区域实施候选检测区域的分割与提取可以显著缩小飞机目标的搜寻范围,进而在分割出的停机坪与跑道区域内针对飞机目标实施精确地检测定位,这是实现大幅面遥感图像飞机目标高效检测的有效途径。在本文中,利用高性能的端到端深度神经网络(Deep Neural Networks,DNN)结构,对大幅面遥感图像中的停机坪与跑道区域等飞机目标候选检测区域实施高效精准分割,显著提高了飞机目标的检测效率。在分割出的跑道与停机坪区域内,借助手工采集的飞机目标样本集,对YOLO (You Only Look Once)网络模型进行迁移式强化训练,一方面弥补了手工数据集数据规模上的不足,另一方面借助YOLO网络的强时效性的优势,实现了飞机目标的高效检测与定位。在候选检测区域的分割提取与飞机目标的高效检测2个环节中,都充分考虑了大幅面遥感图像飞机目标检测精确性与实时性的实际应用需求,借助2种高性能DNN网络的级联组合,提出了新颖的搜寻与检测相集成的飞机目标高效检测算法。

为了验证本文所提出的级联式飞机目标高效检测算法的有效性,在实际获取的大幅面遥感图像上,将本文提出的检测算法与R-CNN (Regions with Convolutional Neural Networks)[2]、Faster R-CNN[3]进行飞机目标检测实验结果的对比分析和性能评估。结果表明,本文提出的搜寻与检测相集成的级联组合式飞机目标高效检测算法不仅在检测速度上具有明显优势,同时在检测精度上也能达到满意水平,可为大幅面遥感图像中飞机目标的高效检测提供良好的技术支持。

1 相关工作与技术动态 遥感图像幅面大,包含的地物类型多,为了提高检测效率,降低虚警干扰,需要对停机坪与跑道区域实施高效精准分割。

赵雪梅等[4]提出了基于隐马尔可夫高斯随机场模型的模糊聚类高分辨率遥感影像分割算法,分别利用隐马尔可夫模型和高斯模型构建标号场和特征场的邻域关系,同时强化空间和光谱信息对影像分割的影响,在特征域上,不但考虑了同一彩色的邻域关系,也考虑了不同彩色间的邻域关系, 完善了光谱的邻域信息,实现了高分辨率遥感影像地物目标的精准分割。陈荣元等[5]提出了一种结合Gibbs随机场的特征加权遥感影像分割方法,利用加权最小距离分类法对影像进行初始分割,并利用Gibbs随机场描述像素的空间相关性,综合Gibbs随机场描述的标记场和加权最小距离分类法描述的特征场来获取影像的最终分割结果。Budak等[6]提出了一种新颖的由粗检到精筛的停机坪与跑道区域分割方案,先基于直线段检测(Line Segment Detector, LSD)算法提取长直线区域作为停机坪与跑道分割的候选区域,再对候选检测区域进行局部不变特征提取与分类,最终达到停机坪与跑道区域检测与分割的目的。Wang和Pan[7]提出了一种基于显著性区域搜索的停机坪与跑道分割算法,先通过显著图提取停机坪与跑道的候选区域,再提取候选区域的视觉词包(Bag of Visual Words, BoVW)特征,通过支持向量机(SVM)对BoVW特征进行分类,最终实现停机坪与跑道区域的定位和分割。

然而,经典的停机坪与跑道区域分割算法具有一定的局限性:①基于直线形状特征的停机坪与跑道区域分割算法在非直线区域性能欠佳,而基于显著性提取的分割算法无法准确描述停机坪与跑道区域的轮廓信息,从而导致分割精度较低;②利用长直线特征进行候选分割区域搜寻,其搜寻结果与直线长度的阈值设置密切相关,在应对不同检测场景时泛化性能较弱,容易造成误分割情况的发生。

伴随着深度学习理论的迅猛发展,特别是AlexNet获得了ImageNet2012挑战赛冠军以后[8],DNN网络在数字手写体识别、人脸识别以及无人驾驶等诸多领域取得了巨大的成功。借助卷积神经网络(Convolutional Neural Networks, CNN),可以为图像中的每个像素分配具有语义信息的类别标签,从而实现像素级的图像分割。然而,经典的CNN网络对于输入图像的大小有严格限制,而原始图像的裁剪和缩放会引起目标信息的畸变与缺失,造成分割精度的下降。为了解决这一问题,Long等[9]提出了全卷积神经网络(Fully Convolutional Neural Network, FCN)的概念。在FCN网络中,全连接层被1×1大小的卷积层所替代,从而使得FCN网络具备处理任意大小图像的能力。FCN网络对浅层特征与深层特征进行融合,获得了性能更优的特征表达,并借助融合特征图的上采样,获得最终的分割结果。然而,简单的上采样操作会破坏原始图像像素之间的空间位置关系,导致分割精度欠佳。为了解决这一问题,Badrinarayanan等[10]提出了新颖的SegNet网络模型结构。SegNet的创新之处在于其独特的编码-解码结构。在编码阶段,SegNet借助VGG-16网络中的13个卷积层完成特征提取,而在解码阶段,则采用对称的网络模型进行空间信息和语义信息的恢复。相比FCN网络简单的上采样算法,SegNet多层转置卷积操作更有利于精确恢复原始图像像素点之间的空间位置关系,因而能够实现更加精确的图像分割。Ronneberger等[11]提出了结构更为复杂的U-Net网络模型。U-Net结合了编码-解码的结构设计以及多特征图融合的优势,相比Dan等[12]提出的模型,在性能上有了大幅提高。此外,条件随机场(Conditional Random Fields, CRF)可以显著提高图像分割精度,这在Chen等[13]的研究中也得到了充分的借鉴和应用。Zhao等[14]在CVPR2017发表的PSPNet、Chen等[15]发表的DeepLab及He等[16]在ICCV2017上发表的Mask R-CNN使图像语义分割的精度得到了进一步提升。

飞机目标作为一种高价值的时敏目标,在不同天时、天候的复杂场景下对其实施高效精准检测一直都是国内外****研究的热点。经典的飞机目标检测算法在特征选择上,主要包括外型特征、轮廓特征、显著性特征和局部不变特征等。伴随着深度学习的迅猛发展,传统的手工特征被深度学习提取的机器特征快速超越和取代。Girshick等[2]在CVPR2014上首次将深度学习引入到目标检测中,提出了R-CNN算法。在R-CNN算法的实现过程中,首先借助选择性搜索算法获取大量的目标线索,然后利用AlexNet网络模型对目标线索区域进行特征提取,最后借助SVM分类器对特征进行分类,从而实现目标检测的目的。相比经典的可变性部件模型(Deformable Part Model, DPM)目标检测算法,R-CNN算法在平均精度均值(Mean Average Precision, MAP)上提高了30%以上。然而,由于选择性搜索算法需要消耗大量的计算资源,并且每个目标线索进行特征提取时都要进行重复的卷积操作,导致R-CNN算法的检测速度较慢。Girshick[17]在ICCV2015上发表的Fast R-CNN算法及Ren等[3]发表的Faster R-CNN算法陆续解决了这些问题。在Fast R-CNN算法中,Ren等[18]借鉴了SPPNet空间金字塔池化的思路,通过在卷积层后加入感兴趣池化层对

不同大小的目标线索的特征图进行归一化处理,一方面克服了R-CNN算法输入图像必须为固定大小的局限,避免了图像剪裁和变形造成的目标畸变; 另一方面所有的目标线索可以共享卷积层的权重参数,大幅降低了计算资源开销。而在Faster R-CNN算法中,选择性搜索算法被区域线索神经网络(Region Proposal Neural Networks, RPN)所替代,不仅目标线索检测的精确率和召回率得到了明显改进,而且线索生成效率也获得了显著提高。为了进一步加快目标检测的效率,Redmon等[19]在CVPR2016上提出了新颖的YOLO算法。YOLO算法的创新之处在于其采用了端到端的网络结构设计,利用回归算法对目标类别以及目标边界框位置进行拟合,相比Faster R-CNN算法先产生目标线索,再对目标线索进行分类筛选的检测策略,在检测速度上有了大幅提升。

本文在分析前沿研究动态的基础上,通过DNN网络的深度学习与级联组合将搜寻分割与检测定位有机结合起来,设计构建了高性能的飞机目标检测算法。

2 快速搜寻与高效检测的组合方案 2.1 大幅面遥感图像中飞机目标的分布特点 为了调查遥感图像中飞机目标的分布规律,从Google Earth上搜集了100幅遥感图像,并对停机坪与跑道以及其他区域的飞机样本数目进行统计。不同区域停放的飞机目标样本在图 1中进行了展示。在图 1中,上下两行图像展示了两组不同区域停靠的飞机目标样本示意图。在每行图像中,停机坪、跑道以及其他区域的飞机目标样本,均为该行首列展示的原始遥感图像局部放大所得。

|

| 图 1 不同区域停靠的飞机目标样本示意图 Fig. 1 Schematic of aircraft target sample docked in various areas |

| 图选项 |

对不同区域飞机目标样本的数量进行统计,结果如表 1所示。从结果中可以看出,停机坪与跑道区域内停靠的飞机目标为1046架,占总数的97.85%,而停靠在其他区域的飞机目标为23架,占总数的2.15%。因此,对停机坪与跑道区域进行高效精准分割,可以在尽可能不遗漏飞机的条件下,大幅减少搜索范围,同时避免无关检测区域产生的干扰,显著提高飞机目标检测的效率和精度。

表 1 不同区域停靠的飞机目标样本数量统计 Table 1 Quantity statistics of aircraft target sample docked in various areas

| 区域 | 飞机目标样本数量/架 | 比例/% |

| 停机坪 | 1035 | 96.82 |

| 跑道 | 11 | 1.03 |

| 其他区域 | 23 | 2.15 |

表选项

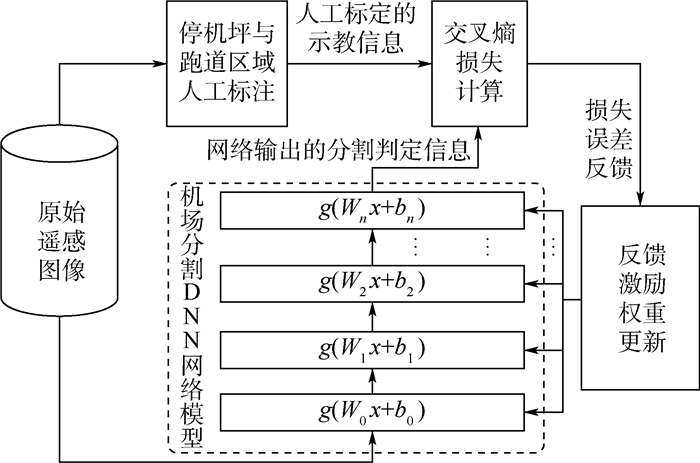

2.2 基于DNN网络的停机坪快速检测与分割 大幅面遥感图像中的停机坪与跑道区域的分割和提取不仅需要满足高精度的要求,精确判定候选检测区域范围,避免误分割和漏分割情况的发生,还需要具有很高的分割效率,满足飞机目标检测实时性的需求。借助深度学习理论,本文设计了新颖的端到端DNN网络以实现大幅面遥感图像停机坪与跑道区域的高性能分割,网络的离线监督训练如图 2所示。图中:g(·)为DNN网络模型的非线性激活函数;Wi和bi分别为第i层神经元的权重系数和偏移量。

|

| 图 2 停机坪与跑道区域分割DNN网络模型的离线监督训练 Fig. 2 Off-line supervised training of DNN model for apron and runway area segmentation |

| 图选项 |

在DNN网络的离线监督训练过程中,借助开源标注工具LableMe[20],对遥感图像样本集中的停机坪与跑道区域进行人工标注。当离线监督训练完成后,DNN网络模型便固定下来。在实际使用过程中,将原始遥感图像输入到训练好的DNN网络模型中,即可生成对应大小的停机坪与跑道区域的分割结果。

2.3 遥感图像飞机目标高效检测方案 为了满足高效检测的任务需要,基于YOLO算法,本文设计了面向大幅面遥感图像飞机目标的检测方案。该方案借助分治法的思想,采用了先拆分后拼合的策略。首先,对停机坪与跑道区域分割图像进行大小调整,并按照448像素×448像素对其进行标准块切分;然后,利用手工采集的飞机目标样本集对预训练的YOLO网络模型进行迁移式强化训练;再次,借助迁移式强化训练YOLO网络模型对标准块遥感图像进行飞机目标的检测和定位;最后,将包含飞机目标检测结果的标准块图像按原始空间排布顺序重新拼合,得到完整的大幅面遥感图像飞机目标检测结果。

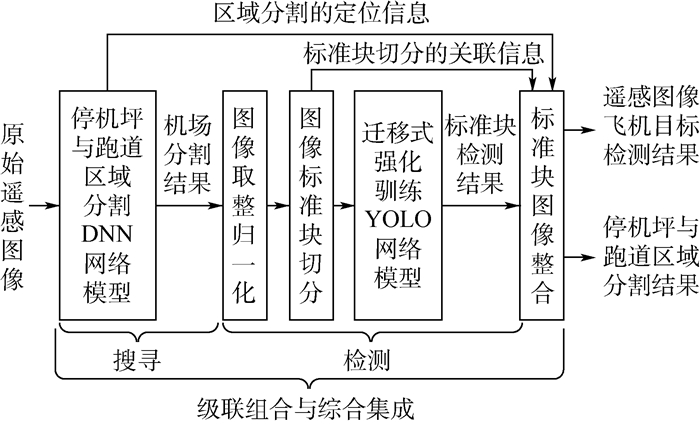

2.4 搜寻与检测相集成的级联组合方案 借助本文提出的停机坪与跑道区域分割DNN网络以及YOLO网络的性能优势,对区域搜寻与目标检测2个环节进行级联组合,给出搜寻与检测的级联组合方案,如图 3所示。

|

| 图 3 搜寻与检测的级联组合 Fig. 3 Cascade combination of searching and detection |

| 图选项 |

从图 3中可以看出,本文提出的搜寻与检测相集成的级联组合方案在候选检测区域搜寻与飞机目标检测中分别设计了不同的DNN网络以实现各自部分的功能。其优势为:①具备良好的时效性;②由于采用了端到端的设计思路,在整个飞机目标的检测过程中无需人为干预,只需提供原始的大幅面遥感图像,即可获得停机坪与跑道区域分割图像及飞机目标的检测结果,为大幅面遥感图像飞机目标的高效检测提供了便利。

3 停机坪与跑道区域的分割和提取 3.1 停机坪与跑道区域检测和分割的DNN模型 借助深度学习方法,本文设计了大幅面遥感图像停机坪与跑道区域分割深度神经网络(Large-Scale Remote Sensing Image Apron and runway Segmentation Neural Networks, LS-RSIASNN),网络模型结构及参数设置如图 4(a)所示。

|

| 图 4 停机坪与跑道区域分割DNN网络模型示意图 Fig. 4 Schematic of DNN models for apron and runway area segmentation |

| 图选项 |

从图 4中可以看出,LS-RSIASNN网络的深度为76层,相比其他DNN网络具有更深的网络结构,因而有利于抽象特征的挖掘,提高图像分割的精度。LS-RSIASNN网络模型中一共包括20个卷积网络单元(Convolutional Network, ConvNet),其中前19个用于特征提取与图像恢复,最后1个用于分割标签的生成。而在每个ConvNet中包含一个卷积层、一个最大整合层及一个激活层。所有卷积层的卷积核大小为3×3,卷积步长为1,最大整合层的步长为2。激活函数选用修正的线性单元(Rectified Linear Unit, ReLU),其解析表达式为

| (1) |

ReLU激活函数与Sigmoid和Tanh激活函数相比,由于对其局部定义域x≤0的取值限制,使之不易落入梯度死区,而扩展了活化范围。在每个激活层前设置的批归一化层能够进一步避免梯度消失和梯度爆炸情况的发生,增强DNN网络训练过程的稳定性。

LS-RSIASNN网络采用了端到端的模型结构设计,当离线训练过程完成以后,输入原始的遥感图像即可生成对应大小的分割结果,因而具备了很高的效率。与此同时,LS-RSIASNN网络借鉴了U-Net与FCN网络的设计思路,借助不同深度网络特征图的相互融合,产生性能更优的特征表达,进而实现高精度的图像分割,该方法在He[21]、Huang[22]及Su[23]等的工作中也得到了成功的应用。与U-Net不同的是,一方面LS-RSIASNN网络具有更深的网络结构,以产生更加抽象的目标特征;另一方面除了跨层的目标特征融合,LS-RSIASNN网络对相邻ConvNet输出的目标特征也进行了融合,以获取更加精确的目标分割结果。

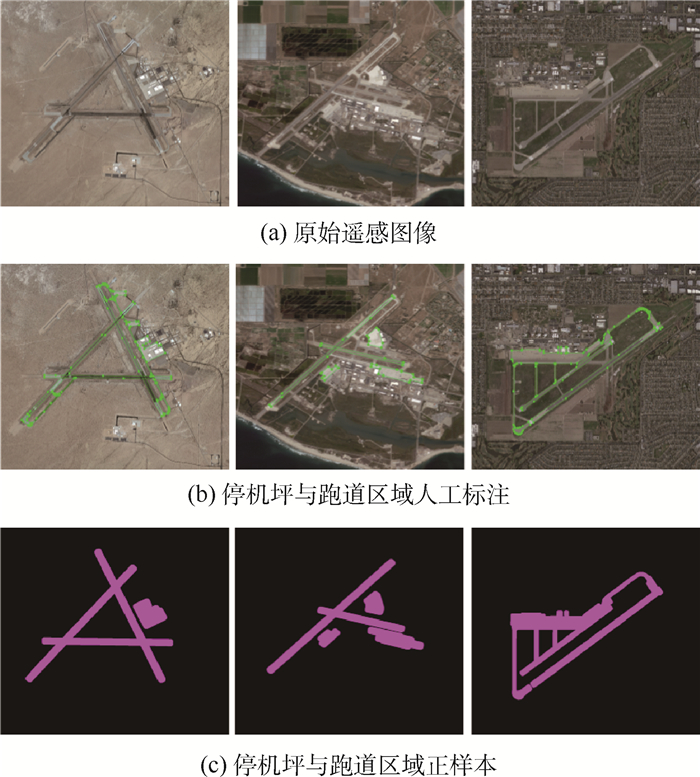

3.2 样本数据标注和DNN模型的离线监督训练 在LS-RSIASNN网络的离线监督训练中,借助开源工具LabelMe对200幅遥感图像中的停机坪与跑道区域进行人工标注。图 5展示了停机坪与跑道区域的人工标注过程及生成的停机坪与跑道区域正样本。其中,图 5(a)展示了3个不同机场拍摄的原始遥感图像;图 5(b)显示的是利用LabelMe对停机坪与跑道区域进行人工标注;图 5(c)为人工标注后对应生成的停机坪与跑道区域正样本,浅色部分代表停机坪与跑道正样本区域,黑色部分代表背景区域。

|

| 图 5 停机坪与跑道区域人工标注及样本 Fig. 5 Manual labelling samples of apron and runway areas |

| 图选项 |

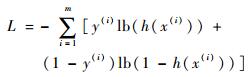

由于手工样本集数据量较为有限,将160幅图像划分为训练集对DNN网络实施离线监督训练,而其余40幅图像则作为测试集对训练完成后的DNN网络进行测试与评估。在离线监督训练过程中,借助交叉熵作为损失函数,利用自适应矩估计(Adaptive moment estimation, Adam)算法[24]对网络模型进行参数更新,交叉熵的解析表达式为

| (2) |

式中:m为像素点的个数;y(i)为第i个像素的类别标签;h(·)为Sigmoid函数。

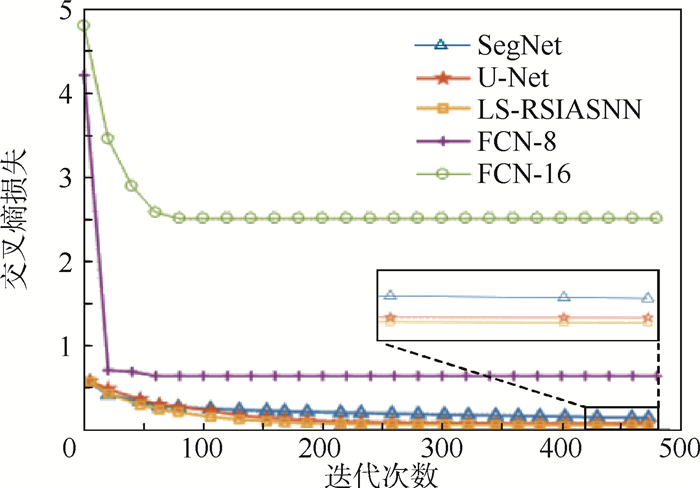

经过500轮迭代训练后DNN网络趋于收敛,其离线监督训练过程的性能进化曲线如图 6所示。可以看出,在离线监督训练过程中,LS-RSIASNN网络的交叉熵损失低于对比的其他DNN网络。进一步,借助测试集中的遥感图像对离线监督训练后的DNN网络进行停机坪与跑道区域分割实验,以对各种DNN网络的图像分割性能进行评估。

|

| 图 6 停机坪与跑道区域分割DNN网络模型性能进化曲线 Fig. 6 Performance evolution curves of DNN models for apron and runway area segmentation |

| 图选项 |

3.3 DNN网络学习进化的停机坪与跑道区域分割和提取 为了对DNN网络的图像分割性能进行评估,将测试集遥感图像送入网络中,获得停机坪与跑道区域的分割结果如图 7所示。图 7(a)的4幅原始遥感图像拍摄于4个不同的机场,图 7(b)浅色部分为人工标注的停机坪与跑道正样本,图 7(c)~(g)为不同DNN网络生成的停机坪与跑道区域分割结果。

|

| 图 7 不同DNN网络模型停机坪与跑道区域分割结果对比 Fig. 7 Comparison of apron and runway area segmentation results among various DNN models |

| 图选项 |

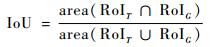

从图 7可以看到,本文提出的LS-RSIASNN网络在分割精度上明显优于对比的其他DNN网络模型。借助式(3),对分割结果的交并比(Intersection-over-Union, IoU)进行计算。

| (3) |

式中:area(·)为面积大小;RoIT为不同DNN网络生成的停机坪与跑道区域分割结果;RoIG为手工标注的正样本区域。IoU得分的分布区间为[0, 1],越接近1说明分割结果越好。

不同DNN网络停机坪与跑道区域分割IoU得分对比如表 2所示。表 2的结果在图 8中进行了更为直观的展示。

表 2 不同DNN网络模型停机坪与跑道区域分割IoU得分 Table 2 IoU for apron and runway area segmentation with various DNN models

| DNN网络 | FCN-16 | FCN-8 | SegNet | U-Net | LS-RSIASNN |

| IoU得分 | 0.1730 | 0.3840 | 0.6495 | 0.7243 | 0.7454 |

表选项

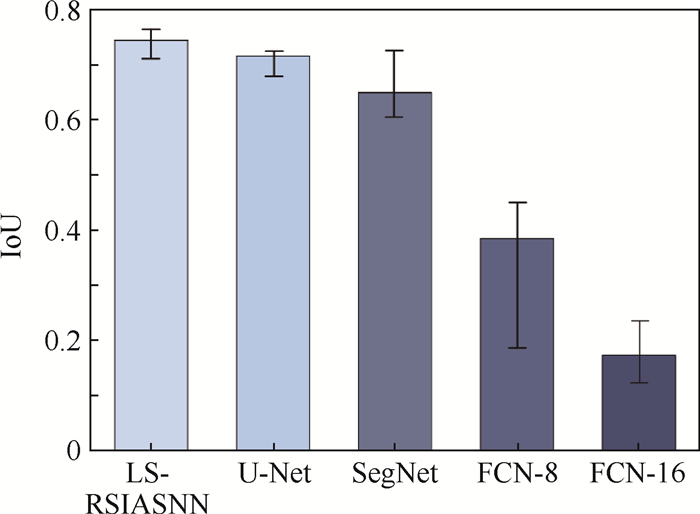

FCN-8、FCN-16网络借助上采样操作进行图像恢复,破坏了像素点之间的空间位置关系,导致分割结果欠佳。而LS-RSIASNN网络则采用了更加精确的多层反卷积操作进行图像细节恢复,借助不同深度图像特征的相互融合,获得了更为精确的分割结果。此外,还对LS-RSIASNN网络的分割效率进行了评估。在实验中,将4480像素×4480像素大小的遥感图像输入到不同的DNN网络中,统计从原始遥感图像输入到分割结果输出之间的时间开销,实验结果如图 9所示。实验中,借助一颗Nvidia Tesla M60 GPU进行运算加速,从实验结果中可以看到,单帧图像分割的时间开销具有一定的波动性,这与图像场景的复杂程度有关。而从平均时间开销来看,由于LS-RSIASNN网络具有更加复杂的结构,因此相比结构较为简单的DNN网络需要消耗更长的计算时间,但不同DNN网络的时间开销总体维持在较低水平,平均时间开销不超过1s。

|

| 图 8 不同DNN网络模型停机坪与跑道区域分割IoU对比 Fig. 8 Comparison of IoU for apron and runway area segmentation with various DNN models |

| 图选项 |

|

| 图 9 停机坪与跑道区域分割时间开销对比 Fig. 9 Comparison of time cost for apron and runway segmentation |

| 图选项 |

4 基于YOLO网络的飞机目标快速检测 借助高性能的DNN网络模型,对飞机目标可能出现的停机坪与跑道区域实施了精准的分割和提取,大幅缩小了目标搜索的区域范围。为了进一步对停机坪与跑道区域内的飞机目标进行高效检测,本节借助YOLO网络模型的迁移式强化训练,设计了飞机目标的高效检测算法。在分割的停机坪与跑道区域内,通过与R-CNN及Faster R-CNN算法的飞机目标检测结果进行对比分析,验证了本文算法的有效性。

4.1 YOLO网络原理及优势分析 YOLO网络将目标检测中的边界定位与类型判别转化为回归问题进行求解,在检测速度与召回率上优于经典的目标检测算法。同时作为一种端到端的DNN网络,YOLO网络不仅易于训练,也能大幅节省特征存储、调用等中间环节带来的计算资源消耗,有利于实现目标的实时检测。

4.1.1 YOLO网络检测算法的原理 YOLO网络由24个卷积层、4个最大整合层及2个全连接层组合而成,网络结构模型如图 10所示。

|

| 图 10 YOLO网络模型及参数设置 Fig. 10 YOLO network model and parameter setting |

| 图选项 |

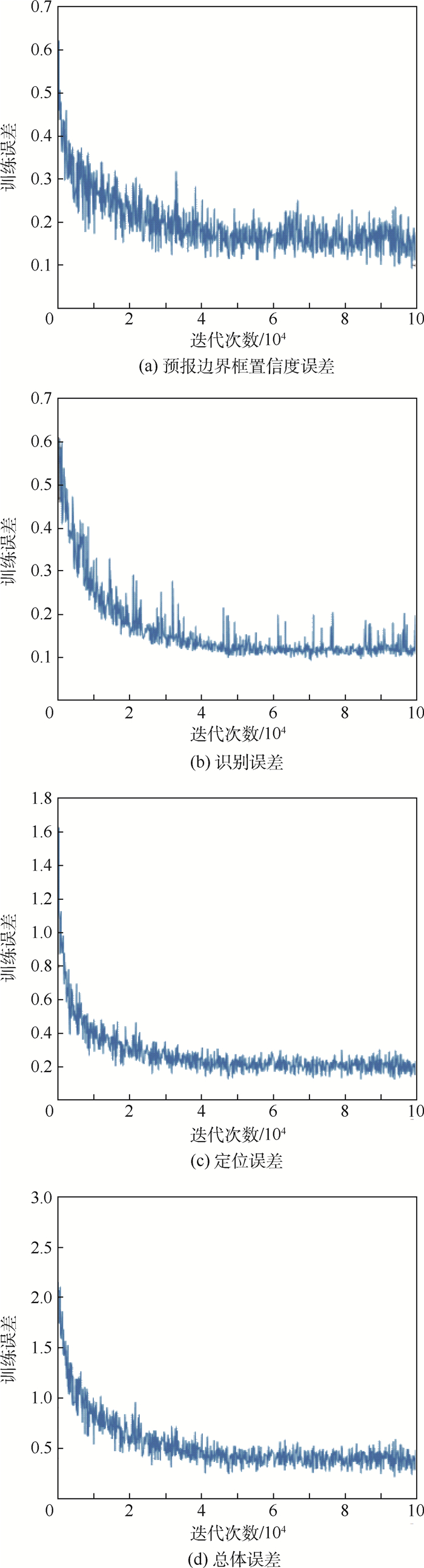

在YOLO网络中,输入图像的大小为448像素×448像素,经过网络模型计算,输出7×7×30维的特征向量,它们分别对应着原图中7×7=49个单元格区域。30维的特征向量中包含2个5维的边界框特征及一个20维的目标类别特征。5维的边界框特征中包括边界框的置信度C、归一化的边界框中心坐标

| (4) |

对7×7×2=98个预报边界框得分S进行计算并排序,设置阈值排除得分较低的边界框,进而借助非极大值抑制(Non-Maximum Suppression, NMS)去除重合的预报边界框从而获得最终的目标检测结果。

4.1.2 YOLO网络实时检测的性能优势 YOLO算法将目标检测作为回归问题进行求解,与R-CNN、Fast R-CNN及Faster R-CNN相比在计算效率上具有明显优势。R-CNN算法采用选择性搜索获得目标线索区域,进而借助DNN网络提取目标线索区域特征,利用SVM对特征进行分类从而完成目标检测任务。DNN网络及特征分类器的训练需要在多个模块中分别进行,因此检测效率较低。而Faster R-CNN算法利用RPN网络替代选择性搜索算法,借助RPN与Fast R-CNN的集成实现高效的目标检测。尽管RPN与Fast R-CNN共享了部分卷积层权重参数,但2个网络需要分别进行训练。Faster R-CNN算法虽然能够保持较高的检测精度,但在检测速度上依然不能满足实时性的需要。借助YOLO网络,原始图像通过端到端的DNN网络结构,便能直接输出目标的位置、类别及相应的置信概率,显著简化了检测流程,在检测效率上实现了大幅提升。

4.2 YOLO网络的训练策略与实施方案 YOLO网络受到Ren等[3]工作的启发,将网络分为特征提取器与目标分类器2个部分分别进行训练。在特征提取器训练阶段,借助Image-Net2012数据集,对YOLO网络中的前20个卷积层进行预训练。YOLO网络中的前20个卷积层主要用于图像特征的提取,而ImageNet2012包含的1000类目标共126万张图片,可以为特征提取器提供丰富的训练数据。YOLO网络中的后4个卷积层及2个全连接层组成的卷积特征图网络(Network on Convolution feature map, NoC)主要用于特征整合与特征分类。相比简单的Softmax分类器,NoC网络可以对高维的目标特征进行更好的区分,从而进一步提高目标检测的精度。在ImageNet2012预训练的基础上,在较小的样本集Pascal VOC 2007(20类9963张图片)上进行再次训练。最终YOLO网络在Pascal VOC 2007数据集上目标检测的平均精度均值MAP达到65.5%,弱于Faster R-CNN的71.6%,在检测速度上达到45帧/s,明显快于Faster R-CNN的0.5帧/s,在实时检测中表现出较强优势。

4.3 面向高效检测的迁移式扩充样本强化训练 借助新颖的网络结构设计及大规模数据集的离线监督训练,YOLO网络在目标检测的精度和时效性方面都达到了较高水平。为了充分利用YOLO网络的性能优势,在有限的计算资源和数据集的条件下,利用自行采集的手工训练样本集,对YOLO网络进行迁移式强化训练,从而实现飞机目标实时检测的任务需求。

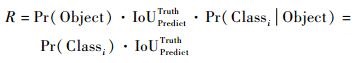

4.3.1 扩充样本的采集与标注 借助开源标注工具LabelImg,对遥感图像数据集中的飞机目标位置进行人工标注。与预训练的YOLO网络模型保持一致,训练样本集中的遥感图像大小均设置为448像素×448像素。同时采用了数据增广方法对有限的手工样本集进行扩充,如图 11所示。图 11每行4幅遥感图像拍摄于4个不同机场,图 11(b)显示的是利用LabelImg对飞机目标位置进行手工标注的过程。在手工标注过程中,LabelImg会记录下标注区域的坐标及目标的类别信息,并与Pascal VOC 2007的数据格式保持一致。

|

| 图 11 飞机目标样本的数据扩充 Fig. 11 Sample data augmentation for aircraft targets |

| 图选项 |

进一步,为了弥补手工样本集数量规模的不足,对有限的样本集进行水平和垂直翻转,使样本数量扩充至原来的3倍。通过对100幅遥感图像中的353架飞机目标进行手工标注,最终获取了1059个扩充样本及其对应的飞机目标位置信息,用于对预训练的YOLO网络进行迁移式强化训练。

4.3.2 性能迁移的合理性分析 手工采集的数据集不论在数据规模还是目标种类的多样性上都无法与ImageNet2012及Pascal VOC 2007相比。然而,大规模数据集的离线监督训练对于DNN网络模型的性能提升至关重要。在深度学习中,如果预训练模型的数据集与任务数据集在样本类型及目标特征上具有较强的相关性,则可借助迁移学习方法将预训练好的模型应用在新任务中,从而克服训练样本不足的缺点。在Pascal VOC 2007数据集中共包含9963幅20类共24640个目标的类型及位置信息,其中包括477幅共625个飞机目标样本。一方面,Pascal VOC 2007数据集中的飞机目标特征与手工建立的数据集中的飞机目标特征具有较强的相关性;另一方面,大规模数据集中不同类型目标的浅层特征,如边缘、纹理与手工数据集之间具有互通性。因此,本文中没有从头训练YOLO网络,而是在ImageNet2012及Pascal VOC 2007数据集预训练的YOLO网络模型的基础上,利用手工标注的数据集进行迁移式强化训练,从而充分利用大规模数据集的优势,实现飞机目标的高效检测。

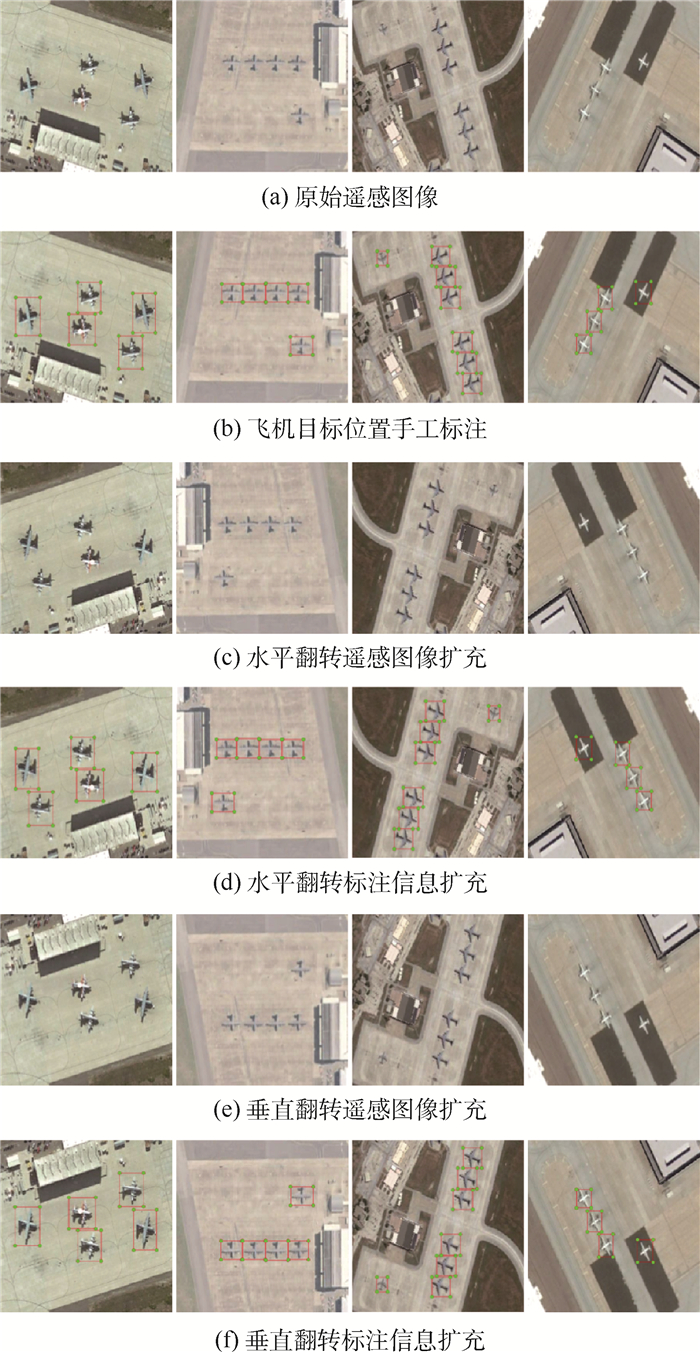

4.3.3 扩充样本监督下的强化训练 为了对预训练的YOLO网络进行迁移训练,将手工标注的飞机目标样本与Pascal VOC 2007原有的飞机目标样本的类别属性设置为一致,将预训练的模型权重参数载入到图 10所示的YOLO网络模型中,进而借助手工标注的飞机目标样本集对预训练的网络模型进行迁移训练与权重微调,其离线监督迁移强化训练过程的性能进化曲线如图 12所示。

|

| 图 12 YOLO网络性能进化曲线 Fig. 12 Performance evolution curves of YOLO networks |

| 图选项 |

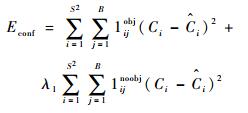

图 12(a)中曲线代表预报边界框的置信度误差Econf,用于衡量预报边界框内是否存在目标及预报边界框与真实边界框之间的重合度,其测算表达式为

| (5) |

式中:S2为图像分割的单元格数; B为预测的边界框数; 在YOLO网络参数设置中S=7, B=2;1ijobj表示第i个单元格的第j个边界框对当前预报负责,即目标的中心落在了第i个单元格内并且第i个单元格的第j个预报边界框与目标的真实边界框的重合度最高;1ijnoobj表示目标的中心没有落入第i个单元格内; Ci=Pr(Object)·IoUPredictTruth为预报的置信度结果;

图 12(b)中曲线代表识别误差Eclass,用于衡量中心落在第i个单元格内的目标是否属于正确的类别,识别误差表达式为

| (6) |

式中:1iobj表示目标的中心点落入了第i个单元格内;pi(c)为第i个单元格预报的目标类别为c的概率;

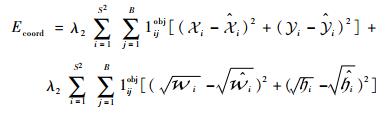

图 12(c)中曲线代表定位误差Ecoord,用于衡量预报边界框的定位精度,定位误差的测算表达式为

| (7) |

式中:

图 12(d)中的总体误差为以上3类误差的总和,表达式为

| (8) |

在迁移式强化训练过程中利用Adam算法对网络模型参数进行更新。经过10万次训练,基于扩充样本迁移式强化训练的YOLO网络模型趋于收敛。

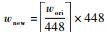

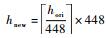

4.4 YOLO网络飞机目标检测时效性能评估 在大幅面遥感图像停机坪与跑道其余分割的基础上,对候选检测区域图像进行强化处理,只保留停机坪与跑道区域的像素值,而将背景区域的像素值置0。根据式(9)对强化图像进行尺度取整归一化处理,并利用三线性插值对图像进行分辨率提升。

| (9) |

式中:符号?·?代表向上取整;wori、hori与wnew、hnew分别为遥感图像原始及调整后的宽度与高度。

整幅遥感图像被切分为448像素×448像素的标准块子区域,进而借助迁移式强化训练YOLO网络模型对每一个标准块子区域进行飞机目标检测。将包含飞机目标检测结果的标准块图像进行重新拼合,最终得到遥感图像飞机目标的检测与定位结果。

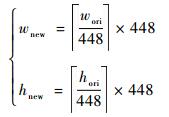

通过与R-CNN、Faster R-CNN算法进行检测时间开销对比,验证迁移式强化训练YOLO网络的时效性,实验结果如图 13所示。对实验结果进行统计,得到3种对比算法的平均检测时间开销如表 3所示。

|

| 图 13 飞机目标检测的时间开销对比 Fig. 13 Comparison of time cost for aircraft target detection |

| 图选项 |

表 3 飞机目标平均检测时间开销对比 Table 3 Comparison of average time cost for aircraft target detection

| s | |

| 算法 | 平均检测时间开销 |

| R-CNN | 2.0257 |

| Faster R-CNN | 0.0946 |

| YOLO | 0.0277 |

表选项

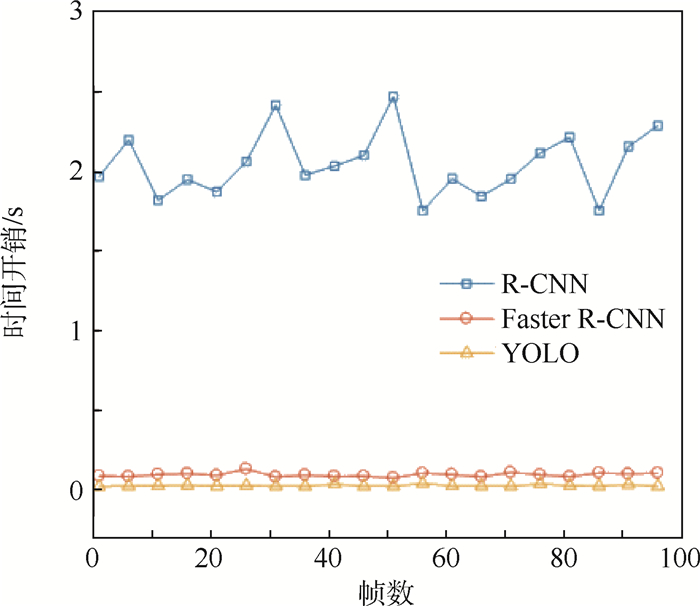

从表 3中可以看出,相比R-CNN以及FasterR-CNN算法,YOLO网络在检测速度上具有明显优势,能够为大幅面遥感图像飞机目标的实时检测提供有力支持。图 14展示了基于不同算法的飞机目标检测结果,其中每行的4幅图像均拍摄于4个不同的机场。

|

| 图 14 飞机目标检测结果对比 Fig. 14 Comparison of aircraft target detection results |

| 图选项 |

5 基于搜检级联的飞机目标高效检测 候选检测区域的高效分割及目标的快速定位是大幅面遥感图像飞机目标实时检测的2个必要环节。本节对搜索与检测的级联组合式检测方案的必要性与可行性进行了分析,借助DNN网络性能优势的互补与强化,最终形成级联组合式飞机目标高效检测算法。

5.1 搜索与检测的综合集成 在大幅面遥感图像中,飞机目标所占像素比例小,信噪比低,为了实现飞机目标的高效检测,必须对停机坪与跑道等候选检测区域进行分割和提取,缩小飞机目标的搜索范围,从而提高检测效率。同时,候选检测区域的分割和提取也能够避免背景目标引发的虚警,提高飞机目标检测精度。因此,搜寻与检测的级联组合对于大幅面遥感图像飞机目标的实时检测是必要的。

借助深度学习及高性能的端到端DNN网络模型,可以实现停机坪与跑道区域的精准分割,相比经典的图像分割算法,DNN网络在分割精度与速度上具有显著优势。进而,对停机坪和跑道区域分割图像进行取整归一化处理与标准块切分,借助迁移式强化训练YOLO网络模型对每一个标准块图像进行飞机目标检测,再将包含飞机目标检测结果的标准块图像按照原先的空间顺序进行拼合,最终得到遥感图像飞机目标的检测结果。搜寻与检测的级联组合能够满足大幅面遥感图像飞机目标检测实时性与精确性的应用需求,因此该方案是可行的。

5.2 级联组合式飞机目标高效检测算法 根据第3、4节所述内容,给出级联式飞机目标高效检测算法。

输入:原始遥感图像Iori。

输出:飞机目标检测结果Iresult。

初始化:原始遥感图像的长宽w, h。

步骤1??利用标注工具LabelMe制作机场分割数据集

步骤2??利用数据集

步骤3??将原始遥感图像Iori输入到Model1中得到机场分割图像Iairport。

步骤4??调整Iairport长宽至

步骤5??切分Iairport为448像素×448像素的子图

步骤6??利用标注工具LabelImg制作飞机目标检测数据集

步骤7??在Pascal VOC 2007的YOLO网络模型基础上,利用

步骤8??将Iset的每一帧输入到Model2中得到飞机目标检测结果I′set={I′1, I′2, …, I′n}。

步骤9??将I′set重新合并为整幅遥感图像,得到最终的飞机目标检测结果Iresult。

在级联式飞机目标高效检测算法中,候选检测区域的高效搜寻与飞机目标的精准定位分别采用了不同的DNN网络予以实现。在网络模型的离线监督训练上,停机坪与跑道区域分割DNN网络选择了完整训练的方式,而在飞机目标检测中,则借助YOLO网络的迁移式强化训练弥补了手工数据集数据规模上的不足。由于YOLO网络模型图像处理尺寸的限制,在算法中采用了先切分再拼合的检测策略,而小范围的图像调整对于大幅面遥感图像中目标的形变影响较为微弱,同时也可以借助大数据集数据规模与样本类型多样性的优势进一步提高飞机目标检测的结果。

6 综合实验与性能分析 本节利用实际的大幅面遥感图像对级联式飞机目标高效检测算法进行综合实验验证。在实验中,借助精确率、漏检率及时效性,与R-CNN、Faster R-CNN的目标检测算法进行对比分析,验证本文算法的有效性。

6.1 数据库与实验平台 实验采集了40幅可见光遥感图像作为测试集,图像大小均为4480像素×4480像素。数据集涵盖了轰炸机、预警机、运输机、战斗机等多种机型、多种尺寸大小的飞机目标。实验硬件平台由一颗Nvidia Tesla M60 GPU提供运算加速。实验软件平台为Python 2.7.13,深度学习框架为基于TensorFlow 1.02的Keras 2.0.9。

6.2 实验框架设计与参数设置 为了对本文算法的精度和效率进行综合分析与性能评估,设计综合实验框架如下:首先,利用R-CNN、Faster R-CNN及YOLO算法在原始遥感图像及停机坪与跑道区域分割图像中分别进行飞机目标检测实验,对比相同算法在停机坪与跑道区域分割前、后飞机目标检测的精确率、漏检率及时间开销3个性能指标的差异,验证基于DNN网络的停机坪和跑道飞机目标候选检测区域分割对于检测性能提升的有效性。然后,对R-CNN、Faster R-CNN及YOLO算法的检测结果进行横向对比,验证YOLO算法在检测时效性方面的优势。在所有实验中,输入的原始遥感图像大小为4480像素×4480像素。整幅图像被切分为100个标准块子区域分别进行检测,然后按照原先的顺序进行拼合,最终给出飞机目标检测的最终结果。

6.3 实验结果与性能评估 在综合实验中,借助LS-RSIASNN网络对停机坪和跑道区域进行分割提取,不同算法进行飞机目标检测的实验结果如图 15所示。从飞机目标检测结果的对比中可以得知,停机坪与跑道区域的精确分割可以大幅减少背景区域带来的虚警干扰。从图 15(c)、(e)、(g)三幅图像可知,R-CNN、Faster R-CNN及YOLO算法在停机坪与跑道区域之外都检测到了大量的虚警目标。与之相比,图 15 (d)、(f)、(h)三幅图像只对停机坪与跑道区域内的飞机目标进行检测,因而大幅减低了虚警发生的概率。

|

| 图 15 综合实验结果对比 Fig. 15 Comparison of comprehensive experimental results |

| 图选项 |

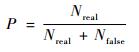

为了对检测结果进行定量分析,对R-CNN、FasterR-CNN及YOLO算法的精确率、漏检率及时间开销进行了对比,其中精确率P、漏检率M表达式为

| (10) |

| (11) |

式中:Nreal为预测正确的飞机目标数量;Nfalse为虚警目标数量;Nmiss为未检测到的飞机目标数量;Ntotal为飞机目标的总数。精确率P反映了所有检测目标中真实飞机目标正确检测数所占的比例,而漏检率M反映了真实飞机目标的漏检数量占真实飞机目标总数的比例,实验结果如表 4所示。

表 4 飞机目标检测性能对比 Table 4 Performance comparison of aircraft target detection

| 算法 | 图像类型 | 精确率/% | 漏检率/% | 时间开销/s |

| R-CNN | 原始遥感图像 | 56.25 | 18.72 | 385.51 |

| 停机坪与跑道区域分割图像 | 78.32 | 15.35 | 87.49 | |

| Faster R-CNN | 原始遥感图像 | 68.87 | 6.31 | 039.46 |

| 停机坪与跑道区域分割图像 | 94.69 | 5.19 | 28.29 | |

| YOLO | 原始遥感图像 | 62.56 | 10.83 | 006.65 |

| 停机坪与跑道区域分割图像 | 90.28 | 9.26 | 4.76 |

表选项

从表 4中可以看到,停机坪和跑道区域的精确提取减少了无关区域虚警目标的干扰,3种飞机目标检测算法的精确率均得到了明显提升。在漏检率上,Faster R-CNN相比YOLO和R-CNN算法具有一定优势,其主要原因在于:Faster R-CNN算法中,在特征图的每个像素点上会生成9种不同大小和宽高比的预测框对可能出现的飞机目标线索区域进行判定。与之相比,YOLO算法在每个单元格区域内只生成2个候选的预测框,而R-CNN算法利用选择性搜索判断目标可能出现的潜在区域,因此Faster R-CNN算法的RPN网络在飞机目标线索的数量上具有一定优势,可以减少飞机目标漏检情况的发生。然而,过多的目标线索也会增加检测时间的开销。通过3种算法的对比可以看到,YOLO算法的检测效率相比Faster R-CNN及R-CNN算法有明显优势,同时在精确率和漏检率上也能保持在满意的水平。搜寻与检测相集成的级联组合式飞机目标检测方案的有效性得到了充分验证。

为了增强YOLO算法在漏检率上的性能表现,一方面可以缩小单元格区域的面积,提高算法对小尺度飞机目标的检测效果,另一方面也可以增加每个单元格区域候选预测框的数量,从而减少飞机目标漏检情况的发生。

6.4 述评与注解 候选检测区域的精准分割及高效的目标检测算法是实现大幅面遥感图像飞机目标实时检测的必要环节。借助DNN网络对复杂外型的停机坪和跑道区域实施精准分割,GPU单元提供的运算加速,使得DNN网络在分割速度上能够保持明显优势。YOLO算法将目标定位和目标类型判别合并为一个回归问题进行求解,相比R-CNN及Faster R-CNN算法具有更强的时效性,同时在检测精度上也能保持在满意的水平。因此,本文提出的搜寻与检测相集成的级联式飞机目标高效检测算法在大幅面遥感图像的飞机目标检测中具有较强的综合优势。

7 结论 本文提出了一种新颖的搜寻与检测相集成的级联式飞机目标高效检测算法,以实现大幅面遥感图像中飞机目标的高效精准检测与定位。算法将候选检测区域的高精度分割及面向候选区域的目标高效检测级联为统一的整体,通过高性能的DNN网络的相互协作,实现优势互补与增强。级联组合式目标检测算法在检测的时效性上具有较为明显的优势,同时在检测精度上也能达到较高水平,能够为大幅面遥感图像飞机目标的高效检测与定位提供有效帮助。在后续的工作中,计划将基于深度学习的视觉注意力机制引入到算法中,从而实现更大幅面遥感图像停机坪与跑道区域的快速定位与分割,使算法的实用性得到进一步的提高。

参考文献

| [1] | HAN Z X, ZHANG H, ZHANG J F, et al.Fast aircraft detection based on region locating network in large-scale remote sensing images[C]//24th IEEE International Conference on Image Processing.Piscataway, NJ: IEEE Press, 2017: 2294-2298. |

| [2] | GIRSHICK R, DONAHUE J, DARRELL T, et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2014: 580-587. |

| [3] | REN S, HE K, GIRSHICK R, et al. Faster R-CNN:Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [4] | 赵雪梅, 李玉, 赵泉华. 基于隐马尔可夫高斯随机场模型的模糊聚类高分辨率遥感影像分割算法[J]. 电子学报, 2016, 44(3): 679-686. ZHAO X M, LI Y, ZHAO Q H. Hidden Markov Gaussian random field based fuzzy clustering algorithm for high-resolution remote sensing image segmentation[J]. Acta Electronica Sinica, 2016, 44(3): 679-686. DOI:10.3969/j.issn.0372-2112.2016.03.028 (in Chinese) |

| [5] | 陈荣元, 徐雪松, 李广琼, 等. 自适应特征加权的Gibbs随机场影像分割方法[J]. 电子学报, 2016, 44(10): 2351-2356. CHEN R Y, XU X S, LI G Q, et al. Image segmentation by combining adaptively weighted features with Gibbs random field[J]. Acta Electronica Sinica, 2016, 44(10): 2351-2356. DOI:10.3969/j.issn.0372-2112.2016.10.010 (in Chinese) |

| [6] | BUDAK U, HALICI U, SENGUR A, et al. Efficient airport detection using line segment detector and Fisher vector representation[J]. IEEE Geoscience & Remote Sensing Letters, 2016, 13(8): 1079-1083. |

| [7] | WANG Y, PAN L. Automatic airport recognition based on saliency detection and semantic information[J]. ISPRS International Journal of Geo-Information, 2016, 5(7): 115-118. DOI:10.3390/ijgi5070115 |

| [8] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E.ImageNet classification with deep convolutional neural networks[C]//International Conference on Neural Information Processing Systems, 2012: 1097-1105. |

| [9] | LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651. DOI:10.1109/TPAMI.2016.2572683 |

| [10] | BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet:A deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495. DOI:10.1109/TPAMI.2016.2644615 |

| [11] | RONNEBERGER O, FISCHER P, BROX T.U-Net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-assisted Intervention.Berlin: Springer, 2015: 234-241. |

| [12] | DAN C C, GIUSTI A, GAMBARDELLA L M, et al. Deep neural networks segment neuronal membranes in electron microscopy images[J]. Advances in Neural Information Processing Systems, 2012, 25: 2852-2860. |

| [13] | CHEN L, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[J]. Computer Science, 2014(4): 357-361. |

| [14] | ZHAO H, SHI J, QI X, et al.Pyramid scene parsing network[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2017: 6230-6239. |

| [15] | CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab:Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFS[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 |

| [16] | HE K, GKIOXARI G, DOLLAR P, et al.Mask R-CNN[C]//IEEE International Conference on Computer Vision.Piscataway, NJ: IEEE Press, 2017: 2980-2988. |

| [17] | GIRSHICK R.Fast R-CNN[C]//IEEE International Conference on Computer Vision.Piscataway, NJ: IEEE Press, 2015: 1440-1448. |

| [18] | HE K, ZHANG X, REN S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 |

| [19] | REDMON J, DIVVALA S, GIRSHICK R, et al.You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2016: 779-788. |

| [20] | TORRALBA A, RUSSELL B C, YUEN J. LabelMe:Online image annotation and applications[J]. Proceedings of the IEEE, 2010, 98(8): 1467-1484. DOI:10.1109/JPROC.2010.2050290 |

| [21] | HE K, ZHANG X, REN S, et al.Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2016: 770-778. |

| [22] | HUANG G, LIU Z, WEINBERGER K Q, et al.Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2017: 3-8. |

| [23] | SU W, WANG Z. Widening residual skipped network for semantic segmentation[J]. IET Image Processing, 2017, 11(10): 880-887. DOI:10.1049/iet-ipr.2017.0070 |

| [24] | KINGMA D P, BA J.Adam: A method for stochastic optimization[EB/OL]. (2014-12-22).https://arxiv.org/abs/1412.6980. |