, 于欢1,2, 张汉宇1

, 于欢1,2, 张汉宇1 1. 吉林大学 通信工程学院,吉林 长春 130022;

2. 上海无线电设备研究所,上海 201109

收稿日期:2020-04-14

基金项目:国家自然科学基金重点资助项目(61631009);吉林省自然科学基金资助项目(20200201295JC)。

作者简介:桑爱军(1973-),女,山东莱州人,吉林大学教授。

摘要:为提高监控视频的编码效率,在AVS监控伸展档次的编码框架下,提出一种新的背景帧更新方法,即迭代更新均值法.根据某一像素在前景区域和背景区域出现频率不同的原理来确定该像素点在某一帧中的性质.通过在监控视频Crossroad,Overbridge和Classover的测试比较,得到不同性质的像素点对应的背景模型像素值.结果表明,慢速运动物体难以从背景中消除的缺点得到一定程度的改进,同时加强了背景信息的完整性和提高了背景帧的质量.在同等码率和相同峰值信噪比的条件下,相比于AVS基准档次方法平均节省码率为43.283%,平均提高峰值信噪比1.186 dB,其监控视频的编码效率也得到了提升.

关键词:背景帧更新方法背景模型监控视频AVS监控伸展档次AVS基准档次

AVS-S Coding Based on Background Model

SANG Ai-jun1

, YU Huan1,2, ZHANG Han-yu1

, YU Huan1,2, ZHANG Han-yu1 1. College of Telecommunication Engineering, Jilin University, Changchun 130022, China;

2. Shanghai Radio Equipment Research Institute, Shanghai 201109, China

Corresponding author: SANG Ai-jun, professor, E-mail: sangaj@jlu.edu.cn.

Abstract: In order to improve the coding efficiency of surveillance video, a new background frame update method was proposed, namely, iterative update mean value method, under the coding framework of AVS surveillance extension grade. The nature of the pixel in a certain frame was determined according to the principle of different frequencies of occurrence of a certain pixel in the foreground area and in the background area. Through the test comparison of the surveillance video Crossroad, Overbridge and Classover, the pixel values of the background model corresponding to the pixels of different nature were obtained. The results showed that the shortcomings that slow moving objects are difficult to eliminate from the background are improved to a certain extent in this experiment. At the same time, the integrity of the background information is strengthened and the quality of the background frame is improved. Under the conditions of the same bit rate and the same peak signal-to-noise ratio, compared with the AVS benchmark method, the average code saving rate is 43.283% and the peak signal-to-noise ratio is increased by 1.186 dB on average. The coding efficiency of its surveillance video is also improved.

Key words: background frame update methodbackground modelsurveillance videomonitoring the AVS stretch gradeAVS benchmark grade

随着人们对安全意识的增强,监控视频的普及程度越来越高[1-4].如何能够提高监控视频的编码效率,是该领域所面临的一系列重要挑战.通常监控视频[5-7]有以下特点:固定的摄像头位置,光线变化呈一定规律性,场景变化少.根据这些特点,人们主要采用面向对象的编码方法[8-11]、基于感兴趣区域的编码优化方法和背景参考图像的编码优化方法[12-15]来解决监控视频中的编码问题.监控视频一般工作时间都是持续的,并且时间很长,为了减少监控视频工作的时间,选择合适的编码技术进行编码在实际应用中有很重要的意义.AVS监控伸展档次,即AVS-S,在该框架中有背景帧(G帧)和背景预测帧(S帧),其中G帧是帧内预测编码时所使用的背景图像,用来显示场景信息,为S帧提供背景信息;S帧大大提高了监控视频的编码效率.该方法主要是通过消除监控视频中的背景冗余实现的.

本文在AVS-S的编码框架之下,提出一种新的背景帧更新方法,即迭代更新均值法(iterative update average, IUA),该方法进一步加强了背景信息的完整性和提高了背景帧的质量,提升了监控视频的编码效率.

1 背景帧(G帧)更新1.1 建立背景模型的理论基础在监控视频中,运动物体运行轨迹经过的区域将会进行背景状态和前景状态之间的转换,而大部分区域将会长时间处于背景状态.因此,忽略光线及自然现象等客观因素的影响,像素点的状态可分为两类:背景像素值和前景像素值.

在任意一监控视频中,取某一像素点在一定范围的连续帧内的全部像素值组成集合A,则集合A内的所有数据是一组分类数据.分类数据是统计学中一种反映事物类别的数据,是离散数据.集合A中不同性质的数据之间相互独立,同一性质的数据之间具有相关性,因此可以根据数据之间的关系完成对集合A的分组.分组后集合A中包括众数组和非众数组,通过异众比率可以判定每个数组的性质.

异众比率是指非众数出现的频数占总频数的比例,即

| (1) |

1.2 影响背景帧质量的因素在监控视频编码的过程中,背景帧的质量越好,最终的编码效率越高.而影响背景帧质量的因素有以下两种:

1) 训练集长度将会影响背景帧的质量.要想提高背景模型的质量和不断改善建模的效果,就要有充足的可参考实验数据和足够长的训练集长度,G帧更新的方法正好可以满足这两点要求.但是由于运动目标出现的不确定性,所以对建模效果也会有不同程度的影响.因此背景模型的质量与训练集的长度不成正比.

2) 前景目标的运动速度将会影响背景帧的质量.在测试视频中,物体停留在某一像素点区域的时间由物体的运动速度决定,对建模效果也会有不同程度的影响,物体运动越快,影响越小,反之则相反.故要消除慢速运动的物体对背景模型的影响更困难.

2 迭代更新均值法2.1 基本原理迭代更新均值法通过众数将数据进行分组.根据异众比率判定该组数据的状态,并根据像素点状态的不同选择不同的处理方法,得到最终的背景模型.

根据对当前像素点的性质进行判定的结果共有三种,分别是仅受光照、受快速运动物体以及慢速运动物体影响的像素点.仅受光照影响的像素点的影响因素为光照的自然变化;快速运动的物体经过像素点停留时间短,对建模效果影响小;慢速运动物体与快速运动物体情况相反.迭代更新均值法对不同性质的像素点采用相对应的处理方法,尽可能减少对建模效果的影响,保留更为准确的背景像素值.

2.2 具体步骤1) 初始化.创建数据集,其长度为M,数据集用来存放前M帧数据,即

|

2) 选择阈值.记μ为均值,σ2为方差,则对应的正态分布为

| (2) |

3) 数据判定及分组.当前像素值It(x, y)根据式(3)判定其状态,若式(3)成立,则Ft(x, y)记为1,否则记为0.其中,Ft(x, y)见文献[16],为当前像素点状态判定标志,该标志的值用于后续的背景像素点的判定.

| (3) |

5) 循环步骤1)~4)直至遍历训练集所有像素点,得到最终的背景模型.

2.3 参数选取迭代更新均值法中当前像素点的长度为K,而训练集的长度为L(K < L),在这L帧的训练集中找出出现频率最高的像素值,并判定其当前像素点的状态.其中训练集长度L决定了阈值的大小以及Ft(x, y)的数值,通过阈值以及Ft(x, y)判断像素点在背景中保持时间的长短和物体运动的快慢,进而得到该点像素值的求解方式,最终得到背景模型,可见L在该算法中的取值至关重要.

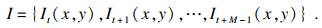

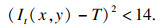

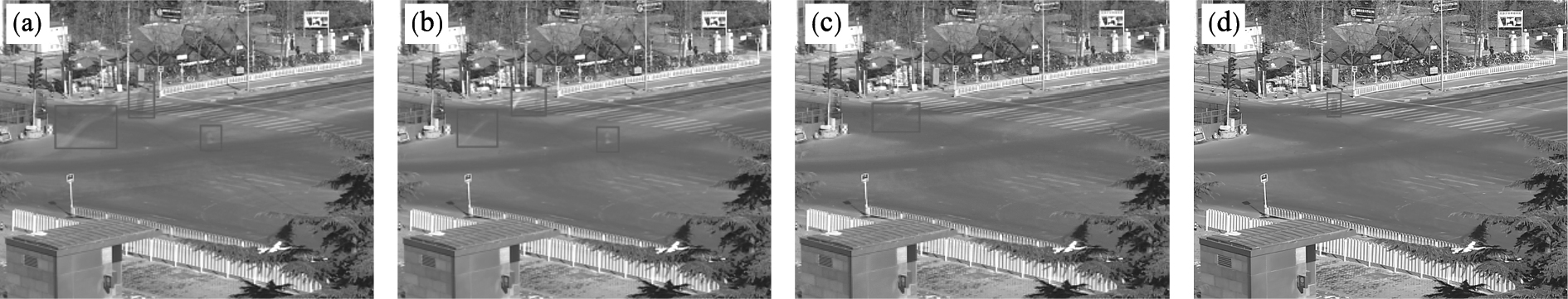

选择不同长度的训练集和判定像素值状态的数据集,长度分别用L和K表示,本实验取L为100, 200,K为10, 50,在此数据条件下观察背景模型效果.图 1~图 3分别是视频训练集Classover,Crossroad和Overbridge在此数据下的实验仿真结果,图中方框是不同训练集、不同训练长度及不同当前像素点条件下得到的运动目标.

图 1(Fig. 1)

| 图 1 训练集Classover下的背景模型Fig.1 Background model under the training set Classover (a)—L=100,K=10;(b)—L=200,K=10;(c)—L=100,K=50;(d)—L=200,K=50. |

图 2(Fig. 2)

| 图 2 训练集Crossroad下的背景模型Fig.2 Background model under the training set Crossroad (a)—L=100,K=10;(b)—L=200,K=10;(c)—L=100,K=50;(d)—L=200,K=50. |

图 3(Fig. 3)

| 图 3 训练集Overbridge下的背景模型Fig.3 Background model under the training set Overbridge (a)—L=100,K=10;(b)—L=200,K=10;(c)—L=100,K=50;(d)—L=200,K=50. |

通过直观地观察和客观的实验结果分析可以得出,在当前像素点的长度和训练集长度分别为K=50,L=200条件下,可以获得最佳的背景模型效果.因此迭代更新均值法中的参数选取为L=200,K=50.

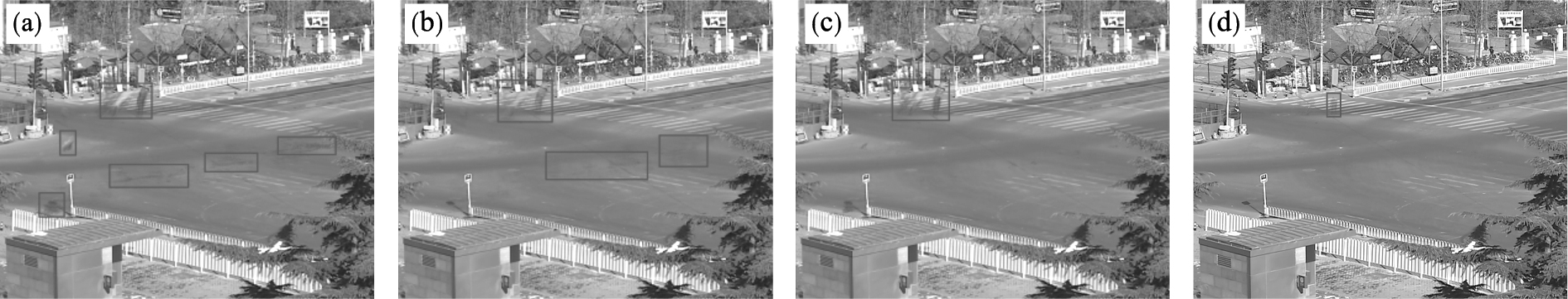

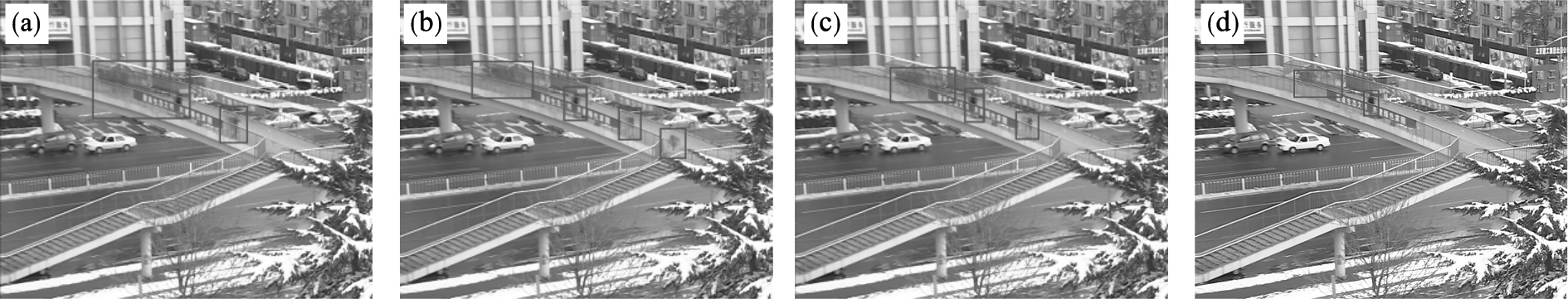

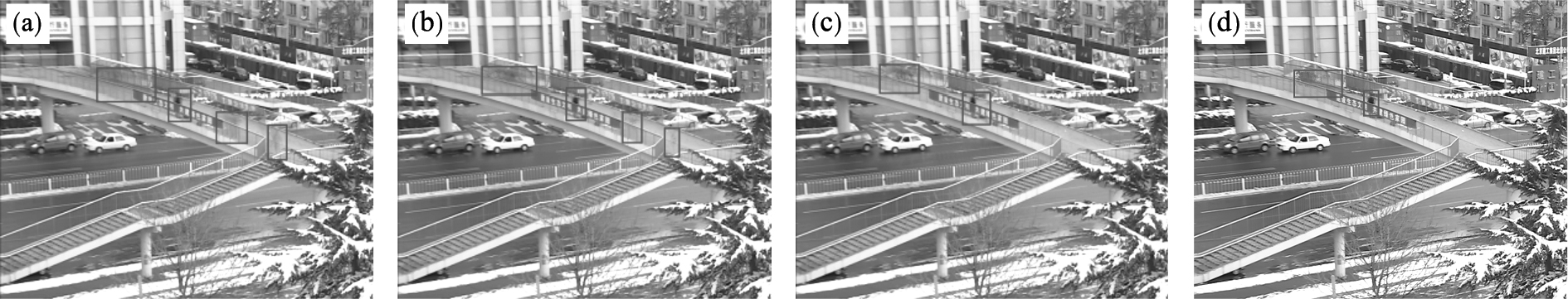

3 实验结果及分析在AVS-S框架中,选取分段加权滑动平均值法(SWRA)、均值法(AV)以及混合高斯背景建模法(GMM)在训练集长度为200所生成的背景模型,同迭代更新均值法(IUA)所生成的背景模型进行比较,如图 4~图 6所示,图中方框为不同方法在不同训练集条件下得到的运动目标.从图中可看出,IUA所生成的背景模型在主观质量上要优于其他方法所生成的背景模型,并且SWRA方法生成的背景模型要优于AV和GMM方法.为了更进一步地观察背景帧质量对监控视频编码效率的影响,对编码效率进行以下数据分析.

图 4(Fig. 4)

| 图 4 不同方法在训练集Crossroad下所生成的背景模型Fig.4 Background models generated by different methods under the training set Crossroad (a)—AV;(b)—SWRA;(c)—GMM;(d)—IUA. |

图 5(Fig. 5)

| 图 5 不同方法在训练集Overbridge下所生成的背景模型Fig.5 Background models generated by different methods under the training set Overbridge (a)—AV; (b)—SWRA;(c)—GMM;(d)—IUA. |

图 6(Fig. 6)

| 图 6 不同方法在训练集Classover下所生成的背景模型Fig.6 Background models generated by different methods under the training set Classover (a)—AV; (b)—SWRA;(c)—GMM;(d)—IUA. |

本文实验中全部测试视频来自PKU-SVD-A,仿真软件为AVS-S编解码软件的官方版本RM09.13-v3.将AVS-S框架下的IUA和SWRA以及AVS基准档次在不同监控视频下进行编码效率对比.码率与峰值信噪比的关系曲线如图 7所示,生成率失真曲线相关数据以及实验参数设置见文献[16].根据图 7可以得出,在三种不同监控视频下,IUA编码性能优于其他两种编码方法,其中峰值信噪比越大编码性能越好,码率是单位时间内视频传输的数据量,单位为Kb/s,码率值越大,视频中信息量越大.对三种编码方式进行数值分析,如表 1所示,评价指标为BDBR和BD-PSNR[17].BDBR表示在相等的峰值信噪比下,在率失真曲线中画一条水平线,得到的两种方法码率节省情况,即水平方向分析编码性能;BD-PSNR表示在相同的码率下,在率失真曲线中画一条垂直线,得到的两种方法峰值信噪比差异,即垂直方向分析编码性能.客观分析与直观观察结果保持一致,通过表 1分别计算三种视频中得出的BDBR和BD-PSNR平均值,得出本文方法的G帧比SWRA方法平均节省码率12.402%,平均峰值信噪比提高0.363 dB;同理,与AVS基准档次相比平均节省码率43.283%,平均峰值信噪比提高1.186 dB.

图 7(Fig. 7)

| 图 7 不同训练集下编码性能对比Fig.7 Comparison of coding performance under different training sets (a)—Crossroad;(b)—Overbridge;(c)—Classover. |

表 1(Table 1)

| 表 1 本文方法与各编码方法比较 Table 1 Comparison between the proposed methodand each coding method | ||||||||||||||||||||||||||||||||||||||

4 结论在AVS的编码框架下,本文提出一种新的G帧更新方法,即迭代更新均值法.该方法可以很好地区分不同运动速度的物体,从而得到视频中较为完整的背景信息,提高了背景帧的质量,并且在同等码率和相同峰值信噪比的条件下,G帧更新方法的编码效率要优于AVS基准档次方法和分段加权滑动平均值法,是一种更加高效的编码方法.

参考文献

| [1] | Eren H, Melike S, Cem D, et al. A novel framework and concept-based semantic search interface for abnormal crowd behaviour analysis in surveillance videos[J]. Multimedia Tools Applications, 2020, 79(25/26): 17579-17617. |

| [2] | Sun H, Shi W, Xu L. VU:edge computing-enabled video usefulness detection and its application in large-scale video surveillance systems[J]. IEEE Internet of Things Journal, 2020, 7(2): 800-817. DOI:10.1109/JIOT.2019.2936504 |

| [3] | 张晴. 视频监控系统在手术室护理安全管理中的应用[J]. 中医药管理杂志, 2019, 27(22): 131-132. (Zhang Qing. Application of video monitoring system in nursing safety management of operating room[J]. Journal of Chinese Medicine Management, 2019, 27(22): 131-132.) |

| [4] | Ma M, Song H B. Effective moving object detection in H.264/AVC compressed domain for video surveillance[J]. Multimedia Tools and Applications, 2019, 78: 35195-35209. DOI:10.1007/s11042-019-08145-4 |

| [5] | Xiem H V, Le D T H, Giap P V.Adaptive long-term reference selection for efficient scalable surveillance video coding[C]//2018 IEEE 12th International Symposium on Embedded Multicore/Manycore Systems-on-Chip(MCSoC).Hanoi: IEEE, 2018: 69-73. |

| [6] | Shao Z F, Wang L G, Wang Z Y, et al. Saliency-aware convolution neural network for ship detection in surveillance video[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2020, 30(3): 781-794. DOI:10.1109/TCSVT.2019.2897980 |

| [7] | Fayyaz M A, Anjum A, Ziauddin S, et al. An improved surveillance video forgery detection technique using sensor pattern noise and correlation of noise residues[J]. Multimedia Tools and Applications, 2020, 79: 5767-5788. DOI:10.1007/s11042-019-08236-2 |

| [8] | 宋庆昌, 赵庆波, 王丽华. 基于Solr与面向对象的全物资编码的研究应用[J]. 现代信息科技, 2019, 3(6): 166-168. (Song Qing-chang, Zhao Qing-bo, Wang Li-hua. Research and application of Solr and object oriented full material coding[J]. Modern Information Technology, 2019, 3(6): 166-168. DOI:10.3969/j.issn.2096-4706.2019.06.067) |

| [9] | Madhav H, Kumar V.A method for predicting software reliability using object oriented design metrics[C]//2019 International Conference on Intelligent Computing and Control Systems.Madurai, India: IEEE, 2019: 679-682. |

| [10] | Tan Q, Guo B, Hu J, et al.Object-oriented remote sensing image information extraction method based on multi-classifier combination and deep learning algorithm[EB/OL].(2020-08-31)[2020-09-02].https://doi.org/10.1016/j.patrec.2020.08.028. |

| [11] | Gu A, Li l, Li S, et al. Method of coupling metrics for object-oriented software system based on CSBG approach[J]. Mathematical Problems in Engineering, 2020(5): 1-20. |

| [12] | Sun X, Ma H, Zuo W. Perceptual-based HEVC intra coding optimization using deep convolution networks[J]. IEEE Access, 2019(7): 56308-56316. |

| [13] | 陈方栋.基于背景建模的高性能视频编码方法研究[D].合肥: 中国科学技术大学, 2017. (Chen Fang-dong.Research on background modeling based high efficiency video coding method[D].Hefei: University of Science and Technology of China, 2017. ) |

| [14] | Li H, Ding W, Shi Y, et al.A double background based coding scheme for surveillance videos[C]//2018 Data Compression Conference.Snowbird: IEEE, 2018: 420-420. |

| [15] | Han S, Zhang X, Tian Y, et al.An efficient background reconstruction based coding method for surveillance videos captured by moving camera[C]//2012 IEEE Ninth International Conference on Advanced Video and Signal-Based Surveillance.Beijing: IEEE, 2012: 160-165. |

| [16] | 于欢.面向监控视频的高效压缩编码算法研究[D].长春: 吉林大学, 2018. (Yu Huan.Research on high efficiency compression coding algorithm for surveillance video[D].Changchun: Jilin University, 2018. ) |

| [17] | Bjontegaad G.Calculation of average PSNR differences between RD curves[EB/OL].(2001-04-01)[2020-03-15].http://ss.zhizhen.com/s?ecode=utf-8&sw=Calculation+of+Average+PSNR+Differences+between+RD-curves&strchannel=. |