,1,*, 曹畅

,1,*, 曹畅 ,1, 唐雄燕

,1, 唐雄燕 ,1, 何涛

,1, 何涛 ,1, 李建飞

,1, 李建飞 ,1, 刘秋妍

,1, 刘秋妍 ,2

,2Research on Edge Resource Scheduling Solutions for Computing Power Network

Li Mingxuan ,1,*, Cao Chang

,1,*, Cao Chang ,1, Tang Xiongyan

,1, Tang Xiongyan ,1, He Tao

,1, He Tao ,1, Li Jianfei

,1, Li Jianfei ,1, Liu Qiuyan

,1, Liu Qiuyan ,2

,2通讯作者: * 李铭轩(E-mail:limx59@chinaunicom.cn)

收稿日期:2020-03-28网络出版日期:2020-08-20

| 基金资助: |

Received:2020-03-28Online:2020-08-20

作者简介 About authors

李铭轩,中国联通网络技术研究院高级工程师,硕士,美国IEEE高级会员,中国电子学会高级会员,从事技术研发和标准跟踪工作。主要研究方向为大数据技术,云计算技术,业务平台技术和IT支撑系统技术;参与CCSA、GSMA、ITU等国内外标准组织的会议。

本文中负责整体技术解决方案设计、技术架构设计。

Li Mingxuan, master’s degree, senior engineer of China Unicom Network Technology Research Institute, senior member of the United States IEEE, senior member of the Chinese Institute of Electronics, engaged in technology research and development and standard tracking; the main research directions are big data technology, cloud computing technology, business platform technology And IT support system technology; participate in CCSA, GSMA, ITU and other domestic and international standards organizations meetings.

In this paper, he is responsible for overall technical solution design, technical architecture design.

E-mail:

曹畅,中国联合网络通信有限公司网络技术研究院未来网络研究部,高级专家、智能云网技术研究室主任,博士后,主要研究方向为IP网宽带通信、SDN/NFV、新一代网络编排技术等。

本文中完成了论文的算力网络技术架构和算力网络应用需求分析。

Cao Chang, postdoctoral, senior expert of Future Network Research Department, Director of Intelligent Cloud Network Technology Research Department, Network Technology Research Institute, China United Network Communications Co., Ltd. His main research directions are IP network broadband communication, SDN / NFV, and next-generation network orchestration. Technology, etc.

In this paper, he is responsible for the analysis of the overall technical architecture and computing power network application requirements.

E-mail:

唐雄燕,中国联合网络通信有限公司网络技术研究院,教授,首席科学家、智能网络中心总架构师,北京邮电大学兼职教授、博士生导师,主要研究方向为宽带通信、光纤传输、互联网/物联网、SDN/NFV与下一代网络等。

本文中负责设计算力网络整体架构和下一代网络边缘技术架构。

Tang Xiongyan, Professor, is the Chief Scientist of China United Network Communications Co., Ltd., Institute of Network Technology, Chief Architect of Intelligent Network Center, Adjunct Professor and Doctoral Supervisor of Beijing University of Posts and Telecommunications. His research interests include broadband communications, fiber optic transmission, internet networking, SDN, NFV and next-generation networks.

In this paper, he is responsible for designing the overall architecture of the computing power network and the next-generation network edge technical architecture.

E-mail:

何涛,中国联合网络通信有限公司网络技术研究院,硕士,高级工程师,主要从事云化网络及数据通信网络相关技术研究。

本文中负责云原生平台Kubernetes研究。

He Tao, master and senior engineer of Network Technology Research Institute of China United Network Communications Co., Ltd., is mainly engaged in researches on cloud-based networks and data communication network related technologies.

In this paper, he is responsible for dong researches on cloud native platform Kubernetes.

E-mail:

李建飞,中国联合网络通信有限公司网络技术研究院,硕士,高级工程师,主要从事下一代网络、AI算法以及自动驾驶等相关技术研究。

本文中负责边缘计算嵌入式架构、GPU架构研究和人工智能应用分析。

Li Jianfei, master and senior engineer of Network Technology Research Institute of China United Network Communications Co., Ltd., is mainly engaged in researches on next-generation networks, AI algorithms, and autonomous driving.

In this paper, she is responsible for researching edge computing embedded architecture, GPU architecture and artificial intelligence application analysis.

E-mail:

刘秋妍,中国联通网络技术研究院,博士后,高级工程师,主要研究方向为无线通信与区块链技术。

本文中负责研究容器标签资源调度机制。

Liu Qiuyan, Ph.D., is a senior engineer of China Unicom Network Technology Research Institute. Her main research directions are wireless communication and blockchain technologies.

In this paper, she is responsible for researching container tag resource scheduling mechanism.

E-mail:

摘要

【目的】介绍了算力网络面向业务需求,在云、网、边之间按需分配和灵活调度计算资源的网络组织方式。该方式旨在实现更广泛的计算资源的统一调度和纳管。而在网络边缘侧,由于各种嵌入式数量众多,架构各异,现有的资源调度方式难以满足算力纳管的需求。【方法】从算力网络架构出发,基于云原生的资源调度机制,阐述了轻量化、多集群的分级边缘资源调度方案。【结果】基于轻量级的云原生平台,实现了面向算力网络的前端海量边缘设备的统一纳管,并且能够在多种架构的嵌入式平台进行部署。【局限】作为面向算力网络整体技术架构,“云、边、端”中前端设备的统一资源调度平台,如何实现云边协同、人工智能算法等在前端嵌入式集群中的实现和部署,使其前端设备更具自主性是其下一步需要解决的重要问题。【结论】面向算力网络的前端嵌入式资源调度方案可以广泛应用于物联网、车联网、智慧城市等领域,进一步实现前端设备的自主处理能力,解决我国智能产业领域创新能力和支撑不足等现实问题。

关键词:

Abstract

[Objective] This paper introduces a network organization method for computing power network to satisfy business needs, which is able to flexibly schedule and allocate computing resources among clouds, networks, and edge devices. This approach aims to schedule and manage a wider range of computing resources in a unified framework. At the edge of the network, due to the large number of embedded devices and their different architectures, it is difficult for the existing resource scheduling methods to meet the demand of computing power. [Methods] Starting from the computing network architecture and based on the cloud-native resource scheduling mechanism, a lightweight, multi-cluster hierarchical edge resource scheduling scheme is described. [Results] Based on the lightweight cloud-native platform, we successfully manage and deploy a massive amount of hetero-architecture edge devices inside computing power networks in a unified framework. [Limitations] As a unified resource scheduling platform for front-end equipment in the “cloud, edge, and end” designed for computing power networks, it is important to solve the problems of implementing cloud-side collaboration, deploying artificial intelligence algorithms in front-end embedded clusters and making front-end equipment more autonomy. [Conclusions] The front-end embedded resource scheduling solution for computing power networks can be widely used in the Internet of Things, Internet of Vehicles, smart cities and other fields to improve the autonomous processing capabilities of the front-end equipment, and solve other practical problems such as the lack of innovation capabilities and insufficient supports in intelligent industry of China.

Keywords:

PDF (9882KB)元数据多维度评价相关文章导出EndNote|Ris|Bibtex收藏本文

本文引用格式

李铭轩, 曹畅, 唐雄燕, 何涛, 李建飞, 刘秋妍. 面向算力网络的边缘资源调度解决方案研究. 数据与计算发展前沿[J], 2020, 2(4): 80-91 doi:10.11871/jfdc.issn.2096-742X.2020.04.007

Li Mingxuan, Cao Chang, Tang Xiongyan, He Tao, Li Jianfei, Liu Qiuyan.

开放科学标识码(OSID)

引言

随着云计算技术的发展与企业上云的加速推进,基于云化架构构建企业基础设施平台已经成为业务普遍采用的方式。预计到2025年,85%的企业应用将会承载在云上[1]。同时电信运营商一直十分重视云计算市场和技术的发展,其内部IT系统已经基本完成云化改造,正在推动其核心业务云化改造,并且纷纷成立专业云服务公司,开拓企业市场[2]。随着国家大力提倡发展新基建,云计算作为基础设施建设的重点领域将会得到快速的发展。现有的云计算发展方向包括两个方面:一方面沿着传统的技术路线发展,采用资源集约化的方式着重建设大规模和超大规模数据中心,并且由数据中心统一提供IT资源;另一方面的云计算发展路线则是着重研究面向异构云计算资源进行协同和纳管,其中多云管理目前是这种云计算技术发展方向的代表。而随着5G技术的发展,边缘计算成为了信息技术领域和通信技术领域相互结合的热点。和传统的云计算发展路线不同,边缘计算主要研究如何更好地将外围或者边缘资源有效的进行管理,这就为边缘计算的研究提出了挑战。一方面,因为边缘资源更靠近用户侧,要求更低的用户访问时延;另一方面,边缘计算设备数量众多,而且存在计算架构差异性等问题,如何实现对海量的异构边缘计算资源的统一管理等也是一种挑战。另外,由于边缘计算节点分布比较广泛,计算节点之间的协同和资源的调度相比于传统的云计算对于网络的要求更高,因此边缘计算的研究除了传统的计算、存储等虚拟化技术的研究外,需要更加关注如何实现网络和边缘计算的协同,从传统的云网融合向算网融合的方向发展。

本文主要研究了基于算力网络如何实现对于边缘嵌入式计算资源,诸如ARM、GPU等多种嵌入式设备进行资源纳管,从而能够解决算力网络下的异构计算资源协同管理问题。

1 算力网络

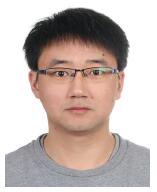

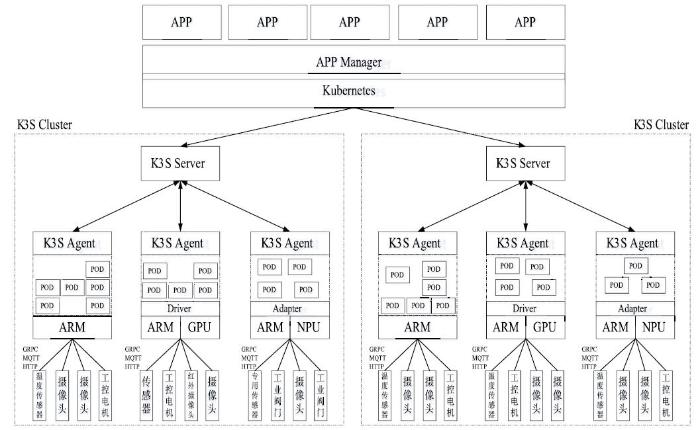

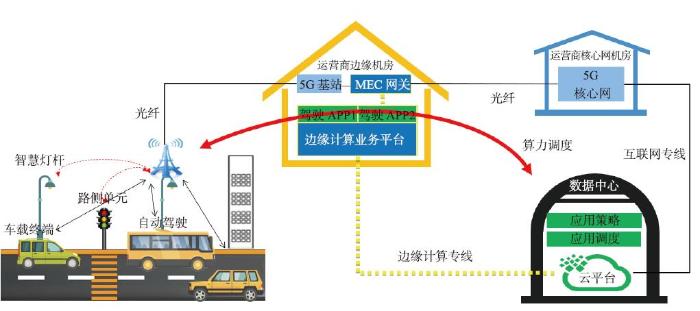

算力网络从传统云网融合的角度出发,结合边缘计算、网络云化以及智能控制的优势,通过网络连接实现更加广泛的算力资源的纳管和动态调度。但是,区别于传统的云计算资源的纳管采用集中式的资源管理或者集约化的资源提供,在算力网络的资源纳管中更多考虑了网络延时、网络损耗对于资源调度方面的影响。因此网络的核心价值是提高效率,算力网络的出现正是为了提高端、边、云三级计算的协同工作效率。算力网络整体技术架构如图1所示。图1

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图1算力网络技术架构

Fig.1Technology architecture on computing power network

依据上述算力网络架构,通过计算和网络的联动将云、边、端设备协同统一起来。其中中心云采用传统的云计算实现集中式的资源统一管理,在中心云中主要面向大规模或者超大规模的数据处理,以电信运营商为例,中心云主要承载面向全国的业务平台运营和数据处理[2]。在边缘云由于接入的边缘数据中心众多,而且分布比较广泛,基本上每一个边缘数据中心通常会采用相对独立的轻量化容器集群来实现,而在特殊行业或者指定场景下,行业用户拥有自己独立的数据中心或者业务上要求数据保密等场景下,也要求在用户环境下形成一个相对比较独立的云资源池[3],同时在边缘云的统一管理中,需要将此部分单独作为独立的边缘云进行管理,同时在算力的分配或者应用的部署方面需要指定部署到用户的边缘云内,因此边缘云多数采用Kubernetes多集群的方式来实现多个边缘计算集群的协同管理。在算力网络设备端侧,结合现有工业互联网以及智慧城市等场景,往往涉及海量的前端嵌入式边缘设备,而且采用的计算架构有ARM、DSP、FPGA、SOC等,负责用户的数据采集、用户侧的业务访问入口和交互等,因此通过算力网络将整个云、边、端的计算资源协同起来,采用分级、多集群的方式进行统一管理。目前在中心云主要采用OpenStack等传统的IaaS进行承载[4],而在边缘或者远端设备上的计算资源通过轻量级的云原生Kubernetes等i-PaaS和A-Paas进行计算资源的管理和应用能力的管理等。

2 轻量级云原生架构

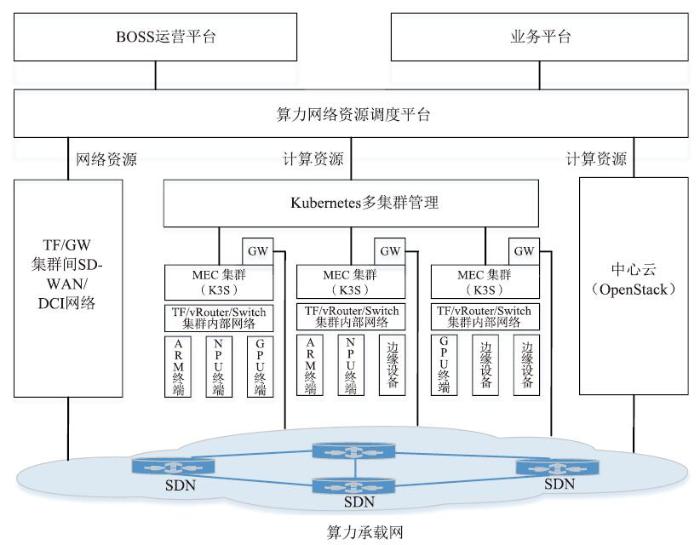

依据上述算力网络整体架构,在电信运营商的数据中心分级部署方案中,边缘数据中心或者边缘机房主要突出计算灵活、轻量化等特点,面向用户提供低延时的网络接入和应用访问,因此现有的边缘资源的算力调度方案主要采用基于云原生方式来实现的,面向用户提供业务平台的快速部署、业务访问,而其中资源调度和管理平台是以Kubernetes为主的容器云来实现资源调度编排和统一管理。依据参考文献[5]所描述,Kubernetes主要采用主从模式来实现计算节点的统一管理,其总体技术架构如图2所示[5]。图2

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图2Kubernetes技术架构

Fig.2Technology architecture on Kubernetes

结合Kubernetes技术架构主要采用主从模式,Master节点主要负责资源的调度和键值数据库的存储,同时实现POD的生命周期管理,同时Node节点主要作为计算节点,实现本地Pod的部署运行和本地相关计算、存储和网络资源的纳管。因此Kubernetes在开源之初,就定位为 i-PaaS功能,既具备上层PaaS平台的能力,同时又对底层IaaS资源具备资源纳管的能力。随着近年来Kuberentes技术的飞速发展,目前Kuberentes已经发展到了1.17版本,不仅仅可以纳管通用CPU等通用计算资源,同时也支持对于GPU、ARM等专用计算资源的管理。

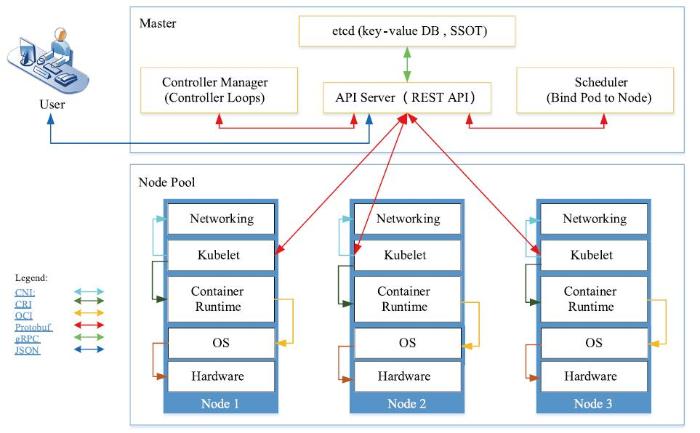

另一方面,由于通用型的嵌入式设备自身的计算、内存以及存储等方面的资源有限,从而导致Kubernetes在进行部署时受到限制。现有的解决方案往往通过修改嵌入式设备的系统配置,诸如扩展SWAP交换空间等方式以保证Kubernetes能够顺利的安装[6],参考文献[6]正是按照此种方式实现的。但是在实际设备运行过程中还是存在容器运行受限、集群本身数据库和相关组件运行占用较多资源等问题。针对这些问题在业界也越来越引起广泛的关注,目前在云原生开源社区最新开源项目K3S针对原有Kubernetes进行功能裁剪和优化,使其成为更加轻量化的容器云编排调度平台,能够更好的应用于面向边缘计算、物联网等场景下的多种嵌入式设备的部署和容器编排管理,因此项目一经发布在社区获得广泛关注,其技术架构如图3所示。

图3

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图3K3S技术架构

Fig.3Technology architecture on K3S

和Kubernetes技术架构相比,K3S的技术架构同样是采用C/S架构,并且在Server主要通过KubeAPI来实现和Kubernetes中的API Server相同的功能,通过KubeAPI提供集中的连接,并且通过Controller Mananger和Scheduler来实现节点管理和资源调度管理等,这样外部系统在访问K3S集群时,可以采用标准的Kubernetes的接口进行访问,而不需要再单独开发一套独立的访问接口。不同点在于原有的Kubernetes采用etcd键值型数据库来实现数据管理,而在K3S中为了满足轻量化的需求,改用SQLite实现数据库管理。同时在底层容器引擎方面采用Containerd来实现POD管理。

在系统集成方面,由于整个云原生平台之间都是通过API接口实现相互之间的访问和调用,而K3S平台主要是由KubeAPI提供外部访问接口,同时该接口是经过CNCF认证的标准Kubernetes接口,因此K3S接口和标准的Kubernetes的接口是一致的,可以实现无缝对接。基于K3S技术架构设计的考虑一方面可以保证K3S对外提供标准的Kubernetes平台接口;另一方面,经过架构的精简和优化,使得K3S本身的架构更加轻量化,整个的可执行性文件可以精简到几十兆,能够更加适用于在嵌入式系统等有限计算平台上进行部署。

3 边缘资源调度方案

根据参考文献[7]所描述的算力网络的四个特征要求,包括:资源抽象、业务保证、统一管控和弹性调度等方面,其中弹性调度能够实时检测业务流量,动态调整算力资源,完成各类任务高效处理和整合输出,并在满足业务需求的前提下实现资源的弹性伸缩,优化算力分配[7]。在算力网络资源调度方面,一方面采用轻量级的容器调度平台适配于开放式嵌入式边缘计算集群;另一方面,实现了统一的多集群的边缘计算集群的统一管控和动态扩缩容的资源弹性调度。结合现实情况,由于现有在边缘侧的设备资源中存在大量的嵌入式等工控设备等,因自身的计算资源和存储资源有限,传统的Kubernetes云原生架构无法承载,因此本文在面向算力网络的边缘资源调度方案设计过程中,考虑采用“Kubernetes+K3S”的分级云原生容器资源调度方案,前端嵌入式设备基于K3S实现资源管理,基于Kubernetes来实现云原生多集群的统一管理。3.1 边缘系统整体架构

在面向算力网络Kubernetes多集群计算资源管理方面,本文采用基于“Kubernetes+K3S”两级联动的架构来实现统一的边缘侧资源调度管理,即边缘计算节点侧采用传统Kubernetes云原生实现边缘计算节点侧的资源纳管,同时负责底层嵌入式终端集群的注册和管理等统一多集群调度管理,而前端嵌入式终端集群则采用更加轻量级的K3S云原生平台实现资源管理,其总体的技术架构如图4所示。图4

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图4边缘系统技术架构

Fig.4Technology architecture on edge system

依据上述系统技术架构,在面向整个边缘系统的资源调度方面主要是基于云原生容器化的方式来实现。以电信运营商为例,现有边缘侧的基础设施部署情况,边缘云主要分布在省分地市级边缘机房或者用户的数据中心内,主要采用通用型服务器作为计算节点,硬件性能相对较高,同时可以支持GPU、FPGA等多种加速硬件资源,因此集中部署云原生的Kubernetes容器集群,甚至有些边缘云部署轻量级的OpenStack云计算集群,比如目前著名的边缘计算解决方案StarlingX,而前端设备则主要连接海量的嵌入式设备,负责数据采集、工业控制以及用户交互访问等。目前市场上的嵌入式设备主要基于“MCU+协处理器”的SOC架构来实现,其中MCU目前普遍采用ARM架构的处理器实现设备的管理和连接,而协处理器则面向不同的数据处理类型采用不同的专用芯片,比如GPU主要面向二维数据的图像处理和视频处理,NPU主要面向张量数据的处理等。本文基于轻量级的K3S实现容器化的嵌入式设备资源调度,应用程序将根据策略以POD的形式调度到指定的嵌入式设备上运行,同时前端接入的传感器设备或者工控设备等通过MQTT、HTTP和GRPC等通信协议将采集到的数据上传到嵌入式设备上进行处理,或者将嵌入式设备发送的指令传递到前端设备上执行[8]。

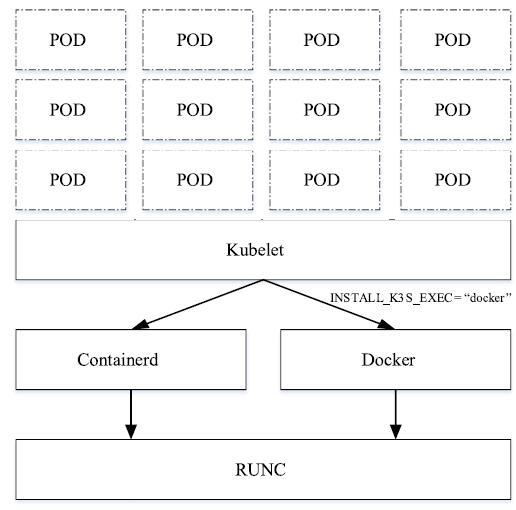

3.2 基于ARM的容器部署

本文主要采用K3S的ARM部署方式,根据参考文献[9]所描述的部署需求,目前的K3S版本支持硬件最低要求仅需要1个CPU、512M内存,同时面向X86_64、Arm64和Armv7等平台发布,因此基本上涵盖目前市场上绝大部分ARM平台架构[9],另外K3S包含了轻量级的容器引擎Containerd,并不需要额外安装Docker引擎,在底层容器引擎方面K3S可以默认采用Containerd的容器调度方式,但是也支持通过Docker方式来实现容器调度。在整个嵌入式设备的容器部署和调度方式上,如图5所示。图5

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图5边缘设备容器部署和调用方式

Fig.5Edge device container deployment, invocation method

依据容器化部署方式,结合具体的应用场景需要,在部署K3S的Agent节点时,可以选择K3S默认的Containerd作为底层的容器调度引擎,也可以选择Docker Engine作为其容器调度引擎,但是需要在部署K3S Agent之前就已经成功安装了Docker Engine,目前Docker Engine官方也提供面向诸如ARMv7架构的版本。根据官网安装部署文档所描述的具体操作,只需要在安装部署K3S Agent时通过参数INSTALL_K3S_EXEC=”docker”传递给K3S系统,以表明在后续的容器调度过程中使用Docker Engine作为容器调度引擎。但是需要说明的是,由于K3S架构采用C/S主从方式,在Agent节点的部署过程中可以选择容器引擎,而在Server节点上只能采用Containerd作为其唯一的容器调度引擎。因为在整个K3S的POD运行管理过程中,K3S Agent是作为唯一的POD运行和调度的载体,而Server只是负责整个K3S集群的运行管理,因此不需要额外地执行相关的容器运行等,通过这种方式可以大大提高K3S Server的轻量化,也可以实现Server和Agent可在同一个节点上进行部署。另外,在嵌入式集群中具有控制节点,相比于其他MEC方案诸如Kubeedge等,集群具有自主可控的资源调度能力,这样更适合未来基于神经网络的算力网络智能化发展。

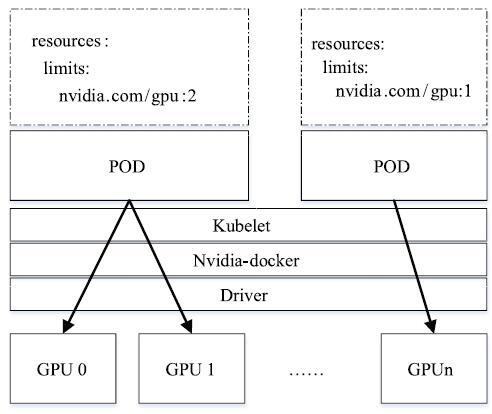

3.3 基于专用芯片的容器部署

面向专用芯片的边缘嵌入式设备一般在特定场景下对于数据处理有特殊要求,在芯片的架构设计上主要采用“MCU+专用芯片”的SOC方式进行构建,通常采用ARM作为MCU(主控单元),具体负责整个设备的系统管理、外部通信以及访问,而专用芯片则包括诸如GPU、NPU以及FPGA等,专门负责数据的处理和相关算法的硬加速处理等功能,而在MCU和专用芯片之间往往通过专用的数据通道进行数据传输,比如HDI、HCI、SPI等,各厂家设计的芯片不同,可能采用的数据传输协议也各有不同,而对外的数据输入和数据输出则主要由MCU负责。由于专用芯片在某些特定场景下对于数据的处理具有较高的处理能力,因此和通用性处理器相比,专用芯片在算法训练、推理和硬件编解码等方面具有非常明显的优势,因此在边缘计算场景下,开始逐渐采用专用芯片来执行算力。目前在容器化部署方案上,各厂商都结合自家的专用芯片推出了相应的解决方案,通常的技术架构则是基于MCU的嵌入式操作系统提供驱动层或者系统适配层,用于专用芯片的资源访问接口和资源调度能力,并通过插件方式实现Kubernetes对于专用芯片资源的调度和适配。本文以英伟达的嵌入式开发板Nvidia Jetson Nano为例具体阐述面向专用芯片的K3S部署方案和调度过程,英伟达在嵌入式系统推出了基于GPU的驱动层,并且在原生Docker引擎的基础上推出了自己的容器编排调度工具Nvidia-docker,并且该容器引擎和英伟达的GPU开放平台CUDA进行了完美的适配[10],因此在容器部署过程中主要基于英伟达的Nvidia-docker进行容器调度,并且通过驱动来为POD分配具体的GPU资源,其具体的架构如图6所示。图6

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图6GPU容器部署方式

Fig.6GPU container deployment on GPU

依据GPU容器部署方式,在算力资源调度过程中,可以通过在K3S集群的配置文件yaml中创建资源对象Resource,并且通过配置GPU的数据量来指令K3S集群为该POD分配GPU资源以执行相应的算力,而该参数配置会通过Nvidia-docker来调用底层的驱动在创建POD过程中为其提供指定的GPU数量。

而在上层的POD调度和配置方面,通过上述容器化部署以及POD资源分配方式,可以在标准的Kubernetes配置文件yaml中创建Resource对象[11],并且在该资源对象中设置计算单元数量,而该资源对象下的计算单元类型可以进行扩展和定义,因此为后续的其他专用芯片的资源调度和管理提供了可能。用户可以在配置文件中为POD指定不同的专用芯片来运行。

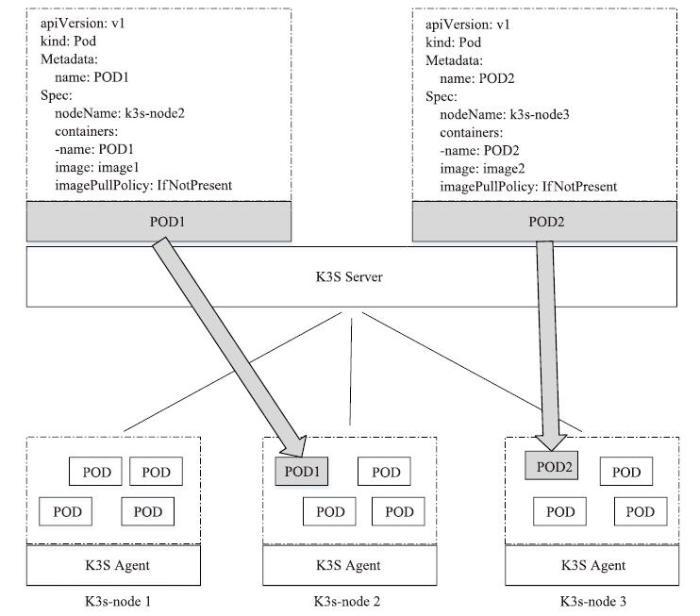

3.4 基于标签的算力调度机制

在面向算力网络的边缘资源调度机制方面,由于考虑需要将整个边缘侧和前端嵌入式设备侧的算力资源统一调度和纳管。在算力应用匹配和算力节点调度方面,基于Kubernetes提供的标签以及容器标签来实现整个边缘侧的算力调度机制,通过为前端嵌入式设备在注册到K3S集群时,为设备创建节点标签,同时在创建POD时可以通过节点标签将POD部署到指定的边缘节点上运行,其调度流程如图7所示。图7

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图7基于标签的算力资源调度

Fig.7Computing power resource scheduling based on label

基于标签的算力资源调度机制主要是基于Kubernetes的Scheduler和Controller manager来实现的。首先在创建K3S集群时,为算力节点统一进行命令规则,而算力节点的标签命名统一由设备管理模块进行管理,并且维护整个集群中设备节点的基本信息。在创建容器时根据应用场景和用户需求的不同,通过在设备管理模块中查询匹配的计算节点,并且在创建容器的配置文件中进行指定,从而使得资源调度平台为容器应用分配合适的计算节点。

4 应用场景

目前业界正在积极探索算力网络和工业互联网以及物联网等行业的实际落地场景,以智能驾驶业务场景下的算力网络资源调度为例,车载系统一方面在保证低时延的数据处理需求的情况下,需要将数据和控制尽可能的保证在本地进行处理,同时需要通过MEC等实现云端资源和策略调度等协同智能路灯等信号的处理和反馈;另一方面,由于车载系统本身的计算和存储能力有限,因此需要基于正如本文所述的K3S等轻量级的资源调度系统来实现车载系统的资源管理和应用运行。具体如图8所示。图8

新窗口打开|下载原图ZIP|生成PPT

新窗口打开|下载原图ZIP|生成PPT图8面向智能驾驶的算力网络资源调度

Fig.8Resource scheduling of computing power network for intelligent driving

基于上述智能驾驶应用场景下的算力网络资源调度,通过环境感知来实现周围智能设备的数据采集和智能训练以实现无人驾驶车辆自主识别障碍物,通过避障规划来实现判断障碍物后所采取的措施,并且跟踪障碍物并及时做出判断和措施。上述流程强调智能驾驶车辆自主的学习处理能力以及及时和中心业务平台的联动时延要求,运营商目前积极推动“5G+MEC”实现智能驾驶的解决方案以实现低时延和资源轻量化调度,从而拉动包括智能驾驶、智能灯杆、智能交通控制等智慧城市公共交通的整体协同和资源管理。

5 结论和展望

随着算力网络技术的发展,将广泛的边缘计算节点纳入到统一的资源管理,尤其是在算力网络中引入嵌入式设备管理和自主资源调度机制,改变了传统的嵌入式设备只能被动接受服务器指令和上传数据采集等工作模式,使得嵌入式设备集群更具自适应能力,为后续AI算力以及神经网路架构下的深度学习分层在嵌入式设备集群上的部署和运行,以及嵌入式设备的自主学习能力和智能交互提供了可能。随着未来具备AI能力的专用芯片的发展和普及,算力网络除了在数据中心和边缘数据中心实现资源的纳管外,对于嵌入式设备的自主学习能力和自适应能力会提出更高的要求。通过本文所提出的面向算力网络的边缘资源调度解决方案的研究,可以更好的实现算力网络应用于边缘计算、物联网、车联网等应用场景下的统一资源调度以及智能化的运行模式。利益冲突声明

所有作者声明不存在利益冲突关系。参考文献 原文顺序

文献年度倒序

文中引用次数倒序

被引期刊影响因子

[J].

[本文引用: 1]

[J].

[本文引用: 2]

[J].

[本文引用: 1]

[J].

[本文引用: 1]

[J].

[本文引用: 2]

[J].

[本文引用: 2]

[J].

[本文引用: 2]

[J].

[本文引用: 1]

[J].

[本文引用: 2]

[D].

[本文引用: 1]

[J].

[本文引用: 1]