| 任务类型 | 搜索目标 | 搜索词 |

| 导航类 | 中国银行的主页 | 中国银行 |

| 信息类 | 人工智能的定义 | 人工智能 定义 |

表选项

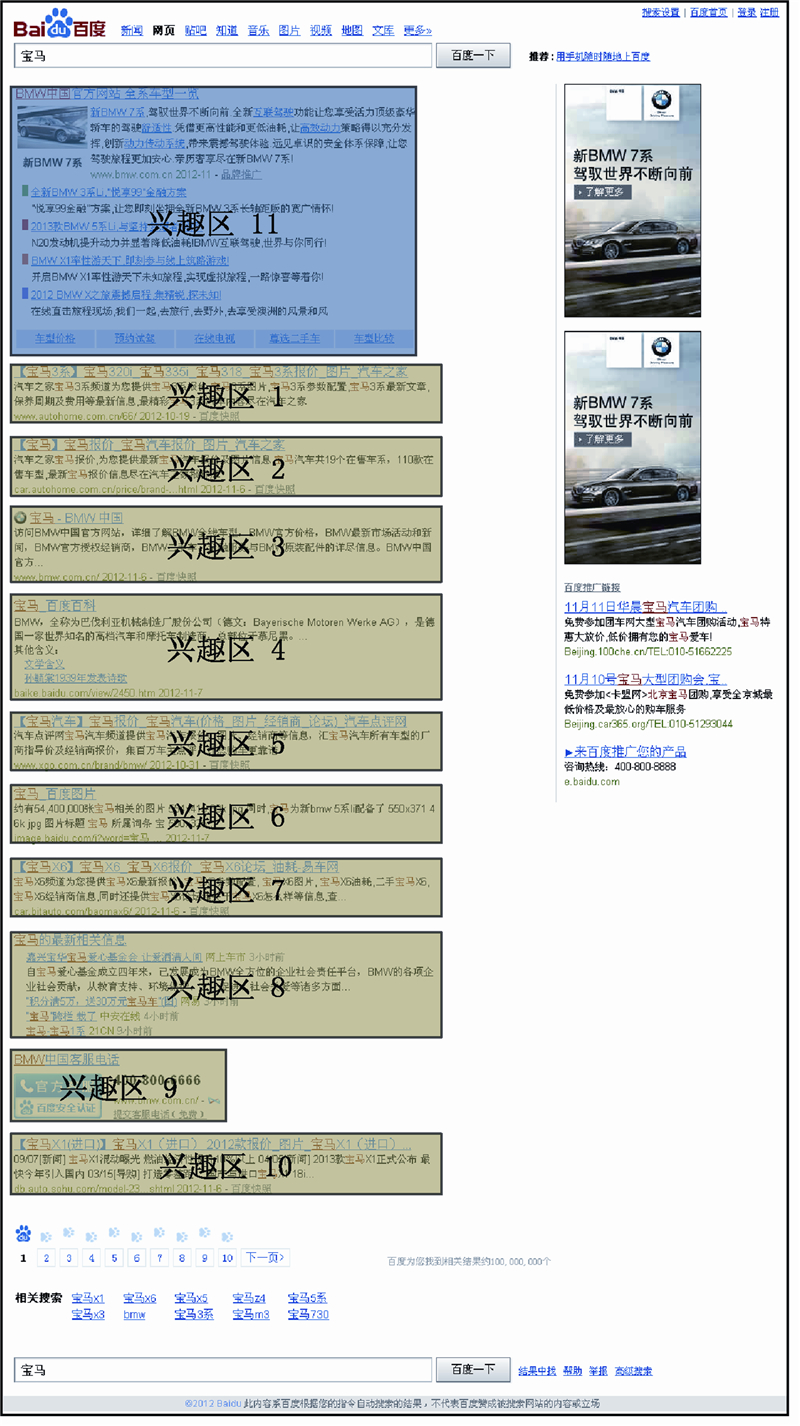

2.2 实验被试有偿招募被试81人,其中,4人由于眼动仪校准问题或系统故障没有完成实验,17人的眼动数据采样率相对较低(低于50%).为保证数据质量,只选取60人的眼动数据,其中30人为女性.这60名被试均为来自同一所大学不同专业的本科生和研究生,视力正常或矫正视力正常,没有如色盲等眼睛问题.被试年龄在18~31岁之间(均值为23.9岁,标准差2.5岁). 2.3 实验设备实验使用瑞典Tobii公司的T120型眼动仪.该眼动仪配有17英寸(1英寸=2.54cm)显示器,采样率为120Hz,精确度(视角)为0.5°.实验中将显示器分辨率设为1024×768像素,放置在距离被试约60cm的位置.被试的眼动数据由眼动仪自带软件Tobii Studio记录.实验在配有IE 6浏览器和Windows XP操作系统的计算机上完成. 2.4 实验过程实验开始前,对每名被试用9点校正法校正眼动仪,并以文字形式向其介绍实验内容;然后,被试进行一组练习以熟悉实验流程.每名被试完成全部20个搜索任务,任务之间有短暂的由被试控制的休息时间.对每一个搜索任务,屏幕上会以文字的形式向被试说明搜索目标.被试记下该目标之后点击“开始”按钮进入含有预定义搜索词的搜索引擎页面.被试不允许改变搜索词,直接点击“搜索”按钮进入SERP(这种从搜索引擎页面到SERP的方式更符合被试在日常生活中的实际情况,因此其眼动数据更为真实).每个SERP中均含有10个搜索结果,一些SERP中还含有顶部广告.被试需要浏览SERP并点击最符合搜索目标的某个搜索结果或者顶部广告,以完成搜索任务.全部搜索任务完成之后,被试需要填写有关其背景信息的调查问卷.每名被试实验耗时约30min.3 预测方法 通过眼动实验,采集到用户在网络搜索任务时的眼动数据.这些数据能够以“注视点”的形式导出,每个注视点包含许多数据项.本文只使用其中的5个数据项:时间戳(注视点发生的时间)、注视时间(注视点持续的时间)、横坐标、纵坐标和刺激名称(注视点所属网页的名称).这些原始的眼动数据将转化成两种描述被试注视模式的数据格式:直方图和序列.这些转化后的数据配合学习算法,用来对用户行为进行预测. 3.1 数据转化首先,依照刺激名称剔除属于SERP之外的注视点.其次,由于SERP中的注视点主要落在10个搜索结果和顶部广告上,因此将这些区域定义为兴趣区,如图 1所示:10个搜索结果定义为兴趣区1~10(绿色区域),顶部广告定义为兴趣区11(蓝色区域).再次,利用横、纵坐标将各注视点映射到11个兴趣区中,剔除不属于任何兴趣区的注视点.最后,按照刺激名称和时间戳将属于同一被试、同一SERP的注视点整合,转化为直方图数据和序列数据,每个搜索任务的眼动数据对应一个直方图数据和一个序列数据.

|

| 图 1 兴趣区示例Fig. 1 An example of areas of interest |

| 图选项 |

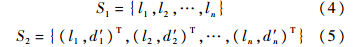

直方图数据反映被试在SERP上的注意力分布情况,类似于认知心理学中分析眼动数据时使用的注视热点图.本文设计了3种形式的直方图数据:总注视次数形式(简称“总次数”),包含11个兴趣区各自注视点的总个数;总注视时间形式(简称“总时间”),包含11个兴趣区各自注视点持续时间的总和;总注视次数加总注视时间形式(简称“总次数+总时间”),包含11个兴趣区各自的总注视次数和总注视时间,即

式中:H1、H2和H3分别为“总次数”、“总时间”和“总次数+总时间”形式的直方图数据;cx为兴趣区x的总注视次数;dx为兴趣区x的总注视时间,s.序列数据反映被试在SERP上的扫视路径,由一系列按时间先后顺序排列的数据点构成,每个数据点表示一个注视点,类似于眼动数据分析中的眼动轨迹图.序列数据有两种不同形式:注视位置形式(简称“位置”),包含每个注视点所处的位置,用数字1~11表示11个兴趣区;注视位置加注视时间形式(简称“位置+时间”),包含每个注视点所处的位置和注视点持续的时间,即

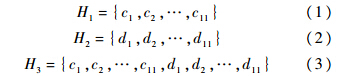

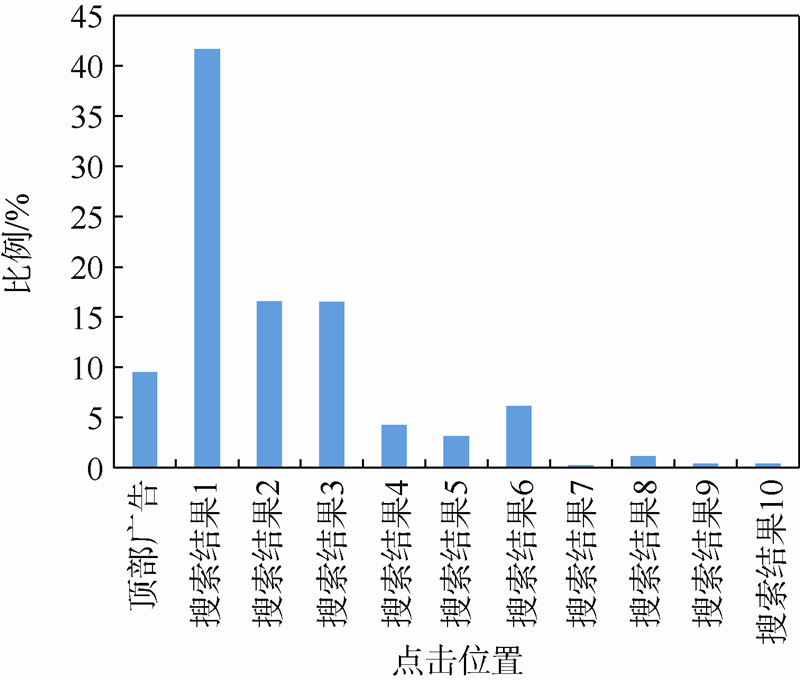

式中,S1和S2分别为“位置”和“位置+时间”形式的序列数据;lx为第x个注视点的注视位置;d′x为第x个注视点的注视时间,s. 3.2 学习算法直方图数据和序列数据能够描述被试在完成网络搜索任务时的视觉行为,如果给每一个数据以相应的标记,那么就可以应用学习算法进行建模,从而对用户行为进行预测.针对不同的预测目的,需要对数据进行不同的标记.本文分别对两类用户行为进行预测:用户决策或用户意图,详细的数据标记方法见第4节.两种数据格式具有不同的数据长度,直方图为定长数据,序列为不定长数据,因此需要不同的学习算法.如果对每种数据格式只使用一种学习算法,那么当比较二者的性能时,不能分辨出性能优势是源于数据,还是源于学习算法的.为此,本文采用了4种学习算法:支持向量机[19]、随机森林[20]、隐马尔科夫模型[21]和隐条件随机场[22].支持向量机和随机森林需要输入定长数据,因此用于3种形式的直方图数据.其中,支持向量机使用3种不同的核函数:线性、多项式和径向基;随机森林将最小双亲数设为10;隐马尔科夫模型和隐条件随机场能够处理长度不一的输入数据,因此用于序列数据.其中,隐马尔科夫模型将“位置”形式的序列数据作为观测,对每个标记(label)用离散隐马尔科夫模型单独训练;隐条件随机场用于“位置”和“位置+时间”形式的序列数据,并采用零初始化策略和拟牛顿法的优化策略. 4 实验结果本文利用直方图数据和序列数据对用户决策或用户意图进行预测.预测用户决策,是指预测用户对搜索结果和顶部广告的选择,即通过眼动数据预测点击行为.预测用户意图,是指预测用户进行搜索任务的目的,即通过眼动数据预测搜索任务的类型(导航类任务或信息类任务).两类用户行为预测均使用相同的眼动数据,其区别在于数据标记方式的不同:预测用户决策按照用户的点击位置对数据进行标记,预测用户意图按照搜索任务的类型对数据进行标记. 4.1 预测用户决策在眼动实验中,眼动仪能够记录被试的点击数据,这些数据用来对被试的眼动数据(直方图和序列)进行标记:搜索结果1~10被标记为1~10,顶部广告被标记为11.由此,将预测用户决策转换成一个多分类问题(11分类).图 2给出了11类数据的分布情况.如果总是将所占比例最多的一类作为预测结果,即总认为被试会选择第一个搜索结果,那么预测正确率约为42%.

|

| 图 2 用户决策分布Fig. 2 Distribution of user decisions |

| 图选项 |

表 2和表 3为3层交叉验证(3-fold validation)的结果,即用40名被试的数据训练、20名被试的数据测试.其中,隐马尔科夫模型和隐条件随机场的隐状态数目为3个;正确率(accuracy)的计算方法为正确预测的样本个数除以总测试样本个数.需要指出,同一被试的全部数据只出现在训练集或测试集中,即对用户行为预测是用一些用户的行为进行学习,以便预测其他用户的行为.这种方式特别适合于网络搜索行为预测,因为网络用户数量庞大,无法获取全部用户的行为数据.从表中可以看到,线性核函数支持向量机的性能在使用直方图数据的算法中是最好的;隐条件随机场的性能优于隐马尔科夫模型的性能.表 2 直方图数据的用户决策预测正确率Table 2 Accuracy of user decision prediction using histogram data

| 算法 | 正确率/% | ||

| 总次数 | 总时间 | 总次数+总时间 | |

| 支持向量机(线性) | 74.38 | 79.36 | 76.49 |

| 支持向量机(多项式) | 71.51 | 66.44 | 73.29 |

| 支持向量机(径向基) | 65.28 | 76.48 | 69.58 |

| 随机森林 | 72.03 | 74.55 | 75.23 |

表选项

表 3 序列数据的用户决策预测正确率Table 3 Accuracy of user decision prediction using sequence data

| 算法 | 正确率/% | |

| 位置 | 位置+时间 | |

| 隐马尔科夫模型 | 52.17 | 无 |

| 隐条件随机场 | 74.64 | 74.29 |

表选项

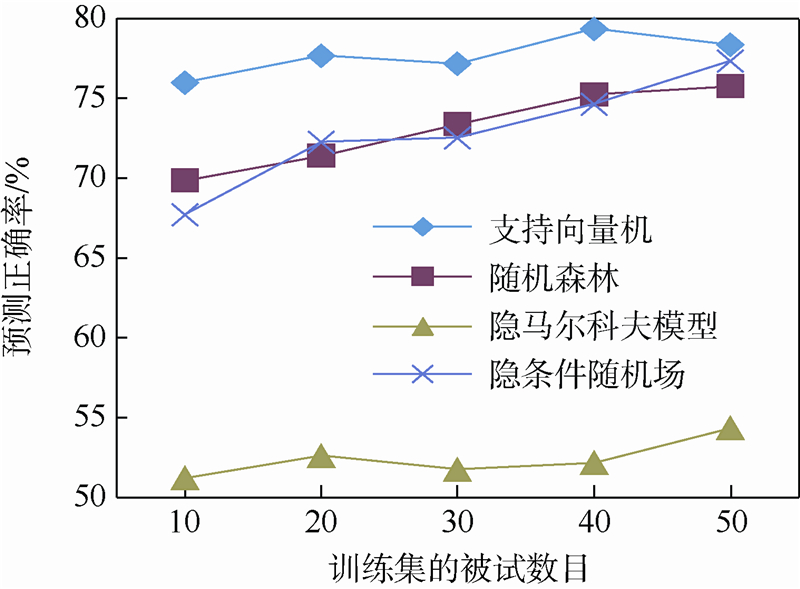

图 3为不同训练集大小下,各算法的预测正确率.当使用10名被试的数据进行训练时,其余50名被试的数据则用来测试,反之亦然.每种算法均采用表 2和表 3中正确率最高的组合(加粗字体,隐状态数目为3个).随着训练数据的增加,预测正确率呈上升趋势.此外,支持向量机的性能优于随机森林的性能,隐条件随机场的性能优于隐马尔科夫模型的性能.

|

| 图 3 不同训练集大小下的用户决策预测正确率Fig. 3 Accuracy of user decision prediction under different training data sizes |

| 图选项 |

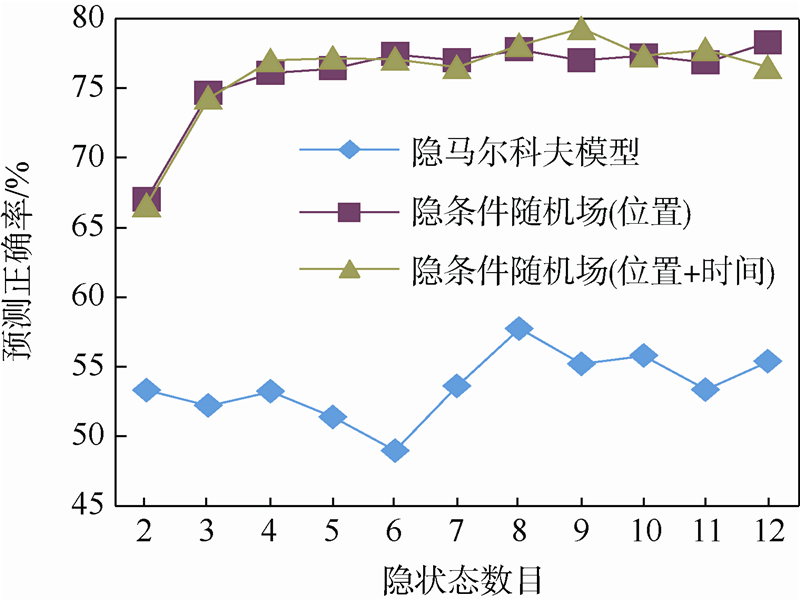

图 4为不同隐状态数目下,隐马尔科夫模型和隐条件随机场的预测正确率(基于3层交叉验证).对于隐马尔科夫模型,预测正确率随隐状态数目的增加起伏变化较大.对于隐条件随机场,随着隐状态数目的增加,预测正确率呈上升的趋势,并趋于稳定.

|

| 图 4 不同隐状态数目下的用户决策预测正确率Fig. 4 Accuracy of user decision prediction under different number of hidden states |

| 图选项 |

为评价预测结果的性能,本文设计3种人工预测策略作为基线:最多注视、最长注视和最后注视策略.最多注视策略将注视次数最多的搜索结果或顶部广告作为预测结果;最长注视策略将注视时间最长的搜索结果或顶部广告作为预测结果;最后注视策略将最后一个注视点所属的搜索结果或顶部广告作为预测结果.最多注视和最长注视策略假定被试会选择花费最多注意力的搜索结果或顶部广告,相对来说比较直观.最后注视策略认为被试会点击最终注视的搜索结果或顶部广告,来源于人的行为规律:人们总是会利用眼睛来监督行为,因此当被试使用鼠标点击某个搜索结果的同时会注视该结果,从而使得注视点落于该结果上.这种策略是一种非常“严格”的基线,其预测正确率相对前两种基线要更高.表 4给出了各学习算法与3种人工策略的预测正确率(基于3层交叉验证).可以看到,3种基线的预测正确率远高于“总是将所占比例最多的一类作为预测结果”的正确率(42%).无论是采用直方图数据还是序列数据,学习算法的最佳预测正确率(加粗字体)均高于人工策略,尤其是极其严格的最后注视策略,体现了本文方法在预测用户决策方面的优越性.同时,该结果还说明两种数据均适用于预测用户决策.表 4 各算法和策略的用户决策预测正确率Table 4 Accuracy of user decision prediction using different methods and strategies

| 方法 | 正确率/% | |

| 学习算法 | 支持向量机 | 79.36 |

| 随机森林 | 75.23 | |

| 隐马尔科夫模型 | 57.72 | |

| 隐条件随机场 | 79.29 | |

| 人工策略 | 最多注视 | 64.24 |

| 最长注视 | 67.71 | |

| 最后注视 | 75.99 |

表选项

4.2 预测用户意图 在眼动实验中有两种搜索任务:导航类和信息类.按照任务类型对两种格式的眼动数据进行标记,将预测用户意图转换为二分类问题.其中,导航类搜索任务的比例为49.96%,信息类搜索任务的比例为50.04%.如果将所占比例最多的一类作为预测结果,则正确率约为50%.表 5和表 6给出了3层交叉验证的结果(隐状态数目为3个).其中,随机森林的预测正确率要高于支持向量机,并且采用“总次数+总时间”形式的直方图数据结果更好;隐条件随机场的预测正确率要高于隐马尔科夫模型,并且采用“位置+时间”形式的序列数据结果更好.表 5 直方图数据的用户意图预测正确率Table 5 Accuracy of user intent prediction using histogram data

| 方法 | 正确率/% | ||

| 总次数 | 总时间 | 总次数+总时间 | |

| 支持向量机(线性) | 60.52 | 61.03 | 62.04 |

| 支持向量机(多项式) | 60.26 | 60.16 | 62.95 |

| 支持向量机(径向基) | 65.66 | 65.92 | 67.44 |

| 随机森林 | 67.78 | 69.89 | 70.32 |

表选项

表 6 序列数据的用户意图预测正确率Table 6 Accuracy of user intent prediction using sequence data

| 方法 | 正确率/% | |

| 位置 | 位置+时间 | |

| 隐马尔科夫模型 | 60.65 | 无 |

| 隐条件随机场 | 71.77 | 72.12 |

表选项

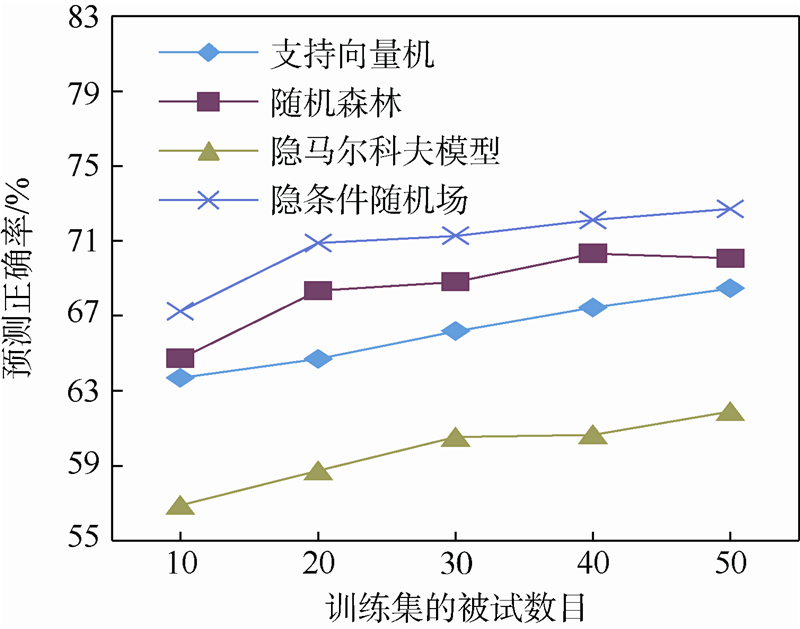

图 5为不同训练集大小下,各算法的预测正确率(采用表 5和表 6中正确率最高的组合,隐状态数目为3个).随着训练数据的增加,预测正确率呈上升趋势.此外,随机森林的性能要优于支持向量机的性能,隐条件随机场的性能要优于隐马尔科夫模型的性能.

|

| 图 5 不同训练集大小下的用户意图预测正确率Fig. 5 Accuracy of user intent prediction under different training data sizes |

| 图选项 |

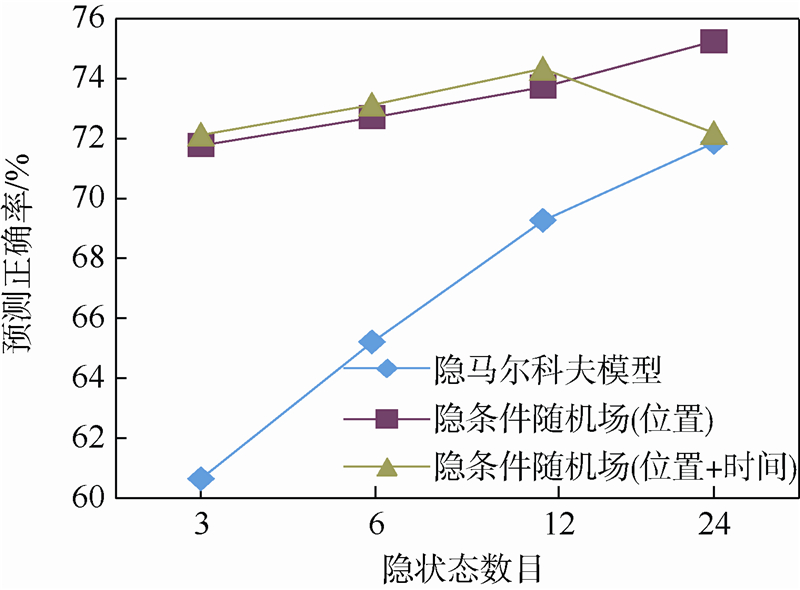

图 6为不同隐状态数目下,隐马尔科夫模型和隐条件随机场的预测正确率(基于3层交叉验证).随着隐状态数目的增加,两种算法的预测正确率基本成上升趋势.

|

| 图 6 不同隐状态数目下的用户意图预测正确率Fig. 6 Accuracy of user intent prediction under different number of hidden states |

| 图选项 |

为评价预测结果的性能,将本文方法与Guo和Agichtein[8]的实验进行比较,结果见表 7.Guo和Agichtein的实验使用点击数据和鼠标移动数据分别对用户意图进行预测.其中,基于点击数据的预测方法使用决策树配合如点击率和平均考虑时间等较为简单的点击特征;基于鼠标移动数据的预测方法使用如鼠标的总移动长度、横向移动长度和纵向移动长度等特征.该实验的数据集由249个搜索任务组成,其中41%为导航类任务、59%为信息类任务.从表 7中可以看出,基于点击数据的预测正确率约为68%,比59%的基线(总是预测为所占比例最大的那一类)高9%;基于鼠标移动数据的预测正确率约为70%,比基线高11%.本文实验数据集由1183个搜索任务组成,其中导航类和信息类各占50%.从表 7中可以看到,基于眼动数据的用户意图预测正确率(加粗字体)约为75%,高于基于点击数据和鼠标移动数据的正确率,并且比50%的基线高25%,从而体现出了本文方法在预测用户意图方面的优越性.此外,序列数据的预测正确率高于直方图数据的预测正确率,说明序列数据更适合于预测用户意图.表 7 各方法的用户意图预测正确率Table 7 Accuracy of user intent prediction using different methods

| 方法 | 正确率/% | |

| 基于眼动数据 | 支持向量机 | 67.44 |

| 随机森林 | 70.32 | |

| 隐马尔科夫模型 | 71.86 | |

| 隐条件随机场 | 75.23 | |

| 基于点击数据[8] | 67.87 | |

| 基于鼠标移动数据[8] | 70.28 |

表选项

5 结 论本文给出基于眼动数据的网络搜索行为预测方法,经实验验证表明:①该方法能够有效地预测用户的网络搜索行为,包括用户决策和用户意图;②两种数据(直方图和序列)均适用于预测用户决策,其性能高于人工策略的性能;③序列数据更适合于预测用户意图,其性能高于基于点击数据和鼠标移动数据的预测方法.为使本文提出的方法取得更好的性能,如何选取合适的特征来表示用户的视觉行为,以及设计专门的建模学习算法将是下一步的工作内容.

致谢 感谢北京工业大学WIC研究院提供眼动仪及眼动实验中所有被试的参与.感谢腾鹏博士为本研究提供的建议,以及钦夏孟的帮助.

参考文献

| [1] | Lee U,Liu Z,Cho J.Automatic identification of user goals in web search[C]//Proceedings of the 14th International Conference on World Wide Web.New York:ACM,2005:391-400. |

| [2] | Li X,Wang Y Y,Acero A.Learning query intent from regularized click graphs[C]//Proceedings of the 31st Annual International ACM SIGIR Conference on Research and Development in Information Retrieval.New York:ACM,2008:339-346. |

| [3] | Shen Y,Yan J,Ji L,et al.Sparse hidden-dynamics conditional random fields for user intent understanding[C]//Proceedings of the 20th International Conference on World Wide Web.New York:ACM,2011:7-16. |

| Click to display the text | |

| [4] | Agichtein E,Brill E,Dumais S,et al.Learning user interaction models for predicting web search result preferences[C]//Proceedings of the 29th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval.New York:ACM,2006:3-10. |

| Click to display the text | |

| [5] | Hassan A,Jones R,Klinkner K L.Beyond dcg:user behavior as a predictor of a successful search[C]//Proceedings of the 3rd ACM International Conference on Web Search and Data Mining.New York:ACM,2010:211-230. |

| Click to display the text | |

| [6] | Moshfeghi Y,Jose J M.On cognition,emotion,and interaction aspects of search tasks with different search intentions[C]//Proceedings of the 22nd International Conference on World Wide Web.New York:ACM,2013:931-942. |

| Click to display the text | |

| [7] | Wang K,Gloy N,Li X. Inferring search behaviors using partially observable markov(pom) model[C]//Proceedings of the 3rd ACM International Conference on Web Search and Data Mining.New York:ACM,2010:211-220. |

| Click to display the text | |

| [8] | Guo Q,Agichtein E.Exploring mouse movements for inferring query intent[C]//Proceedings of the 31st Annual International ACM SIGIR Conference on Research and Development in Information Retrieval.New York:ACM,2008:707-708. |

| Click to display the text | |

| [9] | Guo Q,Agichtein E.Ready to buy or just browsing?:detecting web searcher goals from interaction data[C]//Proceedings of the 33rd International ACM SIGIR Conference on Research and Development in Information Retrieval.New York:ACM,2010:130-137. |

| Click to display the text | |

| [10] | Arguello J.Predicting search task difficulty[C]//Proceedings of the 36th European Conference on IR Research.Switzerland:Springer International Publishing,2014:88-99. |

| [11] | Rodden K,Fu X,Aula A,et al.Eye-mouse coordination patterns on web search results pages[C]//Proceedings of the CHI'08 Extented Abstracts on Human Factors in Computing Systems.New York:ACM,2008:2997-3002. |

| Click to display the text | |

| [12] | Guo Q,Agichtein E.Towards predicting web searcher gaze position from mouse movements[C]//Proceedings of the CHI'10 Extended Abstracts on Human Factors in Computing Systems.New York:ACM,2010:3601-3606. |

| Click to display the text | |

| [13] | Faro A,Giordano D,Pino C,et al.Visual attention for implicit relevance feedback in a content based image retrieval[C]//Proceedings of the 2010 Symposium on Eye-Tracking Research and Applications.New York:ACM,2010:73-76. |

| Click to display the text | |

| [14] | 施笑畏,黄瑶佳,胡鸿韬,等.眼动行为数据挖掘在提取网上购物决策因子中的应用[J].上海海事大学学报,2014,35(1): 60-64. Shi X W,Huang Y J,Hu H T,et al.Application of eye movement behavior data mining in identifying decision factors on online shopping[J].Journal of Shanghai Maritime University,2014,35(1):60-64(in Chinese). |

| Cited By in Cnki | |

| [15] | Giordano D,Kavasidis I,Pino C,et al.Content based recommender systems by using eye gaze data[C]//Proceedings of the Symposium on Eye Tracking Research and Applications.New York:ACM,2012:369-372. |

| Click to display the text | |

| [16] | 秦林蝉,钟宁,吕胜富,等.一种融合视觉决策理论预测用户选择的方法[J].计算机应用研究,2013,30(8):2549-2551. Qin L C,Zhong N,Lv S F,et al.Visual decision making theory conbined method to predict user choice[J].Application Research of Computers,2013,30(8):2549-2551(in Chinese). |

| Cited By in Cnki | |

| [17] | Bulling A,Weichel C,Gellersen H.Eyecontext:recognition of high-level contextual cues from human visual behavior[C]//Proceedings of the SIGCHI Conference on Human Factors in Computing Systems.New York:ACM,2013:305-308. |

| Click to display the text | |

| [18] | Border A.A taxonomy of web search[C]//SIGIR Forum.New York:ACM,2002,36(2):3-10. |

| [19] | Chang C C,Lin C J.Libsvm:a library for support vector machines[J].ACM Transactions on Intelligent System and Technology,2011,2(3):27. |

| Click to display the text | |

| [20] | Breiman L.Random forests[J].Machine Learning,2001,45(1): 5-32. |

| Click to display the text | |

| [21] | Murphy K.Hidden Markov model(HMM)toolbox for Matlab[CP/OL].[2014-04-20].http://www.cs.ubc.ca/-murphyk/Software/HMM/hmm.html. |

| Click to display the text | |

| [22] | Morency L P,Christoudias C M,Quattoni A,et al.HCRF 2.0b[CP/OL].[2014-04-20].http://sourceforge.net/projects/hcrf. |

| Click to display the text |