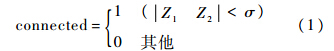

本文在二维空间区域连通的基础上采用深度相机增加判定条件式(1),变量connected的值代表相邻点是否连通,若相邻两像素的深度距离小于σ,connected=1则认为相邻两像素在三维空间中连通,为0则不连通.由于遮挡目标之间深度距离限制,可有效地避免遮挡目标被视为一体的分割(图 1(b)),有助于后续运动跟踪的鲁棒性.

|

| 图 1 区域连通算法改进前后的人物分割Fig. 1 Character segmentation of original and improved regional connected algorithm |

| 图选项 |

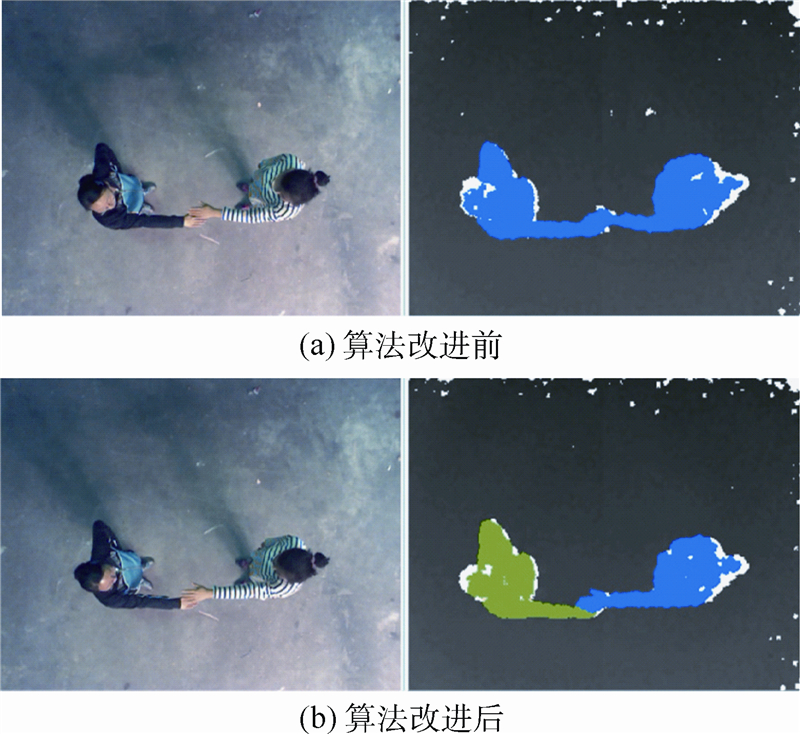

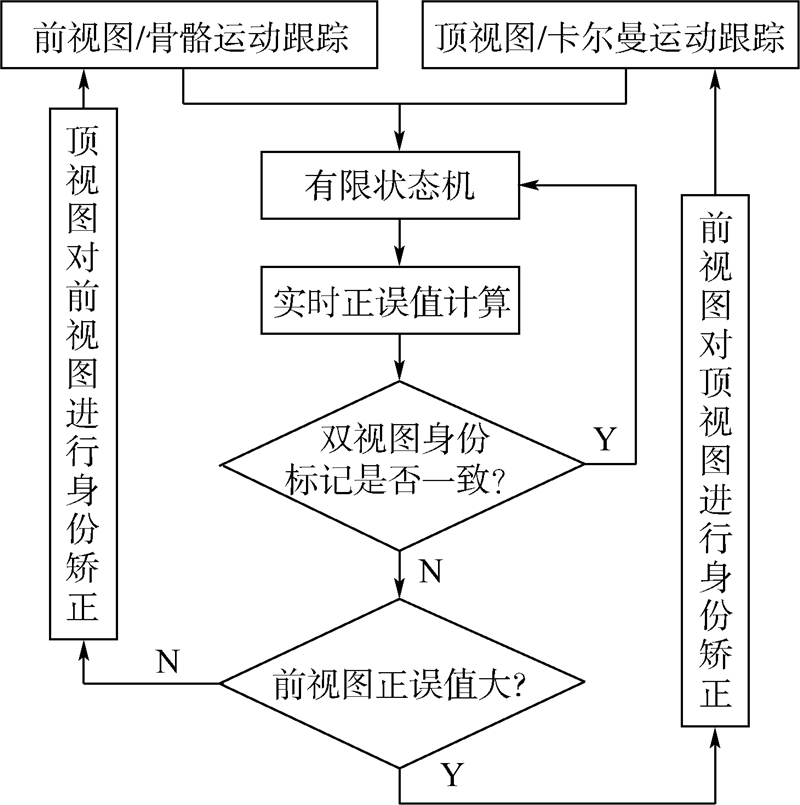

需要指出的是,虽然改进连通区域计算后结合卡尔曼滤波能够有效地对多目标进行运动跟踪,但是在解决多目标的部分接触问题时仍然会出现跟踪错误. 2 方法概述 2.1 双视图布局单视图多用户识别方法在一定程度上实现了对多用户的身份识别,但是无法有效地解决多用户之间因遮挡、接触和跟踪错误,造成的多用户身份识别错误.本文认为,采用双视图合理布局,建立耦合,通过实时正误标记,实现双视图之间相互矫正,可以有效避免多用户之间因遮挡、交叉等因素造成的用户身份识别错误.具体双视图布局组合如图 2所示.

|

| 图 2 双视图的布局组合Fig. 2 Distribution and combination of double views |

| 图选项 |

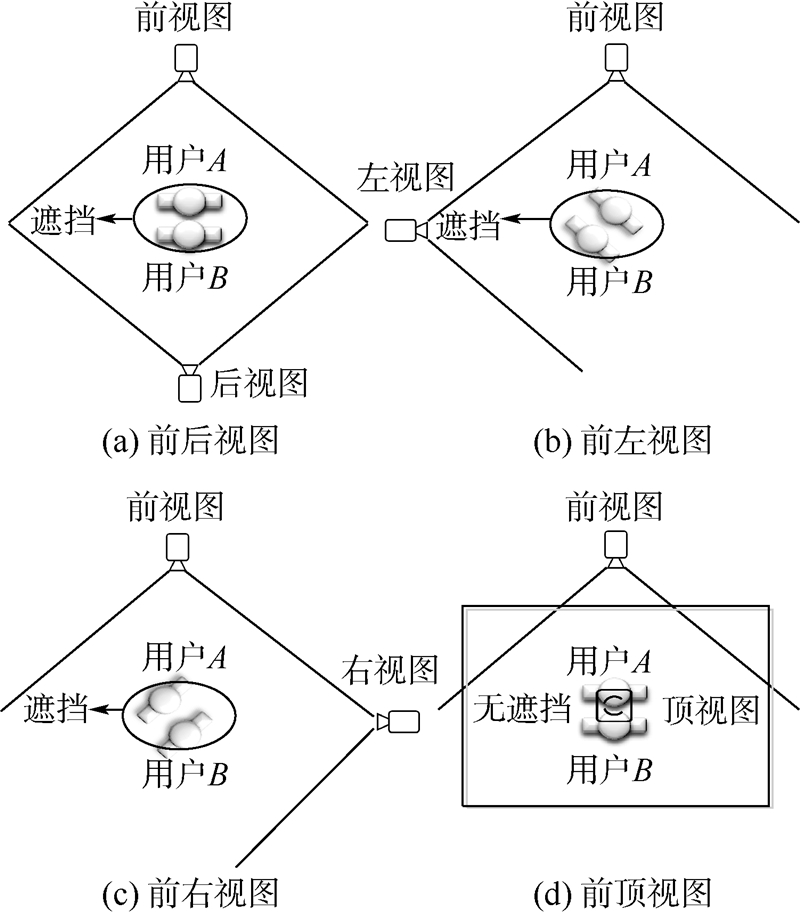

图 2(a)~图 2(c)所示的布局方式都会不可避免地出现多用户的遮挡问题,如黑色椭圆圈所示,容易引发因遮挡造成的多用户身份识别错误.因此,本文采用图 2(d)所示的前视图和顶视图的布局方式,因为相对于前3种双视图布局方式,这种双视图布局能更好地避免多用户之间的相互遮挡.2.2 方法流程 如图 3所示,所提出的方法主要分为3个部分:①骨骼运动跟踪视图.②卡尔曼滤波运动跟踪视图.③双视图耦合身份识别与矫正.

|

| 图 3 方法流程图Fig. 3 Approach procedure chart |

| 图选项 |

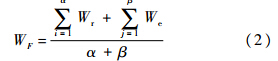

运动跟踪部分:前视图和顶视图分别采用了骨骼运动跟踪和卡尔曼滤波运动跟踪的方法,根据用户骨骼跟踪和分割用户跟踪点建立各自的身份标记映射,进行基于身份识别的多用户运动跟踪.双视图耦合部分:依据双视图的运动跟踪建立耦合有限状态机,依据多用户的运动情况进行状态切换.对多用户的有限运动状态进行分析,结合各自前后关键帧的运动跟踪状况,分别计算双视图运动跟踪的实时正误标记值.匹配当前双视图用户身份标记是否一致,并根据各自正误标记值的大小建立耦合指导矫正关系.如双视图的实时正误标记值符合有限状态机跟踪的正确条件,双视图中身份标记一致时,返回继续监测下一帧的运动跟踪.如果身份标记不一致,比较双视图的实时正误标记值的有效性和大小,实时正误标记值大的对实时正误标记值小的视图进行身份识别矫正.3 基于双视图耦合多用户身份识别 本文提出的基于双视图耦合的多用户身份识别方法,首先在双视图的各个视图中分别进行用户身份识别,并进行正误判定,为耦合的有限状态机提供指导.然后,通过分析耦合前的有限状态机,建立双视图耦合的有限状态机模型.最后,借助耦合有限状态机模型,建立双视图耦合实时身份矫正的规则算法,实现对错误状态的多用户身份的实时矫正. 3.1 双视图中多用户身份识别正误判定首先对双视图中各个视图的实时身份识别结果进行量化,计算各视图中多用户身份识别的实时正误判定指标.身份识别准确度研究主要针对连续采样的平均准确度,本文的方法主要分析当前身份识别状态多用户身份识别的实时正误标记值φ.用户跟踪正确设定φ=1,跟踪丢失、跟踪错误和跟踪无效设定φ=0.3.1.1 前视图身份识别正误判定前视图的骨骼运动跟踪中,针对每个用户的身份分配唯一的跟踪ID,当跟踪正常时每个用户对应的跟踪ID不变,用户跟踪出现大面积接触、丢失或者遮挡引发的跟踪错误会导致跟踪ID发生变化.依据跟踪状态的前后关系匹配,建立前视图的正误判断规则,跟踪正确的用户数为α,用户骨骼的实时正误标记值Wr=1;骨骼跟踪丢失或错误的用户数为β,实时正误标记值We=0,则前视图多用户身份识别正误判定为跟踪用户的平均实时正误标记值WF:

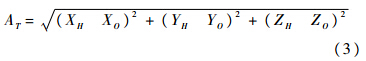

式中:WF的取值范围为0~1.0.式(2)的主要作用是对前视图的骨骼运动追踪正误程度进行评估,为顶视图耦合身份识别实时矫正提供指导.通过WF的值可以判断前视图中当前运动跟踪的准确程度,如视图中总人数α+β=5,WF=0.8,由此可知前视图中4名用户跟踪正确,1名用户跟踪丢失或错误,根据用户标记可以确定到跟踪错误的具体用户. 3.1.2顶视图身份识别正误判定顶视图中卡尔曼滤波的多目标运动跟踪,采用预测位置与实际位置的最小欧氏距离来评价运动跟踪的误差.假设当前帧T时刻,滤波预测空间坐标为HT(XH,YH,ZH),实际位置向量为OT(XO,YO,ZO),滤波的误差距离为

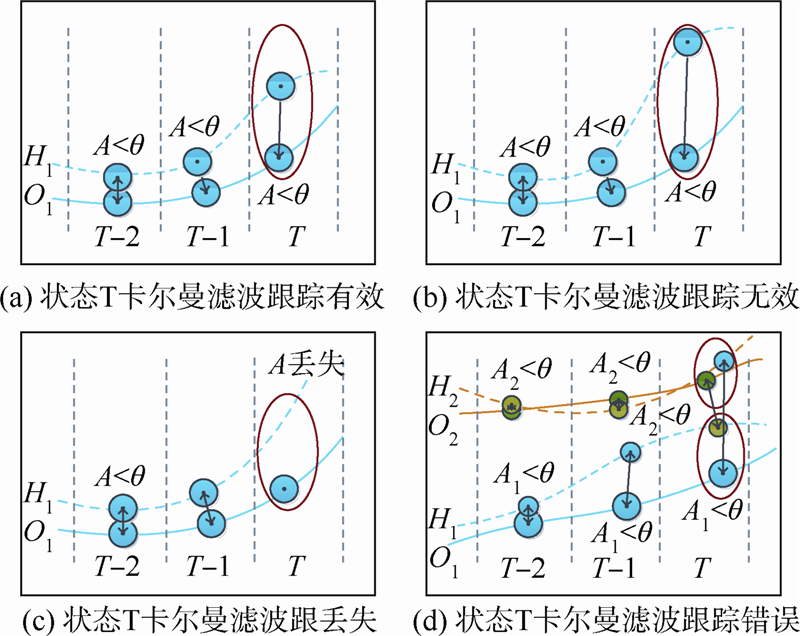

式(3)中AT越小运动跟踪的精度越高,针对当前状态T,根据多用户实际运动跟踪设定有效误差距离阈值为θ,设定跟踪的正误标记值为φ,进行跟踪结果正误量化.卡尔曼运动跟踪中,对当前状态T可能出现的各种常见形式进行分析,并给出跟踪正误标记的量化计算.假定Oi和Hi分别为运动跟踪中的实际位置和预测位置,其中i用于区分跟踪用户,从而建立实际位置与预测位置的对应映射如(O1,H1)、(O2,H2)等,不同用户运动跟踪的误差距离分别为A1和A2等,具体运动跟踪形式如图 4所示.

|

| 图 4 卡尔曼滤波跟踪状态分析图Fig. 4 Analysis diagram of Kalman filtering tracking status |

| 图选项 |

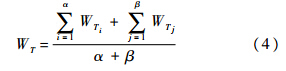

图 4(a)状态T,卡尔曼运动跟踪预测位置H1和实际位置O1的跟踪误差为AT,AT<θ则运动误差在有效距离之内,运动跟踪预测有效,实时正误标记值φ=1;图 4(b)状态T,卡尔曼运动跟踪预测的误差AT>θ,如椭圆圈内所示,则运动跟踪预测无效,实时正误标记值φ=0;图 4(c)状态T,卡尔曼运动跟踪出现跟踪丢失,此时跟踪误差AT不存在,因此当前状态的运动跟踪错误,实时正误标记值φ=0;图 4(d)状态T,多用户的运动跟踪,虽然多用户的跟踪误差AT都在有效距离θ之内,但是根据前后运动预测状态可知,T1预测位置同T预测位置轨迹发生交叉.T1实际位置同T实际位置轨迹无交叉点,造成预测位置同实际位置的最小欧氏距离映射错误(O2,H1)、(O1,H2).图 4(d)椭圆圈内所示,错误跟踪用户的身份识别实时正误标记值φ=0.依据跟踪状态的前后关系匹配,建立顶视图身份识别的正误判断规则,跟踪正确的用户数为α,实时正误标记值WTi=1;用户跟踪丢失或错误的用户数为β,实时正误标记值WTj=0,则顶视图卡尔曼滤波身份识别正误判定为跟踪用户的平均实时正误标记值WT:

式中:WT的取值范围为0~1.0.式(4)的主要作用是对顶视图卡尔曼滤波运动追踪的正误程度进行评估,为前视图耦合身份识别实时矫正提供指导.通过WT的值可以判断顶视图中实时运动跟踪的准确程度,根据用户标记可以具体到所有用户的跟踪正误,便于双视图的耦合.3.2 双视图耦合有限状态机 针对两个视图中不同的用户识别方法,本文提出采用五元组M=(Q,Σ,δ,q0,F),建立双视图有限状态机模型.其中Q为非空有限状态集,Σ为接受状态集合,δ为转移函数,q0为初始状态,F为最终状态集合.假设已知场景中用户数为N,WT和WF分别为顶视图和前视图的实时正误标记值,则双视图有限状态机的状态转移表如表 1所示.表 1 双视图有限状态转移表Table 1 Finite state conversion table based on double view

| 条件 | 状态Q1:双视图跟踪正确 | 状态Q2:前视图跟踪异常 | 状态Q3:顶视图跟踪异常 | 状态Q4:双视图跟踪异常 |

| δ1(WF=1,WT=1) | 状态Q1 | 状态Q1 | 状态Q1 | 状态Q1 |

| δ2(WF<1,WT=1) | 状态Q2 | 状态Q2 | 状态Q2 | 状态Q2 |

| δ3(WF=1,WT<1) | 状态Q3 | 状态Q3 | 状态Q3 | 状态Q3 |

| δ4(WF<1,WT<1) | 状态Q4 | 状态Q4 | 状态Q4 | 状态Q4 |

表选项

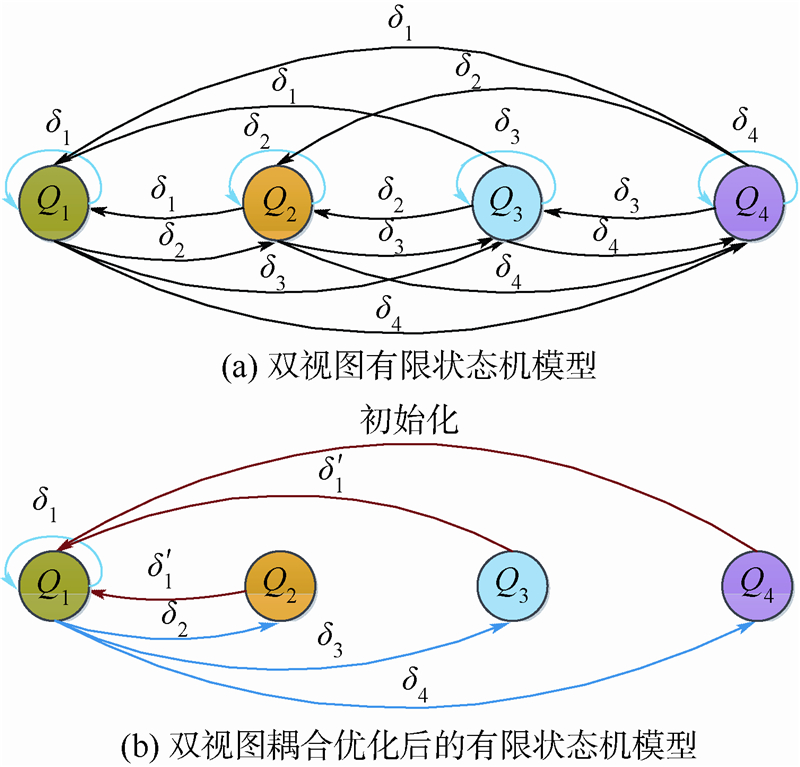

表 1中,Q1状态,双视图跟踪正确,通常体现为多用户之间非遮挡和非接触的运动跟踪;Q2状态,前视图正误标记值WF<1,顶视图正误标记值WT=1,通常体现为前视图因用户之间遮挡造成用户跟踪丢失,以及遮挡后引发的跟踪错误;Q3状态,前视图正误标记值WF=1,顶视图正误标记值WT<1,通常体现为顶视图因用户之间的部分接触造成用户跟踪丢失和接触结束后引发的跟踪错误;Q4状态,双视图的正误标记值都小于1,双视图都出现跟踪错误或丢失情况,通常体现为多用户之间出现既接触又遮挡的情况或大面积接触造成的多用户人数合并.表 1是一个理论的状态转移表,由于Q4状态因为大面积接触、跟踪错误、跟踪丢失等因素造成的双视图异常.双视图的低正误标记值,难以推导出状态转移条件δ1、δ2和δ3对其状态转移进行指导,本文采用初始化算法进行状态转化.由双视图有限状态转移表,结合耦合前的有限状态机模型(图 5(a))分析,建立双视图耦合的有限状态机模型(图 5(b)),并指导双视图进行耦合的多用户身份识别.

|

| 图 5 双视图耦合有限状态机模型Fig. 5 Coupling finite-state machine model based on double views |

| 图选项 |

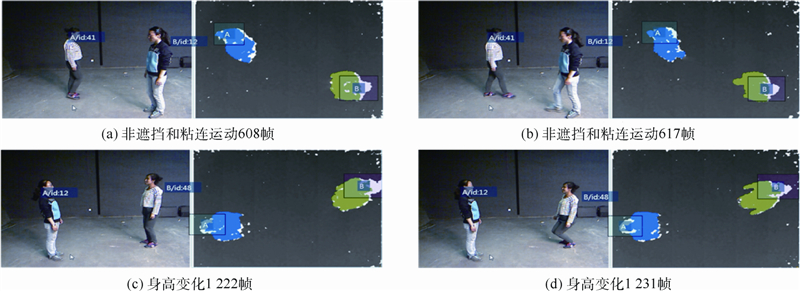

图 5(a)是双视图耦合前的有限状态机模型,所有状态之间通过条件δ相互转化,异常状态Q2、Q3和Q4由于缺乏耦合的正确指导,身份识别的异常状态持续存在并能够相互转移;图 5(b)为双视图耦合后的有限状态机模型,通过耦合对异常状态Q2、Q3和Q4进行身份识别的矫正指导.Q2→Q1状态转移中,因Q2状态正误标记值WF<1,WT=1,所以δ′1为顶视图对前视图进行指导,指导后的效果等同于δ1(WF=1,WT=1),并趋向转化为Q1状态,然后由等同的Q1状态再转化为其他状态.同理Q3的转化过程也是一个耦合指导的过程,而Q4状态难以推导出δ1(WF=1,WT=1)指导条件,因此采取初始化算法重新跟踪进行身份识别.从以上描述不难看出,所提出的双视图耦合有限状态机模型是一个指导、矫正和匹配的模型,是指导双视图中状态机的异常错误状态向正确状态推导转化的过程模型. 3.3 双视图耦合多用户身份识别矫正通过对顶视图和前视图运动的跟踪正误量化,实现双视图的运动跟踪耦合.建立基于双视图跟踪正误标记值的耦合机制,依据双视图耦合的有限状态机模型,对单个视图中的用户身份标记进行矫正,从而提高协同交互情景下的用户身份识别能力.具体耦合机制为

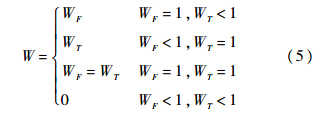

式(5)中,当前视图正误标记值WF=1且顶视图正误标记值WT<1时,双视图耦合的正误标记值采用前视图,说明顶视图发生身份跟踪异常.根据有限状态机判断当前的运动状态,双视图用户标记不一致时,利用前视图对顶视图用户身份进行矫正.当前视图正误标记值WF<1且顶视图正误标记值WT=1时,双视图耦合的正误标记值采用顶视图,说明前视图发生身份跟踪异常,根据有限状态机判断当前的运动状态,双视图用户标记不一致时,顶视图对前视图用户身份进行矫正.当前视图正误标记值WF=1且顶视图正误标记值WT=1时,根据有限状态机判断当前的运动状态,通常WF=WT=1,双视图跟踪正确.当前视图正误标记值WF<1且顶视图正误标记值WT<1时,双视图跟踪均出现异常,根据有限状态机判断当前的运动状态,此时重启算法,重新进行用户跟踪. 4 实验结果实验硬件环境为CPU:Intel酷睿,i7-3770 3.4GHz,显卡:技嘉N660OC-2GD,显存2GB,内存:G.SKILL RipjawsX DDR3 1600,容量8GB;双Kinect相机;软件环境为Kinect SDK1.6,Microsoft Visual Studio 2010;空间环境为前视图Kinect相机高度1.5m,顶部Kinect相机高度3.7m.实验内容为:实验对有限状态机模型中状态Q1、Q2、Q3和Q4对应的常见身份识别类型为无接触和遮挡多用户身份识别、多用户遮挡的身份识别、多用户部分接触的身份识别、多用户大面积接触和接触与遮挡并存的身份识别,进行状态间相互转化的身份识别实验. 4.1 无接触和遮挡的身份识别采用双视图耦合的多用户身份识别方法,对双视图跟踪正常状态即多用户之间无遮挡和接触的运动跟踪进行实验,如图 6所示.

|

| 图 6 双视图耦合无接触和遮挡的身份识别效果Fig. 6 Identification effect of double views coupling without contact and occlusion |

| 图选项 |

图 6(a)和图 6(b)为截取连续图像中608帧和617帧的跟踪结果,多用户之间无遮挡和接触的运动跟踪,双视图中用户身份标记A、B一致,且前后608帧和617帧的多用户身份也识别一致;图 6(c)和图 6(d)为截取连续图像中1222帧和1231帧的跟踪结果,虽然用户的身高发生变化,但双视图中用户身份标记A、B一致,且前后1222帧和1231帧的多用户身份识别也一致.608~617帧和1222~1231帧每帧对应的实时正误标记值均为1,前视图和顶视图连续每帧的正误标记值均为1,用户身份识别正确无需矫正,双视图耦合效果等同于单视图. 4.2 遮挡身份识别在用户遮挡因素的干扰下,双视图耦合与单视图的多用户身份识别效果如图 7所示,左侧为遮挡干扰下的单相机前视图实验效果,右侧为耦合的双视图实验效果,耦合过程相关变量数据如表 2所示.

|

| 图 7 遮挡干扰下耦合双视图与单视图的多用户身份识别效果Fig. 7 Identification effect of coupling double views and single view by interfering with occlusion |

| 图选项 |

图 7(a)~图 7(c)为单视图的前视图实验,RGB图像和深度图身份识别效果,因为用户间的遮挡容易发生识别错误.图 7(b)用户之间发生遮挡,导致被遮挡用户跟踪丢失.图 7(c)遮挡结束后引发身份ID发生变化,从而导致用户身份标记A/B发生错误;图 7(d)~图 7(f)为双视图耦合的用户身份识别效果,462~478帧前视图RGB图像中,用户ID虽然发生变化,但是用户身份标记仍然映射正确,同顶视图用户标记识别一致.表 2中T和F分别为顶视图和前视图实时监测场景中用户数,WT和WF分别为顶视图和前视图的实时正误标记值,W为双视图耦合实时正误标记值.表 2中464~476帧前视图监测到场景中人数为1,顶视图为2可知前视图中出现遮挡情况,用户ID发生变化,引发跟踪丢失,实时准确度降低,而顶视图跟踪实时正误标记值均为1,WT>WF顶视图对前视图进行耦合矫正(图 8).

|

| 图 8 遮挡干扰下多用户身份识别的双视图耦合矫正过程Fig. 8 Double views coupling corrections process of multi-user identification by interfering with occlusion |

| 图选项 |

表 2 遮挡干扰下的双视图耦合过程变量数据Table 2 Variable data of double views coupling process by interfering with occlusion

| 数据帧 | T | F | 身份一致 | WF | WT | W |

| 462 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 463 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 464 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 465 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 466 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 467 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 468 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 469 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 470 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 471 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 472 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 473 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 474 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 475 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 476 | 2 | 1 | NO | 0.50 | 1.00 | 1.00 |

| 477 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 478 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

表选项

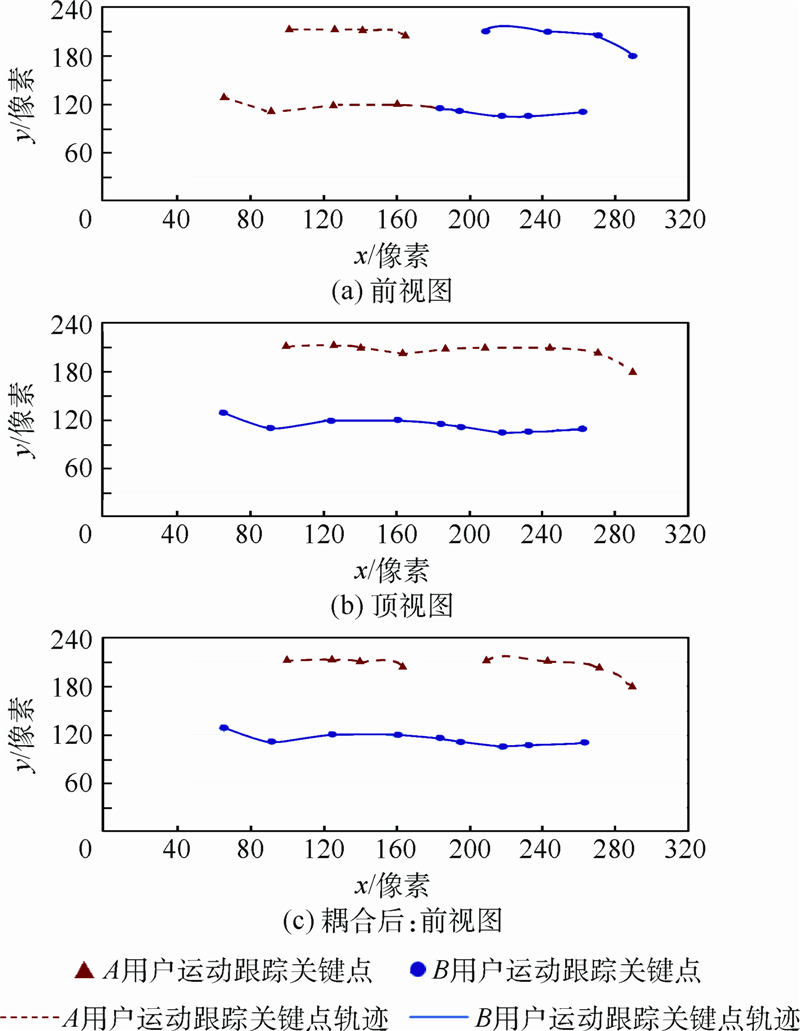

图 8(a)即耦合矫正前,前视图用户A对用户B发生遮挡,从而造成遮挡后用户A和用户B身份的跟踪错误.由图 8(b)顶视图中用户A和用户B运动轨迹可知,顶视图不受用户A和用户B前视图遮挡的影响.图 8(c)为顶视图依据表 2数据对前视图进行耦合矫正后的结果,从图 8(c)前视图用户A和B的运动轨迹可知,耦合矫正后A和B用户跟踪正确.4.3 部分接触的身份识别 在用户部分接触因素的干扰下,双视图耦合与单视图的多用户身份识别效果如图 9所示,双视图身份识别的耦合过程相关变量数据见表 3.

|

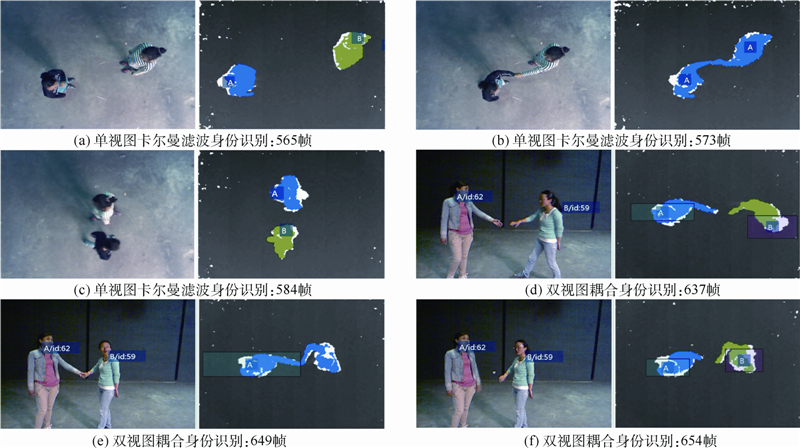

| 图 9 部分接触干扰下耦合双视图与单视图的多用户身份识别效果耦合矫正过程Fig. 9 Identification effect of coupling double views and single view by interfering with partial contactc |

| 图选项 |

图 9(a)~图 9(c)为单视图的顶视图实验,RGB图像和深度图跟踪效果.图 9(b)发生用户之间的部分接触,导致顶视图用户难易分割,从而引发用户身份标记A或B出现丢失,接触结束后用户身份标记A或B发生跟踪错误(图 9(c));图 9(d)~图 9(f)为双视图耦合的用户身份识别效果,637~654帧顶视图深度图像中,虽然用户之间出现接触导致用户分割错误,但是接触结束后顶视图深度图像中用户身份标记仍然正确,同前视图RGB图像中用户标记识别一致.表 3 部分接触干扰下的双视图耦合过程变量数据Table 3 Variable data of double views coupling process by interfering with partial contact

| 数据帧 | T | F | 身份一致 | WF | WT | W |

| 637 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 638 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 639 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 640 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 641 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 642 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 643 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 644 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 645 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 646 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 647 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 648 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 649 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 650 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 651 | 1 | 2 | NO | 1.00 | 0.50 | 1.00 |

| 652 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 653 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

| 654 | 2 | 2 | YES | 1.00 | 1.00 | 1.00 |

表选项

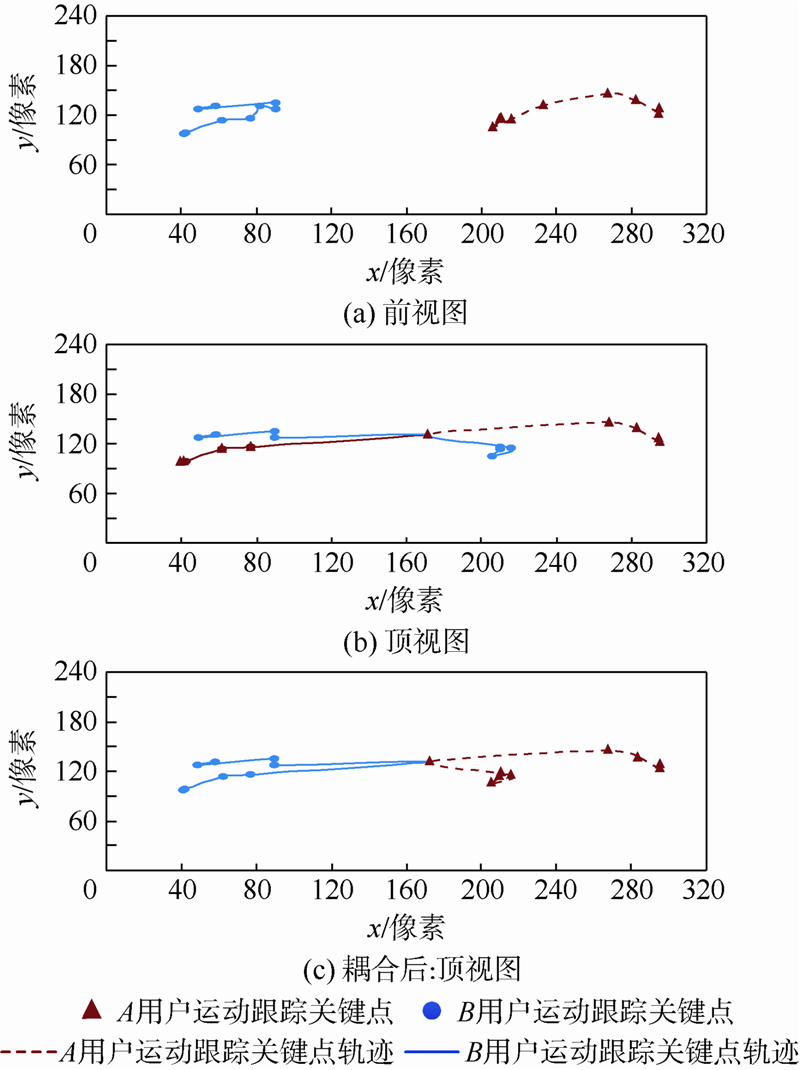

表 3中641~651帧顶视图监测到场景中人数为1,前视图为2,可知用户之间出现部分接触情况,造成顶视图用户难以分割,引发跟踪错误,实时准确度降低,而前视图跟踪正误标记值均为1,WT<WF前视图对顶视图进行耦合矫正(图 10).

|

| 图 10 部分接触状态多用户身份识别的双视图耦合矫正过程耦合矫正过程Fig. 10 Double views coupling corrections process of multi-user identification by interfering with partial contact |

| 图选项 |

由图 10(a)前视图中用户A和用户B运动轨迹可知,前视图不受用户A和用户B前视图部分接触的影响.图 10(b)即耦合矫正前,顶视图用户A和用户B发生部分接触,从而造成接触后用户A和用户B身份的跟踪错误.图 10(c)为前视图依据表 3数据对顶视图进行耦合矫正后的结果,从图 10(c)顶视图用户A和B的运动轨迹可知,耦合矫正后A和B用户跟踪正确. 4.4 大面积接触和遮挡并存的身份识别当多用户大面积接触或接触与遮挡并存时,前视图骨骼运动跟踪将大面积接触的用户视为同体.大面积接触和遮挡容易引发用户跟踪丢失以及接触和遮挡结束后的跟踪错误,从而造成前视图的跟踪异常WF<1;顶视图卡尔曼滤波运动跟踪的前期很难将接触的用户分割开来,视大面积接触的用户为同体,出现跟踪丢失以及接触结束后的跟踪错误,从而造成顶视图WT<1.此时双视图很难建立耦合的指导关系,因此初始化算法便于重新开始身份识别.4.5 双视图耦合多用户身份识别准确度 实验分别对有限状态机的Q1、Q2和Q3状态转化,以及3个状态连续转化的用户身份识别准确性进行测试.人数为3人,每组状态转化运行40次.由于人体运动速度的可变性,难以控制每次的运动速度相等,因此采用人体运动的正常速度,控制每个状态运行转化速度为100帧.双视图耦合的用户身份识别效果,与单视图的前视图(骨骼运动跟踪)和顶视图(卡尔曼滤波)进行对比,如图 11和表 4所示,并利用SPSS卡方检验效果对比的显著性差异.图 11左侧和右侧分别为3个用户部分粘连前后和遮挡前后的跟踪效果.表 4 各视图多用户身份识别效果Table 4 Identification effect of various views for multi-user

| 视图 | 人数 | 状态 | 正/误次数 | 准确度 |

| 顶视图 | 3 | Q1-Q1 | 40/0 | 1.00 |

| 顶视图 | 3 | Q1-Q2-Q1 | 40/0 | 1.00 |

| 顶视图 | 3 | Q1-Q3-Q1 | 18/22 | 0.53 |

| 顶视图 | 3 | Q1-Q2-Q1-Q3-Q1 | 24/16 | 0.67 |

| 前视图 | 3 | Q1-Q1 | 40/0 | 1.00 |

| 前视图 | 3 | Q1-Q2-Q1 | 23/17 | 0.77 |

| 前视图 | 3 | Q1-Q3-Q1 | 38/0 | 1.00 |

| 前视图 | 3 | Q1-Q2-Q1-Q3-Q1 | 21/19 | 0.70 |

| 双视图 | 3 | Q1-Q1 | 40/0 | 1.00 |

| 双视图 | 3 | Q1-Q2-Q1 | 40/0 | 1.00 |

| 双视图 | 3 | Q1-Q3-Q1 | 40/0 | 1.00 |

| 双视图 | 3 | Q1-Q2-Q1-Q3-Q1 | 40/0 | 1.00 |

表选项

|

| 图 11 3个用户的双视图耦合识别效果耦合矫正过程Fig. 11 Identification effect of coupling double views for three users |

| 图选项 |

由表 4所示,在Q1(用户无遮挡和粘连)自身转化状态中,双视图耦合的身份识别准确性与单视图的前视图和顶视图相比无明显差别;在Q1-Q2-Q1(用户遮挡)状态转化中,双视图耦合的身份识别准确性与单视图的顶视图相比无明显差别,但与单视图的前视图相比准确度大于前视图,卡方检验P(0.032)<0.05;在Q1-Q3-Q1(用户遮挡)状态转化中,双视图耦合的身份识别准确性与单视图的前视图相比无明显差别,但与单视图的顶视图相比准确度大于前视图,卡方检验P(0.004)<0.05;在Q1-Q2-Q1-Q3-Q1(用户遮挡)完整状态转化中,双视图耦合的身份识别准确性,与单视图的顶视图和前视图相比准确度大于单视图,且卡方检验P分别为0.046和0.015,均小于0.050.以上分析可以看出,双视图耦合与单视图骨骼跟踪和卡尔曼滤波相比多用户身份识别更具有鲁棒性. 5 结 论通过实验分析表明,基于双视图耦合的多用户身份识别方法具有良好的稳定性,可以实现双视图的识别信息融合和相互纠错,有效地解决用户遮挡引发的多用户身份识别错误以及处理用户部分接触造成的多用户身份识别错误.实验数据表明,在3人数的40次无遮挡和粘连、遮挡、粘连的完整转化状态下,该方法的准确度为1.0,明显高于传统的单视图卡尔曼滤波方法0.67和骨骼运动跟踪方法0.7,具有很好的准确度,有效可行.但是,该方法依赖正确数据的耦合和矫正,在解决用户之间大面积接触、多用户之间既遮挡又接触状态的身份识别方面,容易造成多个视图识别的数据错误,从而降低准确度.因此,在双视图异常情况下,如何提高协同交互情境中用户多重遮挡与接触并存的多用户身份识别鲁棒性问题是日后的工作重点和方向.致谢 感谢程萌萌、张慕华、郑颖和杨进中博士为实验过程提供的大力帮助.

参考文献

| [1] | Grudin J,Poltrock S.Taxonomy and theory in computer supported cooperative work[M].Kozlowski S W J.The Oxford Handbook of Organizational Psychology.Oxford:Oxford University Press,2012:1323-1348. |

| [2] | Navarro P,Johns M L,Lu T H,et al.Webz of war:a cooperative exergame driven by the heart[C]//2013 IEEE Intermational Games Innovation Conference.Vancouver,BC:IEEE,2013:187-190. |

| Click to display the text | |

| [3] | 迟健男,刘丛丛,朱博,等.多人多点触摸系统多用户协同交互触点归属问题研究[C]//第25届中国控制与决策会议论文集.沈阳:东北大学出版社,2013:3478-3485. Chi J N,Liu C C,Zhu B,et al.Research on the ownership of user touch points of multi-user cooperative interaction in multi-user multi-touch system[C]//Control and Decision Conference(CCDC),2013 25th Chinese.Shenyang:Northeastern University Press,2013:3478-3485.(in Chinese) |

| Click to display the text | |

| [4] | Hocking C G,Furnell S M,Clarke N L,et al.Co-operative user identity verification using an authentication aura[J].Computers & Security,2013,39(8):486-502. |

| Click to display the text | |

| [5] | Gall J,Stoll C,De Aguiar E,et al.Motion capture using joint skeleton tracking and surface estimation[C]//2009 IEEE Computer Society Conference of Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE,2009:1746-1753. |

| Click to display the text | |

| [6] | Matt. Managing multiple players with kinect in C#[EB/OL].Matt Crouch-WebDeveloper(2012-06-10)[2014-05-15].http://mattcrouch.net/blog/2012/06/managing-multiple-players-with-kinect-in-c/. |

| Click to display the text | |

| [7] | Salvi D,Waggoner J,Temlyakov A,et al.A graph-based algorithm for multi-target tracking with occlusion[C]//Proceedings of the 2013 IEEE Workshop on Applications of Computer Vision.Washington,D.C.:IEEE,2013:489-496. |

| Click to display the text | |

| [8] | Choi W,Pantofaru C,Savarese S.Detecting and tracking people using an RGB-D camera via multiple detector fusion[C]//Proceedings of the 2011 IEEE International Conference on Computer Vision Workshops.Piscataway,NJ:IEEE,2011:1076-1083. |

| Click to display the text | |

| [9] | 张彦超,许宏丽. 遮挡目标的分片跟踪处理[J].中国图象图形学报,2014,19(1):92-100. Zhang Y C,Xu H L.Fragments tracking under occluded target[J].Journal of Image and Grapgics,2014,19(1):92-100(in Chinese). |

| Cited By in Cnki (2) | |

| [10] | 赵龙,肖军波. 一种改进的运动目标抗遮挡跟踪算法[J].北京航空航天大学学报,2013,39(4):517-520. Zhao L,Xiao J B.Improved algorithm of tracking moving objects under occlusions[J].Journal of Beijing University of Aeronautics and Astronautics,2013,39(4):517-520(in Chinese). |

| Cited By in Cnki (8) | |

| [11] | Qin B,Wan N C.PANOPTICON:person recognition and tracking through occlusion using extended Kalman[EB/OL].New York:Cornell University,2011[2014-05-30].http://www.cs.cornell.edu/Courses/cs4758/2011sp/final_projects/spring_2011/Qin_Wan.pdf. |

| Click to display the text | |

| [12] | Harvey E R,Ouellet J N,Echevarria J,et al.Computer vision application using the Kinect sensor for the identification and tracking of users interacting with a surface computing platform[C]//Proceedings of the 2012 Applied Vision and Robotics Workshop.Montreal:[s.n.],2012:74-86. |

| [13] | Barbosa I B,Cristani M,Del Bue A,et al.Re-identification with RGB-D sensors[C]//Proceedings of the 12th European Conference on Computer Vision.Heidelberg,Berlin:Springer,2012,7583:433-442. |

| [14] | Meng R,Isenhower J,Qin C,et al.Can smartphone sensors enhance kinect experience[C]//Proceedings of the thirteenth ACM international symposium on Mobile Ad Hoc Networking and Computing.New York:ACM,2012:265-266. |

| Click to display the text | |

| [15] | Ackad C,Clayphan A,Maldonado R M,et al.Seamless and continuous user identifica-tion for interactive tabletops using personal device handshaking and body tracking[C]//Proceedings of CHI'12 Extended Abstracts on Human Factors in Computing Systems.New York:ACM:2012:1775-1780. |

| [16] | 王炜,郭毓,俞信. 基于卡尔曼滤波的多区域关联运动目标跟踪[J].计算机应用,2012,32(11):3174-3177. Wang W,Guo Y,Yu X.Moving object tracking with related multi-regions based on Kalman filter[J].Journal of Computer Applications,2012,32(11):3174-3177(in Chinese). |

| Cited By in Cnki (9) | |

| [17] | 陈志敏,薄煜明,吴盘龙,等.基于自适应粒子群优化的新型粒子滤波在目标跟踪中的应用[J].控制与决策,2013,28(2):193-200. Chen Z M,Bo Y M,Wu P L,et al.Novel particle filter algorithm based on adaptive particle swarm optimization and its application to radar target tracking[J].Control and Decision,2013,28(2):193-200(in Chinese). |

| Cited By in Cnki (28) | |

| [18] | Shotton J,Fitzgibbon A,Cook M,et al.Real-time human pose recognition in parts from single depth images[C]//Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Computer Society,2011:1297-1304. |

| [19] | Salhi A,Jammoussi A Y.Object tracking system using camshift,meanshift and Kalman filter[J].World Academy of Science,Engineering and Technology,2012,64(6):674-679. |

| Click to display the text | |

| [20] | 史倩,吴开华. 区域生长的轮对图像分割[J].中国图象图形学报,2012,17(9):1122-1127. Shi Q,Wu K H.Image segmentation for wheel set measurement based on region growing[J].Journal of Image and Graphics,2012,17(9):1122-1127(in Chinese). |

| Cited By in Cnki (5) |