, 边杰

, 边杰 东北大学 信息科学与工程学院,辽宁 沈阳 110819

收稿日期:2022-05-09

基金项目:国家自然科学基金资助项目(61773108)。

作者简介:郑艳(1963-), 女, 辽宁沈阳人, 东北大学副教授, 博士。

摘要:孪生网络系列的跟踪器基于相似度匹配的方法来实现目标跟踪,当遇到相似干扰物时会发生跟踪漂移现象,从而导致跟踪失败.针对这个问题,以SiamBAN跟踪器为研究基础,提出了一种改进算法.主要改进包括:在训练阶段,加入中心回归分支来降低远离目标中心的边界框分数,同时引入Focal Loss损失函数,在推理阶段设计了全新的筛选策略,来区分要跟踪的目标和相似干扰物.改进后的算法在OTB100测试集的成功率和精度相比于原来分别提高了2.1%和3%,在GOT10k的测试集上成功率比原来提高了2.1%.

关键词:目标跟踪SiamBAN孪生网络干扰物感知神经网络

Improved Object Tracking Algorithm Based on SiamBAN Tracker

ZHENG Yan, ZHAO Jia-xu

, BIAN Jie

, BIAN Jie School of Information Science & Engineering, Northeastern University, Shenyang 110819, China

Corresponding author: ZHAO Jia-xu, E-mail: 1927069009@qq.com.

Abstract: The siamese network series tracker utilizes the similarity matching method for object tracking, but tracking drift can occur when similar distractors are encountered, leading to tracking failure. To solve this problem, based on the research of SiamBAN tracker, an improved algorithm is proposed. Major improvements include the addition of a centerness branch during training to reduce bounding box scores far from the object center, the introduction of the Focal Loss function, and a new screening strategy during inference to differentiate the target from similar distractors. Compared with the original, the success plot and precision plot of the improved algorithm are increased by 2.1% and 3% respectively on the OTB100 test set, and the success plot is 2.1% higher than the original on the GOT10k test set.

Key words: object trackingSiamBANsiamese networkdistractor awareneural network

目标跟踪(本文所述的目标跟踪是指单目标跟踪)一直是计算机视觉领域里一个非常活跃的研究方向,它需要根据给定序列初始帧的目标状态来预测后续每一帧的目标状态,通常用一个边界框来表示[1].目标跟踪在视频监控、人机交互以及自动驾驶等诸多领域都有着广泛的应用[2].

近几年,基于孪生网络的跟踪器由于在精度和速度方面良好的平衡表现,受到了广泛关注.最初,SiamFC[3]首先引入结合相关层的特征映射,但由于其只进行了目标和背景分类,采用多尺度测试来改变边界框尺度,并不能处理由目标变化引起的边界框宽高比变化,所以生成的边界框并不紧密.为得到更精确的目标边界框,SiamRPN[4-5]引入了目标检测方法中的区域提议网络,虽然它可以处理边界框尺度和宽高比的变化,但同时引入了锚框相关的参数,这些参数需要仔细的设计和调整来实现良好的性能,而且锚框与目标之间的模糊匹配严重阻碍了跟踪器的鲁棒性.

目标检测领域中CornerNet[6],FCOS[7]等以每像素预测的方式来实现目标检测,直接预测目标存在的可能性和边界盒坐标.受这些无锚检测器的启发,一些基于孪生网络的无锚跟踪器被设计出来,比如SiamFC++[8],SiamBAN[9]和SiamCAR[10]等.它们的整体网络结构非常相似,都是由用于特征提取的孪生网络和区域提议子网络两部分组成.不同的是,SiamBAN对提取特征的后三层进行了融合,从而可以更好地捕获目标的细粒度信息来精确定位目标,以及编码抽象的语义信息来健壮地应对目标外观变化,这也是相对于上述另外两种无锚跟踪器,本文选用SiamBAN跟踪器作为研究基础的主要原因.

与那些简单背景不同,相似干扰物是具有语义信息的背景,比如跟踪目标是一个特定的人,在目标周围出现的其他人就是相似干扰物.具有相似干扰物影响的场景在日常生活中很常见,所以解决这个问题非常具有实际意义,本文通过对SiamBAN进行改进,并设计一种新的策略,来解决相似干扰物影响问题,进一步提升了SiamBAN的跟踪性能.

1 相关研究工作基于孪生网络的跟踪器无法有效应对具有相似干扰物的场景,主要原因在于这种相似度匹配的方法不能区分需要跟踪的目标和相似干扰物.因为当相似干扰物与目标距离很近或者发生交互时,在分类得分图上相似干扰物的最终得分很可能会超过目标的得分,导致跟踪漂移到相似干扰物身上,进而造成跟踪失败.

针对上述的问题,本文以SiamBAN为基础对其进行改进,主要包括以下几方面:

1) 为了提高SiamBAN识别目标和相似干扰物的能力,在训练阶段使用Focal Loss[11]替代原来分类分支的交叉熵损失函数.Focal Loss可以提高模型解决正样本和负样本、简单样本和困难样本不平衡的能力.这里所述的困难样本就是具有语义的背景,即相似干扰物.

2) 训练阶段,在分类分支中加入中心质量分支.中心质量分支首先由FCOS提出,它能够降低远离目标中心的低质量边界框的分数.

3) 在推理阶段,保留目标在当前帧之前相邻几帧的运动状态,并根据目标的运动具有连续、渐变以及平滑性,设计了一种筛选策略来区分目标和相似干扰物.

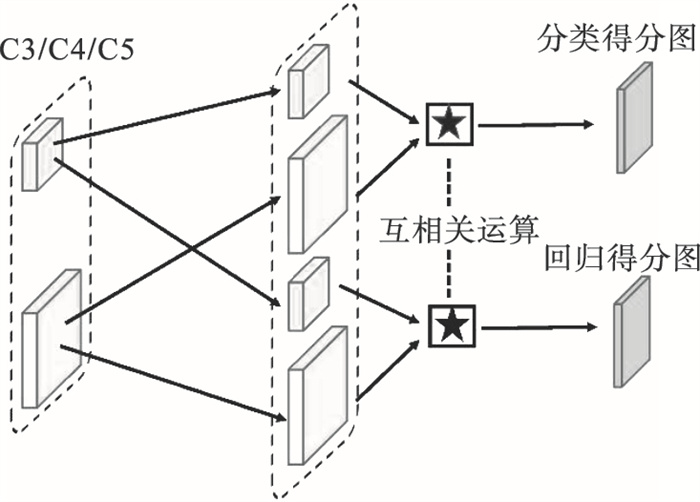

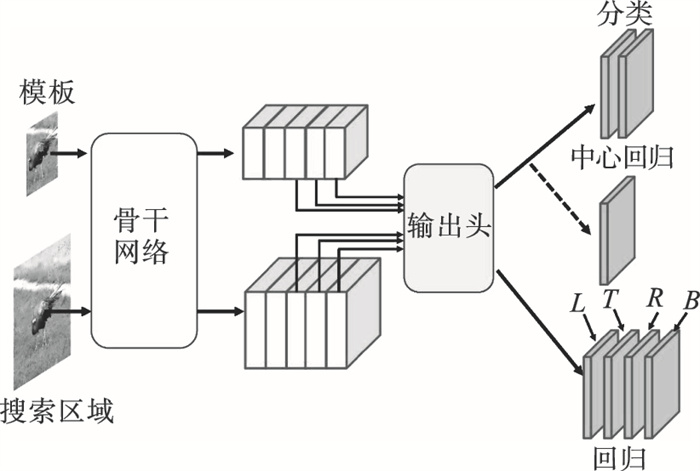

2 改进算法的设计与实现2.1 SiamBAN算法框架SiamBAN跟踪器的网络结构由孪生骨干网络和多个自适应头两部分组成.骨干网络对模板分支和搜索分支的输入图片进行特征提取,自适应头内部结构如图 1所示,C3/C4/C5表示采用提取特征中的Conv3,Conv4,Conv5多层特征进行融合,★表示深度互相关操作.SiamBAN整体网络框架如图 2所示,输出头包括分类和回归两部分,如图 2中最右侧的分类和回归所示,分类部分需要输出两个通道的得分图进行前景和背景分类,回归部分需要输出4个通道的得分图进行边界框预测,L,T,R,B表示分类部分预测的点到边界框4条边的距离.每个部分使用深度互相关层组合特征映射:

图 1(Fig. 1)

| 图 1 Head内部结构Fig.1 Head internal structure |

图 2(Fig. 2)

| 图 2 SiamBAN跟踪器的网络结构Fig.2 Network structure of SiamBAN tracker |

| (1) |

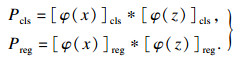

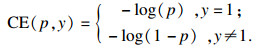

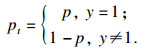

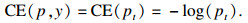

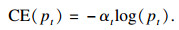

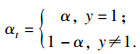

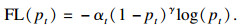

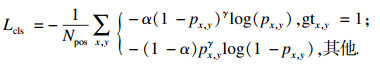

2.2 引入Focal Loss损失函数损失函数是机器学习里一个最为关键的要素,它可帮助模型学习如何能更好地达到预期目的.在目标跟踪任务中,把需要跟踪的目标视为正样本,其他背景视为负样本,可以将分类任务视为简单的二分类问题.相对于庞大的背景而言,目标所占的比例非常小,正样本和负样本之间存在着极大的不平衡问题.对于使跟踪器发生错误判断的目标,即相似干扰物,称之为困难样本,相反能够被跟踪器容易判断的目标称之为简单样本,困难样本蕴含着具有极大价值的信息,能够增强跟踪器的判别能力,相对于简单样本而言所占比例却非常小,它们之间同样存在着极大的不平衡问题.

针对上述问题,为了提高模型对目标和相似干扰物的识别能力,引入Focal Loss损失函数.首先定义二分类交叉熵损失函数:

| (2) |

| (3) |

| (4) |

| (5) |

| (6) |

| (7) |

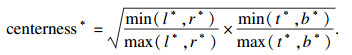

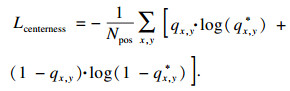

2.3 添加中心质量分支SiamBAN跟踪器是无锚框的,它采取逐像素预测的方式来回归边界框,在分类得分图中找到最大得分位置,并将这个位置映射回原图像中的位置作为目标的参考点,再结合回归得分图预测的四维向量(l, t, r, b)来确定包围目标的边界框.但是远离目标中心的位置往往会预测产生低质量的边界框,这降低了跟踪系统的性能.

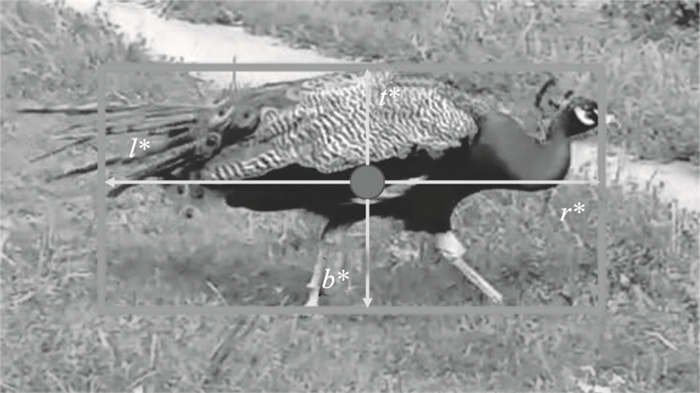

为了抑制这些低质量的边界框,本文在分类分支并行地添加了一个中心回归分支,如图 2中右侧中间的标志所示.每个位置的回归目标用l*,t*,r*和b*表示,中心回归定义为[7]

| (8) |

图 3(Fig. 3)

| 图 3 中心回归示意图Fig.3 Centerness schematic |

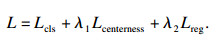

改进后,训练阶段的损失函数由下面几部分组成:

| (9) |

| (10) |

| (11) |

| (12) |

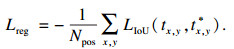

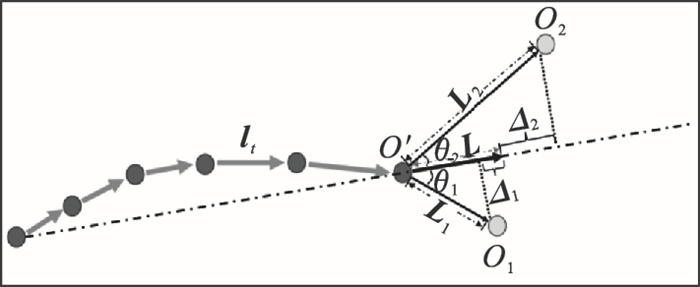

2.4 设计区分目标与相似干扰物策略受DaSiamRPN[12]启发,本文通过对最终的得分图利用非极大值抑制,来找到可能目标,可能目标中包括真正目标和相似干扰物.本文抛弃了原来对得分图的余弦窗惩罚,因为它抑制掉了距离搜索区域中心较远的目标,这不利于找全可能目标.

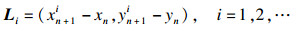

记{(x1, y1), (x2, y2), …, (xn, yn)}表示连续n帧的目标中心坐标,如图 4中的带箭头点所示,向量lt=(xt-xt-1, yt-yt-1), t=2, …, n表示目标在相邻两帧之间的运动状态;(xn+1i, yn+1i), i=1, 2, 3, …, 表示当前帧可能目标的中心坐标,i为可能目标的个数,例如,图 4中点O1和O2可以用(xn+11, yn+11)和(xn+12, yn+12)表示,它们都是通过非极大值抑制得到的;图 4中点O′表示上一帧预测目标的中心坐标,可以用(xn, yn)表示.把目标在连续n帧内的平均运动状态定义为

图 4(Fig. 4)

| 图 4 区分策略示意图Fig.4 Differentiation strategy diagram |

| (13) |

| (14) |

| (15) |

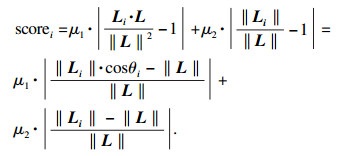

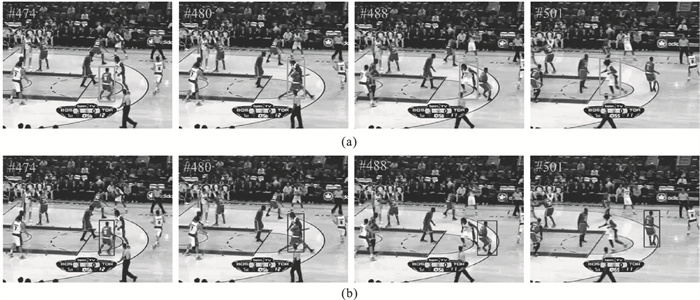

式(15)表明,Li与L夹角越小,||Li||与||L||越接近,则该可能目标的运动越符合真正目标的运动趋势,就是需要跟踪的目标,而相似干扰物只是在某些帧凭空出现,它并不符合目标在连续n帧的运动趋势.跟踪过程中不仅有目标的刚性运动,而且还有相机的刚性运动,但是目标在连续几帧内的运动依然是连续的、渐变的,并且有着它自己的运动趋势,如图 5所示,其中连续的点表示连续帧内的目标中心坐标,可以看出图 5中的目标与白色球衣的球员发生相对运动,在这个过程中目标的运动趋势是向右的,白色球衣的球员相对于目标而言运动方向向左,根据式(15),他不是真正的目标.

图 5(Fig. 5)

| 图 5 目标运动趋势示意图Fig.5 Schematic diagram of target movement trend |

3 实验研究3.1 实施细节训练阶段:用于特征提取的骨干网络采用ResNet-50结构,先在ImageNet[13]数据集上预训练,然后整体训练过程中骨干网络用预训练的权值初始化,并冻结前两层的参数.总共训练20个epoch.根据以往的经验,初始学习率选取0.01~0.001为宜,随着训练的进行学习率应不断衰减,接近训练结束时学习率的衰减应该在100倍以上,所以前5个epoch学习率从0.001到0.005预热,后15个epoch的学习率指数衰减为0.005到0.00005.在前10个epoch中,只训练Head部分,在后10个epoch中,以当前十分之一的学习速率对骨干网落进行微调,权重衰减和动量分别设为0.0001和0.9.

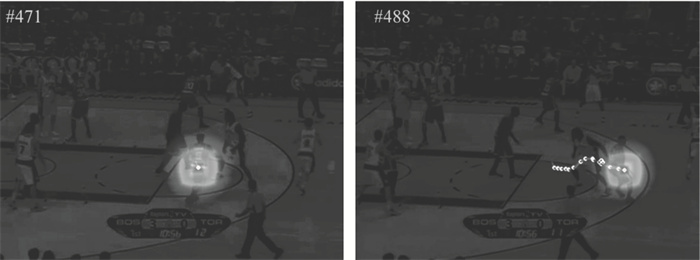

推理阶段:将分类得分图与中心质量分数相乘作为最终的得分图,如图 6所示,得分图中的两座峰分别表示两个不同目标的信息,但两座峰覆盖的范围很大,很多点是冗余的,一个目标只需要一个点来表示,并且两座峰的峰值点应该就是目标的中心点,是表示目标质量最高的点.所以先拿出得分图分数最大的点,并将其乘以0.75作为得分阈值,如图 6中阈值指示的平面所示,对得分高于这个平面的所有点采用非极大值抑制,两个峰的峰值点就会被保留下来,然后将保留下来的点用式(15)来计算,选取最小scorei对应的点作为分类预测结果,结合对应的回归向量,得到预测的边界框.

图 6(Fig. 6)

| 图 6 目标在3D得分图上的体现Fig.6 Representation of goals on a 3D score map |

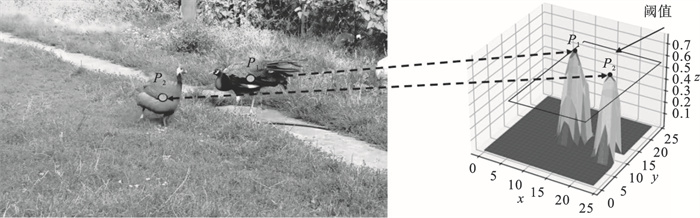

3.2 与改进前算法对比改进前的效果如图 7a所示,改进后的效果如图 7b所示,可以看到算法改进后成功跟住目标而没有发生漂移.

图 7(Fig. 7)

| 图 7 算法改进前后的效果对比Fig.7 Comparison of the effect before and after the algorithm improvement (a)—算法改进前;(b)—算法改进后. |

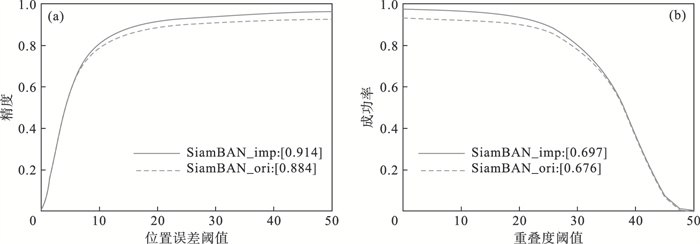

为了公平起见,本文的所有测试都是在带有Nvidia RTX 2080Ti GPU云端服务器上进行的,在OTB100基准测试数据集改进前后的对比如图 8所示,SiamBAN_imp表示改进后的结果,SiamBAN_ori表示原来的结果,从图 8中可以看出改进后的算法成功率提高了2.1%,精度提高了3%.

图 8(Fig. 8)

| 图 8 在OTB100上的精度和成功率Fig.8 Success plot and precision plot on OTB100 (a)—精度对比;(b)—成功率对比. |

除此之外,为了进一步了解改进效果,本文还在GOT10k[14]基准测试数据集上进行了消融实验,如表 1所示,表中的数字都乘了100%.在加入中心质量分支和Focal Loss损失后的改进效果不明显,这是因为原来的算法在得分图上进行了余弦窗惩罚,直接选取惩罚后得分最大的点作为分类部分预测的结果,仍然会受到相似干扰物的影响.当把余弦窗惩罚去除,再引入区分策略,这时成功率比之前提高了2.1%.

表 1(Table 1)

| 表 1 在GOT10k基准上的消融实验 Table 1 Ablation experiments on the GOT10k benchmark |

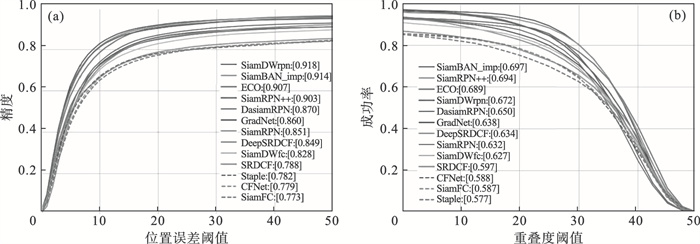

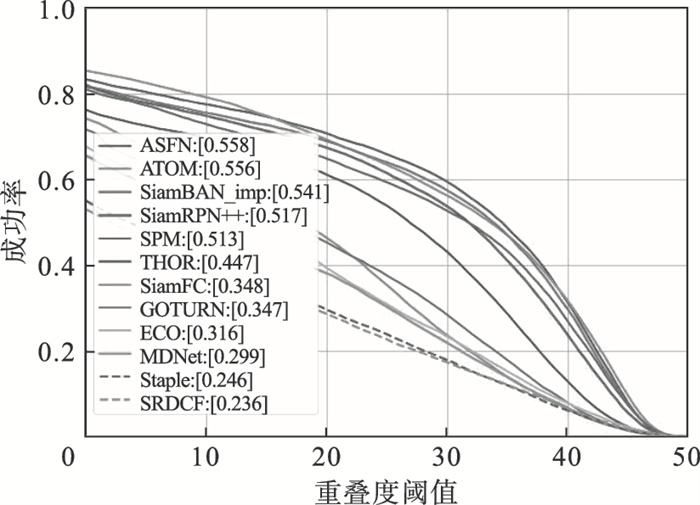

3.3 与先进跟踪器对比本文在OTB100和GOT10k基准测试数据集与ATOM[15], ECO[16]等先进跟踪器进行了对比,图 9是在OTB100基准测试数据集上进行的,无论在成功率还是精度方面,改进后的算法都获得了出色的表现.图 10是在GOT10k基准测试数据集上进行的对比, 与OTB100相比, GOT10k中视频场景更加复杂, 难度更大,但改进后的算法依然获得了良好的表现.

图 9(Fig. 9)

| 图 9 OTB100上多算法的精度与成功率对比Fig.9 Comparison of success plot and precision plot of multiple algorithms on OTB100 (a)—精度对比;(b)—成功率对比. |

图 10(Fig. 10)

| 图 10 GOT10k上的成功率Fig.10 Success plot on GOT10k |

4 结语本文针对孪生网络跟踪器在相似干扰物的影响下容易发生跟踪漂移的问题,在SiamBAN跟踪器基础上进行改进,并设计了一种有效的解决策略.与原来只选取得分最大点作为预测目标的方法不同,本文先找到所有可能目标,然后利用设计的区分策略确定最终的预测目标,这样做可以使模型提高鲁棒性.该区分策略不仅可以应用于SiamBAN,还可以应用于其他基于孪生网络的跟踪器,这相当于一个全新并且通用的后处理方法.

参考文献

| [1] | 孟琭, 杨旭. 目标跟踪算法综述[J]. 自动化学报, 2019, 45(7): 1244-1260. (Meng Lu, Yang Xu. A survey of object tracking algorithms[J]. Journal of Automation, 2019, 45(7): 1244-1260.) |

| [2] | 王红涛, 邓淼磊, 赵文君, 等. 基于深度学习的单目标跟踪算法综述[J]. 计算机系统应用, 2022, 31(5): 40-51. (Wang Hong-tao, Deng Miao-lei, Zhao Wen-jun, et al. A survey of single object tracking algorithms based on deep learning[J]. Computer Systems and Applications, 2022, 31(5): 40-51.) |

| [3] | Bertinetto L, Valmadre J, Henriques J F, et al. Fully-convolutional siamese networks for object tracking[C]//European Conference on Computer Vision. Cham: Springer, 2016: 850-865. |

| [4] | Li B, Yan J, Wu W, et al. High performance visual tracking with siamese region proposal network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, 2018: 8971-8980. |

| [5] | Li B, Wu W, Wang Q, et al. SiamRPN++: evolution of siamese visual tracking with very deep networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 4282-4291. |

| [6] | Law H, Deng J. CornerNet: detecting objects as paired keypoints[C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich, 2018: 734-750. |

| [7] | Tian Z, Shen C H, Chen H, et al. FCOS: fully convolutional one-stage object detection[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul, 2019: 9627-9636. |

| [8] | Xu Y, Wang Z, Li Z, et al. SiamFC++: towards robust and accurate Visual tracking with target estimation guidelines[C]//Proceedings of the AAAI Conference on Artificial Intelligence. New York, 2020, 34(7): 12549-12556. |

| [9] | Chen Z, Zhong B, Li G, et al. Siamese box adaptive network for visual tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, 2020: 6668-6677. |

| [10] | Guo D, Wang J, Cui Y, et al. SiamCAR: siamese fully convolutional classification and regression for visual tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, 2020: 6269-6277. |

| [11] | Lin T Y, Goyal P, Girshick R, et al. Focal Loss for dense object detection[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, 2017: 2980-2988. |

| [12] | Zhu Z, Wang Q, Li B, et al. Distractor-aware siamese networks for visual object tracking[C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich, 2018: 101-117. |

| [13] | Russakovsky O, Deng J, Su H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252. DOI:10.1007/s11263-015-0816-y |

| [14] | Huang L, Zhao X, Huang K. GOT-10k: a large high-diversity benchmark for generic object tracking in the wild[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 43(5): 1562-1577. |

| [15] | Danelljan M, Bhat G, Khan F S, et al. ATOM: accurate tracking by overlap maximization[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 4660-4669. |

| [16] | Danelljan M, Bhat G, Khan F S, et al. ECO: efficient convolution operators for tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, 2017: 6638-6646. |