, 王力

, 王力 东北大学 机器人科学与工程学院,辽宁 沈阳 110167

收稿日期:2022-05-17

基金项目:国家自然科学基金资助项目(61973065,U20A20197); 辽宁省重点研发计划项目(2020JH2/10100040); 中央高校基本科研业务费专项资金资助项目(N2226002)。

作者简介:姜杨(1982-), 男, 辽宁沈阳人, 东北大学副教授。

摘要:从CT图像中快速、准确地分割出新型冠状病毒肺炎(COVID-19)病灶区域,是实现对COVID-19计算机辅助诊疗的重要环节,为此提出了一种基于双注意力机制的COVID-19病灶CT图像分割方法.首先,引入门控注意力AG模块从空间上增强对病灶区域的关注,降低图像亮度不均衡、低对比度对分割精度的影响;其次,引入结合残差单元的SE-Res模块对病灶区域进行通道增强,提取细微结构特征,提高网络对病灶形状变化较大和磨玻璃边界区域的分割性能.在COVID-19公共数据集上实验表明,所提出方法达到的Dice系数、阳性预测值、交并比分别为0.908 8,0.915 2,0.858 9,与前期研究相比,分别提高了0.75%,0.11%,0.65%.所提出方法能提高对病灶形状变化较大区域和磨玻璃边界的分割精度,整体性能优于当前主流模型.

关键词:图像处理医学图像分割新型冠状病毒肺炎双注意力机制UNet

Segmentation of COVID-19 CT Images Based on Dual Attention Mechanism

JIANG Yang, LIU Cheng, DING Qi-chuan

, WANG Li

, WANG Li School of Robotics Science & Engineering, Northeastern University, Shenyang 110167, China

Corresponding author: DING Qi-chuan, E-mail: dingqichuan@mail.neu.edu.cn.

Abstract: Rapid and accurate segmentation of COVID-19 lesions from CT images is an important step to realize computer-assisted diagnosis and treatment of COVID-19. Therefore, a CT image segmentation method of COVID-19 lesions based on dual-attention mechanism is proposed. Firstly, the attention gate module is introduced to enhance the focus on the focal region in space and reduce the influence of image brightness imbalance and low contrast on the segmentation accuracy. Secondly, the SE-Res module combined with residual element was introduced to enhance the channel of the lesion region, extract the fine structural features, and improve the segmentation performance of the network for the lesion shape change and ground glass boundary region. Experiments on the public datasets of COVID-19 show that the Dice, PPV and IoU achieved by the proposed method are 0.908 8, 0.915 2 and 0.858 9, respectively, which are 0.75%, 0.11% and 0.65%higher than previous studies, respectively. The proposed method can improve the segmentation accuracy of the lesions with large shape changes and ground glass boundaries, and the overall performance is better than current mainstream models.

Key words: image processingmedical image segmentationCOVID-19dual attention mechanismUNet

医学影像分割是指对医学图像中的器官或病灶进行提取,其本质是按照纹理、灰度等图像特征,根据同一区域特征的相似性和邻域特征的不同分割出感兴趣区域(region of interest,ROI),从而为临床医学提供诊断依据[1].从肺部CT图像中分割出新型冠状病毒(corona virus disease 2019, COVID-19)病灶可以辅助医生诊断和评估患者病情,但肺部组织结构复杂,其CT图像噪声强、亮度不均及对比度低的特点,影响肺部病灶的分割精度,因此对病灶区域提取是研究肺部疾病的重要步骤.

传统的医学图像分割方法主要分为三种[2]:1)手动分割,由专家手动分割,耗时且容易出错,不适合大规模研究.2)半自动分割,利用形态学分割方法(例如分水岭算法[3])对全局进行分割,手动对感兴趣区域进行选取,避免对全局图像的特征提取,但由于不同类型的CT图像的特征和参数阈值不一致,很难对其进行统一.3)自动分割,依靠数字图像处理领域的分割算法,主要分为基于阈值、区域、聚类的三种分割方法.基于阈值的分割[4]速度较快,但对噪声敏感,对于灰度差异小的图像分割效果较差;基于区域的分割[5]对有病理的边界分割效果较差;基于聚类的分割[6]对初始点赋值敏感,分割结果受初始化影响较大.

目前,研究者利用深度学习方法提取更丰富的图像特征,有效提高分割性能.Shelhamer等[7]提出了全卷积网络(fully convolutional networks,FCN)用于图像语义分割,用卷积层替代全连接层,取得了良好的分割效果,但上采样结果比较模糊,对图像的细节信息不敏感,对医学图像分割效果不佳.Ronneberger等[8]提出了U-Net网络,通过编码器和解码器间的级联操作避免了高层语义信息的丢失,实现多尺度融合,在医学图像分割领域应用广泛,但下采样过程中会存在大量冗余信息,影响分割效果.此后,许多研究者改进了UNet结构,以提升网络性能.Zhou等[9]提出了UNet++模型,重新设计跳跃连接,用于在解码器子网络聚合不同尺度的语义特征.Oktay等[10]提出了Attention-UNet模型,在UNet的基础上引入空间注意力机制,使网络将注意力集中在感兴趣区域,降低冗余信息的干扰.Alom等[11]提出了R2U-Net,将循环卷积神经网络和循环残差网络结合,提高了网络学习能力,解决了网络退化的问题.还有许多针对肺实质和COVID-19病灶的CT图像分割工作,钱宝鑫等[1]提出了一种编码/解码的肺实质分割算法,在编码和解码之间利用空洞空间金字塔池化(ASPP)模块提取上文多尺度信息.钟思华等[12]提出了一种改进U-Net网络的肺结节分割方法,该方法通过引入密集连接,加强网络对特征的传递与利用,并且可以避免梯度消失的问题.Zhao等[13]提出了一种新的CT图像肺实质分割方法,该方法将三维V-Net与使用空间变换网络实现的变形模块相结合,采用V-Net进行端到端的肺提取,利用变形模块根据先验形状知识对V-Net的输出进行细化.Mu等[14]提出了一种渐进式全局感知和局部抛光(PCPLP)网络来自动分割CT图像中的COVID-19病灶区域,利用全局感知模块提供潜在病灶的整体估计,使用局部抛光模块对病灶区域进行精确预测,以提高细节信息的获取.Fan等[15]提出了一种利用隐式反向注意和显式边缘注意改进感染区域的COVID-19病灶CT图像分割网络.Singh等[16]提出了用于分割COVID-19病灶的LungInfSegNet,该网络利用接收场感知(RFA)模块,可以扩大分割模型的接收场,提高模型的学习能力而不损失信息.除了以上自动分割网络外,在交互式网络方面,Maninis等[17]提出了Deep Extreme Cut(DEXTR),通过在分割区域边界人为生成种子交互点从而提高分割精度.Kitrungrotsakul等[18]在DEXTR的基础上,针对COVID-19病灶形状变化较大、边界模糊的特点提出了交互式细化网络Attention-RefNet,该网络在训练中可以自动生成交互种子点,使用者只需在测试阶段人为生成种子点,解决了训练时对新冠感染区域生成交互种子点困难的问题.

以上研究对CT图像分割精度的提升有一定的帮助,但COVID-19的CT图像中存在低对比度、灰度不均衡的问题,并且COVID-19病灶区域存在大小和位置变化较大、磨玻璃边界等问题[19],都会导致分割效果不佳.在上述讨论的基础上,本文提出了一种基于双注意力机制的COVID-19病灶CT图像分割方法,可以有效缓解上述问题的影响,提高对COVID-19病灶区域的分割性能.

本文在UNet基础上,为降低COVID-19CT图像亮度不均衡、低对比度对分割精度的影响,在跳跃连接处引入门控注意力(attention gate, AG)模块,从空间上增强网络对COVID-19病灶区域的关注,抑制U-Net网络下采样带来的浅层冗余.为提高对新冠病灶磨玻璃边界和形状变化较大区域的分割性能,引入结合残差单元的压缩-激励模块替代传统的卷积模块,对新冠肺炎病灶区域的细微特征进行通道增强,同时避免网络出现层数过深导致网络退化,有效提高对病灶区域的特征提取能力.通过在COVID-19公共数据集上实验对本文方法的有效性进行验证,结果表明该网络能有效提高CT图像中COVID-19病灶区域分割的准确率.

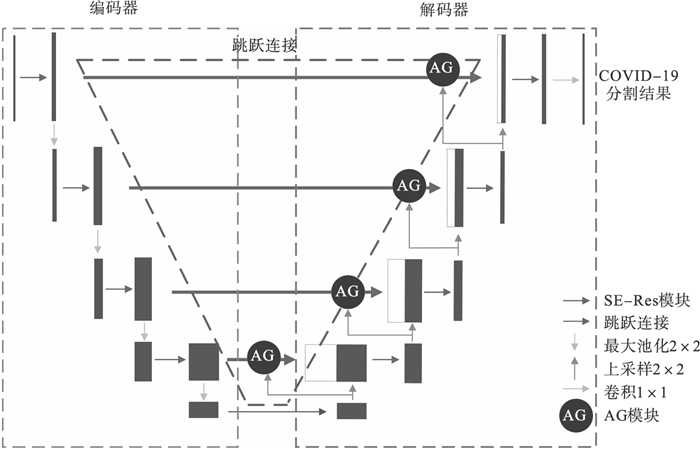

1 网络模型1.1 SER-UNet总体网络结构针对COVID-19病灶CT图像分割问题设计出SER-UNet网络结构如图 1所示,编码部分包含SE-Res模块和池化层,使用SE-Res模块代替传统的卷积模块,在SE模块的基础上结合残差模块,对网络通道增强,提高网络对细微结构特征的提取能力,增强模型对COVID-19病灶磨玻璃边界和形状变化较大区域的分割能力.解码器由SE-Res模块和上采样层构成,在跳跃连接部分引入门控注意力模块,从空间上增强网络对COVID-19病灶区域的关注,抑制了UNet网络的浅层冗余信息,降低了COVID-19病灶CT图像的亮度不均衡、低对比度问题对分割精度的干扰,最后用1×1的卷积层对病灶和背景进行分类.

图 1(Fig. 1)

| 图 1 SER-UNet网络结构Fig.1 SER-UNet structure |

1.2 UNetUNet结构[8]主要由编码器(encoder)、解码器(decoder)和跳跃连接(skip connection)三部分构成.编码部分包含3×3的卷积模块和2×2的最大池化层,主要进行下采样的工作,获得肺部在整个图像中丰富的上下文信息,帮助网络对像素类别判断.解码部分包含2×2的上采样卷积层和3×3的卷积层,主要负责上采样工作,提取图像的深层信息从而实现对COVID-19病灶的精确定位.跳跃连接是UNet区别于其他编码器-解码器网络的重要部分,医学CT图像具有边界模糊、梯度复杂的特点[20],故需要较多的浅层信息用于精准分割,而深层信息可用于COVID-19病灶区域的识别.跳跃连接将COVID-19CT图像的浅层与深层特征图信息结合起来,能够很好地实现多尺度信息融合,以获得更精确的上下文信息.但是由于下采样过程中会带来大量浅层冗余信息,导致CT图像的低对比度、灰度不均衡影响分割效果,同时COVID-19病灶具有形状变化较大、磨玻璃边界等问题[16],在这些区域UNet网络存在较大的欠分割和过分割情况.

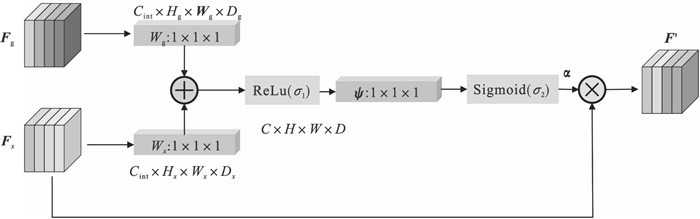

1.3 AG模块注意到UNet的下采样过程带来了许多冗余的浅层特征信息,导致图像亮度的不均匀,低对比度仍会对COVID-19病灶的分割造成较大干扰,考虑在跳跃连接处引入空间注意力机制AG(attention gate)模块[10],加强对新冠病灶区域的权重,从空间上提高网络对新冠病灶区域的关注,降低浅层冗余信息的干扰,捕获更多的高级语义信息,降低CT图像低对比度和灰度不均衡问题对分割精度的影响.AG模块的结构示意图如图 2所示.

图 2(Fig. 2)

| 图 2 门控注意力结构Fig.2 Attention gate structure |

AG模块的输入项为特征图Fx∈RCx×Hx×Wx×Dx和Fg∈RCx×Hx×Wx×Dx,其中C, H, W, D分别代表各自特征图的通道数、高度、宽度及空间维度上的深度.Fx是图 2中网络结构中编码部分的特征图,Fg是一个门控信号,取自网络中Fx对应上采样前一层的特征图,包含上下文信息.Fg通过1×1×1的卷积操作后,其维度变为Cint×Hx×Wx×Dx,Fx通过strided卷积后维度变为Cint×Hx×Wx×Dx, 将变换后的两者进行加操作,此过程导致对齐的权重增大,未对齐的权重相对减小,从而能够使网络从空间上加强COVID-19病灶区域的关注,相加后的向量经过ReLU激活层和1×1×1卷积ψ后,提升网络的非线性表达能力并将通道数从Cint压缩为1,计算公式如下[21]:

| (1) |

| (2) |

| (3) |

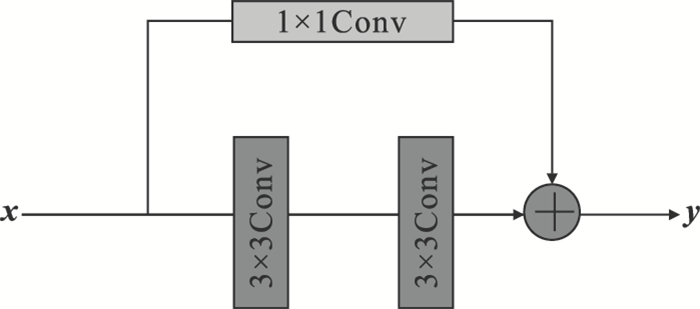

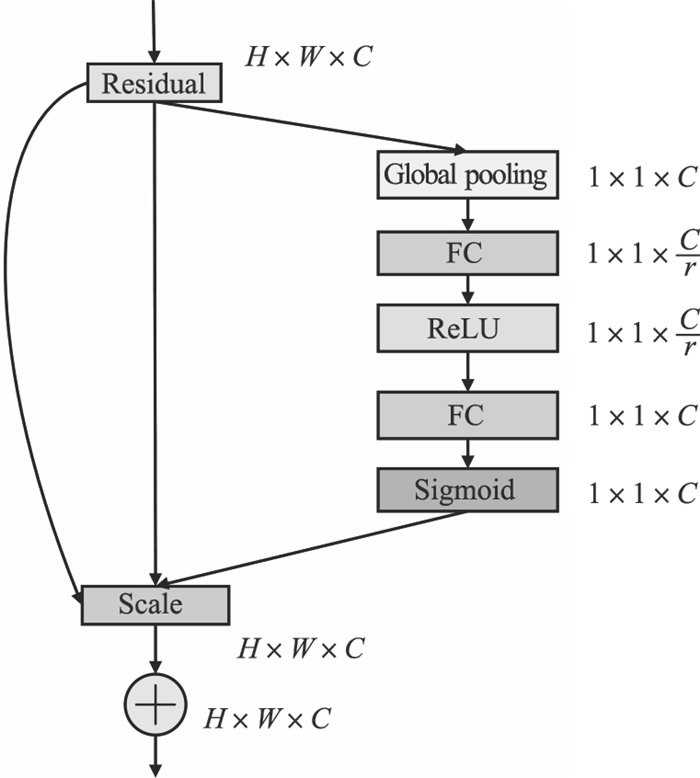

1.4 SE-Res模块尽管AG模块加强了网络对COVID-19病灶区域的关注程度,减少UNet下采样过程中带来大量冗余信息对分割效果的影响,有效降低了新冠CT图像存在的低对比度,灰度不均衡问题对分割效果的影响.但是对于COVID-19病灶中磨玻璃边界以及形状变化较大区域分割效果较差.在加强对COVID-19病灶空间注意力的基础上,注意到不同通道病灶特征间的关联性,引入SE-Res模块对网络进行通道增强,在压缩-激励(squeeze-and-excitation module,SE)模块[22]的基础上结合残差模块[23](residual module,Res),增强模型对细微结构特征的学习能力提高COVID-19病灶CT图像形状变化较大和磨玻璃边界区域的分割效果,残差模块Res的基本计算公式如下[24]:

| (4) |

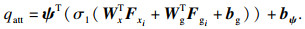

残差模块的网络结构如图 3所示,与普通网络的串行结构相比,残差网络引入了跳跃映射,补充了卷积过程中损失的特征信息.残差模块的引入避免了网络层数加深梯度消失造成网络性能下降的问题,仅添加1*1的卷积层,不会增加模型的计算复杂度,短路连接使得残差网络具有更强的学习能力,缩短了前后层之间的距离,有助于提取CT图像中COVID-19病灶更多的细节特征.

图 3(Fig. 3)

| 图 3 残差模块网络结构Fig.3 Residual module structure |

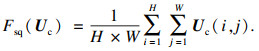

SE模块主要包含压缩和激励两部分,通过对不同通道特征分配权值来代表各自通道的重要程度,对COVID-19病灶区域特征进行通道增强,增强对病灶细微结构和模糊区域的分割精度,其结构如图 4所示.特征图经过全局平均池化(global average pooling)得到一个1×1×C的压缩特征,它代表在特征通道上相应的全局分布,使得靠近输入的层也能获得全局感受野,计算公式为[25]

| (5) |

| 图 4 压缩-激励模块结构Fig.4 Squeeze-and-excitation module structure |

激励操作由两个全连接层构成,第1个全连接层的输入为1×1×C, 输出是1×1×C×SEratio.第2个全连接层输入为1×1×C×SEratio,输出还原为1×1×C.其中SEratio是一个缩放参数,用来减少全连接层的参数.

使用两个全连接层可以更好地拟合通道间的相关性.最后用Sigmoid函数限制到[0, 1]的范围,并通过Scale操作,将得到的1×1×C通道权重向量与原特征图对应通道的二维矩阵相乘,得到输出特征图.

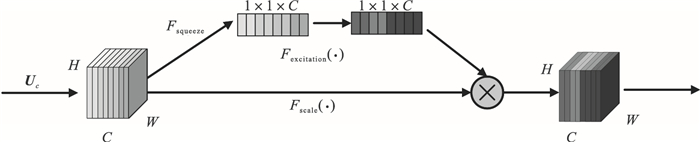

为了加强网络对细节特征的提取,提高对新冠形状变化较大区域和磨玻璃边界区域的分割效果,考虑将SE模块与Res模块结合为SE-Res模块,如图 5所示,将SE模块嵌入到Res模块中,方框旁的维度信息代表该层的输出,由于主干上存在[0, 1]的Scale操作,故需在Res模块的add操作前对分支上的Res进行特征重标定,否则网络较深BP优化会在靠近输入层出现梯度消失的情况,导致模型难以优化[11].采用SE-Res模块代替UNet结构编码阶段中的卷积模块,对COVID-19病灶区域特征进行通道增强,提高对病灶模糊区域和细微结构的识别,进一步加强了网络对COVID-19病灶CT图像的特征提取能力,提高了模型对病灶形状变化较大区域和磨玻璃边界的分割精度.

图 5(Fig. 5)

| 图 5 SE-Res模块结构Fig.5 SE-Res module structure |

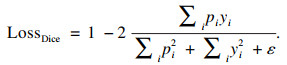

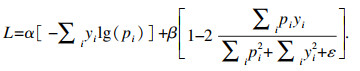

1.5 损失函数本文使用交叉熵损失函数与Diceloss组成的混合损失函数,在二分类图像分割中,交叉熵损失函数定义如下:

| (6) |

| (7) |

| (8) |

2.2 参数设置本文实验使用pytorch1.3.1框架运行,实验选取批量大小batch_size为16,初始学习率lr为0.000 1,选取迭代次数epoch为30,采用Adam优化器对模型优化.选取在验证集上平均损失最小的模型作为最终的分割模型.

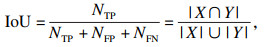

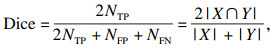

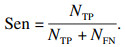

2.3 评价指标为对本文提出的分割模型进行评估,采用相似性系数(Dice coefficient score, Dice),交并比(intersection over union, IoU)和准确度(accuracy, Acc), 阳性预测值(positive predictive value, PPV)灵敏度(sensitivity, Sen)作为评价指标,取值范围均为[0, 1],其计算公式分别为

| (9) |

| (10) |

| (11) |

| (12) |

| (13) |

2.4 消融实验采用UNet网络作为基准模型进行几组消融实验,根据设置的网络参数分别对网络进行训练,使用测试集对模型进行检验,消融实验结果如表 1所示,并展示了分割可视化的结果如图 6~图 8所示,虚线方框代表输入肺部CT图像中COVID-19病灶的磨玻璃边界和形状变化较大区域,图(c)中箭头代表基准模型相较于本文模型分割存在的欠分割或过分割部分,其余图中箭头代表替换模块后改进的分割部分.

表 1(Table 1)

| 表 1 消融实验结果 Table 1 Ablation results |

图 6(Fig. 6)

| 图 6 第1组COVID-19病灶分割可视化Fig.6 Segmentation results of COVID-19 focus in group 1 (a)—Inputimage;(b)—Groundtruth;(c)—UNet;(d)—UNet+SE-Res;(e)—UNet+Res+AG;(f)—UNet+Res;(g)—UNet+AG;(h)—本文模型. |

图 7(Fig. 7)

| 图 7 第2组COVID-19病灶分割可视化Fig.7 Segmentation results of COVID-19 focus in group 2 (a)—Inputimage;(b)—Groundtruth;(c)—UNet;(d)—UNet+SE-Res;(e)—UNet+Res+AG;(f)—UNet+Res;(g)—UNet+AG;(h)—本文模型. |

图 8(Fig. 8)

| 图 8 第3组COVID-19病灶分割可视化Fig.8 Segmentation results of COVID-19 focus in group 3 (a)—Inputimage;(b)—Groundtruth;(c)—UNet;(d)—UNet+SE-Res;(e)—UNet+Res+AG;(f)—UNet+Res;(g)—UNet+AG;(h)—本文模型. |

2.4.1 AG模块将基准模型UNet与UNet+AG模型进行对比,分割可视化如图 6~图 8中的(c),(g)所示.可见(c)图基准模型箭头所示区域存在较大的欠分割和过分割情况,这是由于UNet网络在下采样过程中带来了大量COVID-19病灶的浅层特征,而CT图像中存在低对比度和灰度不均衡的问题,影响了网络对病灶的分割精度.从表 1的分割性能指标可见,加入AG模块后的UNet网络的Dice系数由0.828 1提高到0.831 5,Sen系数由0.832 7提高到0.872 2,IoU系数由0.770 8提高到0.773 7,网络对COVID-19病灶的分割准确率和灵敏度都有所提高,从可视化结果图 6g~图 8g也可见,加入AG模块后减少了COVID-19病灶的欠分割和过分割,分割性能优于基准模型.综上,表明引入AG模块后提高了模型对COVID-19病灶的分割性能,在空间上增强网络对感染区域的关注,突出潜在的感染区域,抑制浅层网络的冗余信息,从而缓解了图像亮度不均衡、低对比度的对分割效果的影响,验证了AG模块的有效性.

2.4.2 SE-Res模块将基准模型与UNet+SEres模型进行对比,分割可视化结果如图 6~图 8中的(c),(d)所示.通过图 6c和图 8c可以观察到,COVID-19病灶之间存在形状变化较大的问题,对于面积较小的感染区域,基准模型会存在欠分割的情况,同时从图 7c可以观察到,COVID-19病灶存在磨玻璃边界,导致基准模型在模糊边界中分割效果较差.从表 1观察到,加入SE-Res模块后Dice系数由0.828 1提高到0.857 8,Sen系数由0.832 7提高到0.883 2,IoU系数由0.770 8提高到0.801 8,同时从可视化结果图 6d~8d观察到,加入SE-Res模块后可以减少对形状变化较大的COVID-19病灶的错误分割情况,同时提高对磨玻璃边界的分割效果,表明加入SE-Res模块后的模型能有效提高对形状变化较大区域和磨玻璃边界的分割效果,通过学习来获取每个COVID-19特征通道的重要程度,对新冠肺炎病灶区域的细微结构特征进行通道增强,验证了SE-Res模块的有效性.同时通过基准模型和UNet+Res模型的对比也可以观察到,结合Res模块后,Dice系数由0.828 1提高到0.849 5,Sen系数由0.832 7提高到0.87 6,IoU系数由0.770 8提高到0.789 0,可以加强网络对新冠病灶特征的提取能力,降低可能出现的错误分割.

2.4.3 双注意力机制网络通过表 1的指标数据和图 6~图 8的(c),(h)可见,结合AG和SE-Res模块的分割效果在实验中达到了最优,相较于基准模型,Dice系数从0.828 1提高到0.908 8,Sen系数由0.832 7提高到0.915 2,IoU系数由0.770 8提高到0.858 9,PPV系数由0.912 4提高到0.926 3,分割效果的提升超过了简单增加任何单一模块时的提升.从分割可视化图 6h~8h也可以观察到,箭头所示的COVID-19病灶磨玻璃边界和形状变化较大区域分割效果明显优于基准模型.验证了本文基于双注意力机制的COVID-19病灶CT图像分割模型不仅缓解了CT图像低对比度和灰度不均衡对分割精度的影响,同时提高了对新冠磨玻璃边界和形状变化较大病灶区域的分割精度.

2.5 与现有分割模型的比较将提出的SER-UNet模型与前期研究的分割模型进行了对比,如表 2所示.这些模型按照分割类型分为自动式分割和交互式分割两类,这两类分割网络中性能最优的指标均用粗体标记.在自动分割网络中,本文提出的模型除灵敏度外均达到了最优,Dice系数从UNet++的0.901 3提高到了0.908 8,PPV系数从FPN的0.925 2提高到了0.926 3,IoU系数从UNet++的0.852 4提高到了0.858 9,分别提高了0.75%, 0.11%, 0.65%, 验证了本模型对COVID-19病灶CT图像具有较好的分割性能.另外,观察到交互式分割网络普遍分割指标优于自动分割网络,文献[18]提出的交互式网络Attention-RefNet在Dice系数、Sen系数上比本文提出模型更优,这是因为交互式网络的分割精度不仅取决于数据集的质量和分割模型的网络结构,还加入了人为生成的交互种子点,这些种子点需要在感染区域边界生成,能帮助模型较大地提高病灶区域的分割精度.但是由于COVID-19病灶形状的碎片化、感染区域边界模糊等特性,使用者需要在每个感染区域都生成交互种子点,导致人为生成种子点的过程比较困难和复杂,这对于使用者生成种子点是一项较为复杂的工作,对比之下本文提出的自动分割网络更加有助于医生对感染进行快速、简便、稳定地诊断COVID-19病灶.数据集中新冠病灶CT图像有多张切片,而本模型只关注了单张切片,因此对于病灶区域较小的位置和一些模糊区域仍会出现分类错误的情况,下一步研究可以关注多张切片之间的像素联系,降低错检和漏检的情况,同时优化模型,进一步加强对病灶区域细微结构特征的提取,提高模型的鲁棒性和分割精度.

表 2(Table 2)

| 表 2 不同分割模型的实验结果 Table 2 Experimental results of different segmentation models |

3 结论针对COVID-19肺炎病灶CT图像存在低对比度和灰度不均匀、病灶区域形状变化较大、磨玻璃边界模糊等问题,本文提出了一种用于COVID-19肺炎病灶分割的SER-UNet网络.该网络引入双注意力机制,在空间上引入门控注意力机制,抑制浅层特征的冗余信息,降低了亮度不均衡、低对比度的影响.考虑到特征通道之间的关系,对病灶区域的模糊区域特征进行通道增强,并结合残差模块加强网络对细节特征的的学习能力,进一步加强了对特征的传递和利用,有效地提高了对COVID-19肺炎病灶CT图像的分割精度.通过消融实验以及最新研究的分割网络进行实验对比,提出方法达到的Dice系数、阳性预测值、交并比分别为0.908 8,0.915 2,0.858 9,与前期研究相比,分别提高了0.75%, 0.11%, 0.65%,结果表明本文的SER-UNet能够有效地区分COVID-19肺炎病灶和背景区域,具有良好的分割性能.

参考文献

| [1] | 钱宝鑫, 肖志勇, 宋威. 改进的卷积神经网络在肺部图像上的分割应用[J]. 计算机科学与探索, 2020, 14(8): 1358-1367. (Qian Bao-xin, Xiao Zhi-yong, Song Wei. An improved convolutional neural network for segmentation of lung images[J]. Computer Science and Exploration, 2020, 14(8): 1358-1367.) |

| [2] | Mansoor A, Bagci U, Foster B, et al. Segmentation and image analysis of abnormal lungs at CT: current approaces, challenges, and future trends[J]. Radiographics, 2015, 35(4): 1056-1076. DOI:10.1148/rg.2015140232 |

| [3] | 周娇, 徐向民, 吕华琳. 基于医学图像分割的半自动ROI提取[J]. 电视技术, 2007(2): 78-80. (Zhou Jiao, Xu Xiang-min, Lyu Hua-lin. Semi-automatic ROI extraction based on medical image segmentation[J]. Television Technology, 2007(2): 78-80.) |

| [4] | Hu S, Hoffman E A, Reinhardt J M. Automatic lung segmentation for accurate quantitation of volumetric X-ray CT images[J]. IEEE Transactions on Medical Imaging, 2001, 20(6): 490-498. DOI:10.1109/42.929615 |

| [5] | Adams R, Bischof L. Seeded region growing[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1994, 16(6): 641-647. DOI:10.1109/34.295913 |

| [6] | Xiao G, Yun X, Wu J M. A multi-cue mean-shift target tracking approach based on fuzzified region dynamic imagefusion[J]. Science China (Information Sciences), 2012, 55(3): 577-589. DOI:10.1007/s11432-012-4553-3 |

| [7] | Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651. DOI:10.1109/TPAMI.2016.2572683 |

| [8] | Ronneberger O, Fischer P, Brox T. U-Net: convolutional networks for biomedical image segmentation[C]//18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Munich, 2015: 234-241. |

| [9] | Zhou Z W, Siddiquee M M R, Tajbakhsh N, et al. UNet++: a nested U-net architecture for medical image segmentation[C]// 4th International Workshop on Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support. Granada, 2018: 3-11. |

| [10] | Oktay O, Schlemper J, Folgoc L L, et al. Attention U-Net: learning where to look for the pancreas[EB/OL]. [2018-05-20]. https://arxiv.org/abs/1804.03999.pdf |

| [11] | Alom M Z, Hasan M, Yakopcic C, et al. Recurrent residual convolutional neural network based on U-Net (R2U-Net) for medical image segmentation[EB/OL]. [2018-05-29]. https://arxiv.org/vc/arxiv/papers/1802/1802.06955v4.pdf. |

| [12] | 钟思华, 郭兴明, 郑伊能. 改进U-Net网络的肺结节分割方法[J]. 计算机工程与应用, 2020, 56(17): 203-209. (Zhong Si-hua, Guo Xing-ming, Zheng Yi-neng. Improved segmentation method of pulmonary nodules in U-Net network[J]. Computer Engineering and Applications, 2020, 56(17): 203-209.) |

| [13] | Zhao C, Xu Y, He Z, et al. Lung segmentation and automatic detection of COVID-19 using radiomic features from chest CT images[J]. Pattern Recognition, 2021, 119: 108071. DOI:10.1016/j.patcog.2021.108071 |

| [14] | Mu N, Wang H Y, Zhang Y, et al. Progressive global perception and local polishing network for lung infection segmentation of COVID-19 CT images[J]. Pattern Recognition, 2021, 120: 108168. DOI:10.1016/j.patcog.2021.108168 |

| [15] | Fan D P, Zhou T, Ji G P, et al. INF-Net: automatic COVID-19 lung infection segmentation from CT images[J]. IEEE Transactions on Medical Imaging, 2020, 39(8): 2626-2637. DOI:10.1109/TMI.2020.2996645 |

| [16] | Singh V K, Abdel-Nasser M, Pandey N, et al. LungINFseg: segmenting COVID-19 infected regions in lung CT images based on a receptive-field-aware deep learning framework[J]. Diagnostics, 2021, 11(2): 158-158. DOI:10.3390/diagnostics11020158 |

| [17] | Maninis K K, Caelles S, Pont-Tuset J, et al. Deep extreme cut: from extreme points to object segmentation[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, 2018: 616-625. |

| [18] | Kitrungrotsakul T, Chen Q Q, Wu H T, et al. Attention-RefNet: interactive attention refinement network for infected area segmentation of COVID-19[J]. IEEE Journal of Biomedical and Health Informatics, 2021, 25(7): 2363-2373. DOI:10.1109/JBHI.2021.3082527 |

| [19] | 宋瑶, 刘俊. 改进U-Net的新冠肺炎图像分割方法[J]. 计算机工程与应用, 2021, 57(19): 243-251. (Song Yao, Liu Jun. Improved COVID-19 image segmentation method based on U-Net[J]. Computer Engineering and Applications, 2021, 57(19): 243-251. DOI:10.3778/j.issn.1002-8331.2010-0207) |

| [20] | 施俊, 汪琳琳, 王珊珊, 等. 深度学习在医学影像中的应用综述[J]. 中国图象图形学报, 2020, 25(10): 1953-1981. (Shi Jun, Wang Lin-lin, Wang Shan-shan, et al. A review of deep learning applications in medical imaging[J]. Journal of Image and Graphics, 2020, 25(10): 1953-1981.) |

| [21] | 付顺兵, 王朝斌, 罗建, 等. 基于改进U-Net模型的脑肿瘤MR图像分割[J]. 西华师范大学学报(自然科学版), 2021, 42(2): 202-208. (Fu Shun-bing, Wang Chao-bin, Luo Jian, et al. Brain tumor MR image segmentation based on improved U-NET model[J]. Journal of China West Normal University, 2021, 42(2): 202-208.) |

| [22] | Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. |

| [23] | Szegedy C, Ioffe S, Vanhoucke V, et al. Inception-v4, inception-ResNet and the impact of connections on learning[C]// 31st AAAI Conference on Artificial Intelligence. San Francisco, 2017: 4278-4284. |

| [24] | 张文秀, 朱振才, 张永合, 等. 基于残差块和注意力机制的细胞图像分割方法[J]. 光学学报, 2020, 40(17): 76-83. (Zhang Wen-xiu, Zhu Zhen-cai, Zhang Yong-he, et al. Cell image segmentation method based on residual block and attention mechanism[J]. Acta Optica Sinica, 2020, 40(17): 76-83.) |

| [25] | 易三莉, 陈建亭, 贺建峰. ASR-UNet: 一种基于注意力机制改进的视网膜血管分割算法[J]. 山东大学学报(理学版), 2021, 56(9): 13-20. (Yi San-li, Chen Jian-ting, He Jian-feng. ASR-UNet: an improved retinal vascular segmentation algorithm based on attention mechanism[J]. Journal of Shandong University, 2021, 56(9): 13-20.) |

| [26] | Chen L C, Papandreou G, Schroff F, et al. Rethinking atrous convolution for semantic image segmentation[EB/OL]. [2017-12-05]. https://arxiv.org/pdf/1706.05587.pdf. |

| [27] | Liang J Y, Sun G L, Zhang K, et al. Mutual affine network for spatially variant kernel estimation in blind image super-resolution[C]// IEEE/CVF International Conference on Computer Vision. Montreal, 2021: 4076-4085. |

| [28] | Lin T Y, Dollar P, Girshick R, et al. Feature pyramid networks for object detection[EB/OL]. [2017-04-19]. https://arxiv.org/pdf/1612.03144.pdf. |

| [29] | Zhao H S, Shi J P, Qi X J, et al. Pyramid scene parsing network[C]// IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, 2017: 6230-6239. |

| [30] | Liu S, Qi L, Qin H F, et al. Path aggregation network for instance segmentation[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, 2018: 8759-8768. |

| [31] | Wang G T, Zuluaga M A, Li W Q, et al. DeepIGeoS: a deep interactive geodesic framework for medical image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(7): 1559-1572. |

| [32] | Kitrungrotsakul T, Yutaro I, Lin L, et al. Interactive deep refinement network for medical image segmentation[EB/OL]. [2020-06-27]. https://arxiv.org/pdf/2006.15320v1.pdf. |