, 赵峰禹, 陈枭

, 赵峰禹, 陈枭 东北大学 机器人科学与工程学院,辽宁 沈阳 110169

收稿日期:2022-03-15

基金项目:国家自然科学基金资助项目(U20A20197); 辽宁省重点研发计划项目(2020JH2/10100040)。

作者简介:姜杨(1982-), 男, 辽宁沈阳人, 东北大学副教授。

摘要:为提高多物体抓取检测网络的抓取检测准确率,提出一种基于改进Cascade R-CNN模型的机械臂抓取检测算法.首先,引入ResNeXt结构能够在不加大网络设计难度的前提下提高了模型的准确率;引入带空洞卷积的空间金字塔池化模块以解决分辨率较低的问题;接着对抓取框回归分支和角度分类分支以分治方法进行优化.其次,针对多物体抓取数据集缺乏的问题,构建多目标抓取数据集(multi-object grasping dataset,MOGD),有效地扩充了多物体抓取检测数据集.最后,基于改进Cascade R-CNN模型设计抓取检测网络,实验结果表明,改进后的算法效率更高,PI-Cascade R-CNN实验准确率为93%,较Cascade R-CNN提升1.5个百分点.

关键词:抓取检测空洞卷积Cascade R-CNN多物体检测机器人抓取

Research on Robotic Grasping Detection Based on Improved Cascade R-CNN Model

JIANG Yang

, ZHAO Feng-yu, CHEN Xiao

, ZHAO Feng-yu, CHEN Xiao School of Robotics & Engineering, Northeastern University, Shenyang 110169, China

Corresponding author: JIANG Yang, E-mail: beyond821015@163.com.

Abstract: In order to improve the grasping detection accuracy of the multi-object grasping detection network, a robotic arm grasping detection algorithm based on the improved Cascade R-CNN model is proposed. Firstly, the introduction of the ResNeXt structure can improve the accuracy of the model without increasing the difficulty of network design. The atrous spatial pyramid pooling module is introduced to solve the problem of low resolution. Then, the grasping box regression branch and the angle classification branch are optimized by the divide and conquer method. Secondly, aiming at the lack of multi-object grasping datasets, a multi-object grasping dataset (MOGD) is constructed, which effectively expands the multi-object grasping detection dataset. Finally, a grasping detection network is designed based on the improved Cascade R-CNN model. The experimental results show that the improved algorithm is more efficient. The experimental accuracy of the PI-Cascade R-CNN is 93 %, which is 1.5 percentage higher than that of the Cascade R-CNN.

Key words: grasping detectionatrous convolutionCascade R-CNNmulti-object detectionrobotic grasping

基于视觉的机器人抓取技术已经成为当前机器人行业研究的重点方向,广泛应用于装配、分拣和码垛等应用场景.抓取检测是指通过视觉传感器获取信息,精确、快速地检测出目标物体的抓取框信息,然后机器人通过抓取框找到抓取的中心位置来抓取目标物体.

滑动窗口检测法常用于候选区域的生成[1-3].其具体操作是使用滑动窗口方法从1幅图像中提取多个图像块,然后依次输入深度神经网络来预测每个图像块的抓取姿态.最后,选取检测置信度最高的预测抓取位姿来完成抓取检测[4].

用于感知机器人抓取环境的传感器通常是RGB相机,其关键任务是获取环境的二维图像信息,然后通过抓取检测算法分析计算得出环境目标在图像空间中的抓取信息,并将图像空间中的抓取位置映射到机械臂下的真实坐标中,由于后续抓取过程是否成功取决于此步骤中计算出的坐标,因此这一步是执行抓取任务的关键步骤.最后,将计算出的真实坐标转换为机器人手臂末端夹爪的位置和姿态,以抵达目标抓取位置完成机器人抓取工作[5-9].上述文献多是基于康奈尔数据集进行单目标抓取检测.文献[10-11]的研究也大多集中于单目标图像抓取位姿预测,缺乏对多目标场景的考虑.

文献[12-16]研究了关于深度学习所具备的自主学习图像特征的能力.文献[17-19]主要是关于目标检测方面的研究,都取得了许多突出成果.Lenz等[1]进行了一项工作量巨大的深度抓取检测工作:将生成的许多大小、位置和方位不同的矩形候选输入到卷积神经网络中进行分类评估,取其中得分最高的候选作为最终抓取检测结果.然而其缺点在于,使用如此多的图像块来预测抓取姿势的滑动窗口检测法是非常耗时.为了提高抓取检测速度,Redmon和Angelova采用了一种使图像一次性通过网络的单级回归方法来直接预测抓取包围盒[20].

Park等[21]提出了一种网络,首先网络对具有一定位置和方向的图像块进行裁剪,然后送入抓取分类器进行抓取可信度判断.最后,利用最大集合选择最佳抓取姿势.Asif等[22]采用目标检测方法预测目标对象的位姿,进而估计出每个图像中物体的抓取姿态.这些工作可以预测杂乱场景中物体的姿态.

1 Cascade R-CNN基于深度学习的目标检测算法常分为一阶段算法和二阶段算法,存在3种代表性的卷积神经网络的目标检测算法,分别是R-CNN[17],Fast R-CNN[18]和Faster R-CNN[19].Fast R-CNN[18]将提取目标的方法替换成网络训练来提取,检测速度比之前大幅提升.

Faster R-CNN中使用IoU(intersection over union)阈值区分不同的anchor来生成Proposal,一般取0.5区分前景和背景,如果IoU阈值选取较高,会导致模型过拟合,并且采用单一阈值,也会出现不匹配的问题,阈值越高,该问题越明显;在不同的IoU阈值挑选Proposal时,越接近该阈值的Proposal在回归之后其IoU阈值越大,即Proposal的质量会越高.

级联式网络Cascade R-CNN能解决检测器不能准确地将检测框与目标物体匹配,导致漏检或误检,从而降低检测结果的准确率的问题[23],由Faster R-CNN第一阶段RPN(region proposal network)提供低质量Proposal给下一层回归网络,由于IoU普遍较小,所以采用低阈值更符合Proposal的分布,发挥该阶段模型的性能,提供高质量的Proposal给下一阶段,Cascade R-CNN对每个阶段的IoU进行优化[23].该方法也显著减少了计算时间,提高了检测精度.考虑到这些优点,本文将Cascade R-CNN作为抓取检测的基本网络框架.

针对机器人多物体抓取检测研究问题,选用Cascade R-CNN为基础网络框架,Cascade R-CNN是通用目标检测中表现较好的一种级联网络,其特点是速度快、检测精度高.但是直接使用Cascade R-CNN本身的框架训练抓取数据集不能得到很好的检测效果,其原因主要包括:

1) 当前公开的多目标抓取数据集较少,即缺少验证机器人多物体抓取检测的数据集.

2) Cascade R-CNN中的默认超参数是针对通用目标检测设计的,并不利于抓取框检测.

3) Cascade R-CNN的主干网络采用ResNet,但是进行抓取框预测需要较高的模型准确率.虽然使用ResNet网络可以通过加深或者加宽网络来提高模型的准确率,但是这样会造成网络参数的数量增加,也会造成网络计算成本增加.

4) 由于Cascade R-CNN检测器部分为全连接层,全连接层在神经网络中起的是分类器的作用,但是对回归起不到很好的帮助.Cascade R-CNN为级联网络,当IoU阈值为0.5~0.7的框进入第三阶段时,会被当作负样本(和背景框一同)处理,那么这些框的分数会被打低,这就造成第一阶段和第三阶段处理结果产生较大差异,出现正样本信息缺失问题.

5) 由于抓取数据集中存在一些较小物体,Cascade R-CNN不能满足较小物体的识别,需要有足够的感受野来覆盖到目标物体.

针对上述问题,本文的工作内容如下:

1) 首先构建一个由32类对象组成的多目标抓取数据集(multi-object grasping dataset,MOGD), 解决当前多物体抓取数据集较为缺乏的问题,并便于对多目标抓取检测模型进行评估.

2) 调整原始Cascade R-CNN的输入尺寸、各检测层检测的调节以及抓取框的生成,使得Cascade R-CNN更好地应用于抓取检测.

3) 引入ResNeXt结构,使网络在不增加参数复杂度的前提下来提高准确率.

4) 将角度分类分支以及抓取框回归分支分治实现,全连接层更适合应用于角度分类,卷积层更适合用于抓取框回归任务.并用集成共享来解决第三阶段IoU阈值选择不均衡出现的负样本问题,以提高Cascade R-CNN的抓取检测准确率.

5) 加入带空洞卷积的空间金字塔池化(atrous spatial pyramid pooling,ASPP)模块来解决分辨率低的问题,以便提取多尺度信息.

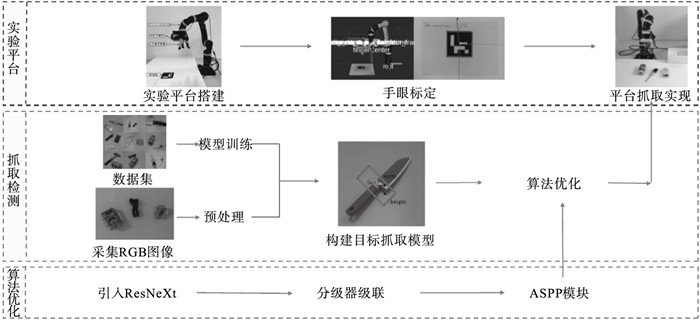

根据上述工作内容,多物体抓取系统总体框架如图 1所示,包括实验平台搭建、抓取检测、网络的算法优化三部分.实验平台包括平台搭建、手眼标定以及平台抓取实现;抓取检测包含数据集制作、数据预处理和网络算法优化.

图 1(Fig. 1)

| 图 1 抓取系统总体框架Fig.1 Overall framework of grabbing system |

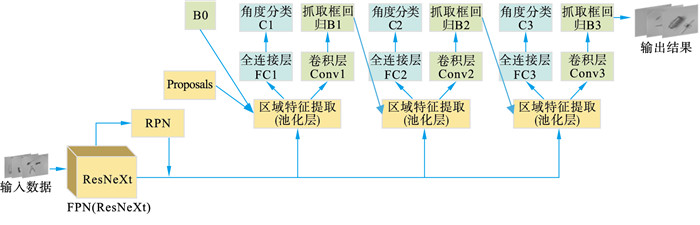

2 PI-Cascade R-CNN模型2.1 PI-Cascade R-CNN抓取检测网络设计本文针对多物体抓取检测提出一种改进Cascade R-CNN的抓取检测模型,将该模型称为PI-Cascade R-CNN,该模型的网络结构如图 2所示.在Cascade R-CNN目标检测算法基础上,本文首先面向抓取检测任务对Cascade R-CNN的超参数设置进行了优化,然后分别引入ResNeXt结构和加入带有空洞卷积的空间金字塔池化模块来进一步提高抓取框检测精度,并将角度分类以及抓取框回归的分治方法应用到抓取检测中;此外还采用集成共享优化了第三阶段的IoU阈值.

图 2(Fig. 2)

| 图 2 PI-Cascade R-CNN网络结构图Fig.2 Network structure of PI-Cascade R-CNN |

具体设计步骤如下:首先将图像输入到PI-Cascade R-CNN的特征提取网络ResNeXt[24]中,然后经过ResNeXt特征提取,针对数据集(MOGD)中包含小目标的物体的情况,加入带空洞卷积的空间金字塔池化(ASPP)模块.空洞卷积作用是扩大感受野以及捕获多尺度信息,可以获得较大的分辨率图,对提升小目标物体检测帮助很大,在特征融合过程对浅层特征图下采样,再与深层特征图进行融合,在特征融合后每一层输出的特征图进行由深到浅的多尺度特征融合,减少了特征丢失,对小目标物体可以很好地识别.为得到抓取候选框,将融合后的特征图输入到RPN(区域建议网络).经RPN得到抓取候选框后,进入添加角度分类以及抓取框回归的特征共享机制的级联检测器中,一共包含3个检测器,每个支路的检测器中包含池化(Pool)层、全连接层(FC)、角度分类(旋转角C)以及抓取框回归(B);通过Pool层统一尺寸后进行融合,然后输入全连接层进行旋转角评估以及抓取框回归,最终提取出最优抓取检测框.

PI-Cascade R-CNN的网络结构如图 2所示,其中本文在回归分支中用卷积替代之前的全连接层.图中B0,B1,B2表示候选边界框,最终输出的B3表示预测抓取框;本文将回归分支和分类分支单独拆分开处理;采用集成共享对第三阶段IoU阈值进行优化.

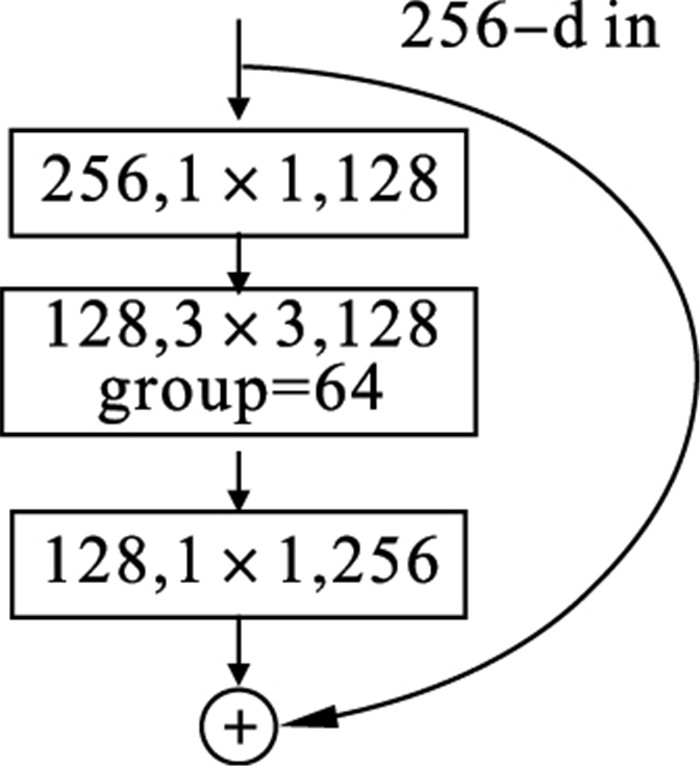

2.2 ResNeXt结构ResNeXt结构整合了VGG(visual geometry group)网络的堆叠思想和Inception中的拆分-转换-合并的策略.ResNeXt采用平行堆叠相同拓扑结构(blocks)替换原来ResNet的三层卷积的block,可以提升模型的准确率,但不会明显增加参数量级,拓扑结构也没有很大改变,不仅超参数减少了,而且模型的移植性也提高了[24].

因此,在PI-Cascade R-CNN中采用ResNeXt特征网络,图像直接输入到ResNeXt50特征提取网络中,通过卷积核进行特征提取(添加带空洞卷积的空间金字塔池化模块将在2.4节描述),然后ResNeXt网络复制浅层网络输出与深层网络输出的元素相加得到下一层的输出.

ResNeXt残差结构如图 3所示,物体图像以RGB形式输入ResNeXt网络,输入为256维,首先通过1×1卷积核将输入的256个通道分成128个通道的低维张量;然后选择分支数目为64,经过3×3的卷积核进行特征提取;最后需要转换数据,对所有的分支使用1×1卷积将输出的通道数从128维增加到256维,对64个256维的张量求和,依然和输入保持相同大小.

图 3(Fig. 3)

| 图 3 ResNeXt的残差结构Fig.3 Residual structure of ResNeXt |

ResNeXt残差结构,具有许多相同分支的模块,每个分支将输入进行通道裁剪,然后通过3×3卷积进行转换,最后将结果进行合并.

2.3 分治分类和回归支路全连接层在神经网络中主要起分类器的作用,但是对回归缺少帮助,所以全连接层更适合角度分类应用,卷积层更适合用于抓取框回归任务,针对此问题利用分治的方法进行解决.

将分治对象按照自身抓取检测的设定,分别对应基于R-CNN的头部检测器角度分类分支以及抓取框回归分支;对于回归网络本文选用卷积来代替之前的全连接层;将抓取检测转化为目标定位加上角度分类问题,将各物体抓取框与水平方向的夹角转化成19个类别,所以引申出抓取框回归分支和角度分类分支.

本文将回归分支和分类分支单独拆分开,分别实现回归和分类.PI-Cascade R-CNN网络级联形式如图 2所示,其中池化将候选区的特征池化为固定大小, 在回归分支中用卷积替代之前的全连接层.图中B0,B1,B2表示候选抓取框,最终输出的B3表示预测抓取框;FC1,FC2和FC3表示角度分类分支的全连接层; C1和C2表示角度预测分类结果,C3是最终角度预测分类结果; Conv1,Conv2和Conv3是卷积层,经过2个卷积层和1个平均池化层进行边界框的回归.

Cascade R-CNN中提出了级联网络,每个阶段都有一个不同的IoU阈值,Cascade R-CNN使用Cascade回归作为一种重采样的机制,逐级提高Proposal的IoU阈值,从而使得前一个阶段重新采样过的Proposals能够适应下一个有更高阈值的stage[23].

Cascade R-CNN级联网络主要针对三个阶段判定正负样本的输入IoU阈值,三个阶段的检测器输入的IoU阈值不同,每个检测器是递进关系,如果单独用Cascade R-CNN中的第三阶段IoU在0.5~0.7进行处理时,会被当作负样本(和背景框一同)处理,那么这些框的分数会被打低,这就导致了第一阶段和第三阶段之间的差距[24].

针对这一问题本文使用集成共享的方法对第三阶段的IoU阈值进行优化,将第三阶段的IoU阈值变为三个阶段的集成共享后的结果,这样可以减少正样本被当成负样本的情况,提高Cascade R-CNN的抓取检测准确率.

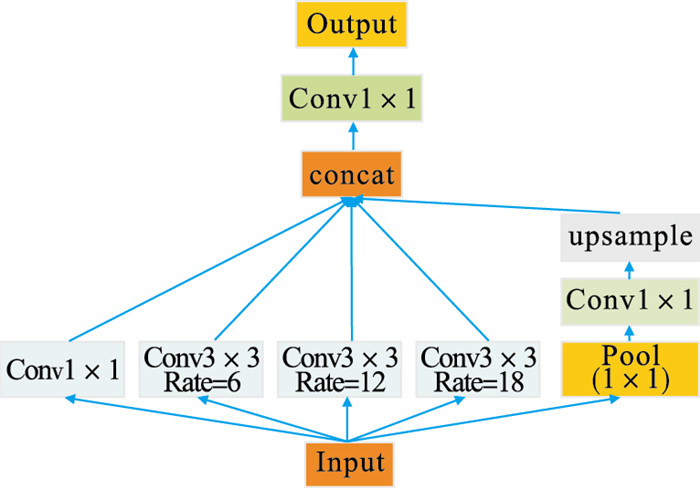

2.4 带空洞卷积的空间金字塔池化模块多目标抓取数据集(MOGD)中包含较小物体,这就要求网络有足够的感受野来覆盖到目标物体.在ResNeXt特征融合过程中,加入带空洞卷积的空间金字塔池化模块.该过程对浅层特征图进行上采样,与降维后深层特征图融合,以减少特征丢失.与普通卷积相比,空洞卷积多出了空洞率为Rate的参数,其中Rate控制感受野的大小,Rate越大感受野越大.

ASPP模块不仅可以扩大感受野,而且不影响图像的分辨率以及不增加额外计算量.因此,针对于不同尺度目标对应感受野的不同,本文将三种不同空洞率的空洞卷积进行并联,然后经过上采样,这样可获取目标周边不同范围、不同大小的信息.不同的空洞卷积的空间率不相同,这样卷积后就保留感受野范围不同的特征,有效提高模型对不同尺度目标的感知能力.ASPP模块未改变特征图的大小,同时感受野范围随之控制,有利于提取多尺度信息,如图 4所示.

图 4(Fig. 4)

| 图 4 ASPP分类器模块Fig.4 ASPP classifier module |

该模块主要包含以下几个部分[25]:

全局平均池化层得到image-level特征,进行卷积(卷积核为1×1),然后双线性插值到原始大小;一个1×1卷积层,还有三个3×3的空洞卷积;通过多渠道维度融合将5个不同尺度的特征融合到一起,送入卷积(卷积核为1×1)进行融合输出.

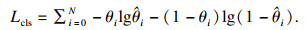

2.5 损失函数参数预测网络需要对抓取框的角度和位置信息进行预测.对于角度预测采用的是分类方法,采用的损失函数是交叉熵,记为Lcls.假设每个输入图像包含一个可抓取对象,网络需要预测抓取矩形的方向和位置.方向预测采用分类方法,采用的损失函数是交叉熵损失函数,分类损失表示如下:

| (1) |

对于位置回归损失,采用平方误差表示如下:

| (2) |

要将数据集标签进行归一化处理,但分类损失和回归损失变化范围相差不多,不需要加入平衡系数,同时也减少了超参数的数量.所以最终的损失函数Lall定义为

| (3) |

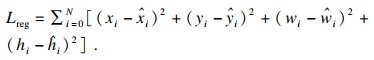

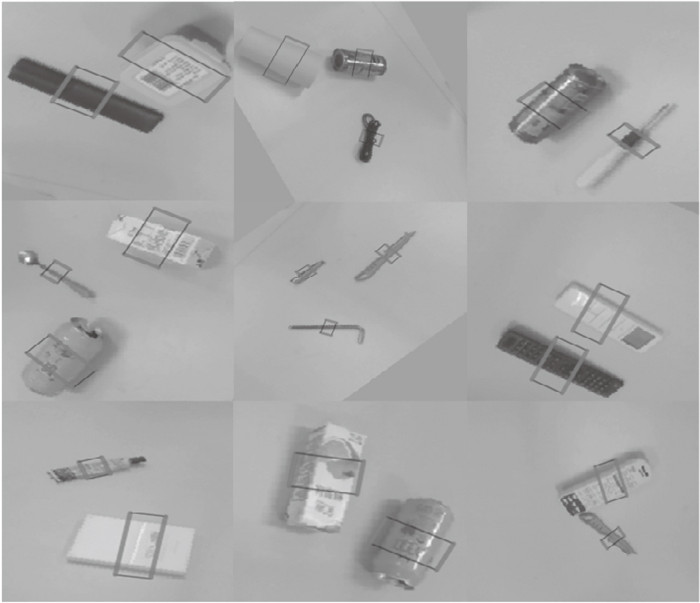

3 数据集给定一个包含多个不同对象的输入图像,正如Lenz等[1]所提出的五参数表征抓取检测,用于真实场景中的机器人抓取.本文重点研究机器人平行板夹持器的二维图像的五维抓取表示.二维图像中的抓取姿态如图 5和式(4)所示.

| (4) |

| 图 5 五维抓取参数Fig.5 Parameters of 5D grasping parameters |

其中:(xg, yg)表示抓取矩形的质心; hg和wg分别代表抓取框矩形的高度及宽度; θg是由抓取宽度hg与图像横轴夹角给出的抓取角度,g表征抓取物体.

对于机器人的二指手抓取配置见式(5),其中G表示一个平面抓取位姿,(x, y)表示机械臂末端在平面中的位置信息,w, h分别表示平行二指手的宽和高,其中θ表示抓取角度,对于机械臂,需要沿水平方向旋转一定的角度到达抓取点.

| (5) |

图 6(Fig. 6)

| 图 6 多目标抓取数据集标注Fig.6 Annotation of the multi-object grasping dataset |

3.2 数据预处理本文制作的多物体抓取数据集(MOGD),由于样本种类和数量等因素限制,数据量达不到大规模数据集的标准,容易导致模型欠拟合,网络无法学习到有效的特征,故采用数据增强的方法解决该问题.通过添加Dropout层防止过拟合,训练过程中Dropout会随机地摒弃部分神经元,可以迫使网络学习更多鲁棒的特征,而不是依赖于部分负责预测功能的子神经元.

1) 数据增强.先将原始640×480图像由中心向四周呈正方形裁剪,这样可以确保待抓取物体完整地保留,得到351×351图像,然后向四周进行扩充75像素,采用opencv中的replicate模式,得到501×501图像,然后进行若干像素的沿水平方向和竖直方向的平移,再进行5次180°内随机角度的旋转,最后进行一次图像的resize,得到320×320的图像;由此可以得到相对于原始数据集100倍的增强,去除部分不合理样本后,最终得到训练集45 000个样本,验证集10 000个样本,测试集5 000个样本,每个样本包含RGB图像,对应抓取标注.

2) 抓取框角度分类问题处理.由于抓取角度比位置的敏感度低,即抓取角度可以在一定的阈值内变化,所以可以将抓取角度的预测转换成一个分类问题.具体的转换过程描述如下:对于一个平行二指夹具,抓取平面上的物体,由于夹具的对称性,故夹具在平面上的旋转角度为[0°, 180°],本文根据康奈尔抓取数据集中提供的标签数据,其示意图如图 7所示.

图 7(Fig. 7)

| 图 7 抓取检测问题分解图Fig.7 Decomposition diagram of grasping detection problems |

需要对图像进行resize以及padding,保证物体不发生形变的同时,尽量使物体保持在视野之中,剔除增强后无效的抓取框,采集得到的图像尺寸是640×480,经过增强后的图像尺寸是320×320,最后将生成的样本导入到符合COCO目标检测数据集格式Json文件中,生成的训练集图片45 000张,测试集15 000张,每个样本包含抓取框,默认所有的样本训练难易程度相同.

经过数据增强以及剔除不可用样本,对于角度预测,将角度预测问题用分类问题来替换,180°均分19个类别.最后,每个样本有1幅RGB图像,1~19的整数标签和位置参数信息为(θ,x,y,w,h).

3.3 训练采用COCO数据集的预训练模型初始化模型参数以及4块GPU并行训练,模型epoch的选取如下:当模型epoch选择超过20时,模型准确率不再提升,故设置epoch值为20,设置batchsize为64,由于数据集中可能会有相似样本,所以优化器采用SGD,SGD一次只进行一次更新,没有冗余,速度较快,并且可以新增样本.学习率是将输出误差反向传播给网络参数,以此来拟合样本的输出.学习率的选择对于最优化的效果至关重要,根据初始学习率训练,观察测试效果,最终设置学习率0.02,设置动量参数为0.9.

3.4 评估指标本文主要研究机械臂的多物体抓取问题,这种机器人抓取的评价指标有两种:点度量和矩度量.点度量[26-27]通过权衡预测抓取框中心和标签抓取框中心之间的距离来评估抓取.

由Jiang等[28]提出的矩度量,目前抓取评估多采用矩度量,同时使用抓取角度和Jaccard指数标准对机器人抓取进行评估.当候选抓取配置满足下面详细描述的两个标准时,该候选抓取配置被认为是有效的.

1) 预测的抓取框角度与有效的抓取框角度之差在30°以内.

2) 预测的抓取框Ap和真值At之间Jaccard指数大于25%,Jaccard指数按式(6)计算:

| (6) |

4 抓取检测结果及分析在多物体抓取数据集(MOGD)上进行对比实验以及消融实验,验证所提创新点的有效性. 实验服务器运行环境如下.

操作系统:Ubuntu MATE16.04;

CPU:Intel(R) Xeon(R) CPU E5-2620 v4@2.10 GHz;

GPU:Titan X;

Python版本:3.6.7;

Torch版本:1.1.0.

4.1 利用Cascade R-CNN抓取检测算法对多目标抓取数据集进行检测在对提出的算法进行评估时,检测Head部分采用RPNHead,用来生成高质量的Proposal.损失函数采用交叉熵评估分类性能,均方差评估回归性能.采用在COCO数据集的预训练模型初始化模型参数,完整的训练过程和测试代码构建在Pytorch上.

在MOGD上的检测结果如表 1所示,其中“R”表示改进backbone,引入ResNeXt结构,“J”表示带有空洞卷积的空间金字塔池化模块,“F”表示加入集成共享分治分类和回归支路.由于空洞卷积“J”是在ResNeXt结构上添加的,所以只有ResNeXt结构上有空洞卷积.

表 1(Table 1)

| 表 1 多目标抓取检测算法的性能 Table 1 Perfermance of multi-object grasping detection algorithm |

为了验证本文所提出的多物体抓取检测算法对于添加不同改进策略的性能提升,设置了分别采用6种算法的实验对照组.对照组的训练配置、参数基本与PI-Cascade R-CNN一致,包括数据集、主干网络、优化器、损失函数等.

实验结果如表 1所示,其中PI-Cascade R-CNN是本文针对多目标抓取检测的Cascade R-CNN改进模型,PI-Cascade R-CNN与Cascade R-CNN相比整体提升1.5个百分点.测试实验结果表明,本文提出的改进方法在抓取检测问题上改进效果较好.基于PI-Cascade R-CNN的抓取检测算法在多目标抓取数据集上取得93%的平均预测准确率,相对于基础网络Faster R-CNN和Cascade R-CNN原网络均有提升.

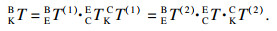

多目标抓取检测算法结果如图 8所示.基于PI-Cascade R-CNN的多物体抓取检测算法在抓取检测方面有较强的适应性,可以预测出抓取框对应的位置信息和旋转角度信息,证明本文提出的多物体抓取检测算法的有效性.

图 8(Fig. 8)

| 图 8 多目标抓取检测算法结果Fig.8 Result of the multi-object grasping detection algorithm |

4.2 基于Kinova机械臂进行抓取平台的搭建4.2.1 实验平台搭建本地Kinova机器臂控制平台环境如下:

操作系统:Ubuntu 16.04;

CPU:Intel(R) Core(TM) i5-10400 CPU@2.90 GHz;

硬件:Kinova mico2六自由度机械臂、Realsense D435相机.

4.2.2 手眼标定本文采用开源项目easy_hand/eye[29]完成eye-in-hand手眼标定.相机固定于机器臂末端,定义如下坐标系:机械臂基坐标系为B,机械臂末端关节坐标系为E,相机坐标系为C,标定板坐标系为K,EBT表示机械臂末端关节坐标系相对于机械臂基坐标系的转换,CET表示相机坐标系相对于机械臂末端关节坐标系的转换,该参数在相机安装完成后是固定值,KCT表示标定板坐标系相对于相机坐标系的转换,KBT表示标定板坐标系相对于机械臂基坐标系的转换.标定过程中,保持标定板位置的固定,采用自动或者手动方式调整相机位姿,对于不同的采样点,则有

| (7) |

| (8) |

| (9) |

| (10) |

| (11) |

| (12) |

4.2.3 相机标定相机内参数标定采用张正友标定法,在Ubuntu16.04下完成Realsense D435安装驱动,在ros下启动相机,安装开源相机标定工具Kalibr,标定板采用6×7比例,尺寸为0.029 m×0.029 m的黑白棋盘格,通过标定工具中的rosbag录制标定数据,最后通过标定程序完成标定.

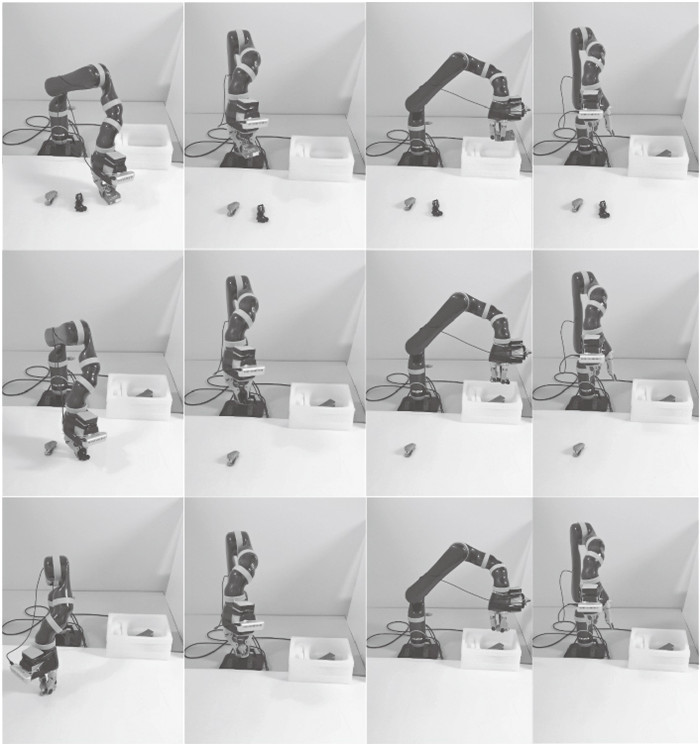

4.3 基于PI-Cascade R-CNN抓取检测算法对多目标抓取数据集进行抓取实验根据机器臂抓取物体个数的不同,本文分别设置单个物体抓取,多个物体抓取.抓取实验设置Cascade R-CNN及PI-Cascade R-CNN两组分别在单目标和多目标场景下进行对比验证.

第一组实验,针对单目标场景,进行150组抓取实验,实验过程中,机械臂能够夹取到物体且保持一定时间,则统计为成功.第二组实验,针对多目标场景,随机选择2至3种物体正放于桌面,物体之间彼此不接触,机器臂需要根据抓取检测的结果进行顺序抓取.抓取成功与否判定标准同上,共进行150次抓取实验.

图 9为实际抓取过程.实验过程中,统计每个物体的抓取次数、抓取成功次数以及平均抓取成功率,最终对比实验结果记录于表 2中.

图 9(Fig. 9)

| 图 9 多目标场景下物体抓取实验Fig.9 Grasping experiment under the multi-object scene |

表 2(Table 2)

| 表 2 改进前后抓取实验结果对照 Table 2 Comparison of grasping experimental results before and after improvement |

根据抓取实验统计表 2数据对比可知,本文的PI-Cascade R-CNN算法在单目标场景下抓取成功率为96.6%,多目标场景下抓取成功率为90.6%.相较于Cascade R-CNN算法,本文算法具有较高的成功率.实验结果证明了本文提出的多物体抓取检测算法的有效性,同时在进行抓取实验的过程中,一些与训练数据集较为相似的物体,抓取检测系统也能够预测出合理的抓取位姿,表现出网络的泛化性能.

5 结语本文提出了一种基于Cascade R-CNN改进算法的多目标抓取检测模型.在深度神经网络中引入了具有平行堆叠相同拓扑结构的ResNeXt网络,有效地提升模型的准确率并且不会增加网络参数量级.对角度分类分支和抓取框回归分支进行拆分优化,并针对Cascade R-CNN网络第三阶段的IoU阈值不匹配造成负样本问题采用集成共享方式进行改善.引入带空洞卷积的空间金字塔池化模块来解决分辨率低的问题,可以在不改变特征图大小的同时控制感受野,以便于提取多尺度信息.

综上所述,本文提出的算法可以很好地完成抓取检测任务.实验验证本文提出的模型在多目标抓取数据集的抓取检测中,具有较高的效率和准确率.未来将在堆叠环境和识别物体信息分类问题上进行深度研究.

参考文献

| [1] | Lenz I, Lee H, Saxena A. Deep learning for detecting robotic grasps[J]. The International Journal of Robotics Research, 2015, 34(4/5): 705-724. |

| [2] | Wei J, Liu H, Yan G, et al. Robotic grasping recognition using multi-modal deep extreme learning machine[J]. Multidimensional Systems and Signal Processing, 2017, 28(3): 817-833. DOI:10.1007/s11045-016-0389-0 |

| [3] | Wang Z, Li Z, Wang B, et al. Robot grasp detection using multimodal deep convolutional neural networks[J]. Advances in Mechanical Engineering, 2016, 8(9): 1687814016668077. |

| [4] | 李秀智, 李家豪, 张祥银, 等. 基于深度学习的机器人最优抓取姿态检测方法[J]. 仪器仪表学报, 2020, 41(5): 108-117. (Li Xiu-zhi, Li Jia-hao, Zhang Xiang-yin, et al. Robot optimal grasping posture detection method based on deep learning[J]. Instruments Journal, 2020, 41(5): 108-117.) |

| [5] | 崔少伟, 魏俊杭, 王睿, 等. 基于视触融合的机器人抓取滑动检测[J]. 华中科技大学学报(自然科学版), 2020, 48(1): 98-102. (Cui Shao-wei, Wei Jun-hang, Wang Rui, et al. Robot grasping sliding detection based on visual-tactile fusion[J]. Journal of Huazhong University of Science and Technology (Natural Science Edition), 2020, 48(1): 98-102.) |

| [6] | 伍广彬. 基于领域自适应学习的机器人多目标物体抓取识别算法研究[D]. 哈尔滨: 哈尔滨工业大学, 2021. (Wu Guang-bin. Research on robot multi-target object grasping recognition algorithm based on domain adaptive learning[D]. Harbin : Harbin Institute of Technology, 2021. ) |

| [7] | Guo D, Sun F, Liu H, et al. A hybrid deep architecture for robotic grasp detection[C]//2017 IEEE International Conference on Robotics and Automation(ICRA). Singapore: IEEE, 2017: 1609-1614. |

| [8] | 夏晶, 钱堃, 马旭东, 等. 基于级联卷积神经网络的机器人平面抓取位姿快速检测[J]. 机器人, 2018, 40(6): 794-802. (Xia Jing, Qian Kun, Ma Xu-dong, et al. Rapid detection of robot plane grasping pose based on cascaded convolutional neural network[J]. Robot, 2018, 40(6): 794-802.) |

| [9] | 喻群超, 尚伟伟, 张驰. 基于三级卷积神经网络的物体抓取检测[J]. 机器人, 2018, 40(5): 762-768. (Yu Qun-chao, Shang Wei-wei, Zhang Chi. Object grasping detection based on three-level convolutional neural network[J]. Robot, 2018, 40(5): 762-768.) |

| [10] | Depierre A, Dellandréa E, Chen L. Jacquard: a large scale dataset for robotic grasp detection[C]//2018 IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS). Madrid, Spain: IEEE, 2018: 3511-3516. |

| [11] | Morrison D, Corke P, Leitner J. Learning robust, real-time, reactive robotic grasping[J]. The International Journal of Robotics Research, 2020, 39(2/3): 183-201. |

| [12] | Saxena A, Driemeyer J, Ng A Y. Robotic grasping of novel objects using vision[J]. The International Journal of Robotics Research, 2008, 27(2): 157-173. DOI:10.1177/0278364907087172 |

| [13] | Le Q V, Kamm D, Kara A F, et al. Learning to grasp objects with multiple contact points[C]//2010 IEEE International Conference on Robotics and Automation. Anchorage: IEEE, 2010: 5062-5069. |

| [14] | Wang P, Ye F, Chen X, et al. Datanet: deep learning based encrypted network traffic classification in SDN home gateway[J]. IEEE Access, 2018, 6: 55380-55391. |

| [15] | Deng Y, Ren Z, Kong Y, et al. A hierarchical fused fuzzy deep neural network for data classification[J]. IEEE Transactions on Fuzzy Systems, 2016, 25(4): 1006-1012. |

| [16] | Wang K, Zhang D, Li Y, et al. Cost-effective active learning for deep image classification[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2016, 27(12): 2591-2600. |

| [17] | Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Columbus, 2014: 580-587. |

| [18] | Girshick R. Fast R-CNN[C]//Proceedings of the IEEE International Conference on Computer Vision. Santiago, 2015: 1440-1448. |

| [19] | Ren S, He K, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(6): 1137-1149. |

| [20] | Redmon J, Angelova A. Real-time grasp detection using convolutional neural networks[C]//2015 IEEE International Conference on Robotics and Automation(ICRA). Seattle, WA: IEEE, 2015: 1316-1322. |

| [21] | Park D, Chun S Y. Classification based grasp detection using spatial transformer network[J]. arXiv Preprint arXiv: 1803. 01356, 2018. |

| [22] | Asif U, Tang J, Harrer S. GraspNet: an efficient convolutional neural network for real-time grasp detection for low-powered devices[C]//International Joint Conference on Artificial Intelligence. Stockholm: CVPR, 2018: 4875-4882. |

| [23] | Cai Z, Vasconcelos N. Cascade R-CNN: delving into high quality object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: CVPR, 2018: 6154-6162. |

| [24] | Li A, Yang X, Zhang C. Rethinking classification and localization for cascade R-CNN[J]. arXiv Preprint arXiv: 1907. 11914, 2019. |

| [25] | Chen L C, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[J]. arXiv Preprint arXiv: 1412. 7062, 2014. |

| [26] | Xie S, Girshick R, Dollár P, et al. Aggregated residual transformations for deep neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, 2017: 1492-1500. |

| [27] | Saxena A, Driemeyer J, Kearns J, et al. Robotic grasping of novel objects[C]//Proceedings of the 19th International Conference on Neural Information Processing Systems. Vancouver, 2006: 1209-1216. |

| [28] | Jiang Y, Moseson S, Saxena A. Efficient grasping from RGBD images: learning using a new rectangle representation[C]//2011 IEEE International Conference on Robotics and Automation. Shanghai: IEEE, 2011: 3304-3311. |

| [29] | Tsai R Y, Lenz R K. A new technique for fully autonomous and efficient 3D robotics hand/eye calibration[J]. IEEE Transactions on Robotics and Automation, 1989, 5(3): 345-358. |