, 肖倩倩, 徐赛

, 肖倩倩, 徐赛 东北大学 计算机科学与工程学院,辽宁 沈阳 110169

收稿日期:2021-12-27

基金项目:中央高校基本科研业务费专项资金资助项目(N2116015,N2116020);辽宁省医工交叉基金资助项目(2021-YGJC-24);国家自然科学基金资助项目(62071134)。

作者简介:耿蓉(1979-),女,辽宁沈阳人,东北大学副教授,博士。

摘要:为了有效地提高天基信息网中的资源利用效率, 提出了一种基于改进GRU(gated recurrent unit)算法的天基信息网资源预测模型.首先,提出递阶式三级架构的资源预测框架来解决天基环境长时延的问题;然后,采用Adam优化器优化GRU网络的学习速率;最后,引入Dropout技术解决网络中存在的过拟合问题.实验仿真了不同预测模型下对各种天基资源的预测,同时对比不同优化器作用下GRU模型的预测准确率,结果表明,基于改进GRU网络的资源预测模型具有更好的性能.

关键词:天基信息网资源预测GRU网络Adam优化器Dropout技术

Research on Resource Prediction of Space-based Information Network Based on Improved GRU Algorithm

GENG Rong, WU Ya-qian

, XIAO Qian-qian, XU Sai

, XIAO Qian-qian, XU Sai School of Computer Science & Engineering, Northeastern University, Shenyang 110169, China

Corresponding author: WU Ya-qian, E-mail: 2656614943@qq.com.

Abstract: In orde to improve the resource utilization of space-based information metwork efficiency, a resource prediction model of space-based information network was presented based on the improved GRU (gated recurrent unit) algorithm. Firstly, a hierarchical three-level resource prediction framework was proposed to solve the problem of long delay in space-based environment. Then, Adam optimizer was used to optimize the learning rate of GRU network. Finally, Dropout technology was introduced to solve the over-fitting problem in the network. The experiments simulated the prediction of various space-based resources under different prediction models, and compared the prediction accuracy of GRU model under different optimizers. The results show that the resource prediction model based on improved GRU network has better performance.

Key words: space-based information networkresource predictionGRU (gated recurrent unit) networkAdam optimizerDropout technology

随着航天技术的深入发展及其应用领域的不断扩展,太空已成为世界各国关注的焦点,能否有效地预测并利用太空资源关乎国家的利益与安全[1].未来,各个国家基础性信息服务如军民航空、教育与医疗、工业与农业、地理环境勘测等均将在空间的各个维度上进行布局,单一空间维度所能提供的信息服务势必无法满足人民日益增长的各种需求[2].有效地协调与调度天基信息网中各维度的信息数据,使各维度资源互联互通、深度联合,能够满足大量任务需求,实现网络中各种资源的合理调配与充分共享[3].实时地预测天基信息网中资源的使用情况,能够为用户提供直观的各种资源预测数据,并且还能够及时地发现资源使用的异常状态,以实现天基信息网中各种资源的负载均衡与资源利用率最大化,同时还在一定程度上降低了资源预测系统对整个系统的影响,从而使得天基信息网能够为用户提供更加安全、稳定与可靠的服务.

资源预测技术已经被广泛应用于各个领域,如软件的配置与优化、模型性能评估等,同时也是进行任务调度、负载均衡、网络分析与异常检测等诸多重要操作的基础[4-6].但是,目前国内外关于资源预测技术的研究大多数都是针对云计算环境的.

针对用户与云网络的交互在时间和空间维度上具有很高的可变性,并且传统的线性预测模型无法有效预测海量倍增及云计算数据复杂度非线性变化的云计算资源.Peng等[7]提出了一种新的云负载预测模型,将混合鲸优化器(hybrid whale optimization algorithm,HWOA)和极限学习机(extreme learning machine,ELM)结合在一起,有效地解决了传统线性模型的弊端.

针对云计算环境下多变量工作负载机制,Ouhame等[8]提出一种适用于对不规则趋势的时间信息进行分析的卷积神经网络和长短期记忆模型(convolutional neural networks-long short-term memory,CNN-LSTM),用于预测中央处理器、内存和网络使用情况.

针对云计算环境下各类资源都聚集在云端,如何解决高能耗问题已成为首要的研究目标,Engl?nder等[9]针对此问题提出了一种对云平台进行能耗管理与监控的系统架构,根据数据采集模块收集到的能源与虚拟机运行状态数据,为平台中的三大高能耗组件构建数学分析模型,进而为制定低能耗的监控策略提供数据支持.Phung等[10]研究了利用黑盒方式来对虚拟机的功率进行监控的可行性问题,该方式能够自动屏蔽虚拟机内部复杂的内存结构,进行虚拟机粒度的功率使用估计.

尽管现阶段预测技术发展趋于成熟,但预测精度仍存在一定挑战,诸多****为此展开研究[11-18].Kumar等[13]提出了一种通过计算预测中的偏差来捕捉预测误差趋势的预测方法(self directed workload forecasting,SDWF),并将其应用于提高进一步预测的准确性.Kumar等[14]使用长短期记忆(long short-term memory,LSTM)网络模型对云系统的负载资源进行中长期时间序列预测,并取得了一定的效果.Cheng等[15]则使用门控循环单元(gated recurrent unit,GRU)与平滑指数的混合模型来预测CPU的使用情况,实验的预测误差相比于单一模型要低.Adhikari等[16]提出了一种仿真方法解决了生成一个透明和可验证的计算资源使用量预测的问题.针对资源使用情况这类非平稳高随机性的时序信号难以精确预测以及预测模型参数需要手动调整的问题,束文娟等[17]提出了基于变分模态分解的优化GRU神经网络预测模型,以预测未来的资源使用情况.Li等[18]提出了一种结合双向门控循环单元(bi-directional gated recurrent unit,Bi-GRU)和麻雀搜索算法(sparrow search algorithm,SSA)来提高预测精度的新框架.

天基环境下资源有限,资源覆盖面广、动态特征多、链路误码率大、时延较长,而现有的资源预测手段无法适应天基信息网资源预测的需求,因此,本文针对现存的问题深入研究并给出解决方案,主要工作如下:

1) 针对天基资源预测实时性差的问题,提出了一种适用于天基环境的递阶式三级架构的资源预测模型.

2) 根据资源预测系统对预测数据的准确性要求较高的问题,应用Dropout技术对GRU模型进行优化,同时引入Adam优化器,获得最优的学习率,以更好地满足天基信息网资源预测的需求.

1 资源预测体系结构及问题描述本文提出的天基信息网资源预测的整体架构如图 1所示.此方案中的资源预测模型采用的是扩展性较强的递阶式三级架构,分为监测节点、预测中心和全局预测中心.该模型很好地适应了天基信息网的高动态性,随着业务的发展需要增加或者卸载节点卫星上的监测组件即可,上面两层无需做任何改动.

图 1(Fig. 1)

| 图 1 资源预测整体架构Fig.1 Overall architecture of resource prediction |

1) 最底层是监测节点层.天基信息网中监测节点对应的物理实体通常为各种卫星或者航天飞行器中的虚拟机.监测节点是整个预测系统的根基,主要负责采集监测对象的各项关键性能指标数据,并将采集到的数据信息发送至预测中心.同时监测节点还具有一定的数据存储能力,将采集到的监测数据根据提前设定好的规则进行存储,以备将来查询和利用.

2) 中间层是预测中心.由于天基信息网处于动态变化中,为了使预测中心节点的选取更具灵活性,卫星内部的任意一个虚拟机节点都可以作为卫星节点,预测中心节点可以获取到网络中监测对象的所有数据信息,并有一定的数据分析处理能力,利用监测节点传来的数据实现资源未来使用情况的预测功能.为了保证资源预测数据显示的实时性,并减少系统本身的资源消耗,本文在全局预测中心和预测中心中使用同样的资源预测模块.除了上述功能外,预测中心还具有数据传输能力,当预测出的资源未来使用情况和监测节点发来的真实值之间的误差超过预先设定的阈值时,就利用真实值对预测模型进行调整[19],将调整后的资源预测模型传送至全局预测中心,更新全局预测中心的预测模型.

3) 最顶层是全局预测中心.该层的主要功能是对预测数据进行实时显示.当没有收到来自预测中心的更新模型时,就利用训练好的模型,基于该节点的历史数据对资源的未来使用情况进行预测并在数据展示界面进行动态显示,在很大程度上减少预测数据的传输,从而减少系统本身带来的资源消耗.

本文所设计的资源预测整体方案如图 2所示.本方案以预测模型的实时性、稳定性以及可靠性为设计目标,适应天基环境的特点,在保证高精度预测的同时,又能在很大程度上降低整个系统的资源消耗.

图 2(Fig. 2)

| 图 2 资源预测整体方案Fig.2 Overall scheme of resource prediction |

2 基于GRU网络的资源预测模型天基信息网中各类资源监测数据呈现典型的非线性和随机性,使用深度学习方法中的循环神经网络模型可以很好地学习到资源数据序列中的各种特性.LSTM是由循环神经网络(recurrent neural network, RNN)优化后获得的[20],通过对网络中的隐藏层架构进行完善改进,使得LSTM网络可以在很大程度上克服传统RNN网络中产生的梯度消失问题,从而使得该网络在进行时间序列预测时表现更佳.但是LSTM网络存在训练耗时长、参数多等缺点,而GRU由LSTM进一步简化而来,可以解决LSTM存在的诸多问题[19-22].本文结合天基信息网特点及资源监测数据进行实验分析,最终选取GRU网络模型作为天基资源预测的核心网络.

2.1 预测模型的设计传统的LSTM网络的细胞核结构如图 3所示.改进后的GRU网络的细胞核结构如图 4所示.

图 3(Fig. 3)

| 图 3 LSTM细胞核结构Fig.3 LSTM cell nucleus structure |

图 4(Fig. 4)

| 图 4 GRU细胞核结构Fig.4 GRU cell nucleus structure |

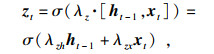

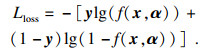

对比图 3和图 4两种网络的细胞核结构发现,与LSTM细胞核结构不同,GRU只有两个门控制结构,分别为重置门和更新门,即图 4中rt和zt.网络将重复细胞单元依次首尾相连接形成链式结构,xt表示输入数据,yt表示输出数据;链式结构中重复的单元称之为GRU网络的细胞核.GRU网络通过每个细胞核中的两个门控制结构来进行相应的运算,实现数据的前向传播,进而实现时间序列预测的功能.该网络的相关表达式如下:

| (1) |

| (2) |

| (3) |

| (4) |

通过上述对GRU网络结构的分析,本文构建的资源预测网络模型如图 5所示.

图 5(Fig. 5)

| 图 5 资源预测网络模型Fig.5 Resource prediction network model |

1) 输入层和输出层.根据前T个时刻各类历史资源监测数据来对下一时刻的资源使用情况进行预测.网络输入连续T个时间段内各类资源的历史监测数据,经过随机打乱后输入到GRU神经网络模型中.输出一维数据值,代表下一时刻该类资源的使用预测值.

2) 隐藏层.2个GRU层和1个全连接层构成了隐藏层.隐藏层的层数和神经元数量越多,模型学习到数据序列里的特征信息越多,预测准确度也会相应地提高,结果会导致整个网络的复杂性急剧上升,从而使训练所需时间也急剧增加.虽然较少的层数和神经元个数使模型结构简单,但是会影响网络的泛化能力,使得模型学习不充分,不能有效掌握数据序列中的各种特征,导致预测精度低、效果差.本文充分考虑资源监测数据的各种特征,将隐藏层中的GRU各层节点数依次设置为80和100,全连接层神经元个数设置为24.

3) 全连接层.全连接层设在隐藏层之后, 功能是将从隐藏层中学习到的所有数据特性加以集成与映射, 并处理大数据的非线性问题,使得模型的拟合效果更好.全连接层的激活函数使用Relu函数, 将神经元总量设置为24,从而实现数据的降维,表达式如(5)所示.

| (5) |

| (6) |

2.2 模型超参数的设置神经网络模型的训练参数包括:隐藏层的层数和神经元个数、每次输入到网络中的数据大小(batch_size)、网络需要执行训练的轮数(epochs)以及网络使用的优化器(optimizer)等.

由于batch_size值会直接影响神经网络模型的训练速度,epochs值可以使网络参数更新和损失函数减小.所以本文通过参考经验数据和实验效果,将batch_size的值设置为64,将epochs的值设置为50. 根据天基信息节点监测数据集的特征以及对比神经网络中常用的4种优化器的作用效果,最终选择在训练时间和精确度上都表现最佳的Adam优化器作为所提出资源预测模型的优化器.

2.3 激活函数的选择本文资源预测模型中使用的GRU网络激活函数的选取方式也有异于传统的神经网络,重置门和更新门选择函数输出取值范围都在[0, 1]的Sigmoid函数作为激活函数;生成候选隐藏状态时使用tanh函数作为激活函数;全连续层中采用Relu函数作为激活函数, 该函数可以有效解决建模中出现的梯度弥散和梯度爆炸问题, 使建模具有更快的参数更新速率和更高的收敛效率.

2.4 模型的训练GRU网络内部采用的是基于时间的前向传播算法, 该算法的具体实现过程:

1) 对历史资源监测数据进行处理,选取合适时间段内的T个时刻的资源使用数据作为模型的输入;

2) 前向传播计算各神经元的输出值rt, zt, ht;

3) 反向传播计算各神经元的误差值τ;

4) 误差项τ通过反向传播传至上一层;

5) 将误差项τ沿时间反向传播,分别计算每个时刻的误差项;

6) 根据计算出的各误差项,进一步得到各神经元的权重梯度;

7) 训练模型直至损失函数Lloss达到最小值;

8) 利用已训练好的资源预测模型对资源未来使用情况进行预测.

前向传播计算各神经元的输出过程如式(1)~ 式(4)及式(7)所示.

| (7) |

| (8) |

| (9) |

| (10) |

| (11) |

| (12) |

| (13) |

| (14) |

| (15) |

| (16) |

| (17) |

| (18) |

| (19) |

| (20) |

| (21) |

| (22) |

| (23) |

| (24) |

| (25) |

| (26) |

| (27) |

| (28) |

3 资源预测模型的优化上述过程构建的基于GRU网络的天基信息网资源预测模型,可以对资源未来使用情况进行预测,但是该网络的预测效果并不能达到天基信息网资源预测系统的性能要求,还需要对构建好的模型进一步优化与完善,使网络具有最优的学习率及较高的准确率,并且能够有效避免过拟合现象的发生.

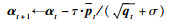

3.1 网络参数的优化在新建的资源预测模型中, 核心网络GRU采用随机梯度下降算法对模型中的各种技术参数进行迭代更新,这样的方式使得网络中的所有参数使用同一个学习速率,而学习速率的选择关系到整个预测模型的收敛速率,决定预测的时效性.为处理该问题,将Adam优化器添加到预测模块中, 代替原有的随机梯度下降算法,并通过Adam优化器降低网络的资源损失函数,并对GRU网络中的各参数进行迭代更新.Adam优化器最突出的特点就是通过选择不同的矩函数,为网络中的各参数设置不同的学习速率,从而使得网络收敛速度得到有效提升[23].

算法1:Adam优化算法

输入:网络训练步长τ,瞬时评估指数衰减率δ, μ∈[0, 1),初始参数向量α,参数为α的随机目标函数F(α)

输出:最优的学习速率αt

BEGIN

1:初始化第一矩矢量p0←0

2:初始化指数加权无限范数q0←0

3:初始化时间步长t←0

4:while αt不收敛时do

5:??更新时间步长t←t+1

6:??在t处获得随机目标的梯度t, λt←▽α∑iL(F(xi, α), yi)

7:??更新有偏第一矩估计pt←δ · pt-1+(1-δ)λt

8:??更新偏置第二原始矩估计qt←μ · qt-1+(1-μ)λt2

9:??计算偏差校正第一矩估计pt← pt/(1-δt)

10:??计算偏差校正第二原始矩估计qt← qt/(1-μt)

11:??更新参数

end while

END

Adam优化算法的具体实现步骤如下:

步骤1:初始化矩阵估计、矩阵估计偏差值与训练步长.

步骤2:计算步长t对应的随机目标的梯度.

步骤3:更新一阶矩阵估计值与二阶矩阵估计值.

步骤4:计算一阶矩阵估计偏差修正值与二阶矩阵估计偏差修正值.

步骤5:更新学习速率.

Adam优化器使得网络各参数不再采用同样的学习率,而是通过计算梯度的一阶与二阶矩阵估计来为网络中的不同训练参数设置合适的学习速率,具体过程如式(29)~式(35)所示.

| (29) |

| (30) |

| (31) |

| (32) |

| (33) |

| (34) |

| (35) |

3.2 过拟合问题的解决方案神经网络随着层数或者各层神经元节点总量的增多,网络中需要训练优化的参数数量也会相应增多, 因此很有可能发生过拟合现象,即所建立的资源预测模型对训练数据集的拟合程度过于准确,而对测试数据集的拟合效果相对较差.具体表现见图 6.

图 6(Fig. 6)

| 图 6 过拟合Fig.6 Overfitting |

为避免这一问题的产生,采用Dropout技术对模型中的全连接层进行优化.通过减小网络中的训练参数来阻止过拟合现象的发生,提高模型的泛化能力,使资源预测模型在测试数据集上也能有较好的拟合效果[21].

Dropout使得网络在迭代的过程中随机地使隐藏层中的某些神经元节点临时失活,每次只更新网络中仍保留活性的部分参数,如此迭代更新直至网络收敛.Dropout技术的实质是使网络中各层之间的连接关系变成一个概率事件,通过调整概率值的大小来控制模型的复杂度.其思想是使神经元节点失活来使所构建的网络模型以更加平等的方式走向最终收敛,让训练得到的资源预测模型在非训练集之外的其他测试数据集上都能具有较好的效果,具有一定的普适性.Dropout的工作原理如图 7所示.

图 7(Fig. 7)

| 图 7 Dropout示意图Fig.7 Dropout schematic diagram (a)—无Dropout的神经网络结构图;(b)—设置Dropout之后的神经网络结构图. |

Dropout技术只在模型训练阶段使用,在模型测试阶段不进行该项操作,测试时所有神经元节点都处于活跃状态.本文所提出的资源预测模型中,Dropout的值设置为0.2,即在每次训练时随机地使80 % 的神经元节点失活.

4 算法仿真与分析本文所有实验均在Windows10的64位操作系统下进行,硬件平台是Intel(R)Core(TM)i5-8250,内存为8.00 GB,程序基于Anaconda3,Spyder及Python3.6进行仿真.所用的资源历史监测数据来自于实验室开发的天基信息网络综合集成仿真验证平台.数据集中包含内存、计算、存储与通信4种资源类型,共采集了2 426条历史监测数据,采集时间为2 426 s,其中前2 126条数据作为训练数据,后300条数据作为测试数据.每次训练时将连续60个时刻的数据作为数据的输入特征,第61个时刻的数据作为标签.

4.1 评价指标本实验用预测时间(t)和预测准确度来对模型的性能进行分析和对比,其中预测准确度从均方误差(MSE)、均方根误差(RMSE)和平均绝对误差(MAE)三个角度进行评估[24-27],三个误差的具体计算方法如下.

1) 均方误差(MSE):

| (36) |

| (37) |

| (38) |

4.2 不同优化器实验对比为了选择一种最适合GRU网络的优化器,分别用Adagrad, SGD, RMSprop和Adam优化后的资源预测模型对同一类资源数据集进行测试.三个损失函数及预测时间作为不同优化器作用下模型预测效果的评价指标.不同优化器的表现效果如表 1所示.

表 1(Table 1)

| 表 1 不同优化器作用下的资源预测模型比较 Table 1 Comparison of resource prediction models under different optimizers |

表 1结果表明,在Adam优化器作用下,所构建的资源预测模型的误差值均小于其他3种优化器,说明采用Adam优化器能够使资源模型的预测精度更高,预测值更接近资源使用真实值.同时模型所需的训练时间均小于其他3种优化器,说明采用Adam优化器使得模型的耗时更少,预测速度更快.

4.3 不同资源预测模型实验对比为了检测该资源预测模型的收敛效果,记录了模型在不同迭代次数(epochs)下所对应的损失函数值.

图 8显示基于改进GRU网络的资源预测模型与对比模型的损失函数在不同迭代次数下的变化情况.其中最大迭代次数为50次,学习速率设置为0.001.结果表明,基于GRU网络的资源预测模型和另外两种常用模型的损失函数值都随着网络迭代次数的增多而逐渐减小,最终趋于稳定.但GRU和LSTM收敛速度较快,表明这两个模型的训练效果较好,在资源预测中均具有很好的性能.

图 8(Fig. 8)

| 图 8 迭代次数与损失函数的关系Fig.8 Relationship between the number of iterations and the loss function |

为了验证该资源预测模型的性能及在天基信息网资源预测领域的先进性,将该模型的预测效果与主流的资源预测模型进行对比实验.

图 9显示基于改进GRU网络的资源预测模型和神经网络模型RNN和LSTM的资源预测情况.结果表明,基于改进GRU的预测模型和LSTM与RNN模型的预测趋势都与资源使用真实值的趋势相同.然而,GRU和LSTM的预测值更接近于真实值,RNN的预测值和真实值之间存在较大的误差,可能是由于RNN中存在梯度消失或梯度爆炸的问题,导致资源预测准确率不高.而且基于改进GRU网络的预测模型在进行资源预测时具有比LSTM模型更好的性能.

图 9(Fig. 9)

| 图 9 内存资源预测结果对比Fig.9 Comparison of memory resource prediction results |

为了更加直观地验证该资源预测模型在各项性能上的优越性,本文计算了不同资源预测模型对应的误差值与预测时间.表 2显示使用不同资源预测模型对同一内存资源数据进行预测的实验效果,模型的性能评估依然采用MSE, RMSE, MAE及t.结果表明,基于改进GRU网络的预测模型的误差值最小,预测耗时最短.说明该模型在对内存资源进行预测时,具有优于其他两种资源预测模型的性能.这是因为GRU网络结构比LSTM更简单,训练时间更短,效率更高.

表 2(Table 2)

| 表 2 不同资源预测模型性能比较 Table 2 Performance comparison of different resource prediction models |

4.4 模型普适性实验由于4.3节所做的实验均是利用资源监测数据集中的内存资源历史监测数据,而在天基信息网资源监测的过程中,所需实时监测的资源对象不仅仅只有这一种,还有计算资源、存储资源、通信资源、导航资源、遥感资源等多种资源对象.为了防止所提出的资源预测模型对单一资源预测结果的偶然性,本节利用基于改进GRU网络的资源预测模型分别对数据集中的计算资源、存储资源和通信资源进行预测,并且与LSTM和RNN两种预测模型分别进行对比.

图 10~图 12分别表示计算资源、存储资源和通信资源的预测结果图.结果表明,对于不同种类的资源监测数据,基于改进GRU网络的资源预测模型的预测结果更接近于真实值,预测曲线更逼近于真实曲线.说明该预测模型在进行资源预测时具有较高的准确性和较强的普适性.

图 10(Fig. 10)

| 图 10 计算资源预测结果对比Fig.10 Comparison of calculation resource prediction results |

图 11(Fig. 11)

| 图 11 存储资源预测结果对比Fig.11 Comparison of storage resource prediction results |

图 12(Fig. 12)

| 图 12 通信资源预测结果对比Fig.12 Comparison of communication resource prediction results |

为了更加直观地分析与观察基于改进GRU网络资源预测模型在不同种类资源数据进行预测时的准确性,分别计算各预测模型进行计算、存储、通信资源预测时的误差,这里仍然采用MSE, RMSE, MAE来对模型的性能进行量化评估,结果如表 3所示.

表 3(Table 3)

| 表 3 不同种类资源预测结果对比 Table 3 Comparison of prediction results of different types of resources |

从表 3中数据可以看出,基于改进GRU网络的资源预测模型的3种误差值均小于另外两种对比模型.说明该算法不仅对内存资源预测时表现较好,而且对常见的计算、存储、通信等资源进行预测时也有较高的预测精度,模型的预测值与真实值的误差均小于其他资源预测模型.

5 结论1) 本文构建了灵活性较强的递阶式三级预测模型架构,全局预测中心基于预测数据进行实时显示,既保证了数据显示的实时性,又降低了本模型的资源消耗.为了确保数据显示的实时性,在预测中心采用与全局预测中心一样的资源预测模块,并将预测数据与真实数据进行比较,判断是否更新全局预测中心的资源预测模型.

2) 为了提高资源预测的准确率,并降低预测所需时间,本文提出了基于改进GRU网络的资源预测模型.为了优化网络的学习速率,缩短网络训练的时间,采用Adam优化器对网络进行优化;对网络中存在的过拟合问题,采用Dropout技术进行解决.对算法进行了仿真分析,从预测准确率、预测所需时间以及模型的普适性等方面验证了算法的有效性.

参考文献

| [1] | Xue K, Meng W, Zhou H, et al. A lightweight and secure group key based handover authentication protocol for the software-defined space information network[J]. IEEE Transactions on Wireless Communications, 2020, 19(6): 3673-3684. DOI:10.1109/TWC.2020.2975781 |

| [2] | 章小宁, 朱立东. 通信与安全一体化的天地异构融合网络体系架构[J]. 天地一体化信息网络, 2020, 1(2): 11-16. (Zhang Xiao-ning, Zhu Li-dong. Communication and security integration of heterogeneous fusion network architecture[J]. Terrestrial Integration Information Network, 2020, 1(2): 11-16.) |

| [3] | Lin J, Cui D, Peng Z, et al. Virtualized resource scheduling in cloud computing environments: an review[C]//2020 IEEE Conference on Telecommunications, Optics and Computer Science(TOCS). Shenyang, 2020: 303-308. |

| [4] | Salinas D, Flunkert V, Gasthaus J, et al. DeepAR: probabilistic forecasting with autoregressive recurrent networks[J]. International Journal of Forecasting, 2020, 36(3): 1181-1191. DOI:10.1016/j.ijforecast.2019.07.001 |

| [5] | Hauser C B, Wesner S. Reviewing cloud monitoring: towards cloud resource profiling[C]//2018 IEEE 11th International Conference on Cloud Computing(CLOUD). San Francisco, 2018: 678-685. |

| [6] | Phung J, Lee Y C, Zomaya A Y. Lightweight power monitoring framework for virtualized computing environments[J]. IEEE Transactions on Computers, 2019, 69(1): 14-25. |

| [7] | Peng H, Wen W S, Tseng M L, et al. A cloud load forecasting model with nonlinear changes using whale optimization algorithm hybrid strategy-extreme learning machine[J]. Soft Computing, 2021, 25(15): 10205-10220. DOI:10.1007/s00500-021-05961-5 |

| [8] | Ouhame S, Hadi Y, Ullah A. An efficient forecasting approach for resource utilization in cloud data center using CNN-LSTM model[J]. Neural Computing and Applications, 2021, 33: 10043-10055. DOI:10.1007/s00521-021-05770-9 |

| [9] | Engl?nder J, Wenger L, Kledzinski Y, et al. A methodology to realize energy-related use cases for a cloud-based smart energy management[C]//2019 IEEE International Conference on Smart Cloud(SmartCloud). Tokyo, 2019: 19-24. |

| [10] | Phung J, Lee Y C, Zomaya A Y. Lightweight power monitoring framework for virtualized computing environments[J]. IEEE Transactions on Computers, 2019, 69(1): 14-25. |

| [11] | Kumar J, Singh A K. Performance assessment of time series forecasting models for cloud datacenter networks' workload prediction[J]. Wireless Personal Communications, 2021, 116(3): 1949-1969. DOI:10.1007/s11277-020-07773-6 |

| [12] | 王俊娜. 一类混合预测模型的研究及其应用[D]. 青岛: 青岛大学, 2020. (Wang Jun-na. Research and application of a kind of mixed prediction model[D]. Qingdao: Qingdao University, 2020. ) |

| [13] | Kumar J, Singh A K, Buyya R. Self directed learning based workload forecasting model for cloud resource management[J]. Information Sciences, 2021, 543: 345-366. DOI:10.1016/j.ins.2020.07.012 |

| [14] | Kumar J, Goomer R, Singh A K. Long short term memory recurrent neural network(LSTM-RNN)based workload forecasting model for cloud datacenters[J]. Procedia Computer Science, 2018, 125: 676-682. DOI:10.1016/j.procs.2017.12.087 |

| [15] | Cheng Y, Wang C, Yu H, et al. Gru-es: resource usage prediction of cloud workloads using a novel hybrid method[C]//IEEE 21st International Conference on High Performance Computing and Communications; IEEE 17th International Conference on Smart City; IEEE 5th International Conference on Data Science and Systems(HPCC/SmartCity/DSS). Zhangjiajie, 2019: 1249-1256. |

| [16] | Adhikari S, Plewnia C, Netramai C, et al. A simulation for forecasting compute resource usage[C]//3rd Asia Pacific Information Technology Conference. Bangkok, 2021: 26-32. |

| [17] | 束文娟, 曾凡平, 陈国柱, 等. 基于变分模态分解与门控循环单元网络的云资源预测[J]. 计算机应用, 2021, 41(sup2): 159-164. (Shu Wen-juan, Zeng Fan-ping, Chen Guo-zhu, et al. Cloud resource prediction based on variational modal decomposition and gated cyclic unit network[J]. Computer Application, 2021, 41(sup2): 159-164.) |

| [18] | Li X, Ma X, Xiao F, et al. Time-series production forecasting method based on the integration of bidirectional gated recurrent unit(Bi-GRU)network and sparrow search algorithm(SSA)[J]. Journal of Petroleum Science and Engineering, 2022, 208: 109309. DOI:10.1016/j.petrol.2021.109309 |

| [19] | 程杰仁, 罗逸涵, 唐湘滟, 等. 基于LSTM流量预测的DDoS攻击检测方法[J]. 华中科技大学学报(自然科学版), 2019, 47(4): 32-36. (Cheng Jie-ren, Luo Yi-han, Tang Xiang-yan, et al. DDoS attack detection method based on LSTM traffic prediction[J]. Journal of Huazhong University of Science and Technology(Natural Science Edition), 2019, 47(4): 32-36.) |

| [20] | Ke K, Hongbin S, Chengkang Z, et al. short-term electrical load forecasting method based on stacked auto-encoding and GRU neural network[J]. Evolutionary Intelligence, 2019, 12(3): 385-394. |

| [21] | Han P, Wang W, Shi Q, et al. Real-time short-term trajectory prediction based on GRU neural network[C]//IEEE/AIAA 38th Digital Avionics Systems Conference(DASC). California, 2019: 1-8. |

| [22] | Sri H M, Rao P, Kammardi P K, et al. A smart adaptive LSTM technique for electrical load forecasting at source[C]//2nd IEEE International Conference on Recent Trends in Electronics, Information & Communication Technology(RTEICT). Bangalore, 2017: 1717-1721. |

| [23] | Gan D, Wang Y, Zhang N, et al. Enhancing short-term probabilistic residential load forecasting with quantile long-short-term memory[J]. The Journal of Engineering, 2017, 2017(14): 2622-2627. |

| [24] | 高德亮. 基于AdamW算法的WT-GRU模型在高频股指预测中的应用[D]. 济南: 山东大学, 2021. (Gao De-liang. Application of WT-GRU model based on Adam algorithm in high frequency stock index prediction[D]. Jinan: Shandong University, 2021. ) |

| [25] | 李静, 莫思敏. 基于改进遗传算法的深度神经网络优化研究[J]. 计算机工程与科学, 2021, 43(8): 1503-1511. (Li Jing, Mo Si-min. Research on depth neural network optimization based on improved genetic algorithm[J]. Computer Engineering and Science, 2021, 43(8): 1503-1511.) |

| [26] | 谢晓兰, 梁荣华. 基于PF-LSTM的云资源预测[J]. 计算机工程与设计, 2021, 42(10): 2823-2829. (Xie Xiao-an, Liang Rong-hua. Cloud resource prediction based on PF-LSTM[J]. Computer Engineering and Design, 2021, 42(10): 2823-2829.) |

| [27] | 王悦悦, 谢晓兰, 郭杨, 等. 基于自适应神经网络的云资源预测模型[J]. 科学技术与工程, 2021, 21(25): 10814-10819. (Wang Yue-yue, Xie Xiao-lan, Guo Yang, et al. Cloud resource prediction model based on adaptive neural network[J]. Science, Technology and Engineering, 2021, 21(25): 10814-10819.) |