, 许华文, 杨棉子美

, 许华文, 杨棉子美 东北大学 理学院, 辽宁 沈阳 110819

收稿日期:2021-07-06

基金项目:国家重点研发计划项目(2020YFB1710003)。

作者简介:张雪峰(1966-),男, 辽宁辽阳人,东北大学副教授。

摘要:针对如何获得符合人类视觉感知的压缩图像问题, 提出了基于条件生成对抗网络的图像压缩模型(HPIC).在HPIC中, 首先利用一个超先验概率模型对原始图像进行编码量化, 将条件附加标签和残差模块相结合的生成器用于压缩图像的重建, 基于深度卷积神经网络搭建的判别器则用于区分压缩后的图像和真实图像间的差异.损失函数是基于比特率-失真-感知优化理论来设计的, 一方面选用基于预训练Inception网络特征值的感知失真指标来实现具有高感知质量的图像压缩重建, 另一方面利用生成对抗网络损失来消除压缩伪影, 提高压缩精度.实验结果表明, HPIC在比特率-失真-感知三重权衡中取得了较好的平衡, 即使目前的常见算法使用两倍于本文算法的比特率, 本文算法在所有的感知指标得分上均优于前者, HPIC仍能够实现具有高感知质量的压缩.

关键词:图像压缩比特率-失真-感知优化理论条件生成对抗网络损失函数

High Perceptual Image Compression Based on Conditional GAN

ZHANG Xue-feng

, XU Hua-wen, YANG Mian-zimei

, XU Hua-wen, YANG Mian-zimei School of Sciences, Northeastern University, Shenyang 110819, China

Corresponding author: ZHANG Xue-feng, E-mail: zhangxuefeng@mail.neu.edu.cn.

Abstract: A conditional generative adversarial network-based high perceptual image compression(HPIC) model was proposed to obtain a compressed image that conforms to human visual perception. In HPIC, the original image was encoded and quantized based on a hyper prior probability model. A generator based on the conditional additional label and residual module was used for the reconstruction of the compressed image, and a discriminator based on the convolutional neural network was used to distinguish the difference between the compressed image and the real image. Based on the bit rate-distortion-perception optimization theory to design the loss function, the perceptual distortion metric was chosen based on the eigenvalues of the pre-trained inception network to achieve image compression reconstruction with high perceptual quality on the one hand, and use the adversarial generation network loss to eliminate compression artifacts and improve the compression accuracy on the other hand. The experimental results show that HPIC achieves a good balance in the bit rate-distortion-perception tradeoff and outperforms the current common algorithms in all perceptual metrics scores, even though the latter uses twice as much bit rate as ours. HPIC can achieve compression with high perceptual quality.

Key words: image compressionbit rate-distortion-perception theoryconditional generative adversarial networkloss function

随着多媒体技术及计算机硬件性能的跨越式发展, 图像在信息传递过程中发挥着愈来愈重要的作用.同样的信息, 文字表达篇幅冗长, 图像往往更为生动形象和直观.为了高效地存储图像, 有损图像压缩算法在许多实际场景都有应用.

最广泛使用的有损图像编解码算法之一是JPEG[1].它把图像分割成小块, 并且使用离散余弦变换对图像数据进行编码.然后将得到的系数进行缩放、量化和熵编码以形成最终的比特流.对于比较新的编码格式, 工业界在诸多不同的方向进行了探索研究, 如使用其他变换——JEPG2000[2]中的小波或内部预测, 而BPG(better portable graphics)[3]和WebP[4]则是使用了来自视频编解码器HEVC(high efficiency video coding)[5]的环内过滤.

近些年来, 深度学习工具在计算机视觉领域得到了比较广泛的应用, 基于深度学习的有损压缩算法不断地被提出.这些模型不需要人工设计编解码器的各个组成部分, 而是可以从图像数据中深度学习得到一个最佳的非线性变换, 然后以端到端的方式将熵编码成比特流, 人们在其中直接使用神经网络来进行优化香农提出的比特率-失真权衡.早期的研究依赖于循环神经网络[6-7], 而后续的研究则是基于自动编码器[8-10].为了降低存储图像所需的比特率, 人们尝试使用各种方法来更精确地建模自动编码器隐藏层的概率密度, 以实现更有效的算术编码.采用的方法包括使用分层先验、具有各种上下文形状的自动回归或将二者结合[11-14].目前, 最新的模型在峰值信噪比(PSNR)指标上优于BPG, 例如Minnen等[15]的研究.

自从Goodfellow等[16]提出生成对抗网络后, 它在无条件和有条件的图像生成方面均快速发展.现今最先进的生成对抗网络可以生成高分辨率的逼真图像[17-19].相较于传统的方法[20-21], 生成对抗网络在图像分割[22]、图像去噪[23]等应用中也取得了进展.此外, 生成对抗损失也被用来改善神经网络压缩算法的视觉质量[14, 24-26].Rippel等[14]在全分辨率压缩算法中使用生成对抗损失作为损失函数的一个组成部分, 但是并没有系统地最小化这类损失, 也没有研究这类损失对于压缩质量的影响.Tschannen等[24]和Blau等[25]则侧重于以概念上合理的方式将生成对抗损失纳入比特率-失真指标当中.具体而言, Tschannen等[24]提出使用分布约束来作为比特率-失真指标的一部分, 以确保压缩图像的分布在所有比特率下都与原始图像的分布相吻合; Blau等[25]则提出并研究了比特率-失真-感知之间的三重权衡.Agustsson等[26]提出了使用生成对抗网络来防止压缩伪影, 还验证了在很低的比特率下使用基于生成对抗网络的压缩算法可以节省两倍于传统算法的比特率.他们提出的压缩模型可以在极低的比特率下生成视觉感知上十分细腻的压缩重建,但压缩所得的图像往往只保留高级的语义, 与原始图像有较大的偏差.

针对上述问题, 本文提出一种基于条件生成对抗网络的图像压缩算法, 使用条件生成对抗网络来优化深层卷积神经网络.生成器中采用通道归一化层替代实例归一化, 对各个通道进行归一化处理, 有助于缓解暗化伪影的问题[27].在损失函数方面, 使用预训练好的VGG-16网络激活前的特征值来计算感知损失, 以实现压缩图像的细腻纹路细节重建.最后, 在训练过程中加入生成对抗损失, 以提升压缩精度.

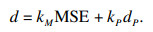

1 基于条件生成对抗网络的图像压缩1.1 图像压缩模型给定原始图像x, 希望对其进行压缩, 而不是存储原始的RGB数据.首先需要对其进行编码, 为此需要设计一个编码器E, 记编码后的隐变量为y=E(x), 接着需要对编码的y进行存储, 而存储则是经由概率模型P和熵编码(如算术编码)实现, 忽略熵编码增加的比特率, 记无损存储y的比特率为r(y)=-log(P(y)).为了得到压缩后的图像x′, 需要设计一个解码器G对y进行解码, 记为x′=G(y).原始图像与压缩重建图像之间的差异记为失真d(x, x′).将E, G, P参数化为卷积神经网络, 那么本文的目标转换训练网络使得以下比特率-失真权衡最小化:

| (1) |

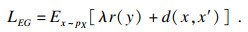

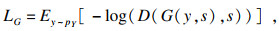

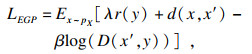

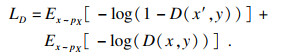

在上述基于神经网络的有损压缩算法的基础上, 本文引入条件生成对抗网络[28]进行优化, 其由有约束的生成器G(也就是解码器)和判别器D组成.生成器试图将编码量化的数据变换为逼近原始图像的压缩重建图像, 而判别器则试图区分压缩重建图像与原始图像之间的差异.总体模型框架如图 1所示.

图 1(Fig. 1)

| 图 1 HIPC模型结构图Fig.1 The architecture of HIPC |

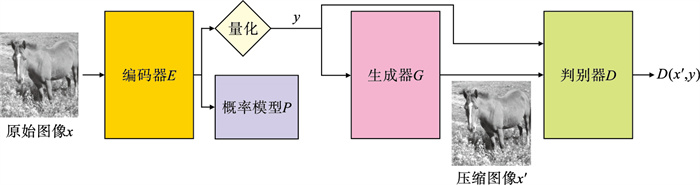

1.2 各个网络结构设置1.2.1 编码器架构和概率模型及量化编码器、生成器、判别器的架构借鉴自文献[26, 29], 其中编码器的架构如图 2所示.卷积核除图中特殊说明以外, 均采用3×3的大小.Conv60表示卷积层中滤波器的数量或者输出空间的维数为60, 其余类似解读.↓2表示进行卷积步长为2的下采样, 而Norm表示通道归一化(channel normalization), 有关归一化详见1.2.3节, ReLU是常用的激活函数(后同).编码器首先采用了5个各异的卷积层进行图像特征的提取, 之后本文在编码器最后一层引入一个瓶颈层Conv Cy以避免过拟合.对于概率模型, 本文使用文献[11]中提出的超先验概率模型, 用于剔除图像压缩过程中的冗余信息.对于待压缩图像, 无法知道其实际分布, 只知道它的分布是存在统计依赖关系的.为了模拟目标变量之间的依赖关系, 该模型引入一组额外的随机变量进行描述.具体来说, 将边信息视为熵模型参数的先验信息, 从而使它们成为潜在表示的先决条件.提取边信息z来建模y的分布以便于存储, 并在超编码器当中以及估计p(y|z)使用均匀噪声U(-1/2, 1/2)来模拟量化.但是, 当将y输入到G时, 本文使用四舍五入代替了噪声, 这确保了生成器在训练过程中量化噪声是相同的.

图 2(Fig. 2)

| 图 2 编码器架构Fig.2 The architecture of encoder |

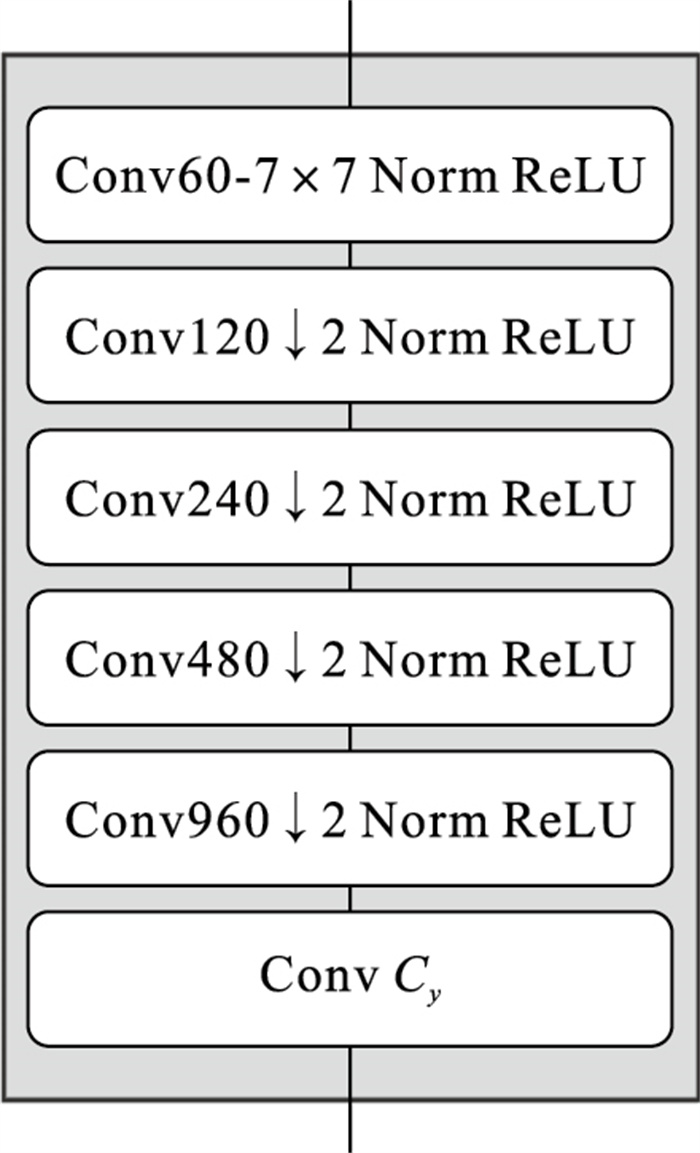

1.2.2 生成器及判别器架构生成器的架构如图 3所示, ↑2表示进行卷积步长为2的上采样.与编码器相比较, 本文在生成器中引入了残差模块.对于编码量化后的隐变量y, 采用了9层残差层进行解码, 其后提取其中的特征用于压缩重建图像的生成, 与编码器类似, 最后加入了瓶颈层防止过拟合.

图 3(Fig. 3)

| 图 3 生成器架构Fig.3 The architecture of generator |

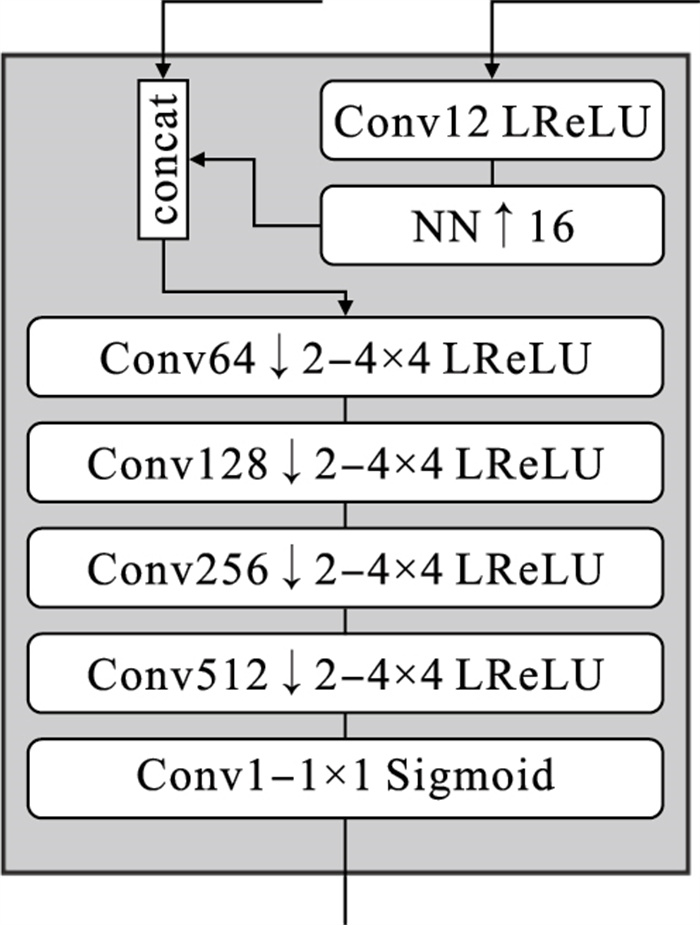

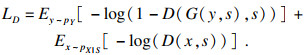

判别器的架构如图 4所示, NN↑16表示进行16×16的上采样调整.部分卷积层中采用的激活函数LReLU, 其中参数取α=0.2.最后一层采用1×1的卷积核并施加Sigmoid激活函数以得到判别结果.文献[26, 29]中都使用了多尺度马尔科夫判别器, 但本文仅使用单一尺度, 并且本文使用了谱归一化(spectral normalization)取代实例归一化(instance normalization).谱归一化的具体实现如下:

图 4(Fig. 4)

| 图 4 判别器架构Fig.4 The architecture of discriminator |

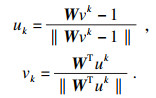

谱归一化即为参数矩阵W除以W的谱范数.若想求得W的谱范数, 需计算得到矩阵的奇异值, 但计算量较大, 所以使用“幂迭代法”近似计算.先随机生成高斯初始化向量.再按从上到下的顺序计算下式:

|

在迭代次数足够多时, uk为W最大奇异值的相应的特征矢量, 所以有WWTu=σ(W)u, 即可求得矩阵W的最大奇异值.

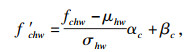

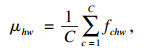

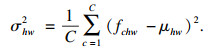

1.2.3 归一化在文献[26]中, 编码器和生成器也使用了实例归一化, 但文献[27]发现当在分辨率与训练裁剪大小不同的图像上使用该模型时, 会产生明显的暗化伪影.他们假设这是由于实例归一化的空间平均引起的, 并且采用通道归一化缓解了这个问题.基于此, 本文使用通道归一化, 它可以对各个通道进行归一化.假设输入的是一批C×H×W维卷积输出层fchw, 使用学习得到的每通道偏移量αc, βc, 则可以将其归一化为

| (2) |

| (3) |

| (4) |

| (5) |

| (6) |

|

| (7) |

| (8) |

| (9) |

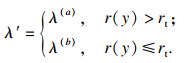

当采用式(1)作为损失函数来训练模型时, 式中只有一项失真d(x, x′)与比特率项r(y)有冲突, 此时模型的最终(平均)比特率可以只通过变化来控制.但考虑到本文所采用的损失函数式(8)中, MSE, dP=DISTS以及log(D(x′, y))均与比特率项不一致.对于固定的或者不同的超参数kM, kP, 将会导致模型具有不同的比特率, 使得比较变得困难.为了缓解上述情况, 本文引入一个“目标比特率”超参数rt, 并将式(8)中的参数λ替换为自适应项λ′, 引入两个超参数λ(a), λ(b)将其定义如下:

| (10) |

表 1(Table 1)

| 表 1 固定参数设置 Table 1 Fixed parameter settings |

表 2(Table 2)

| 表 2 变化参数设置 Table 2 Change parameter settings |

为了使模型能更好地接近目标比特率, 在初始训练时采用更高的比特率(相应的自适应项参数也调整为目标比特率的两倍)进行训练, 到达一定的步长后再调整为目标比特率.对于学习率而言, 损失函数下降到局部最优值之后进行裁剪来优化训练过程.

为了验证加入生成对抗网络的效果, 本文训练了一个无生成对抗网络的基准模型, 也采用MSE和DISTS作为损失函数.此外, 本文与文献[11]中的bmshj2018模型以及文献[15]中的mbt2018模型进行了对比, 后者与本文采用相同的超先验概率模型.而为了得到本文的高感知模型, 首先训练一个初始模型, 采用MSE和DISTS作为损失函数.之后的高感知模型基于上述模型进行初始化, 加入生成对抗网络的损失函数, 而不是从0开始初始化, 具体的训练策略如表 3所示, 其中k表示1 000.

表 3(Table 3)

| 表 3 训练策略 Table 3 Training strategies |

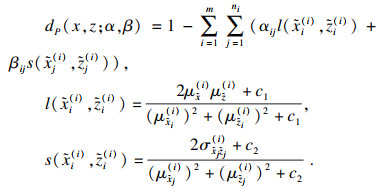

2.2 模型评价指标本文计算训练得到的各个模型的PSNR以及感知失真DISTS和MS-SSIM, 并且采用FID[34]和KID [35], LPIPS作为感知质量指标.峰值信噪比PSNR是图像处理领域最常用的评价指标, 而多尺度结构相似性MS-SSIM是评估(和训练)神经网络压缩算法最广泛使用的失真指标.DISTS与LPIPS类似, 它可以测量最初训练用于图像分类的深层神经网络的特征空间中的距离, 但也适用于预测压缩像素块的相似性, 其经过验证可以预测这些形变的视觉感知得分[30].

FID是一种广泛使用的指标, 用于评估图像生成(尤其是生成对抗网络)中的样本质量和多样性.与PSNR, MS-SSIM和LPIPS分别测量单个图像对之间的相似度不同, FID则是评估原始图像分布与生成的或失真的图像分布之间的相似性.这种相似性是在为图像分类所训练的Inception网络的特征空间中测量的, 方法是对特征进行高斯拟合, 并计算参考图像的概率分布函数与生成图像的概率分布函数之间的Wasserstein距离.Heusel等[34]验证了FID与失真的增长及用户感知是一致的.此外, 经过验证它还可以用来检测常见的生成对抗网络失效模式, 如模式下降和模式崩溃.KID与FID是类似的, 但不同之处在于KID是无偏的, 并且不对特征空间中的分布做任何假设.

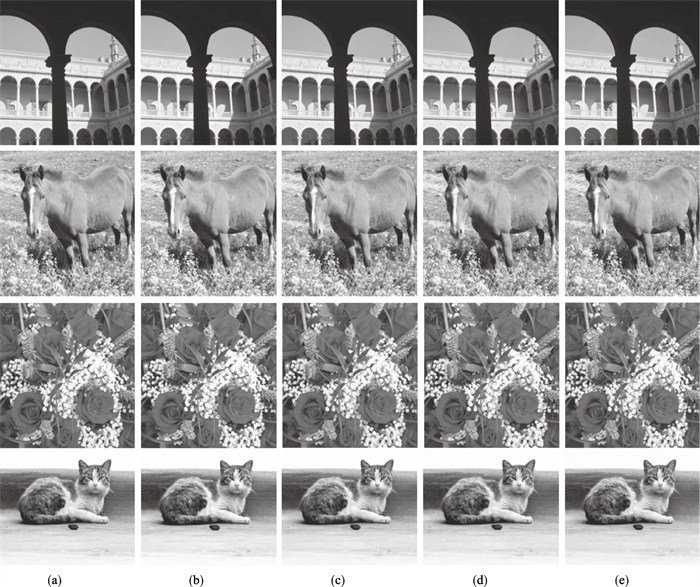

2.3 可视化结果本文训练的模型效果如图 5所示, 将所得到的模型与相同比特率的mbt2018模型、BPG模型以及两倍比特率的BPG模型进行了比较.当采用BPG模型进行压缩时采用最高的PSNR设定, 即无色度二次采样和“慢速”模式.可以看到, 基于生成对抗网络的模型生成了非常接近输入的高感知压缩重建, 包括毛发与皮肤纹理, 而BPG则出现了块状伪影, 如图 6所示, 而且这些伪影是以两倍的比特率出现.

图 5(Fig. 5)

| 图 5 各模型压缩效果Fig.5 Compressed images of each model (a)—原图;(b)—HIPC(0.15 bpp);(c)—BPG(P.30 bpp); (d)—mbt2018(0.14 bpp); (e)—bmshj2018(0.16 bpp). |

图 6(Fig. 6)

| 图 6 压缩细节对比Fig.6 Comparing of texture detail (a)—原图;(b)—HIPC(0.15 bpp);(c)—BPG(P.30 bpp); (d)—mbt2018(0.14 bpp); (e)—bmshj2018(0.16 bpp). |

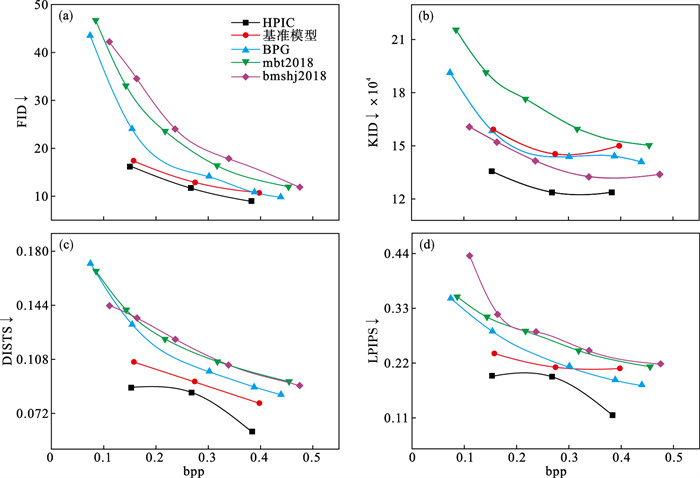

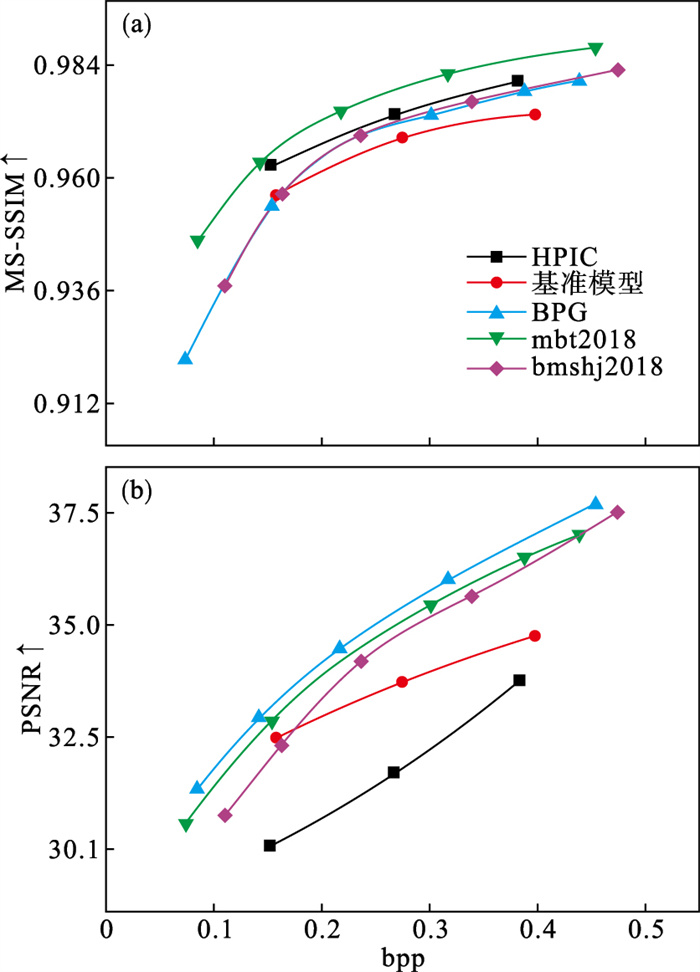

在测试数据集上采用了上文所叙述的6个指标作为纵坐标, 以每像素比特率bpp(bits per pixel)作为横坐标, 在图 7和图 8中分别画出了比特率-感知和比特率-失真曲线(其中↓表示指标越小越好, ↑表示指标越大越好).将本文的模型与基准模型(无生成对抗网络)、mbt2018模型、bmshj2018模型以及BPG模型进行了对比.

图 7(Fig. 7)

| 图 7 各模型的比特率-感知曲线Fig.7 Bit rate-distortion curves of each model (a)—比特率-FID曲线;(b)—比特率-KID曲线;(c)—比特率-DISTS曲线;(d)—比特率-LPIPS曲线. |

图 8(Fig. 8)

| 图 8 各模型的比特率-失真曲线Fig.8 Bit rate-perception curves of each model (a)—比特率-MS-SSIM曲线;(b)—比特率-PSNR曲线. |

如图 7所示, 正如预想中的那样, 本文的高感知模型HPIC在所有感知质量指标中处于领先, 但PSNR指标和MS-SSIM指标相对较差.把具有相同的失真的基准模型(无生成对抗网络)与HPIC进行比较, 结果表明增加生成对抗网络损失的效果与理论相符,所有感知指标都得到了改善.而且HPIC在所有感知指标上的表现都要优于以往的模型.

从图 8基于MS-SSIM和PSNR指标的比特率-失真曲线可以观察到, 与DISTS等感知指标相比, 基准模型与HPIC在这两个失真指标中的表现各异.加入生成对抗网络使得模型的PSNR稍微变差, 但MS-SSIM却略有提高, 这与参数设定有关.而与bmshj2018和mbt2018模型相比, HPIC模型的PSNR指标都有一定程度下降, 但如图 7所见, HPIC模型的所有感知指标相较于前两者得到了大幅提升, 这说明牺牲一定的数据保真度以换取更好的人类视觉感知质量是可行的.上述结果促使本文在进行灵敏度分析时使用KID等感知指标, 只需要在固定失真的损失函数以及整体训练设定的条件下进行对比.

总体而言, 基于Blau等[25]提出的“比特率-失真-感知”权衡理论, 在一个固定的比率下, 更好的感知质量总是意味着更糟糕的失真.相反, 当最小化失真时就会使得感知质量变得较差.本文通过引入生成对抗网络, 使得输入分布和压缩重建分布之间的差异尽量减少, 以取得更好的感知质量, 但三者仍是不可兼得的.实验结果表明本文的方法相较于以往的方法而言, 在三者之间取得了较好的平衡, 且实现了高感知质量的图像压缩.

3 结论1) 本文针对图像设计了一个将条件生成对抗网络和卷积神经网络相结合的压缩算法框架, 在图像压缩的损失函数中加入感知失真指标, 在感知上接近输入的情况下实现了具有高感知的图像压缩.

2) 本文使用了一组不同的失真、感知度量指标来评估所得的图像压缩模型, 并且运用比特率-失真-感知优化理论对实验结果进行了分析.结果表明, 即使传统图像压缩算法BPG采用两倍于本文模型的bpp, 本文的压缩效果也优于它们.

参考文献

| [1] | Wallace G K. The JPEG still picture compression standard[J]. IEEE Transactions on Consumer Electronics, 1992, 38(1): 18-34. |

| [2] | Rabbani M. JPEG2000:image compression fundamentals, standards and practice[M]. Berlin: Springer, 2002. |

| [3] | Developers G. Compression techniques[EB/OL]. [2021-07-23]. https://developers.google.com/speed/webp/docs. |

| [4] | Bellard F. BPG image format[EB/OL]. [2021-07-23]. https://bellard.org/bpg/. |

| [5] | Sullivan G J, Ohm J R, Han W J, et al. Overview of the high efficiency video coding(HEVC)standard[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(12): 1649-1668. DOI:10.1109/TCSVT.2012.2221191 |

| [6] | Toderici G, O'Malley S M, Hwang S J, et al. Variable rate image compression with recurrent neural networks[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1511.06085v5. |

| [7] | Toderici G, Vincent D, Johnston N, et al. Full resolution image compression with recurrent neural networks[C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, 2017: 5306-5314. |

| [8] | Ballé J, Laparra V, Simoncelli E P. End-to-end optimized image compression[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1611.01704. |

| [9] | Theis L, Shi W, Cunningham A, et al. Lossy image compression with compressive autoencoders[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1703.00395. |

| [10] | Agustsson E, Mentzer F, Tschannen M, et al. Soft-to-hard vector quantization for end-to-end learning compressible representations[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1704.00648. |

| [11] | Ballé J, Minnen D, Singh S, et al. Variational image compression with a scale hyperprior[EB/OL]. [2021-07-23]. http://export.arxiv.org/abs/1802.01436. |

| [12] | Mentzer F, Agustsson E, Tschannen M, et al. Conditional probability models for deep image compression[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Long Beach, 2018: 4394-4402. |

| [13] | Li M, Zuo W, Gu S, et al. Learning convolutional networks for content-weighted image compression[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Long Beach, 2018: 3214-3223. |

| [14] | Rippel O, Bourdev L. Real-time adaptive image compression[C]// International Conference on Machine Learning. Sydney, 2017: 2922-2930. |

| [15] | Minnen D, Ballé J, Toderici G. Joint autoregressive and hierarchical priors for learned image compression[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1809.02736. |

| [16] | Goodfellow I J, Pouget Abadie J, Mirza M, et al. Generative adversarial networks[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1406.2661. |

| [17] | 王雪松, 晁杰, 程玉虎. 基于自注意力生成对抗网络的图像超分辨率重建[J]. 控制与决策, 2021, 36(6): 1324-1332. (Wang Xue-song, Chao Jie, Cheng Yu-hu. Image super-resolution reconstruction based on self-attention GAN[J]. Control and Decision, 2021, 36(6): 1324-1332.) |

| [18] | Karras T, Laine S, Aila T. A style-based generator architecture for generative adversarial networks[C]// Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 4401-4410. |

| [19] | Park T, Liu M Y, Wang T C, et al. Semantic image synthesis with spatially-adaptive normalization[C]// Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 2337-2346. |

| [20] | 邓廷权, 盛春冬. 结合变精度粗糙熵和遗传算法的图像阈值分割方法[J]. 控制与决策, 2011, 26(7): 1079-1082. (Deng Ting-quan, Sheng Chun-dong. Image threshold segmentation based on entropy of variable precision rough sets and genetic algorithm[J]. Control and Decision, 2011, 26(7): 1079-1082.) |

| [21] | 张雪峰, 闫慧. 基于中值滤波和分数阶滤波的图像去噪与增强算法[J]. 东北大学学报(自然科学版), 2020, 41(4): 482-487. (Zhang Xue-feng, Yan Hui. Image denoising and enhancement algorithm based on median filtering and fractional order filtering[J]. Journal of Northeastern University(Natural Science), 2020, 41(4): 482-487.) |

| [22] | Zhu X, Zhang X, Zhang X Y, et al. A novel framework for semantic segmentation with generative adversarial network[J]. Journal of Visual Communication and Image Representation, 2019, 58: 532-543. DOI:10.1016/j.jvcir.2018.11.020 |

| [23] | Vo D M, Nguyen D M, Le T P, et al. HI-GAN: a hierarchical generative adversarial network for blind denoising of real photographs[J]. Information Sciences, 2021, 570: 225-240. DOI:10.1016/j.ins.2021.04.045 |

| [24] | Tschannen M, Agustsson E, Lucic M. Deep generative models for distribution-preserving lossy compression[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1805.11057. |

| [25] | Blau Y, Michaeli T. Rethinking lossy compression: the rate-distortion-perception tradeoff[C]// International Conference on Machine Learning. Sydney, 2019: 675-685. |

| [26] | Agustsson E, Tschannen M, Mentzer F, et al. Generative adversarial networks for extreme learned image compression[C]// Proceedings of the IEEE/CVF Internat ional Conference on Computer Vision. Seoul, 2019: 221-231. |

| [27] | Mentzer F, Toderici G, Tschannen M, et al. High-fidelity generative image compression[EB/OL]. [2021-07-23]. https://arxiv.org/abs/2006.09965. |

| [28] | Wang T C, Liu M Y, Zhu J Y, et al. High-resolution image synthesis and semantic manipulation with conditional gans[C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Long Beach, 2018: 8798-8807. |

| [29] | Mirza M, Osindero S. Conditional generative adversarial nets[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1411.1784. |

| [30] | Ding K, Ma K, Wang S, et al. Image quality assessment: unifying structure and texture similarity[EB/OL]. [2021-07-23]. https://arxiv.org/abs/2004.07728. |

| [31] | Zhang R, Isola P, Efros A A, et al. The unreasonable effectiveness of deep features as a perceptual metric[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Long Beach, 2018: 586-595. |

| [32] | Lin T Y, Maire M, Belongie S, et al. Microsoft COCO: common objects in context[C]// European Conference on Computer Vision. Zurich, 2014: 740-755. |

| [33] | Asuni N, Giachetti A. Testimages: a largescale archive for testing visual devices and basic image processing algorithms[C]// STAG: Smart Tools & Apps for Graphics. Cagliari, 2014: 6370. |

| [34] | Heusel M, Ramsauer H, Unterthiner T, et al. GANS trained by a two timescale update rule converge to a local Nash equilibrium[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1706.08500. |

| [35] | Bińkowski M, Sutherland D J, Arbel M, et al. Demystifying MMD GANS[EB/OL]. [2021-07-23]. https://arxiv.org/abs/1801.01401. |