, 曹文伟, 陈超

, 曹文伟, 陈超 东北大学 机械工程与自动化学院, 辽宁 沈阳 110819

收稿日期:2021-03-08

基金项目:国家重大科技攻关项目(JB2016GD034)。

作者简介:原培新(1953-),男,辽宁营口人,东北大学教授。

摘要:针对摘钩作业时间短, 需要在机器人和车厢同步时准确识别目标把手和测距的问题, 提出使用双目立体视觉技术配合机械臂自动摘取车钩的方法并对视觉部分进行深入研究: 通过图像预处理和模板匹配技术识别目标把手, 在利用特征检测和匹配算法恢复双目摄像机间的位姿信息, 并对双目摄像机的位姿信息进行校正.为了克服立体匹配时光照不均的影响, 提出了基于局部融合的立体匹配算法获取视差图, 最后使用三角测量计算列车分解区域中目标把手的深度信息, 实现三维重建.此方法可以在识别把手位置后, 测量把手距双目视觉系统的物理距离, 为机器人自动摘钩提供数据基础.

关键词:自动摘钩机器人双目立体视觉图像预处理立体匹配双目测距

Train Target Recognition and Ranging Technology Based on Binocular Stereoscopic Vision

YUAN Pei-xin, CAI Da

, CAO Wen-wei, CHEN Chao

, CAO Wen-wei, CHEN Chao School of Mechanical Engineering & Automation, Northeastern University, Shenyang 110819, China

Corresponding author: CAI Da, E-mail: 1553317260@qq.com.

Abstract: In view of short time unhooking operation and the need to accurately identify the target handle and ranging when the robot is synchronized with the carriage, a method of automatic unhooking using binocular stereoscopic vision technology combined with the manipulator is proposed, and the vision part is deeply studied: identifying the target handle through image preprocessing and template matching technology, recovering the pose information between binocular cameras by feature detection and matching algorithm, and correcting the pose information of binocular cameras. In order to overcome the influence of uneven illumination in stereoscopic matching, a stereoscopic matching algorithm based on local fusion is proposed to obtain the disparity map. Finally, triangulation is used to calculate the depth information of the target handle in the train decomposition area to realize three-dimensional reconstruction. This method can measure the physical distance between the handles and the binocular vision system after identifying the position of the handles, so as to provide data basis for the automatic unhooking of the robot.

Key words: automatic unhooking robotbinocular stereoscopic visionimage preprocessingstereoscopic matchingbinocular ranging

随着世界流通领域的高速发展, 以及铁路运输的业务量大幅度增长, 诸多因素对我国铁路货物运输提出了严峻考验.由于铁路货运到达的目的地不同, 列车的编组解体作业成为不可缺少的环节, 编组站便成为重要的枢纽.编组站的主要任务是货物列车的解体与编组作业, 驼峰是编组站的主要特征.驼峰的形状和骆驼背类似, 因此而得名.在驼峰上铺设铁轨, 当列车经过驼峰时, 利用列车自身的重力和驼峰坡度产生的势能使两个车钩的拉力为零, 工作人员提起连接车钩的把手, 将车钩分解.此时分解后的列车顺坡自动溜放到编组场的预定线路上, 根据要求进行最后的编组.现今, 列车在编组站上的溜车调度、信息接收等操作均已实现自动化, 但是人工操作仍然是驼峰处列车摘钩的唯一方式, 这不仅增加工作人员的劳动强度, 也威胁其人身安全.

早在20世纪70年代, 德国的KB公司就开始进行铁路运输自动摘钩相关技术的研究.该公司研发了摘钩机械手, 并在列车旁铺设轨道, 机械手在轨道上根据自动化综合系统对目标车厢进行追踪, 利用雷达测出列车此时的运行速度并传输给机械臂, 机械臂根据之前得到的位置信息感知车钩目标的距离, 对车钩手柄进行抓取, 完成摘钩作业.但是, 由于当时的实验环境困难和技术落后等因素, 造成对目标的识别和测距结果偏差严重, 无法抓取, 最后放弃了这项研究.

沈阳市裕国站实验基地设计了一种代替工作人员进行摘钩作业的机器人: 在货车驼峰线旁铺设一条轨道, 工作人员在后台通过机器人上的摄像头观测现场, 找到适当位置时, 控制机械手的进给量进行车钩抓取, 从而实现车厢分解.虽然此方法可以保障工作人员的人身安全, 但依旧存在不足: 1)没有实现节约人力物力, 由于需要人工观测和控制机械臂, 从某种程度来说此方法使摘钩作业变得更加复杂; 2)人工观测存在一系列不稳定因素, 如注意力不集中、光线强烈无法准确识别等原因, 会造成抓取失败或抓取错误等, 影响工作效率.

为实现完全的摘钩自动化, 解放人力, 提高摘钩工作效率, 本次研究以与裕国站共同合作的项目为支撑, 在自动摘钩机器人的基础上, 为其植入“眼睛和大脑”, 使用双目立体视觉技术进行目标识别和测距, 为机器人摘钩提供数据基础.通过实际现场考察和实验研究, 本课题的难点如下:

1) 摘钩作业时间短, 需要在机器人和车厢同步时准确识别目标把手和测量距离;

2) 和单目视觉技术相比, 双目立体视觉一直都是研究的难点.由于左右相机存在光照不均匀或者遮挡现象, 会给立体匹配算法的应用带来困难.

针对实际工程背景和研究的难点, 本次研究首先通过模板匹配对摄像机拍摄双目图像中的车钩把手进行匹配与识别; 其次, 对摄像机进行标定获得系统成像模型参数, 恢复双目相机间的位姿, 即旋转矩阵R和平移向量T, 从而实现立体校正; 最后, 通过立体匹配技术获得双目相机的视差d, 利用三角测量恢复场景的深度Z,它可以控制机械手的进给量, 从而进行准确的摘钩作业.此方法可代替人工后台观测, 得到摘钩环境的三维信息, 为机器人建立“大脑”, 实现真正的自动摘钩.

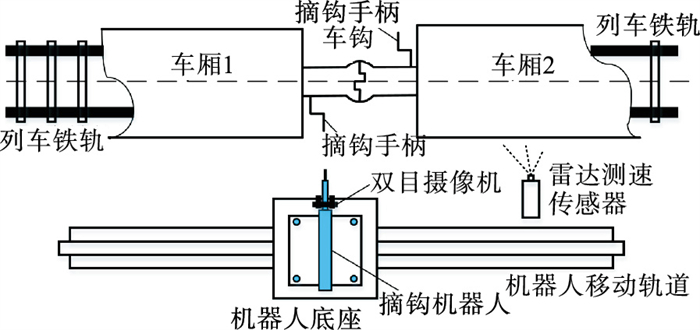

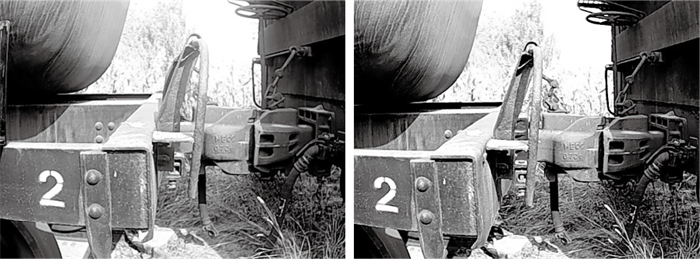

1 机器人摘钩动作虽然本文主要研究的是机器视觉部分, 但为了便于分析, 需要对机器人自动摘钩的过程进行介绍.在驼峰处进行摘钩时, 并不是每一节车厢都要摘钩分解, 因此在摘钩之前需要确定目标车厢.现今, 编组站大部分装置已实现自动化, 可利用计数传感器系统对车厢数量依次计数, 当得到目标车厢的数字信息时, 机器人底座开始在铺设好的轨道上运行.如图 1所示, 雷达测速传感器可以测量此时列车速度, 反馈给机器人达到共速.当机器人和列车处于相对静止状态时, 便可以通过双目摄像机采集车厢、手柄和车钩组成的实时双目图像, 如图 2所示, 用视觉算法对目标把手进行识别和测距, 此距离为目标点到视觉系统的物理距离(mm).最后将信息反馈给机器人的执行装置, 进行自动抓取.

图 1(Fig. 1)

| 图 1 自动摘钩过程示意图Fig.1 Schematic diagram of automatic unhooking process |

图 2(Fig. 2)

| 图 2 列车双目图像Fig.2 Train binocular images |

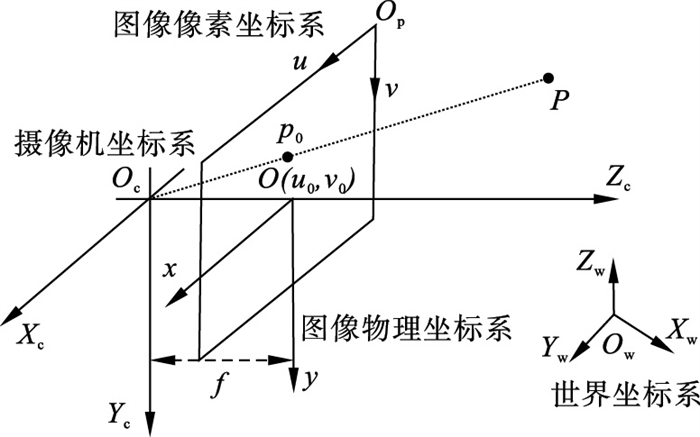

2 系统成像模型在机器视觉中, 相机成像会涉及以下4种坐标系: 图像像素坐标系(uOpv)、图像物理坐标系(xOy)、摄像机坐标系(XcOcYcZc)、世界坐标系(XwOwYwZw).如图 3所示, 世界坐标系(XwOwYwZw)通过一系列矩阵变换得到图像像素坐标系(uOpv).

图 3(Fig. 3)

| 图 3 摄像机成像模型Fig.3 Camera imaging model |

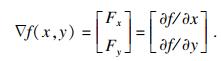

由此可得

| (1) |

3 目标把手的识别和测距方法3.1 目标把手识别技术研究当机器人与列车在行进间共速时, 为了测量目标把手的距离, 需要对把手进行识别并确定该区域在整个图像的位置.本文使用图像预处理和模板匹配算法, 首先通过图像算法增强图像质量, 使图像细节丰富, 纹理清晰.最后选择一个把手区域图像作为模板, 根据模板与双目图像之间的相似度来确定目标把手在图像的位置并识别.通过图像预处理和模板匹配算法进行目标识别的步骤为: ①图像边缘检测; ②图像锐化; ③模板匹配识别.

3.1.1 图像边缘检测在图像处理技术中, 图像的边缘是灰度变化明显的像素连接而成的集合, 它是图像特征的基本体现, Sobel算子是常用的边缘检测算法.在数学中, 函数的导数往往表征着函数的极值, 而图像的边缘灰度相对于周围像素具有突变的性质, 因此计算图像灰度值的导数可以有效地提取图像的边缘特征.二维梯度可近似图像的一阶导数, 其表达式为

| (2) |

| (3) |

图 4(Fig. 4)

| 图 4 Laplacian边缘检测图像Fig.4 Laplacian edge detection image |

3.1.2 图像锐化模板匹配是利用模板图像和原始图像进行对比, 根据相似度识别目标.因此, 得到高质量、特征细节清晰的双目图像是模板匹配的重要前提.图像锐化突出图像的高频部分, 使图像边缘清晰, 特征明显.图像锐化将原图像与边缘图像进行权重融合, 经对比, 原始灰度图像和锐化结果如图 5和图 6所示.

图 5(Fig. 5)

| 图 5 原始灰度图像Fig.5 Original grayscale image |

图 6(Fig. 6)

| 图 6 图像锐化效果图Fig.6 Image sharpening effect |

3.1.3 模板匹配识别模板匹配就是利用已知模板对原始图像进行搜索找到对应区域的过程.为了保证匹配的精度, 本文选用了基于图像灰度的模板匹配方法.该方法通过计算模板与原图像灰度值差的平方和S(x, y)来确定匹配程度, 如式(4)所示:

| (4) |

截取图像的目标把手作为模板, 尺寸为64×355像素, 对其进行灰度变换、图像边缘检测和图像锐化操作, 结果如图 7所示.

图 7(Fig. 7)

| 图 7 模板图像预处理Fig.7 Template image preprocessing (a)—灰度图像;(b)—模糊图像;(c)—锐化图像. |

利用模板图像与锐化后的双目图像进行模板匹配, 结果如图 8所示, 红框标注的区域为目标把手.

图 8(Fig. 8)

| 图 8 左、右图像目标把手识别Fig.8 Target recognition of left and right images |

3.2 图像特征点检测与匹配特征点体现图像的重要特征, 它对图像的理解和分析有着很重要的作用.特征点在保留图像重要特征的同时可以有效地减少信息的数据量, 提高了计算速度, 为实时处理提供了可能.SIFT(scale-invariant feature transform)[1-2]特征检测是提取特征点的常用算法, 它对旋转、尺度缩放、亮度变化保持鲁棒性, 对视角的变化、仿射变换和噪声也保持一定程度的稳定性, 并适用于在海量特征中进行快速、精准匹配.SIFT特征检测结果见图 9.

图 9(Fig. 9)

| 图 9 双目图像SIFT特征检测Fig.9 SIFT feature detection of binocular image |

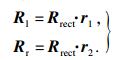

特征匹配[3-5]是双目立体视觉技术中极为重要的一步, 它解决了数据关联性问题, 经过匹配, 可知2幅图像特征点之间的关系, 进一步得出相机之间的位姿关系.根据2幅图像的匹配特征点的描述进行排序, 取最近距离的点对作为匹配点, SIFT匹配结果如图 10所示.

图 10(Fig. 10)

| 图 10 SIFT特征点匹配Fig.10 SIFT feature point matching |

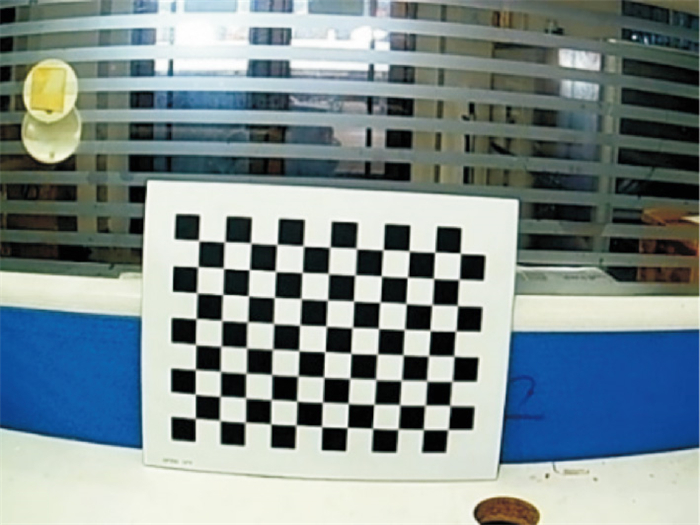

3.3 摄像机标定技术3.3.1 单目摄像机标定实验的标定板是8×11的黑白棋盘格, 每个小正方形的边长为20 mm, 如图 11所示.

图 11(Fig. 11)

| 图 11 棋盘格标定板Fig.11 Checkerboard calibration board |

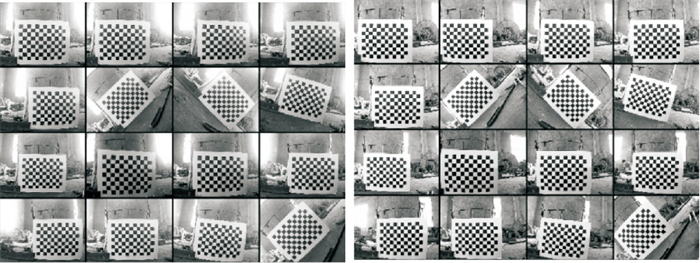

如图 12所示, 使用双目相机从不同距离和角度各拍摄16张标定板图像.Harris角点检测得到棋盘格标定板的角点坐标, 通过平面单应性原理和张正友标定技术[6-7]进行单目摄像机标定, 标定所得的单目摄像机的参数如表 1和表 2所示.

图 12(Fig. 12)

| 图 12 左右摄像机拍摄的标定板图像Fig.12 Calibration board images taken by left and right cameras |

表 1(Table 1)

| 表 1 左摄像机标定结果 Table 1 Calibration results of left camera |

表 2(Table 2)

| 表 2 右摄像机标定结果 Table 2 Calibration results of right camera |

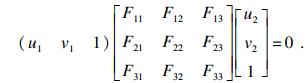

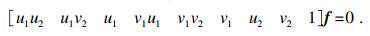

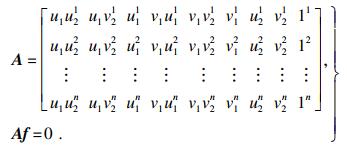

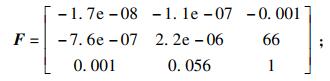

3.3.2 双目摄像机标定基础矩阵F[8-9]将双目图像中的像素点关联起来, 取一对匹配点x1=[u1 v1 1]T和x2=[u2 v2 1]T, 根据极线约束x2T Fx1=0可得

| (5) |

| (6) |

| (7) |

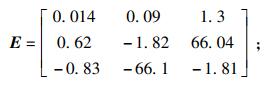

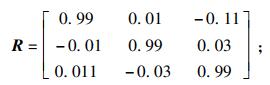

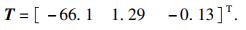

求解本质矩阵E[10]: Ml和Mr分别为左、右相机的内参数矩阵, 令三维点的世界坐标系与左相机坐标系重合, 右相机相对于三维点的位姿就是两相机间的位姿, 由本质矩阵E的奇异值分解得到双目相机的位姿信息R和T, E的奇异值分解为

| (8) |

| (9) |

| (10) |

| (11) |

| (12) |

图 13(Fig. 13)

| 图 13 立体校正示意图Fig.13 Stereoscopic correction diagram |

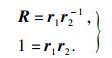

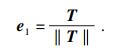

设定2幅图像的旋转矩阵R和平移向量T, 为了使图像重投影畸变最小化, 将右侧摄像机的图像平面旋转至左侧摄像机的旋转平面的旋转矩阵R在2台摄像机之间被分为两半, 左右摄像机的合成旋转矩阵分别为r1和r2, r1和r2的关系为

| (13) |

| (14) |

| (15) |

| (16) |

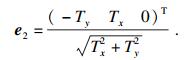

图 14(Fig. 14)

| 图 14 立体校正Fig.14 Stereoscopic correction (a)—校正前的双目图像;(b)—校正后的双目图像;(c)—双目相机匹配点云. |

3.5 立体匹配在立体视觉中, 立体匹配[14-16]一直是一个关键的问题, 它是在立体校正的基础上计算视差d.根据计算像素区域的不同, 立体匹配算法大致可分为: 基于局部区域的立体匹配算法和全局立体匹配算法.根据实验现场的环境可知, 所检测的手柄和车钩周围环境组成了一个纹理丰富的场景, 故本文选择基于局部的立体匹配算法.

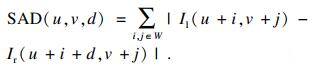

SAD(sum of absolute difference)[17]是一种基于局部区域的立体匹配算法, 计算的是像素邻域内对应位置的像素灰度差的绝对值之和, 其表达式为

| (17) |

SAD算法在速度和匹配质量方面较其他算法更具有优势, 但其易受光照影响.

Census变换[18]也是一种常用的基于局部区域的立体匹配算法, 它是在图像区域定义一个矩形窗口, 用该窗口遍历整幅图像.选取中心像素为参考像素, 将矩形窗口中的每个像素灰度值与参考像素灰度值进行比较, 灰度值小于或等于参考值的像素记为0, 大于参考值的像素记为1, 最后将它们按位连接, 得到变换结果.其表达式如下:

| (18) |

为了提高匹配的效率和鲁棒性, 现将上述两种算法进行加权融合, 其匹配步骤如下:

1) 匹配代价计算.以左视图为基准图像, 选择1个参考匹配点为中心像素建立一个大小为m×n的矩形窗口.以右视图为匹配图像, 沿着校正后的水平线进行搜索.将SAD算法和Census变换通过加权的方式进行相加融合, 其表达式为

| (19) |

2) 视差计算.当代价函数确定后, 取使代价函数最小的视差dmin为所求视差.

3) 视差优化.计算出的视差为离散的数值.可通过亚像素插值等方法进行视差精确化.由于实验环境的影响, 所得的视差图会存在大量噪声, 可采用平滑滤波等方法进行去噪优化.

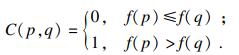

3.6 双目测距与三维重建双目立体视觉就是用2台相同的工业摄像机模拟人的双眼, 通过视差和三角测量等一系列算法感知物体的距离, 从而恢复出物体的深度信息[19-20].如图 15所示, 令世界坐标系为XO1YZ, 其与左相机的坐标系重合.基线b是2台摄像机光心间的距离.空间三维点P的坐标为(X, Y, Z), 由于世界坐标系和左相机坐标系重合, 所以点P在左相机坐标系下的坐标为(X, Y, Z).当使用双目相机观察同一点时, 会存在视差d, 因此点P在右相机坐标系下的坐标为(X-b, Y, Z).定义点P在左、右摄像机成像平面下的坐标为p1(x1, y1)和p2(x2, y2), 令y1=y2=y, 通过上述关系, 可以求出

图 15(Fig. 15)

| 图 15 三角测量示意图Fig.15 Triangulation diagram |

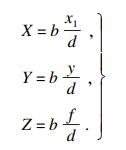

| (20) |

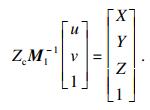

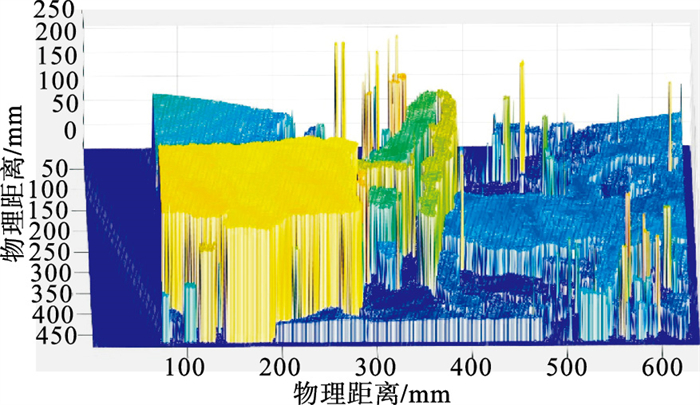

得到视差图和图像深度信息, 便可以进行全局的三维重建, 对式(1)进行逆变换, 得

| (21) |

表 3(Table 3)

| 表 3 摄像机参数 Table 3 Camera parameters |

以苏家屯编组站的两节连接车厢为研究区域, C++为主要编程语言, 通过VS2017配置OpenCV库为编程环境进行双目图像的采集、图像预处理、立体校正和立体匹配等操作, 利用双目立体视觉系统采集带有车钩和把手的图像.若想实现机械臂对车钩的自动摘取, 需对车厢、车钩和最重要的目标把手进行测距.

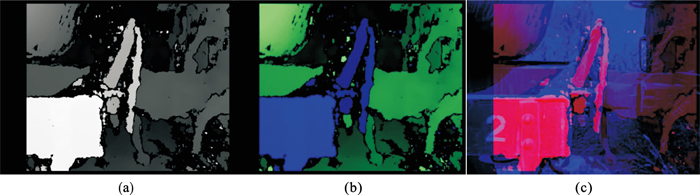

图 16是通过立体匹配算法得到的列车分解区域的视差图, 灰度值较大的部分表示距离拍摄像机的垂直距离较小, 根据灰度图的灰度值分布可知列车各部分的距离.为了便于实验分析将其转化为三通道的RGB图像, 在彩色图像中, 蓝色表示距离摄像机较近的部分, 绿色则表示较远.为了更直观地表示深度图与原图像的关系, 将左摄像机拍摄的矫正图像和深度图的灰度图进行融合.其中蓝色部分是左摄像机经过立体校正后的拍摄图像, 红色部分是视差图.可以看出, 场景中的车厢、车钩和把手均被深度图表示, 在蓝色的原始图像的强纹理区域实现了立体匹配与视差计算, 进而验证了算法和实验的准确性.

图 16(Fig. 16)

| 图 16 列车视差图像Fig.16 Train disparity image (a)—灰度视差图像;(b)—彩色视差图像;(c)—融合视差图像. |

将立体匹配算法得到的三通道RGB视差图像与原始列车图像进行对比, 如图 17所示, 列车的车钩、车厢和目标把手各自的区域在视差图中清晰可见.通过三角测量算法, 公式(21)计算列车的车厢、车钩和把手三部分物理距离, 测距结果如表 4至表 6所示.深度Z表示双目立体视觉系统的光心和三维场景各个部分的垂直距离, 根据前文机器人摘钩过程, 该距离是一个物理量, 其单位为mm.机器人在识别到目标把手后, 可根据把手的距离进行伸缩, 当抓取到把手时, 执行机构可模仿人工摘钩动作, 实现自动摘钩.实验中三部分的深度计算值和利用激光测距仪检测出的实际距离的误差如表 4至表 6所示, 经过比较可知车钩处纹理丰富, 故匹配精确, 即其距离测量结果较为理想; 反观目标把手, 由于把手处表面纹理较少, 且目标较小, 因此存在误匹配, 影响测量精度, 但总体误差不大, 可以在后续研究中继续优化.

图 17(Fig. 17)

| 图 17 视差图像区域标注Fig.17 Disparity image region labeling (a)—原始图像;(b)—RGB视差图像. |

表 4(Table 4)

| 表 4 目标把手处测距结果 Table 4 Distance measurement results at target handle |

表 5(Table 5)

| 表 5 车厢处测距结果 Table 5 Distance measurement results at the carriage |

表 6(Table 6)

| 表 6 车钩处测距结果 Table 6 Distance measurement results at hook |

为了更加直观地观测列车分解的操作场景, 重建出的场景三维稀疏点云如图 18所示.

图 18(Fig. 18)

| 图 18 列车场景三维重建结果Fig.18 3D reconstruction results of train scene |

5 结论1) 对复杂背景下的双目图像进行边缘检测和图像锐化等图像预处理操作, 增强图像质量.使用模板匹配算法搜索图像上目标区域并进行识别.

2) 利用匹配点和单目摄像机的标定参数恢复了双目相机的位姿关系, 并进一步实现了立体校正, 其校正效果良好, 验证了双目摄像机参数和位姿信息的准确性.

3) 通过SAD加权Census的立体匹配算法得到了区域明显的视差图, 测量了场景的深度信息, 并与激光测距仪的实际深度信息对比进行验证.

4) 经对比, 目标把手处目标较小且纹理信息单一, 所以测得的距离误差较大, 但误差在规定范围内.实验结果表明, 该方法稳定可靠, 测量目标精准.

参考文献

| [1] | Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [2] | Zhu Z. Parallel remote sensing image registration based on improved SIFT point feature[J]. Journal of Remote Sensing, 2011, 15(5): 1024-1039. |

| [3] | Dou J F, Qin Q, Tu Z M. Robust image matching based on the information of SIFT[J]. Optik, 2018, 171: 850-861. DOI:10.1016/j.ijleo.2018.06.094 |

| [4] | Caspi Y, Simakov D, Irani M. Feature-based sequence-to-sequence matching[J]. International Journal of Computer Vision, 2006, 68(1): 53-64. DOI:10.1007/s11263-005-4842-z |

| [5] | Zhang Z. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2000, 22(11): 1330-1334. |

| [6] | Wu F C, Hu Z Y, Zhu H J. Camera calibration with moving one-dimensional objects[J]. Pattern Recognition, 2005, 38(5): 755-765. DOI:10.1016/j.patcog.2004.11.005 |

| [7] | Luong Q T, Faugeras O D. The fundamental matrix: theory, algorithms, and stability analysis[J]. International Journal of Computer Vision, 1996, 17(1): 43-75. DOI:10.1007/BF00127818 |

| [8] | Moisan L, Bérenger S. A probabilistic criterion to detect rigid point matches between two images and estimate the fundamental matrix[J]. International Journal of Computer Vision, 2004, 57(3): 201-218. DOI:10.1023/B:VISI.0000013094.38752.54 |

| [9] | Daniel B, Levente H. Efficient recovery of essential matrix from two affine correspondences[J]. IEEE Transactions on Image Processing, 2018, 27(11): 5328-5337. DOI:10.1109/TIP.2018.2849866 |

| [10] | Checcucci E, Amparore D, Fiori C, et al. 3D imaging applications for robotic urologic surgery: an ESUT YAUWP review[J]. World Journal of Urology, 2020, 38(2): 869-881. |

| [11] | Lu C, Wang X, Shen Y. A stereo vision measurement system based on OpenCV[C]// Third International Conference on Mechanic Automation & Control Engineering. Shanghai: IEEE Computer Society, 2012: 261-264. |

| [12] | Anwar A, Rube I E. An assessment of image matching algorithms in depth estimation[J]. Biotropica, 2013, 44(4): 498-505. |

| [13] | Lin Q, Yang R, Zhang Z, et al. Robust stereo-match algorithm for infrared markers in image-guided optical tracking system[J]. IEEE Access, 2018, 6(2): 52421-52433. |

| [14] | Mozerov M G, Weijer J V D. Accurate stereo matching by two-step energy minimization[J]. IEEE Transactions on Image Processing, 2015, 24(3): 1153-1163. DOI:10.1109/TIP.2015.2395820 |

| [15] | Li Q, Ni J, Ma Y, et al. Stereo matching using census cost over cross window and segmentation-based disparity refinement[J]. Journal of Electronic Imaging, 2018, 27(2): 1-8. |

| [16] | Essannouni F, Thami R O H, Aboutajdine D, et al. Adjustable SAD matching algorithm using frequency domain[J]. Journal of Real-Time Image Processing, 2007, 1(4): 257-265. DOI:10.1007/s11554-007-0026-0 |

| [17] | Zhong Y, Loop C, Byeon W, et al. Displacement-invariant cost computation for efficient stereo matching[J]. Computer Vision and Pattern Recognition, 2020, 14(8): 1-8. |

| [18] | 王浩, 许志闻, 谢坤, 等. 基于OpenCV的双目测距系统[J]. 吉林大学学报(信息科学版), 2014, 32(2): 188-194. (Wang Hao, Xu Zhi-wen, Xie Kun, et al. Binocular ranging system based on OpenCV[J]. Journal of Jilin University(Information Science Edition), 2014, 32(2): 188-194. DOI:10.3969/j.issn.1671-5896.2014.02.013) |

| [19] | Jiang J, Liu L, Fu R, et al. Non-horizontal binocular vision ranging method based on pixels[J]. Optical and Quantum Electronics, 2020, 52(4): 223-233. DOI:10.1007/s11082-020-02343-3 |

| [20] | 肖静文, 青鑫月, 万琦. 基于OpenCV与MATLAB的双目测距系统研究[J]. 信息通信, 2015, 3(2): 21-23. (Xiao Jing-wen, Qing Xin-yue, Wan Qi. Research on binocular ranging system based on OpenCV and MATLAB[J]. Information and Communication, 2015, 3(2): 21-23. DOI:10.3969/j.issn.1673-1131.2015.02.011) |