, 陈相猛3, 顾正晖1

, 陈相猛3, 顾正晖1 1. 华南理工大学 自动化科学与工程学院, 广东 广州 510640;

2. 桂林航天工业学院 医学人工智能实验室, 广西 桂林 541004;

3. 江门市中心医院 放射科, 广东 江门 529030

收稿日期:2021-06-09

基金项目:国家自然科学基金资助项目(81960324, 61876064, 61967004); 广东省基础与应用基础研究项目(2019A1515011773)。

作者简介:罗家健(1997-), 男, 广东广州人, 华南理工大学硕士研究生;

顾正晖(1973-), 女, 广东新兴人, 华南理工大学教授。

摘要:针对实性肺结节CT影像数据量少、人工标注耗时耗力等问题, 提出一种结合生成对抗网络和集成学习的实性肺结节良恶性计算机辅助诊断方法.首先, 使用基于梯度惩罚的生成对抗网络对肺结节CT影像数据集进行扩充, 缓解由数据量少、样本类别不均衡导致的模型过拟合.然后, 利用卷积神经网络进行CT影像特征提取, 并通过主成分分析对深度特征进行降维.最后, 联合CT图像特征和有效临床信息, 采用集成学习方法构建分类模型预测实性肺结节良恶性.基于多中心临床数据分析表明, 相比于传统卷积神经网络模型, 所提出方法有更好的预测性能.

关键词:实性肺结节肺腺癌计算机断层扫描生成对抗网络集成学习

Diagnosis Algorithm of Pulmonary Nodules Malignancy Based on Generative Adversarial Network

LUO Jia-jian1, FENG Bao2

, CHEN Xiang-meng3, GU Zheng-hui1

, CHEN Xiang-meng3, GU Zheng-hui1 1. School of Automation Science and Engineering, South China University of Technology, Guangzhou 510640, China;

2. Medical Artificial Intelligence Laboratory, Guilin University of Aerospace Technology, Guilin 541004, China;

3. The Department of Radiology, Jiangmen Central Hospital, Jiangmen 529030, China

Corresponding author: FENG Bao, E-mail: fengbao1986.love@163.com.

Abstract: To solve the problem of data scarcity and expensive costs in manual labeling of CT images of solid pulmonary nodules, a computer aided diagnosis algorithm for classification between lung tuberculosis and lung adenocarcinoma of solid pulmonary nodules by combining generative adversarial network and ensemble learning was proposed. Firstly, the original CT image dataset was augmented using Wasserstein generative adversarial network with gradient penalty(WGAN-GP), in order to relieve the problem of overfitting caused by small-scale dataset and class imbalance. Then, feature extraction was performed using convolutional neural network, followed by a dimension reduction procedure using principal component analysis(PCA). Finally, deep features concatenated with effective subjective features were classified by an ensemble learning model to give final prediction of the patient.Analysis based on multi-center clinical data indicated that the proposed algorithm has better performance compared to traditional convolutional neural network method.

Key words: solid pulmonary noduleslung adenocarcinomacomputed tomography(CT)generative adversarial network(GAN)ensemble learning

癌症是目前世界上导致死亡的一个重要因素, 而其中肺癌是死亡率最高的癌症之一.肺结节是早期肺癌的典型表现形式之一[1], 有良恶性之分, 其中肺结核(lung tuberculosis, LTB)[2]是典型的良性肺结节, 肺腺癌(lung adenocarcinoma, LAC)[3]是典型的恶性肺结节.临床中肺结核与肺腺癌的治疗措施并不相同.肺结核患者需要进行抗炎治疗, 肺腺癌患者则需要手术治疗或者放化疗[4].肺结核和肺腺癌在CT影像中均可表现为实性肺结节, 是典型的“异病同影”, 为术前鉴别诊断带来了较高的挑战.为了准确区分两者, 病理活检是一个比较有效的方法[5].然而, 病理活检是一种侵入式的诊断方法, 易造成癌细胞针道播散且不可作为重复监测手段[6]. 因此, 寻找一种非侵入式的预测模型对肺结核和肺腺癌进行鉴别诊断,对提高影像科医生诊断效率具有重要意义.

影像组学(radiomics)是当前医工交叉学科的研究热点之一, 通过高通量地提取包括形状、纹理、小波等图像特征, 同时综合有效临床信息, 构建肿瘤辅助诊断的定量模型[7].Chen等[8]和Demir等[9]通过影像组学方法, 从肺结节CT影像中提取包括形态、纹理、小波等特征构建影像组学模型, 在进行肺结节良恶性分类实验中取得了较好的结果.尽管影像组学方法已经在肺癌、乳腺癌等多个领域得到了应用[10-12], 但图像特征提取依赖于精确的病灶分割结果, 耗时耗力, 重复性欠佳, 不适合开展大数据分析.此外, 影像组学方法所使用的经验性特征并未考虑到数据的个体差异性, 可能导致模型在不同数据集下的性能表现差异较大.

不同于影像组学方法, 基于深度学习的数据驱动类方法能够提取出特异性较强的特征, 相比于经验特征, 基于数据驱动的深度学习特征具有较高的鲁棒性和稳定性[13-15].然而, 在临床数据分析中, 获取规模较大的患者数据是非常困难的.此外, 实性肺结节CT影像数据中, 肺腺癌样本数量远大于肺结核样本数量, 存在严重的样本不均衡现象, 进一步加剧了训练模型时出现的过拟合问题.为解决这一问题, Shen等[16]采用传统数据增广方式扩充肺癌数据集, 在不同方向上平移2个像素点实现增广; Zhang等[17]提出特征表征与相似性矩阵的联合学习方法, 从大量未标记数据中找到与原始数据集最为相近的样本; Zhao等[18]基于空间转换模型和外观转换模型, 将有标签的脑部MRI数据变换为新的样本数据.

针对实性肺结节的临床CT影像数据, 传统增广方法扩充后的数据集容易导致数据分布发生变化, 大量的未标记数据同样难以获得.本文提出一种基于生成对抗网络的实性肺结节辅助诊断算法.首先, 利用生成对抗网络对肺结节CT影像数据进行增广, 避免了传统数据增广方式的弊端, 并在增广后的数据集上训练卷积神经网络进行特征提取.然后, 通过主成分分析对深度学习特征进行降维, 提高深度特征的鲁棒性及稳定性.最后联合深度特征与主观征象, 通过集成分类器对单个病例进行诊断.

1 实验数据与仪器1.1 病例数据集本研究使用的实验数据集为江门市中心医院的临床数据和中山大学附属第五医院的临床数据.江门市中心医院的临床数据包括362个病例, 包含130个肺结核病例和232个肺腺癌病例; 中山大学附属第五医院的临床数据包括219个病例, 包含45个肺结核病例和174个肺腺癌病例.用于构建模型的临床数据的纳入标准为: ①所有病例中的肺结节均为实性肺结节; ②肺结节最大径大于3 mm, 小于30 mm; ③CT影像在患者手术前两周获得; ④病理学检测结果是病灶类别标签的金标准; ⑤主观征象由有着10年以上经验的放射科医生读取.

在本研究中, 江门市中心医院的临床数据作为构建组合模型的内部数据集, 用于对组合模型进行训练和内部验证.内部数据集随机划分为训练集和测试集, 其中训练集包含108个肺结核病例和162个肺腺癌病例, 测试集包含22个肺结核病例和70个肺腺癌病例.中山大学附属第五医院的临床数据作为外部验证集, 用于对组合模型进行外部检验, 模型在外部验证集上的性能表现可以作为衡量其泛化能力的指标之一.

1.2 仪器与方法采用双能量Siemens Somatom Flash及Toshiba Aquilion One 64层螺旋CT机进行胸部CT扫描.进行CT平扫时, 要求病人采取仰卧位并深吸一口气, 扫描范围为胸廓入口至双侧肾上腺.扫描参数如下: 管电压120 kV, 自动管电流调制, 螺距0.75~1.5 mm, 准直0.625~1.25 mm, 扫描视野为200 mm×200 mm, CT重建矩阵尺寸为512像素×512像素, 重建层厚10-3mm, 层距0.8~3 mm, 没有进行CT增强.扫描剂量根据病人的身高体重指数确定, 范围为50~150 mJ·kg-1·cm. 图像分析使用肺窗(窗宽: 1500 HU, 窗位: -400 HU).

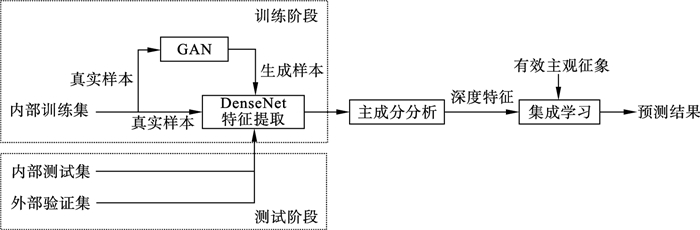

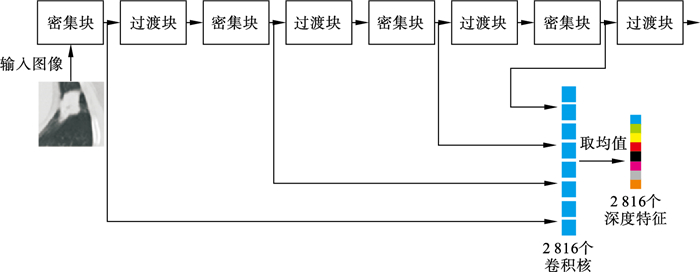

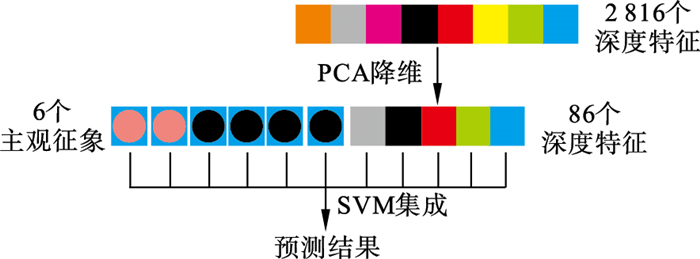

2 算法框架本文方法从以下三个角度缓解因医学影像数据量较小导致的过拟合问题: ①使用真实样本构成的CT影像数据集训练生成对抗网络(generative adversarial network, GAN), 拟合临床CT数据所处的概率分布, 并从中重新采样得到生成样本; ②在增广后的数据集上训练卷积神经网络提取深度特征, 并采用主成分分析进行特征降维, 去除CT影像中存在的噪声与伪影; ③筛选符合统计检验的临床信息及主观征象, 与降维后的深度特征结合, 以支持向量机为基学习器, 使用自举汇聚的集成方法构建集成分类器, 对CT影像特征向量进行分类.本文算法的结构框图如图 1所示.

图 1(Fig. 1)

| 图 1 本文所提出的算法结构框图Fig.1 Structure diagram of the proposed algorithm |

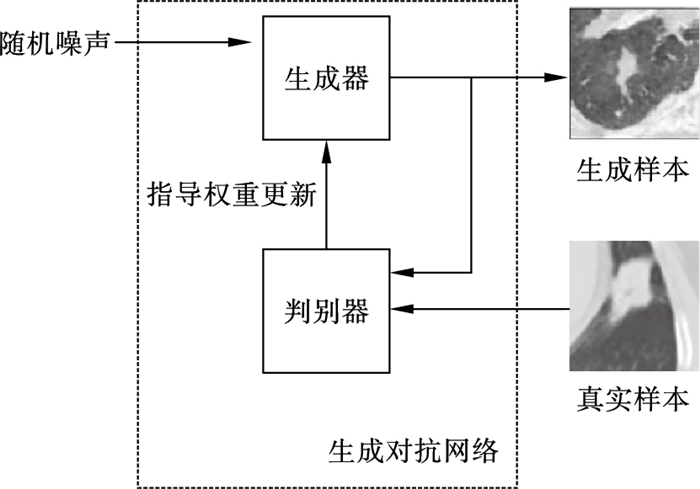

2.1 生成对抗网络扩充数据集本文通过生成对抗网络对临床数据进行增广.生成对抗网络的训练过程本质上是生成器(generator)和判别器(discriminator)之间的零和博弈, 训练完成后生成器得以拟合从随机噪声数据到真实数据分布的映射, 使生成样本具有与真实数据相同的概率分布[19].生成对抗网络的训练过程如图 2所示.

图 2(Fig. 2)

| 图 2 生成对抗网络扩充数据集的训练过程Fig.2 Training process using generative adversarial network to augment dataset |

针对生成对抗网络的训练过程稳定性较差、容易出现模式崩塌和模式丢弃等问题, 目前已有多种用于提升生成对抗网络训练的稳定性方法, 包括Salimans等[20]在判别器中使用小批量数据,Arjovsky等[21]使用Wasserstein距离作为判别器的损失函数等.针对实性肺结节影像数据样本不均衡的情况, 本研究采用基于带有梯度惩罚项的WGAN(Wasserstein generative adversarial network with gradient penalty, WGAN-GP)[22], 对实性肺结节的CT影像数据集进行扩充, 其中判别器的损失函数为

| (1) |

WGAN-GP中判别器的损失函数利用其对输入到生成器的随机噪声的梯度作为正则化项, 同时去除了原来WGAN的权重截断和批正则化, 解决了WGAN中存在的梯度消失和梯度爆炸的问题, 提高了生成样本的质量和稳定性.对于实性肺结节CT临床数据, 梯度项Ez~pz(z)[(‖

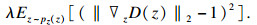

本文设计的生成对抗网络结构如图 3所示.生成器为反卷积神经网络, 通过转置卷积操作对特征图进行上采样, 转置卷积核尺寸为7×7和4×4, 数量依次为512, 256, 128, 64, 32, 1.判别器为卷积神经网络, 卷积核尺寸为4×4和7×7, 数量依次为32, 64, 128, 256, 512, 1.

图 3(Fig. 3)

| 图 3 生成对抗网络结构Fig.3 The structure of generative adversarial network (a)—生成器结构;(b)—判别器结构. |

2.2 使用DenseNet提取深度特征相比于影像组学的方法, 将深度学习模型作为特征提取器的方法不依赖于病灶的精确分割结果, 也不需要事先定义大量的组学特征.影像组学方法提取出的组学特征缺乏特异性, 而深度学习模型可基于单个样本提取出特异性特征, 具有更高的稳定性和鲁棒性.本文基于DenseNet构建深度特征提取器, 其由多个密集连接块和过渡块构成, 相比于其他网络, DenseNet的密集连接结构缓解了模型中梯度消失的问题, 且过渡块将密集连接块输出的特征图进行拼接, 使位于高层的密集连接块能够综合利用低层密集连接块的特征图输出, 更加充分地利用卷积特征, 从而减少网络参数和提升网络效率[23].

针对实性肺结节的诊断任务, 本文方法提取了DenseNet中每一个密集连接块输出的特征图, 由于不同的卷积核关注图像的不同区域, 因此密集连接块输出的特征图有助于挖掘肺结节CT影像数据中更抽象的深度特征.本研究没有采用构建端到端模型(end-to-end model)的方法对实性肺结节的肺结核与肺腺癌进行分类, 其主要原因在于医学影像数据集规模较小, 肺结节CT影像的数据量远达不到普通RGB图像的数据量, 而端到端模型需要大量的训练样本(xi, yi)才能直接学习到输入-输出的映射关系.在样本量较少、类别不均衡的情况下, 额外信息的引入有助于对病灶的类别进行判断, 而端到端模型难以发挥额外信息的作用, 极易出现过拟合训练集的情况.将DenseNet作为特征提取器对实性肺结节CT影像进行处理的过程如图 4所示.

图 4(Fig. 4)

| 图 4 深度特征的提取过程Fig.4 Process of extracting deep features |

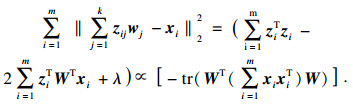

模型输入特征的数量会对模型的性能产生显著影响, 需要控制在一个合适的水平以提高模型性能.特征降维从数据相关性的角度对深度特征作进一步的处理, 减少无关特征的数量.主成分分析(principal component analysis, PCA)算法关注特征之间的相关性, 通过投影法尽可能保留投影后特征的方差, 将原来处于N维空间的特征向量映射到更低的k维空间[24].原样本点xi到投影面的距离可表示为

| (2) |

| (3) |

2.3 主观征象筛选卷积神经网络更关注单个输入样本的局部特征, 在提取特异性特征时有着较好的表现.然而, 相比于影像组学的方法, 卷积神经网络对泛化特征的提取能力不足, 仅依靠深度特征难以提供足够的信息对实性肺结节进行准确的分类.在实性肺结节的肺结核与肺腺癌分类任务中, 病人的临床信息和病灶的泛化信息有助于提高分类的准确性.放射科医师在解读CT影像时, 本质上也是结合临床信息和CT影像的泛化特征来进行诊断, 这些泛化特征被称为CT影像的主观征象.与卷积神经网络相反, 人类的视觉系统更善于处理泛化特征, 而难以处理像素级别的特征.在肺结核与肺腺癌的诊断任务中, 病人年龄及性别、肺结节的尺寸、形状、分叶征、毛刺征是临床上常用的临床信息和主观征象, 其作用在已有研究中得到证实.尺寸更大的肺结节意味着病灶已经扩大或正在生长, 是实性肺结节向肺腺癌转变的典型症状[28].老年人由于免疫系统机能下降, 且易于暴露在更多致癌因素的影响下, 患肺癌的风险比年轻人更高[29].肺结节的不规则形状及分叶征由癌细胞边缘部分不同的生长及分化程度导致, 意味着病灶癌变的概率较高[30-31].毛刺征的出现往往伴随着血管出现癌性浸润、肺结节小叶间隔水肿等现象, 是诊断实性肺结节的重要影像学征象之一[32].

为了结合特异性特征和泛化特征的优势, 本文方法将病人的临床信息和CT影像的主观征象整合到模型中, 并对各主观征象进行卡方检验(Chi-square test)与秩和检验(rank-sum test).临床信息以及主观征象的统计检验结果如表 1所示.

表 1(Table 1)

| 表 1 基于CT的主观征象的统计检验结果 Table 1 Statistical test result of CT-based subjective features | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

2.4 支持向量机与集成学习方法支持向量机(support vector machine, SVM)通过核函数将特征向量映射到高维特征空间中进行线性分类[33].相比于多层感知机(multilayer perceptron, MLP)算法, SVM会产生一个带有余量的决策边界, 进一步减缓过拟合的风险.此外, SVM可看作是带有铰链损失(hinge loss)和L2正则化的MLP.本文以高斯径向基函数(radial based function, RBF)作为SVM的核函数:

| (4) |

相比于使用单一分类器, 集成学习方法通过重新抽样或循环训练的方法, 得到一组基学习器, 并对多个基学习器的预测结果进行聚合, 降低方差, 提升最终预测的性能[34].由于临床数据集样本量小, 且具有较高的非线性, 单个学习器很容易出现过拟合训练集的情况, 难以获得理想的分类性能, 通过集成学习的方法可以综合多个基学习器的预测结果, 减缓单个基学习器的过拟合, 提升模型的泛化能力.Bagging集成方法对训练集进行有放回的重新抽样得到不同的训练子集, 并在多个训练子集上训练多个基学习器, 其中每个训练子集都包含37 % 的包外实例, 可以作为验证集评估基学习器的性能、搜索最优的学习器超参数.

对于降维处理后的特征向量, 本文方法以核SVM作为基学习器, 采用Bagging集成方法对深度特征和主观征象构成的联合特征向量进行分类, 该部分的示意图如图 5所示.

图 5(Fig. 5)

| 图 5 集成学习方法进行最终预测的示意图Fig.5 Schematic diagram of final prediction on patient using ensemble learning |

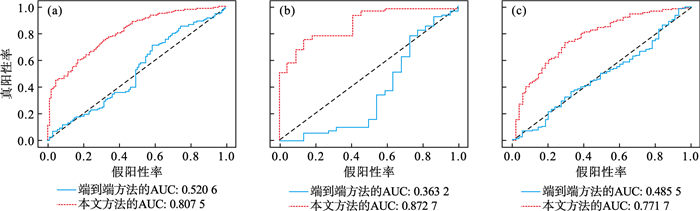

3 实验结果3.1 结果展示本文方法与端到端方法在内部训练集、内部测试集和外部验证集上的性能对比结果如表 2所示, 检验的性能指标包括准确率、精度、敏感度、特异度和接受者工作曲线下面积(area under curve, AUC).其中, 端到端方法为使用DenseNet模型在临床数据集上进行训练和测试的方法, DenseNet模型在ImageNet公开图像数据集上进行预训练, 密集连接块与过渡块的数量均为4, 密集连接块的增长率为32, 卷积层数量依次为6, 12, 24, 16, 优化方法为带有动量的随机梯度下降(momentum SGD)算法, 动量为0.7, 权重衰减为10-5, 学习率为10-4.深度特征向量经PCA进行降维处理后, 特征维数由2 816降低到86, 显著降低了深度特征的数量.本文方法与端到端方法的ROC曲线及AUC结果如图 6所示.

表 2(Table 2)

| 表 2 本文方法与端到端方法的性能对比 Table 2 Comparison of the proposed method with end-to-end method |

图 6(Fig. 6)

| 图 6 不同方法在三个数据集上的ROC曲线Fig.6 ROC curves on three datasets with different methods (a)—内部训练集;(b)—内部测试集;(c)—外部验证集. |

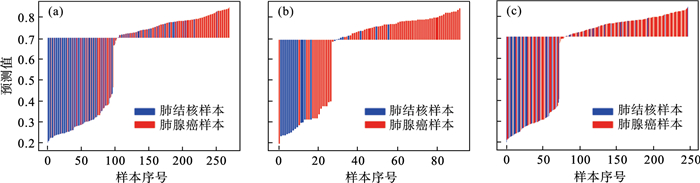

本文方法在三个数据集上的瀑布图如图 7所示, 每一个矩形的颜色代表样本的标签;基准线的数值代表模型的判断阈值,最佳判断阈值经试验确定为0.7.从图 7中可知, 本研究提出的算法在内部训练集上的表现最优, 对于大部分的肺结核样本, 模型的输出值小于判断阈值, 而对于大部分的肺腺癌样本, 模型的输出值大于或等于判断阈值.

图 7(Fig. 7)

| 图 7 本文方法的瀑布图Fig.7 Waterfall plot of the proposed algorithm (a)—内部训练集;(b)—内部测试集;(c)—外部验证集. |

从上述实验结果可知, 本文方法相比于端到端方法, 在多个性能指标上均有明显的提升, 说明在对实性肺结节的肺结核与肺腺癌诊断任务中, 综合使用生成对抗网络对原始数据集进行扩充,使用卷积神经网络提取深度特征并结合主观征象的方法, 能够克服原始数据集规模较小、样本类别不均衡带来的问题.

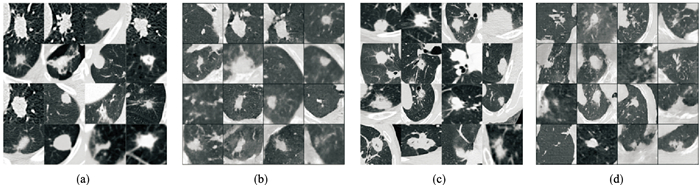

3.2 真实样本与生成样本真实样本与生成样本对比如图 8所示, 经影像科医生对生成样本进行评判, 生成样本具有较好的视觉效果, 且生成样本并非对真实样本的复制或简单变换, 说明生成器较好地拟合了真实样本所在的数据分布, 并从中重新采样获得新的生成样本, 避免了传统数据增广方式可能会改变原始数据集的数据分布这一弊端.使用生成对抗网络能够消除临床数据中肺结核与肺腺癌样本数据量的数量差距, 恢复样本类别的平衡, 从而解决原始数据集样本类别不均衡的问题.

图 8(Fig. 8)

| 图 8 真实样本与生成样本对比Fig.8 Comparison of real and generated samples (a)—真实肺结核样本; (b)—生成肺结核样本; (c)—真实肺腺癌样本; (d)—生成肺腺癌样本. |

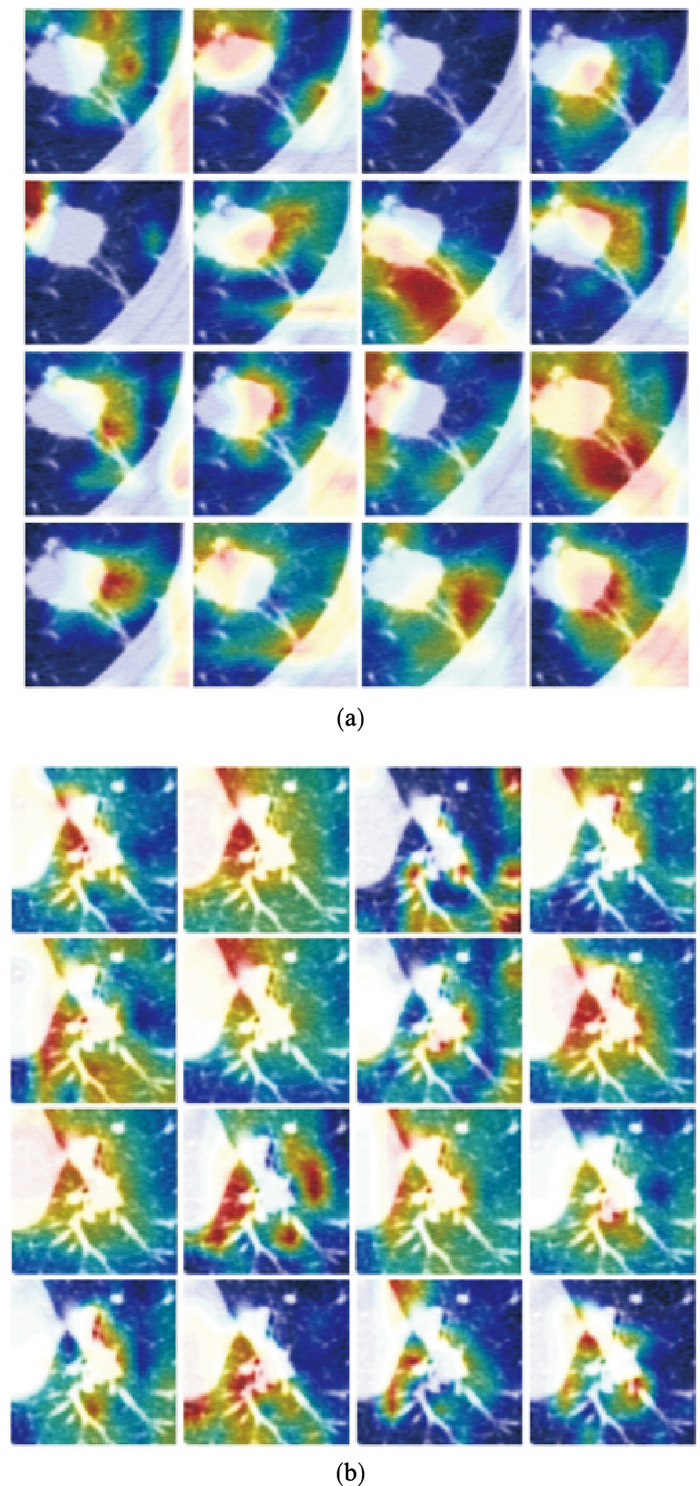

3.3 卷积输出可视化训练深度学习模型时可将其看作黑盒, 只需关注模型的输入输出, 并通过梯度下降的训练算法使模型在训练集上找到最合适的输入-输出映射关系.可以通过反向传播对卷积层进行可视化, 得到能够使卷积核激活程度最高的输入[35], 进而对模型有进一步的了解和认识.本文方法对特征提取器的可视化结果如图 9所示.图 9反映出特征提取器对肺结节的边缘及其病灶所处的微环境的关注程度更高, 这与放射科医师对肺结节的判断较为相似.肺结节的边缘可能包含了更多能够帮助判断病灶是否为肺腺癌的信息, 如规则度、分叶、毛刺等.例如, 从图 9b中可知, 大部分的卷积核在实性肺结节的边缘处被激活的程度最高, 而另一部分的卷积核在实性肺结节的内部被激活的程度最高, 说明特征提取器在肺结节的边缘位置发现了有助于对病灶进行分类的特征.

图 9(Fig. 9)

| 图 9 特征提取器可视化结果Fig.9 Visualization of feature extractor (a)—肺结核样本注意力图;(b)—肺腺癌样本注意力图. |

主观征象也能够间接说明深度特征的有效性.CT影像的主观征象筛选部分中有3个主观征象属于实性肺结节的形态特征, 包括规则度、分叶征和毛刺征, 而深度特征中同样包含与肺结节的形态特征相关联的信息.例如图 9b的第4行第2列所展示的卷积核更关注病灶的左下方区域, 这对应于放射科医师通过病灶的规则度进行诊断.

4 结语本文提出一种实性肺结节辅助诊断方法, 对表现为实性肺结节的肺结核与肺腺癌进行分类, 通过生成对抗网络扩充数据集、使用卷积神经网络提取深度特征和引入主观征象的方法缓解医学影像数据集规模较小、样本类别不均衡带来的影响, 相比于端到端方法, 在各项性能指标上均有提升, 且在多个数据集的验证中表现出较好的稳定性和鲁棒性.

但本研究还存在一定的局限性: ROI区域的分割需要手动完成, 这一部分工作较为繁琐; 没有充分利用CT影像的序列性, 在临床实践中, 放射科医师会将CT影像看成是连续的时间序列来帮助诊断, 而时序信息在本研究中并没有得到充分利用.

参考文献

| [1] | Winer-Muram H T. The solitary pulmonary nodule[J]. Radiology, 2006, 239(1): 34-49. DOI:10.1148/radiol.2391050343 |

| [2] | Yun J S, Song S Y, Na K J, et al. Surgery for hemoptysis in patients with benign lung disease[J]. Journal of Thoracic Disease, 2018, 10(6): 3532-3538. DOI:10.21037/jtd.2018.05.122 |

| [3] | Horn L. Pulmonary adenocarcinoma: approaches to treatment[M]. Amsterdam: Elsevier Health Sciences, 2018: 1-10. |

| [4] | Hirsch F R, Scagliotti G V, Mulshine J L, et al. Lung cancer: current therapies and new targeted treatments[J]. The Lancet, 2017, 389(10066): 299-311. DOI:10.1016/S0140-6736(16)30958-8 |

| [5] | Boskovic T, Stojanovic M, Stanic J, et al. Pneumothorax after transbronchial needle biopsy[J]. Journal of Thoracic Disease, 2014, 6(sup 4): 427-434. |

| [6] | Sollini M, Cozzi L, Antunovic L, et al. PET radiomics in NSCLC: state of the art and a proposal for harmonization of methodology[J]. Scientific Reports, 2017, 7(1): 1-15. DOI:10.1038/s41598-016-0028-x |

| [7] | Lambin P, Rios-Velazquez E, Leijenaar R, et al. Radiomics: extracting more information from medical images using advanced feature analysis[J]. European Journal of Cancer, 2012, 48(4): 441-446. DOI:10.1016/j.ejca.2011.11.036 |

| [8] | Chen C H, Chang C K, Tu C Y, et al. Radiomic features analysis in computed tomography images of lung nodule classification[J]. PloS One, 2018, 13(2): e0192002. DOI:10.1371/journal.pone.0192002 |

| [9] | Demir ?, ?amurcu A Y. Classification of lung nodules using textural features[C]//2019 3rd International Symposium on Multidisciplinary Studies and Innovative Technologies (ISMSIT). Turkey: IEEE, 2019: 1-5. |

| [10] | 王超, 刘侠, 董迪, 等. 基于影像组学的非小细胞肺癌淋巴结转移预测[J]. 自动化学报, 2019, 45(6): 1087-1093. (Wang Chao, Liu Xia, Dong Di, et al. Radiomics based lymph node metastasis prediction in non-small-cell lung cancer[J]. Acta Automatica Sinica, 2019, 45(6): 1087-1093.) |

| [11] | Conti A, Duggento A, Indovina I, et al. Radiomics in breast cancer classification and prediction[J]. Seminars in Cancer Biology, 2020, 72(1): 238-250. |

| [12] | Ning Z, Luo J, Li Y, et al. Pattern classification for gastrointestinal stromal tumors by integration of radiomics and deep convolutional features[J]. IEEE Journal of Biomedical and Health Informatics, 2018, 23(3): 1181-1191. |

| [13] | Ma J C, Song Y, Tian X, et al. Survey on deep learning for pulmonary medical imaging[J]. Frontiers of Medicine, 2020(4): 450-469. |

| [14] | Litjens G, Kooi T, Bejnordi B E, et al. A survey on deep learning in medical image analysis[J]. Medical Image Analysis, 2017, 42: 60-88. |

| [15] | Meyer P, Noblet V, Mazzara C, et al. Survey on deep learning for radiotherapy[J]. Computers in Biology and Medicine, 2018, 98: 126-146. |

| [16] | Shen W, Zhou M, Yang F, et al. Multi-scale convolutional neural networks for lung nodule classification[C]//International Conference on Information Processing in Medical Imaging. Sabhal Mor Ostaig: Springer, 2015: 588-599. |

| [17] | Zhang C H, Tavanapong W, Wong J, et al. Real data augmentation for medical image classification[C]//Intravascular Imaging and Computer Assisted Stenting, and Large-Scale Annotation of Biomedical Data and Expert Label Synthesis. Quebec City: Springer, 2017: 67-76. |

| [18] | Zhao A, Balakrishnan G, Durand F, et al. Data augmentation using learned transformations for one-shot medical image segmentation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 8543-8553. |

| [19] | Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets[J]. Advances in Neural Information Processing Systems, 2014, 27: 2672-2680. |

| [20] | Salimans T, Goodfellow I, Zaremba W, et al. Improved techniques for training GANs[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona: Neural Information Processing Systems, 2016: 2234-2242. |

| [21] | Arjovsky M S C, Bottou L. Wasserstein generative adversarial networks[C]//Proceedings of the 34th International Conference on Machine Learning. Sydney: IEEE, 2017: 214-223. |

| [22] | Gulrajani I, Ahmed F, Arjovsky M, et al. Improved training of Wasserstein gans[C]//Advances in Neural Nnformation Processing Systems. Long Beach: Neural Information Processing Systems, 2017: 5767-5777. |

| [23] | Huang G, Liu Z, van der Maaten L, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 4700-4708. |

| [24] | Jolliffe I T, Cadima J. Principal component analysis: a review and recent developments[J]. Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences, 2016, 374(2065): 1-16. |

| [25] | Fodor I K. A survey of dimension reduction techniques[R]. Livermore: Lawrence Livermore National Laboratory, 2002. |

| [26] | 周志华. 机器学习[M]. 北京: 清华大学出版社, 2016. (Zhou Zhi-hua. Machine learning[M]. Beijing: Tsinghua University Press, 2016.) |

| [27] | Diwakar M, Kumar M. A review on CT image noise and its denoising[J]. Biomedical Signal Processing and Control, 2018, 42: 73-88. |

| [28] | MacMahon H, Naidich D P, Goo J M, et al. Guidelines for management of incidental pulmonary nodules detected on CT images: from the Fleischner Society 2017[J]. Radiology, 2017, 284(1): 228-243. |

| [29] | Ahmad A, Gadgeel S M. Lung cancer and personalized medicine: novel therapies and clinical management[M]. Switzerland: Springer, 2016. |

| [30] | Dhara A K, Mukhopadhyay S, Dutta A, et al. A combination of shape and texture features for classification of pulmonary nodules in lung CT images[J]. Journal of Digital Imaging, 2016, 29(4): 466-475. |

| [31] | Feng B, Chen X, Chen Y, et al. Differentiating minimally invasive and invasive adenocarcinomas in patients with solitary sub-solid pulmonary nodules with a radiomics nomogram[J]. Clinical Radiology, 2019, 74(7): 570.e1-570.e11. |

| [32] | El-Baz A, Gimel'farb G, Falk R, et al. Appearance analysis for diagnosing malignant lung nodules[C]//IEEE International Symposium on Biomedical Imaging: from Nano to Macro. Rotterdam: IEEE, 2010: 193-196. |

| [33] | 汪海燕, 黎建辉, 杨风雷. 支持向量机理论及算法研究综述[J]. 计算机应用研究, 2014, 31(5): 1281-1286. (Wang Hai-yan, Li Jian-hui, Yang Feng-lei. Overview of support vector machine analysis and algorithm[J]. Application Research of Computers, 2014, 31(5): 1281-1286.) |

| [34] | Dong X B, Yu Z W, Cao W M, et al. A survey on ensemble learning[J]. Frontiers of Computer Science, 2020, 14(2): 241-258. |

| [35] | Lin T Y, Maji S. Visualizing and understanding deep texture representations[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 2791-2799. |