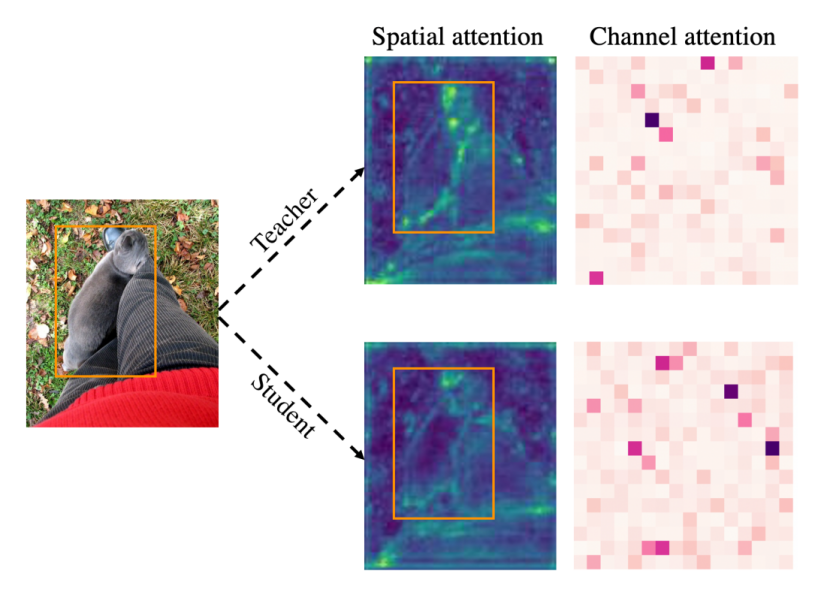

前背景的不平衡对于目标检测而言是一个重要的问题,这个问题同样影响着知识蒸馏。近日,清华大学深圳国际研究生院袁春团队对学生模型和教师模型二者的特征图进行了可视化,发现教师与学生在空间注意力方面在前景中的差异较大,在背景中的差异较小,这会给蒸馏中的学生模型带来不同的学习难度。接着,团队分离出前背景进行蒸馏实验,发现当全图特征混在一起蒸馏时,为学生模型带来的提升最小,而将前景与背景分开,赋予不同的权重时,学生模型能够获得更好的表现。

学生与教师网络空间与通道注意力

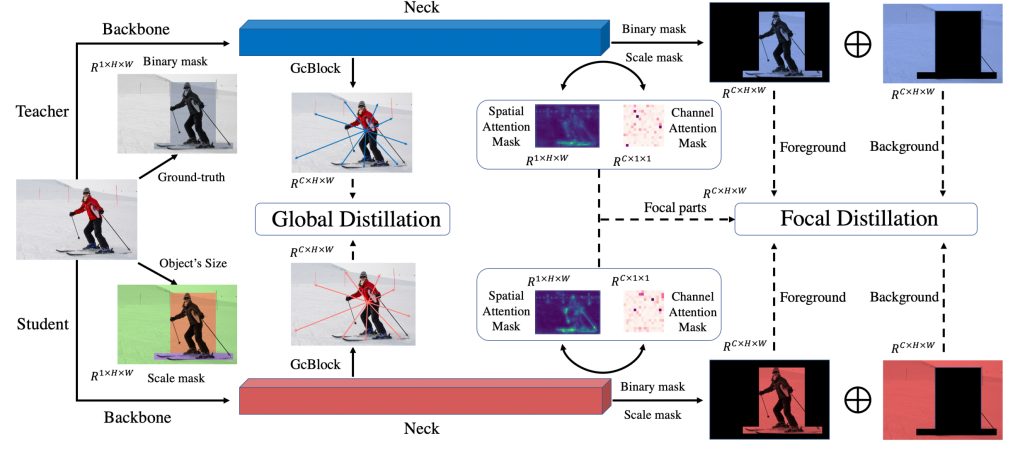

针对上述结论,团队首先提出了“重点蒸馏(Focal Distillation)”:分离前背景,赋予不同的权重,并利用教师的空间与通道注意力作为权重,共同指导学生模型进行学习,计算重点蒸馏损失。由于重点蒸馏将前景与背景分开进行蒸馏,切断了前背景的联系,为此,团队提出了“全局蒸馏(Global Distillation)”解决方案:利用全局语义信息模块(Global Context Block,GcBlock)分别提取学生与教师的全局信息,并计算全局蒸馏损失。结合二者,团队最终提出了“重点与全局知识蒸馏(Focal and Global Distillation,FGD)。

FGD整体结构

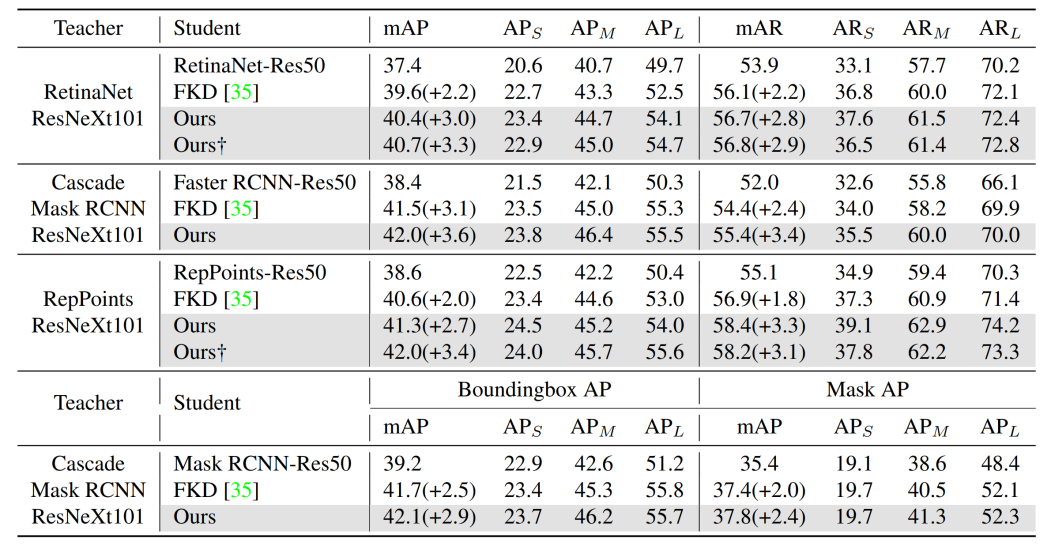

团队将FGD应用到了基于锚框(Anchor-based)与无锚框(Anchor-free)的单阶段与二阶段检测器。可以看到,通过知识蒸馏,各类学生检测器均获得了大幅的平均查准(AP)和平均召回(AR)提升。此外,团队也将FGD拓展到实例分割任务上,FGD同样可以为Mask R-CNN带来大幅的性能提升。

更强的教师蒸馏实验结果

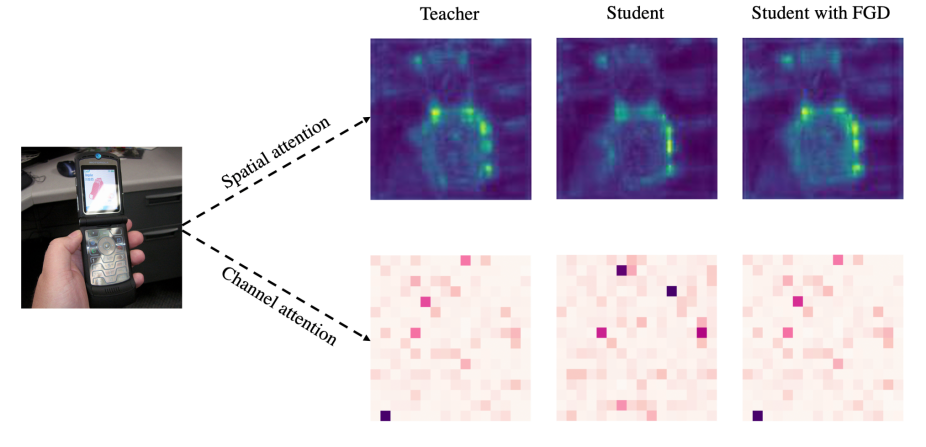

团队也对FGD如何帮助学生模型学习进行了分析,对使用FGD蒸馏完成后的学生模型再次进行了注意力的可视化。研究结果表明,经过FGD蒸馏训练后的学生模型空间注意力和通道注意力的分布均与教师模型相似。这表明学生模型通过蒸馏学到了教师的知识,并获得更好的特征,由此实现性能提升。

蒸馏前后学生与教师注意力对比

FGD作为一种通用的针对目标检测任务的知识蒸馏方法,可以方便地应用到各种类型的检测器上,在不引入额外参数和计算的前提下提升模型表现。

上述研究成果以“目标检测的重点与全局知识蒸馏”(Focal and Global Knowledge Distillation for Detectors)为题,发表在2022年国际计算机视觉与模式识别大会(IEEE Conference on Computer Vision and Pattern Recognition,CVPR 2022)上。该论文第一作者为清华大学深圳国际研究生院2021级硕士生杨震东,通讯作者为清华大学深圳国际研究生院袁春教授,论文作者还包括清华大学深圳国际研究生院2021级硕士生江晓湖。该研究成果得到了国家自然科学基金委和深圳科技创新项目的支持。

论文链接:

https://ieeexplore.ieee.org/document/9879869

供稿:深圳国际研究生院

编辑:李华山

审核:郭玲

2022年11月04日 09:10:50