, 杨雪梅2, 孙志华1,3

, 杨雪梅2, 孙志华1,3 1. 中国科学院大学数学科学学院, 北京 100049;

2. 华北电力大学数理学院, 北京 102206;

3. 中国科学院大数据挖掘与知识管理重点实验室, 北京 100190

2019年5月14日 收稿; 2019年10月9日 收修改稿

基金项目: 国家自然科学基金(11971045)、中央高校基本科研业务费专项资金和中国科学院大数据挖掘与知识管理重点实验室开放课题资助

通信作者: 孙志华, E-mail: sunzh@amss.ac.cn

摘要: 单指标分位回归模型是一类重要的半参数模型,具有降维的优点的同时保留了非参数分位回归模型的稳健性。但现有的单指标分位回归模型的估计程序大部分都是通过内点法来实现。对单指标分位回归模型估计程序的MM(majorize-minimize)算法进行研究。首先找到目标函数的优化函数,然后通过最小化优化函数来得到估计,再逐步迭代至收敛。数值模拟和实证研究表明MM算法在单指标分位回归模型的估计中具有较好的稳定性,能够得到比较准确的估计结果,且相比于内点法,计算效率更高,耗时更短。

关键词: 单指标分位回归模型MM算法替代函数计算效率

MM algorithm of the estimation of single-index quantile regression

GUO Yuanyuan1

, YANG Xuemei2, SUN Zhihua1,3

, YANG Xuemei2, SUN Zhihua1,3 1. School of Mathematical Sciences, University of Chinese Academy of Sciences, Beijing 100049, China;

2. School of Mathematics and Physics, North China Electric Power University, Beijing 102206, China;

3. Key Laboratory of Big Mining and Knowledge Management, Chinese Academy of Sciences, Beijing 100190, China

Abstract: The single-index quantile regression model is an important semiparametric model with the merit of dimensionality reduction. Furthermore, it retains the robustness of a nonparametric model. For most existing estimating procedures of single-index quantile regression models, the estimators are obtained via minimizing the objective functions by the interior point method. In this paper, we investigate the MM (majorize-minimize) algorithm of the single index quantile regression model estimating procedure. We first construct the majorize function of the objective function and then minimize the substituted majorize function to find the estimators. Our numerical simulations and empirical study show that for the considered model, the MM algorithm has good stability and can yield more accurate estimation. Compared with the interior point method, the MM algorithm is more efficient and takes less time.

Keywords: single-index quantile regression modelMM-algorithmsurrogate functioncomputational efficiency

分位回归模型具有稳健的特点,并且能够对响应变量的分布做出精细的描述,因此获得很多****的关注。目前,分位回归方法已经成为分析数据的一个非常重要的工具,广泛地应用在金融、医疗、生物研究等领域。分位回归模型的研究和应用可参考文献[1-4]及相关文献。参数分位回归模型是在实际中应用广泛的一类回归模型[5]。但很多时候无法对参数分位回归模型进行正确的设定。基于误定的参数分位回归的统计推断结果经常是不可信的,文献[6-7] 阐述了参数分位回归需要进行检验的必要性。非参数分位回归不存在误定的风险,但当样本量比较小且协变量比较多时,非参数分位回归方法可能会受到维数祸根的问题的困扰。

对分位回归,构建目标函数时用到的损失函数ρτ(r)=τr-I{r < 0}具有不光滑的特点, 从而使得求解目标函数的最小值比较困难,且可能出现多个最小值点的情况,参见文献[5, 8-11]。一种解决上面问题的方法是将分位回归模型的求解问题转化为线性规划问题,再利用单纯形法或内点法进行计算。不管是单纯形法,还是内点法,运算效率都不能令人满意。2000年,Hunte和Lange[12]提出一种新的用于求解分位回归问题的算法,即MM算法。MM算法概念简单,易于执行,且数值稳定,比内点法拥有更强的数值计算能力。文献[11]对4种求解分位回归问题的算法,即内点法、MM算法、坐标下降法和ADMM算法进行比较研究,验证了MM算法具有数值稳定和计算效率高的特点。

单指标分位回归模型具有降维的效果,同时保持了非参数分位回归的稳健性,其估计问题的研究吸引了很多研究者的兴趣。文献[13-14] 提出基于两步迭代的估计方法,文献[15-16]进一步提出不需要迭代的估计方法,文献[17-18]又提出基于贝叶斯方法的估计方法,文献[19-21]探讨单指标分位回归模型的变量选择以及加权复合单指标分位回归模型的估计。然而这些文献所提的估计方法都基于内点法来实现,内点法在计算分位回归模型时,计算效率低、耗时久,尤其在样本量较大的情况下,这种缺点更为明显。MM算法在求解分位回归模型的估计时比较高效和便捷,这在文献[22-24]中均有体现,但是没有文献研究单指标分位回归模型的MM算法,故本文研究单指标分位回归模型估计的MM算法。

我们借鉴文献[12] 的方法,对单指标分位回归模型的每一步迭代程序中目标函数构建其替代函数,从而将复杂的优化问题简单化。然后,基于优化函数再进行求解计算得到估计值。我们构建的优化函数是光滑的,并能够保证每次迭代目标函数是下降的。数值模拟和实例分析结果表明基于MM算法的估计程序具有较好的稳定性,能够得到比较准确的估计结果,并且相较于传统的内点算法具有更强的数值计算能力,用时更短。

1 单指标分位回归模型的估计介绍对于给定的分位数τ∈(0, 1),在给定x的条件下,响应变量y的τ分位数θτ(x)与协变量x之间的关系如下:

| $\theta_{\tau}(\boldsymbol{x})=g\left(\boldsymbol{x}^{\mathrm{T}} \boldsymbol{\gamma}\right), $ |

本文采用局部线性方法对γ和g(·)进行估计,详细内容可参考文献[13],具体算法如下:

step 1??采用文献[26]提出的平均导数法得到γ的初值,记为

step 2??对给定的

| $\min \limits_{\left(a_{j}, b_{j}\right)} \sum\limits_{i=1}^{n} \rho_{\tau}\left(y_{i}-a_{j}-b_{j}\left(\boldsymbol{x}_{i}-\boldsymbol{x}_{j}\right)^{\mathrm{T}} \hat{\boldsymbol{\gamma}}\right) w_{i j}, $ | (1) |

step 3??基于step 1得到的估计

| $\min \limits_{\boldsymbol{\gamma}} \sum\limits_{j=1}^{n} \sum\limits_{i=1}^{n} \rho_{\tau}\left(y_{i}-\hat{a}_{j}-\hat{b}_{j}\left(\boldsymbol{x}_{i}-\boldsymbol{x}_{j}\right)^{\mathrm{T}} \boldsymbol{\gamma}\right) w_{i j}, $ | (2) |

step 4??重复step 1和step 2直至收敛。

在上述算法中,

| $\begin{aligned}(\hat{a}, \hat{b})=\arg \mathop {\min }\limits_{a, b} & \sum\limits_{i=1}^{n} \rho_{\tau}\left(y_{i}-a-b\left(\boldsymbol{x}_{i}^{\mathrm{T}} \hat{\boldsymbol{\gamma}}-u\right)\right) \\& K_{h}\left(\boldsymbol{x}_{i}^{\mathrm{T}} \hat{\boldsymbol{\gamma}}-u\right).\end{aligned}$ | (3) |

| $\begin{array}{c}Q\left(\boldsymbol{\theta}^{k} \mid \boldsymbol{\theta}^{k}\right)=L\left(\boldsymbol{\theta}^{k}\right) , \\Q\left(\boldsymbol{\theta} \mid \boldsymbol{\theta}^{k}\right) \geqslant L(\boldsymbol{\theta}) \forall \boldsymbol{\theta}.\end{array}$ | (4) |

| $Q\left(\boldsymbol{\theta}^{k+1} \mid \boldsymbol{\theta}^{k}\right) \leqslant Q\left(\boldsymbol{\theta}^{k} \mid \boldsymbol{\theta}^{k}\right) .$ | (5) |

观察目标函数式(1)~式(3),可以发现它们均为非光滑函数,因而不易得到最优解,故借用文献[12] 提出的MM算法的思想来处理这个问题。其主要的处理方式如下:首先给ρτ(r)加一扰动ε,得到其近似函数

| $\rho_{\tau}^{\varepsilon}(r)=\rho_{\tau}(r)-\frac{\varepsilon}{2} \ln (\varepsilon+|r|).$ |

| $\zeta_{\tau}^{\varepsilon}\left(r \mid r^{k}\right)=\frac{1}{4}\left[\frac{r^{2}}{\varepsilon+\left|r^{k}\right|}+(4 \tau-2) r+c\right], $ |

2.2 非参数部分的估计首先,将式(1)中的目标函数修正为

| $L_{\varepsilon}^{j}(\boldsymbol{\theta})=\sum\limits_{i=1}^{n} \rho_{\tau}^{\varepsilon}\left(r_{i j}(\boldsymbol{\theta})\right) w_{i j}, j=1, 2, \cdots, n, $ |

| $Q_{\tau, j}^{\varepsilon}\left(\boldsymbol{\theta} \mid \boldsymbol{\theta}^{k}\right)=\sum\limits_{i=1}^{n} \zeta_{\tau}^{\varepsilon}\left(r_{i j} \mid r_{i j}^{k}\right) w_{i j}, j=1, 2, \cdots, n.$ | (6) |

| $\begin{array}{l}\sum\limits_{i=1}^{n} w_{i j}\left(\frac{Y_{i}}{\left(\varepsilon+\left|r_{i j}^{k}\right|\right)}+(2 \tau-1)\right) \boldsymbol{X}_{i}= \\\sum\limits_{i=1}^{n} \frac{w_{i j}}{\left(\varepsilon+\left|r_{i j}^{k}\right|\right)} \boldsymbol{X}_{i} \boldsymbol{X}_{i}^{\mathrm{T}} \boldsymbol{\theta}, j=1, 2, \cdots, n, \end{array}$ |

| $\begin{array}{c}\boldsymbol{\theta}^{k+1}=\left(\sum\limits_{i=1}^{n} \frac{w_{i j}}{\left(\varepsilon+\left|r_{i j}^{k}\right|\right)} \boldsymbol{X}_{i} \boldsymbol{X}_{i}^{\mathrm{T}}\right)^{-1} \sum\limits_{i=1}^{n} w_{i j} \\\left(\frac{Y_{i}}{\left(\varepsilon+\left|r_{i j}^{k}\right|\right)}+(2 \tau-1) \boldsymbol{X}_{i}\right).\end{array}$ | (7) |

由此,可以将MM算法总结为如下步骤:

1) 选择迭代初始值θ0和一个较小的正常数ε,置k=0;

2) 计算rijk,根据式(7)确定第k+1次迭代值θk+1;

3) 令k=k+1,判断是否满足收敛准则,若满足收敛准则,即:当

| $\left|\frac{Q_{\tau}^{\varepsilon}\left(\boldsymbol{\theta}^{k} \mid \boldsymbol{\theta}^{k}\right)-Q_{\tau}^{\varepsilon}\left(\boldsymbol{\theta}^{k+1} \mid \boldsymbol{\theta}^{k}\right)}{Q_{\tau}^{\varepsilon}\left(\boldsymbol{\theta}^{k} \mid \boldsymbol{\theta}^{k}\right)}\right|<\delta $ |

| $\text { 或者 } Q_{\tau}^{\varepsilon}\left(\boldsymbol{\theta}^{k} \mid \boldsymbol{\theta}^{k}\right)-Q_{\tau}^{\varepsilon}\left(\boldsymbol{\theta}^{k+1} \mid \boldsymbol{\theta}^{k}\right)<\delta$ |

2.3 单指标向量的估计首先定义式(2)中目标函数的近似函数:

| $L_{\tau}^{\varepsilon}(\boldsymbol{\gamma})=\sum\limits_{j=1}^{n} \sum\limits_{i=1}^{n} \boldsymbol{\rho}_{\tau}^{\varepsilon}\left(y_{i}-\hat{a}_{j}-\hat{b}_{j}\left(\boldsymbol{x}_{i}-\boldsymbol{x}_{j}\right)^{\mathrm{T}} \boldsymbol{\gamma}\right) w_{i j}.$ |

| $\begin{array}{c}R_{\tau}^{\varepsilon}\left(\boldsymbol{\gamma} \mid \boldsymbol{\gamma}^{k}\right)=\sum\limits_{j=1}^{n} \sum\limits_{i=1}^{n} \frac{1}{4}\left[\frac{r_{i j}(\boldsymbol{\gamma})^{2}}{\left.\varepsilon+\mid r_{i j}^{k}\right) \mid}+\right. \\\left.(4 \tau-2) r_{i j}(\boldsymbol{\gamma})+c\right] w_{i j}, \end{array}$ |

| $\begin{array}{c}\boldsymbol{\gamma}^{k+1}=\left(\sum\limits_{j=1}^{n} \sum\limits_{i=1}^{n} \frac{w_{i j}}{\left(\varepsilon+\left|r_{i j}^{k}\right|\right)} \boldsymbol{X}_{i j} \boldsymbol{X}_{i j}^{\mathrm{T}}\right)^{-1} \\\sum\limits_{j=1}^{n} \sum\limits_{i=1}^{n} w_{i j}\left(\frac{Y_{i j}}{\left(\varepsilon+\left|r_{i j}^{k}\right|\right)}+(2 \tau-1)\right) \boldsymbol{X}_{i j} .\end{array}$ | (8) |

最后,可将基于MM算法的单指标模型的估计总结为如下步骤:

1) 参考第1节step 1所提供的方法,得到γ的初始估计;

2) 对给定的

3) 对于给定的

4) 重复2)、3)步骤,直至收敛。

2.4 联系函数g(·)的估计对于联系函数的估计,式(6)中目标函数式的近似函数可定义为

| $L_{1, \tau}^{\varepsilon}(a, b)=\sum\limits_{i=1}^{n} \rho_{\tau}^{\varepsilon}\left(y_{i}-a-b\left(\boldsymbol{x}_{i}^{\mathrm{T}} \hat{\boldsymbol{\gamma}}-u\right)\right) K_{h}\left(\boldsymbol{x}_{i}^{\mathrm{T}} \hat{\boldsymbol{\gamma}}-u\right).$ |

| $(\hat{a}, \hat{b})=\left(\sum\limits_{i=1}^{n} \frac{w_{i}}{\left(\varepsilon+\left|r_{i}^{k}\right|\right)} \boldsymbol{X}_{i} \boldsymbol{X}_{i}^{\mathrm{T}}\right)^{-1}$ |

| $\sum\limits_{i=1}^{n} w_{i}\left(\frac{Y_{i}}{\left(\varepsilon+\left|r_{i}^{k}\right|\right)}+(2 \tau-1)\right) \boldsymbol{X}_{i} .$ |

3 数值模拟对于近似函数ρτε(r)中的扰动ε,按照文献[12]给出的建议,选取ε满足εn|lnε|=δ。

3.1 模拟1借鉴文献[13]模拟1的模型设置,考虑模型

| $y = \sin \left( {\frac{{{\rm{ \mathit{ π} }}(u - A)}}{{C - A}}} \right) + 0.1Z{\rm{ , }}$ |

类似参考文献[13, 19, 28]所用的评价标准,用Bias(样本偏差)、SE(样本标准差)、MSE(样本均方误差)、CI (95%的置信区间)、CP(真值落在置信区间的比例)评价单指标向量部分估计

| $\mathrm{ASE}=n^{-1} \sum\limits_{i=1}^{n}\left[\hat{g}\left(u_{i}\right)-g\left(u_{i}\right)\right]^{2}, $ |

| $\mathrm{AAE}=n^{-1} \sum\limits_{i=1}^{n}\left|\hat{g}\left(u_{i}\right)-g\left(u_{i}\right)\right| .$ |

Table 1

| 表 1 模拟1中不同的τ下,估计 |

Table 2

| 表 2 模拟1中不同τ的选择下,?(u)的ASE、AAE的Mean、SETable 2 Outcomes of ?(u) for the models under different choices of τ in simulation 1 | |||||||||||||||||||||||||||||||||

3.2 模拟2借鉴文献[13]模拟2的模型设置,考虑模型

| $y=10 \sin (0.75 u)+\sqrt{1+\sin (u)} Z, $ |

Table 3

| 表 3 模拟2中不同的τ下,估计 |

Table 4

| 表 4 模拟2中不同τ的选择下,?(u)的ASE、AAE的Mean、SETable 4 Outcomes of ?(u) for the models under different choices of τ in simulation 2 | |||||||||||||||||||||||||||||||||

3.3 与内点法比较由前两个模拟可以发现,MM算法在单指标分位回归估计的计算问题中表现良好,接下来比较MM算法与内点法的计算效率,考虑如下3个模型:

模型1: Y=exp(X′1γ1)+ε1;

模型2: Y=5cos(X′2γ2)+ε2;

模型3: Y=5sin(X′3γ3)+exp (-16(X′3γ3)2)+ε3.

其中γ1=(1, 1, 1)T/

Table 5

| 表 5 n=100,模型1、2、3的估计结果比较Table 5 Estimation comparison among models 1, 2, and 3 with n=100 | ||||||||||||||||||||||||||||||||

Table 6

| 表 6 n=200,模型1、2、3的估计结果比较Table 6 Estimation comparison among models 1, 2, and 3 with n=200 |

可以发现MM算法所用的时间远远少于内点法,且随着样本量的增大,这种计算效率上的优势更加明显。这是由于用内点法解决分位回归问题,是将目标函数及约束条件转化为线性规划问题,再用内点法来求解该问题,但转化之后的线性规划问题,协变量维数与样本量的大小有着正相关的关系,这种方法极大地增加了算法的计算量与所用时间。本文第3.2节中的问题转化为线性规划后,协变量的维数为2n+p,第3.3节中的问题转化为线性规划后,维数为2n2+p,具体转化方法及维数的增加量可见文献[11]。而MM算法只需对p维矩阵做运算,故两种方法的计算效率随样本量的增加会产生越来越大的差距。

4 实例分析在这一节,应用本文所提的估计方法对Boston房屋数据集进行分析,Boston房屋数据集包含506个样本。该数据集及其详细介绍均可在R包mlbench(http://cran.r-project.org/) 找到。该数据集的响应变量MEDV(自住房屋房价的中位数)为右删失数据,当其大于50 000时,按50 000来记录,故比较适合用分位回归来分析。该数据集已被很多文献分析过,借鉴文献[13-14, 19] 的设置,选取MEDV(自住房屋房价的中位数)为响应变量,同时选取RM(每间住宅的房屋数目),TAX(每一万美元的不动产税率),PTRATIO(城镇中学生与教师的比例),LSTAT(该地区房东收入较低的百分比)4个协变量,对TAX与LSTAT进行对数变换,并对响应变量做中心化处理,构造如下模型

| $\begin{array}{c}\theta_{\tau}(\text { MEDV | RM, TAX, PTRATIO, LSTAT) = } \\g\left(\gamma_{1} \mathrm{RM}+\gamma_{2} \log (\mathrm{TAX})+\gamma_{3} \text { PTRATIO }\right)+ \\\gamma_{4} \log (\text { LSTAT }).\end{array}$ |

1) 计算每个样本的误差,

2) 对{

3) 产生新的响应变量yi*=

4) 根据新的样本(xi, yi*),得到新的估计。

重复模拟100次计算标准差,所得结果列于表 7。从表 7可以发现,RM的系数在不同的分位数下皆为正,这表明每栋房屋的房间数量越多,房价就越高且收入越多的家庭更加在意每栋房屋的房间数量;log(TAX)的系数为负且随分位数逐渐变大,这表明不动产的税率越高,房价越低且收入较低的家庭更加在意不动产税率的大小;PTRATIO的系数为负且随分位数变化较小,这表明学生与教师的比例越大,即教师资源越匮乏,房价越低且低收入家庭与高收入家庭对教育的重视程度是同样大的;log(LSTAT) 系数为负且随分位数逐渐变小,这表明一个地区低收入人群所占的百分比越高,房价越低且收入较高的家庭更加在意一个地区的低收入人群比例。

Table 7

| 表 7 波士顿数据集在单指标分位回归模型下的系数估计及标准差估计Table 7 Coefficient estimation and standard deviation estimation of Boston data set under the single-index quantile regression mode | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

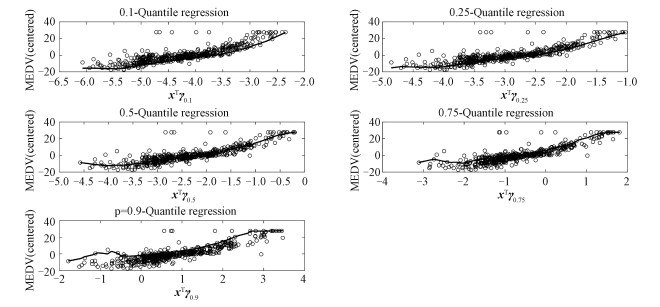

图 1展示了不同分位数下g(·) 的估计,其中,横坐标为估计所得的

Fig. 1

| Download: JPG larger image |

| 图 1 联系函数g(u)及在不同的τ下, ?τ(u)的估计 Fig. 1 The link function g(u) and the estimation of ?τ(u) under different choices of τ 图 1 联系函数g(u)及在不同的τ下, ?τ(u)的估计 Fig. 1 The link function g(u) and the estimation of ?τ(u) under different choices of τ --> | |

5 结论本文研究单指标分位回归模型估计方法的MM算法。相比于内点法,MM算法极大地缩短了计算时间,提高了运算效率。此外,本文给出单指标分位回归模型在MM算法下的参数估计公式,在每次迭代过程中,将协变量与响应变量的观测值直接代入公式,即可得到参数的估计值,避免了每次迭代都要优化目标函数的麻烦。

参考文献

| [1] | Zhao X, Wang W, Liu L, et al. A flexible quantile regression model for medical costs with application to Medical Expenditure Panel Survey Study[J]. Statistics in Medicine, 2018, 37(17): 2645-2666. Doi:10.1002/sim.7670 |

| [2] | Petrella L, Raponi V. Joint estimation of conditional quantiles in multivariate linear regression models with an application to financial distress[J]. Journal of Multivariate Analysis, 2019, 173: 70-84. Doi:10.1016/j.jmva.2019.02.008 |

| [3] | Tan X Z, Gan T Y, Chen S, et al. Modeling distributional changes in winter precipitation of Canada using Bayesian spatiotemporal quantile regression subjected to different teleconnections[J]. Climate Dynamics, 2019, 52: 2105-2124. Doi:10.1007/s00382-018-4241-0 |

| [4] | Xu B, Lin B. Investigating the differences in CO2 emissions in the transport sector across Chinese provinces: evidence from a quantile regrssion model(Article)[J]. Journal of Cleaner Production, 2018, 27(175): 109-122. |

| [5] | 姜成飞. 分位数回归方法综述[J]. 科技信息, 2013, 30(25): 185-240. |

| [6] | He X, Zhu L X. A lack-of-fit test for quantile regression[J]. Journal of the American Statistical Association, 2003, 98(464): 1013-1022. Doi:10.1198/016214503000000963 |

| [7] | Mercedes C A, César S S, Wenceslao G M. A lack-of-fit test for quantile regression models with high-dimensional covariates[J]. Computational Statistics and Data Analysis, 2015, 33(88): 128-138. |

| [8] | 关静. 分位数回归理论及其应用[D]. 天津: 天津大学, 2009. |

| [9] | 朱平芳, 张征宇. 无条件分位数回归: 文献综述与应用实例[J]. 统计研究, 2012, 29(3): 88-96. |

| [10] | 陈建宝, 丁军军. 分位数回归技术综述[J]. 统计与信息论坛, 2008, 23(3): 89-96. |

| [11] | Gao J Y. Computation in quantile and composite quantile regression models with or without regularization[D]. Edmonton: University of Alberta, 2015. |

| [12] | Hunter D R, Lange K. Quantile regression via an MM algorithm[J]. Journal of Computational and Graphical Statistics, 2000, 9(1): 60-77. |

| [13] | Wu T Z, Yu K M, Yu Y. Single-index quantitle regression[J]. Jornal of Multivariate Analysis, 2010, 40(101): 1607-1621. |

| [14] | Kong E F, Xia Y C. A single-index quantile regression model and its estimation[J]. Econometric Theory, 2012, 28(4): 730-768. Doi:10.1017/S0266466611000788 |

| [15] | Kuruwita C N. Non-iterative estimation and variable selection in the single-index quantile regression model[J]. Communications in Statistics-Simulation and Computation, 2016, 45(10): 3615-3628. Doi:10.1080/03610918.2014.992542 |

| [16] | Christou E. A Non-iterative method for fitting the single index quantile regression model with uncensored and censored data[D]. Pennsylvania: The Pennsylvania State University, 2016. |

| [17] | Hu Y A, Gramacy R B, Lian H. Bayesian quantile regression for single-index models[J]. Statistics and Computing, 2013, 23(4): 437-454. Doi:10.1007/s11222-012-9321-0 |

| [18] | Alshaybawee T, Midi H, Alhamzawi R. Bayesian elastic net single index quantile regression[J]. Journal of Applied Statistics, 2017, 44(5): 853-871. Doi:10.1080/02664763.2016.1189515 |

| [19] | Jiang R, Qian W M, Zhou Z G. Weighted composite quantile regression for single-index models[J]. Jornal of Multivariate Analysis, 2016, 148: 34-48. Doi:10.1016/j.jmva.2016.02.015 |

| [20] | Liu H L, Yang H. Estimation and variable selection in single-index composite quantile regression[J]. Communications in Statistics-Simulation and Computation, 2017, 46(9): 7022-7039. Doi:10.1080/03610918.2016.1222424 |

| [21] | Zhong W, Zhu L P, Li R Z, et al. Regularized quantile regression and robust feature screening for single index models[J]. Statistica Sinica, 2016, 26(1): 69-95. |

| [22] | Jiang Y L. Nonparametric quantile regression models via majorization minimization-algorithm[J]. Statistics and Its Interface, 2014, 7(2): 235-240. Doi:10.4310/SII.2014.v7.n2.a8 |

| [23] | Xie S Y, Wan A T K, Zhou Y. Quantile regression methods with varying-coefficient models for censored data[J]. Computational Statistics and Data Analysis, 2015, 88: 154-172. Doi:10.1016/j.csda.2015.02.011 |

| [24] | Chen Y L, Tang M L, Tian M Z. Semiparametric hierarchical composite quantile regression[J]. Communications in statistics: theory and methods, 2015, 50(4-6): 996-1012. |

| [25] | Lin W, Kulasekera K B. Indentifiability of single-index models and additive-index models[J]. Biometrica Jornal, 2007, 31(94): 496-501. |

| [26] | Chaudhuri P, Doksum K, Samarov A. On average derivative quantile regression[J]. Annals of Statistics, 1997, 25(2): 715-744. |

| [27] | Yu K M, Jones M C. Local linear quantile regression[J]. Journal of the American Statistic Association, 1998, 93(441): 228-237. |

| [28] | Lv Y Z, Zhang R Q, Zhao W H, et al. Quantile regression and variable selection of partial linear single-index model[J]. Ann Inst Stat Math, 2015, 67(2): 375-409. Doi:10.1007/s10463-014-0457-x |

| [29] | De Gooijer J G, Zerom D. On additive conditional quantiles with high-dimensional covariates[J]. Journal of the American Statistic Association, 2003, 98(116): 135-146. |