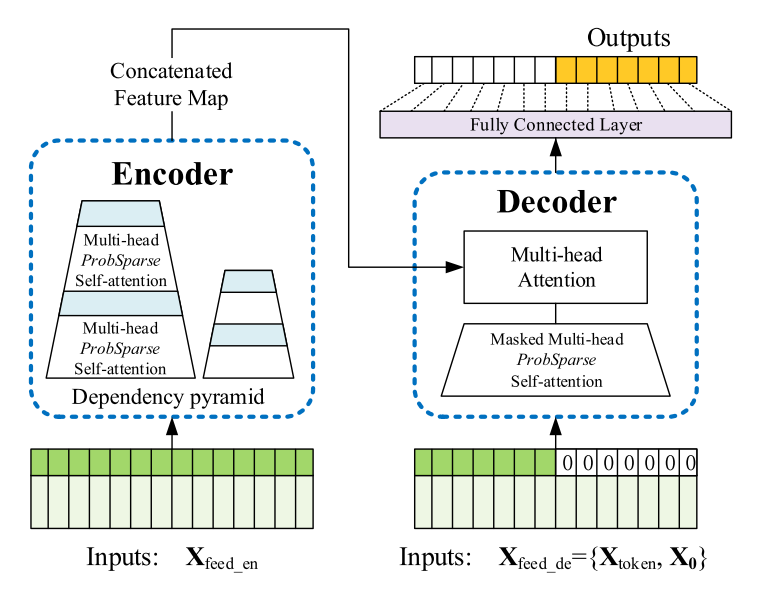

面向长序列数据的Informer网络结构示意图

长时间序列分析预测一直是人工智能基础理论研究的难点,对工业健康维护、疾病传播预测、网络安全分析等关键领域具有重要作用。获奖论文指出“传统循环神经网络因误差逐层累积”已不能满足长序列数据分析的需求,并首次明确了Transformer神经网络架构对长序列问题建模的重要意义。该架构的核心优势是构建了自注意力机制来捕捉跨长度的前后相关性,但其伴随的重大挑战是自注意力操作具有随输入长度的二次时间复杂度,无法适用于长序列输入和输出。据此,该论文突破了传统自注意力的计算复杂度限制,提出一种全新的从概率角度进行自注意力矩阵稀疏化的模型ProbSparse Attention。该模型可以允许以非启发式的方式对自注意力计算进行长尾显著性分析,摘取长序列中重要的前后相关性对,可以依采样方案将计算复杂度降低至对数线性复杂度,令ProbSparse自注意力满足长序列分析的建模要求。同时,该论文还提出了注意力蒸馏机制来允许构建更深的长序列堆叠模型,同时通过生成式解码来实现长序列单次前向输出。这是首次在长序列问题上运用Transformer神经网络架构,依靠所提出的可分析稀疏化、注意力蒸馏和生成式解码组成Informer网络结构,可以在同样硬件限制下显著提高序列分析任务性能,为解决长序列问题提供了一种全新的解决方案。

论文预刊印版本地址:https://arxiv.org/abs/2012.07436

论文项目地址:https://github.com/zhouhaoyi/Informer2020

(审核:王蕴红)

编辑:贾爱平